官方介绍

阿里巴巴通义千问团队推出了最新一代大型语言模型系列 Qwen3。它采用创新的双模推理设计,支持"思考模式"和"非思考模式",能在复杂任务和简单问题之间灵活切换。模型支持119种语言和方言,在编码、推理、多语言理解等方面实现了显著突破。

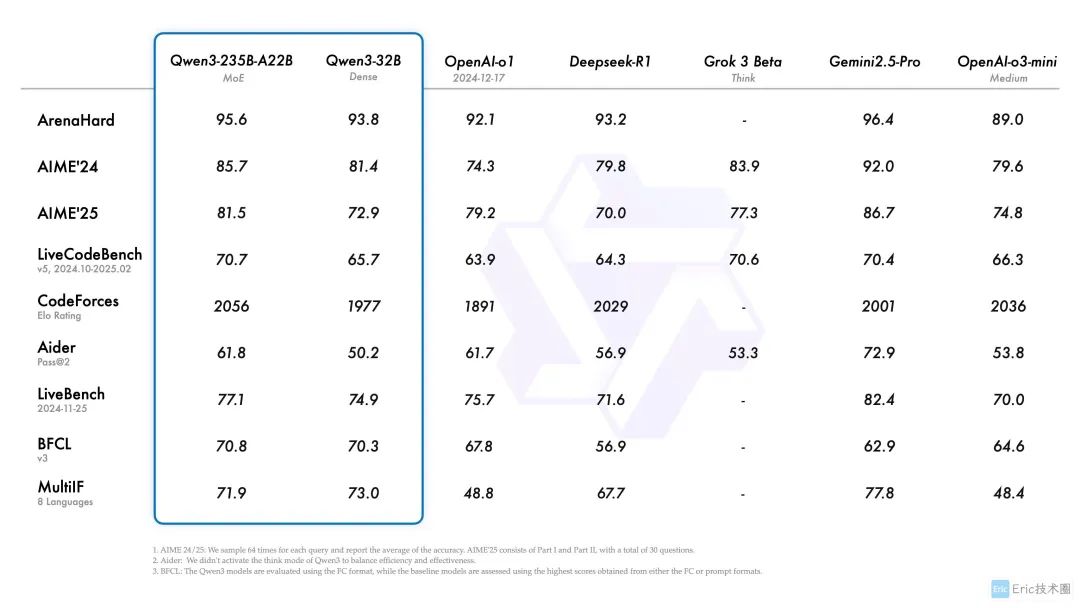

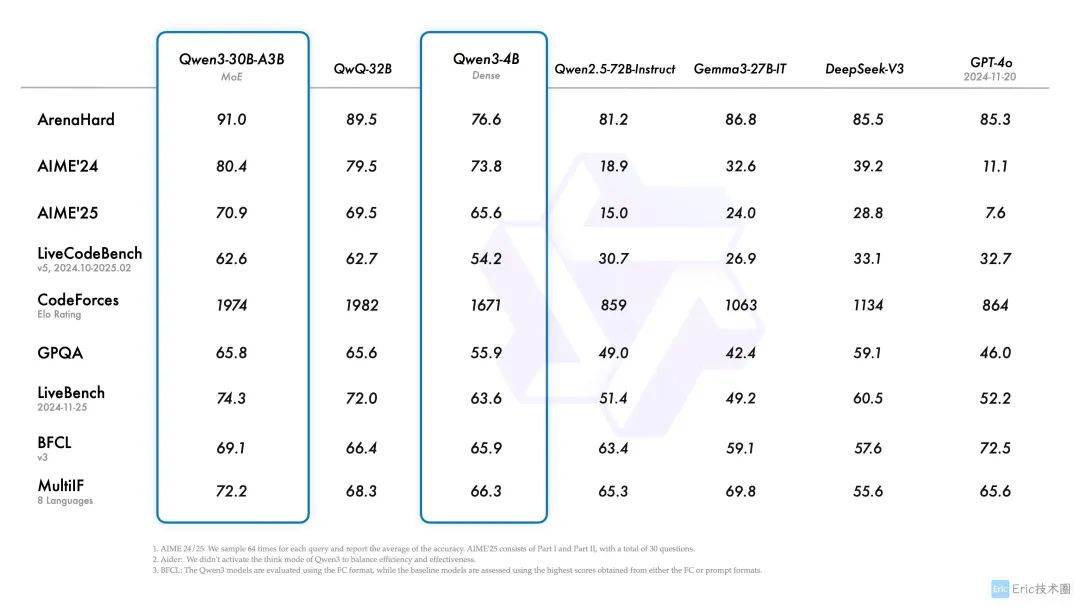

它的旗舰模型 Qwen3-235B-A22B 在代码、数学、通用能力等基准测试中,与 DeepSeek-R1、o1、o3-mini、Grok-3 和 Gemini-2.5-Pro 等顶级模型相比,表现出极具竞争力的结果。此外,小型 MoE 模型 Qwen3-30B-A3B 的激活参数数量是 QwQ-32B 的 10%,表现更胜一筹,甚至像 Qwen3-4B 这样的小模型也能匹敌 Qwen2.5-72B-Instruct 的性能。

以上信息来源于官网:https://qwenlm.github.io/zh/blog/qwen3/ [1]

前期准备

- MacOS(Apple Silicon) / Windows / Linux ,三个系统选其一

- LM Studio

- Qwen3-30B-A3B 模型

LM Studio是一款专为本地运行大型语言模型(LLM)设计的桌面应用程序。它允许用户在个人计算机上离线下载、管理和运行各种开源大语言模型,包括Qwen3、Llama 3、Mistral等。

本地部署为什么选用 Qwen3-30B-A3B 模型?

Qwen3-30B-A3B是一个高效的MoE(混合专家)模型,总参数量为30B,激活参数仅为3B。它具有以下特点:

- 性能强大:在仅激活3B参数的情况下,性能却超过了激活参数为30B的QwQ-32B的密集模型

- 资源友好:相比同性能的密集模型,显存占用大幅降低

- 推理速度快:在推理阶段的计算量减少,提升了推理速度,适合本地部署和实时应用场景

- 完整功能:支持双模推理、119种语言和全系列工具调用能力

- 部署灵活:可在配置适中的消费级GPU上流畅运行

这使得Qwen3-30B-A3B成为本地部署的理想选择,能在保持出色性能的同时大幅降低硬件要求。如果你的设备配置较低,Qwen3-4B 提供了一个轻量级的选择,适合进行简单体验。

想要体验满血版 235B 参数的用户,其在线体验地址:https://chat.qwen.ai/ [1]

本地部署验证

针对 Qwen3 的强大能力,我设计了一些提示词,用于测试模型的核心能力,便于快速验证。

01 推理能力

Qwen3 在数学和逻辑推理等评测中,显著超过QwQ和同尺寸的非推理模型,达到同规模业界顶尖水平。

日常数学问题测试

我计划装修一个长4.5米、宽3.2米的卧室,地板材料每平方米售价为120元,墙面漆每平方米需要40元(墙高2.8米)。

1. 请计算装修所需的总费用(不含天花板)

2. 如果我的预算是3000元,够吗?如果不够,还差多少?

答案✅,思考时间花费了 1 分 43 秒。

逻辑推理测试

小明、小红、小刚和小丽四个人去看电影。已知:

1. 小明不喜欢坐在最边上

2. 小红和小丽一定要坐在一起

3. 小刚想坐在最右边的位置

请问,这四个人有哪些可能的座位安排方式?给出所有可能性并解释你的推理过程。

答案✅,列举出了所有的正确答案,思考时间花费了 5 分 53 秒。

总结:对于逻辑推理相关的问题,在默认开启thingking模式的情况下,思考时间有些长,需要等待较长的时间,在我的观察下,思考过程中会快速的得出了正确答案,但是模型会在其中一直否定自己,花费更长时间进行验证,最后总体的思考时间较长。同时每个问题需要新开一个窗口,会出现之前已回答问题一起思考的情况。

02 人类偏好能力

创意写作、角色扮演、指令遵循能力均大幅提升,通用能力显著超过同尺寸模型。

创意写作测试提示词

请以"遗忘的城市"为主题,写一篇短篇科幻小说开头(约300字),要求氛围神秘,包含未来科技元素。

角色扮演测试提示词

你是一位经验丰富的天文学家,正在接受一位10岁孩子的采访。请用生动有趣且科学准确的方式回答:为什么有的星星会闪烁?什么是黑洞?我们如何知道宇宙在膨胀?

总结:对于创作类问题,思考时间很短,能够快速得到答案,同时回答的问题也很有趣。

03 多语言能力

Qwen3支持119种语言和方言,多语言翻译、指令理解、常识推理能力都明显提升。

多语言翻译测试提示词

请将以下中文段落翻译成法语、西班牙语和日语:

"人工智能技术正在改变我们的生活方式。从智能助手到自动驾驶汽车,这些创新正在各个领域带来革命性的变化。未来十年,我们将看到更多令人惊叹的发展。"

多语言理解测试提示词

Please answer the following questions in the same language they are asked:

1. 中国的四大发明是什么?

2. ¿Cuáles son las principales atracciones turísticas de España?

3. Quels sont les plats traditionnels français les plus célèbres?

4. What are the most significant technological advancements of the 21st century?

语言分别是:中文、西班牙语、法语和英语,但是最后一种回答使用的却是法语,显然是错误的。所以我在官方网站进行验证下是不是都有这样的问题。

满血 Qwen3-235B-A22B:

官方满血版是没有问题的,思考过程也非常好。

Qwen-30B-A3B:

官方 Qwen3-30B-A3B 同样思考过程没有问题,识别出了四种语言,但回答却是错误的,多次测试都一样。

04 编码能力

前端React项目测试提示词

使用Vite + React初始化一个项目,并且完成一个登录组件,样式使用TailwindCSS。要求:

1. 包含用户名、密码字段和记住我选项

2. 实现基本表单验证

3. 添加响应式设计,适配移动端

4. 提供完整的代码和安装依赖步骤

图片太多了,就不截取了,后面可以看我录制的视频。

算法实现测试提示词

请实现一个高效的图算法解决以下问题:

给定一个无向图,实现Dijkstra算法找到从起点到所有其他顶点的最短路径。提供Python代码实现,并解释时间复杂度和空间复杂度。

最后如果发现 Qwen3 的思考时间过长的话,可以添加/no_think来控制:

非推理模式的速度要快的多!

最后

如何更好地使用Qwen3?充分发挥Qwen3的能力,可以考虑以下几点策略:

-

灵活利用双模式推理:针对复杂问题启用"思考模式",让模型进行详细推理;对于简单问题使用"非思考模式"获取快速响应。可以通过在提示词中添加"/think"或"/no_think"来控制。

-

利用多语言能力:Qwen3支持119种语言,可以直接用多种语言提问或要求模型进行多语言翻译,无需切换模型。

-

优化提示词设计:

-

- 提供清晰具体的指令和足够的上下文

- 对于复杂任务,将大问题分解为多个小步骤

- 使用格式化的输出要求(如JSON、表格等)获取结构化内容

-

配合工具使用:搭配Qwen-Agent可以实现更强的工具调用能力,让模型与外部工具和API交互,扩展其功能边界。

-

本地部署优化:

-

- 使用LM Studio等工具进行高效本地部署

- 根据硬件条件选择合适大小的模型(从0.6B到32B)

- 考虑量化版本以降低资源消耗

通过合理利用Qwen3的这些特性,无论是个人用户、研究人员还是开发者,都能在各自领域获得更高效、更智能的语言处理体验。

最后的最后

感谢你们的阅读和喜欢,作为一位在一线互联网行业奋斗多年的老兵,我深知在这个瞬息万变的技术领域中,持续学习和进步的重要性。

为了帮助更多热爱技术、渴望成长的朋友,我特别整理了一份涵盖大模型领域的宝贵资料集。

这些资料不仅是我多年积累的心血结晶,也是我在行业一线实战经验的总结。

这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。如果你愿意花时间沉下心来学习,相信它们一定能为你提供实质性的帮助。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

2556

2556

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?