Background & Motivation

文章认为特征聚合的关键是语义和空间信息的聚合。

Semantic fusion, or aggregating across channels and depths, improves inference of what.

Spatial fusion, or aggregating across resolutions and scales, improves inference of where.

更多的非线性,更大的感受野提高了精度但是给优化和计算带来困难。分层精度比较、可迁移分析和表征可视化都显示更深的层数可以提取到更多的语义信息,但是这些并不能证明网络最后一层的语义特征就是最终的表征。因此 Aggregation 是模型的一个至关重要的维度。

Deep Layer Aggregation(DLA)

layer、block 和 stage 之间的关系:

Layers are grouped into blocks, which are then grouped into stages by their feature resolution.

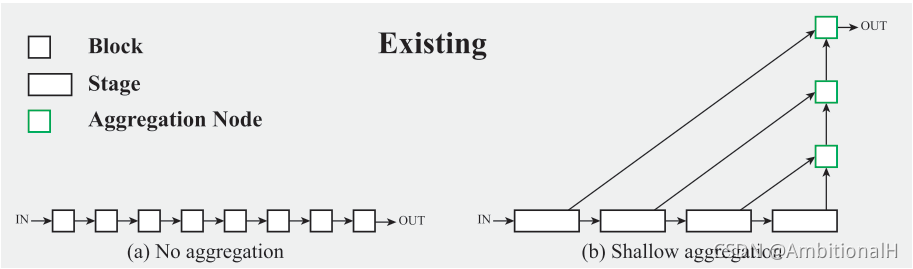

上图中的(b)与 FPN 的做法相同但它不是 FPN,而是作为 backbone,也就是说(b)中的结构可以跟 FPN 结合起来。

We define aggregation as the combination of different layers throughout a network.

We call a group of aggregations deep if it is compositional, nonlinear, and the earliest aggregated layer passes through multiple aggregations.

DLA 包含两个部分:iterative deep aggregation(IDA)和 hierarchical deep aggregation(HDA)。前者更关注融合分辨率和尺度,后者关注各个特征层和通道之间的聚合。

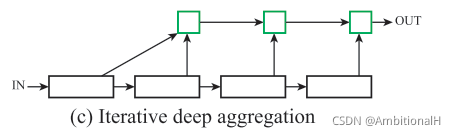

Iterative Deep Aggregation(IDA)

根据特征分辨率将 block 分为不同的 stage,更深层的 stage 包含更多的语义信息而丢失了细节信息。IDA 的做法是:

Aggregation begins at the shallowest, smallest scale and then iteratively merges deeper, larger scales.

这样浅层的特征就被每个不同尺度下 stage 的特征不断地 refine。我认为的 IDA 与 Fig.1 中(b)的不同之处在于:IDA 的主体是从第一个 stage 中聚合出来的 Aggregation Node,refine 第一个 Aggregation Node;而后者的主体是最后一个 stage 中聚合出来的 Aggregation Node,refine 最后一个 Aggregation Node。

Hierarch

本文探讨了深度学习中特征聚合的重要性,提出了Deep Layer Aggregation (DLA) 网络,它包含Iterative Deep Aggregation (IDA) 和Hierarchical Deep Aggregation (HDA) 两部分,旨在有效融合语义和空间信息。DLA通过非线性和多层次的特征融合,提高了模型的精度,同时在ImageNet分类和语义分割任务上展示了优越的性能。尽管更深的网络通常带来更好的性能,但作者发现更深的层次并不总是改善边界检测的预测性能。

本文探讨了深度学习中特征聚合的重要性,提出了Deep Layer Aggregation (DLA) 网络,它包含Iterative Deep Aggregation (IDA) 和Hierarchical Deep Aggregation (HDA) 两部分,旨在有效融合语义和空间信息。DLA通过非线性和多层次的特征融合,提高了模型的精度,同时在ImageNet分类和语义分割任务上展示了优越的性能。尽管更深的网络通常带来更好的性能,但作者发现更深的层次并不总是改善边界检测的预测性能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

221

221

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?