文章目录

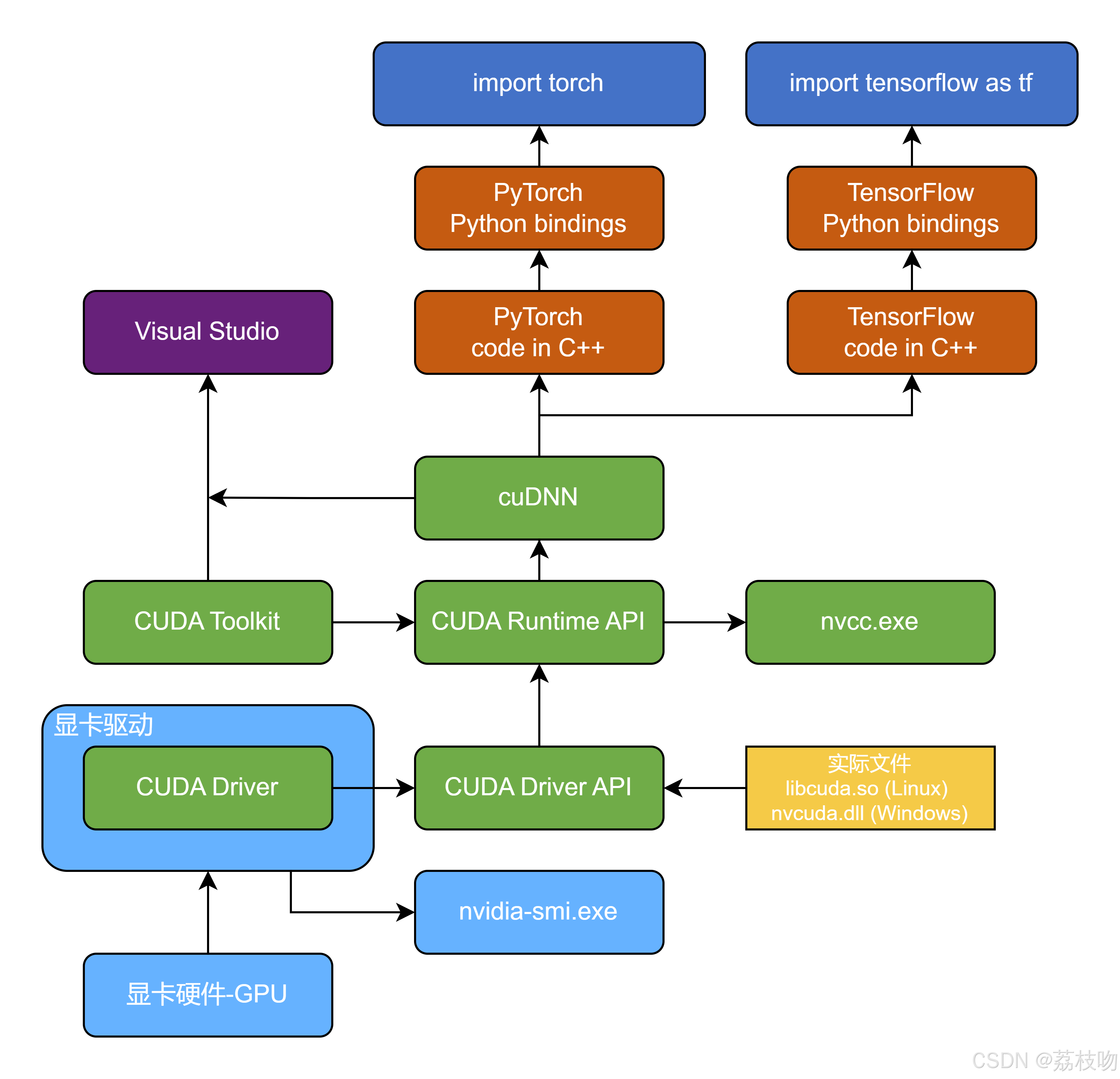

别再傻傻分不清!显卡、驱动、CUDA、cuDNN、nvcc、nvidia-smi、cuda toolkit、cuda driver…一张图带你全部搞懂

一图总览

📌 一表总览

| 名词 | 一句话速记 |

|---|---|

| 显卡 | 物理 GPU 芯片,插在主板上的“计算卡” |

| 显卡驱动 | 让操作系统识别显卡并调度硬件的“操作系统级驱动” |

| CUDA Driver | 显卡驱动里自带的 libcuda.so / nvcuda.dll,用于 GPU 任务 |

| CUDA Toolkit | 开发包:nvcc 编译器 + cuBLAS/cuDNN 等库 + 样例代码 |

| cuDNN | Toolkit 里的一个子库,专门给深度学习算子做极致优化 |

| nvcc | Toolkit 里的 CUDA 编译器(类似 gcc,但面向 GPU) |

| nvidia-smi | 驱动自带的 命令行监控工具,看 GPU 温度/显存/进程 |

| CUDA Runtime API | 程序运行时直接用的 高层 API(默认随框架自带) |

| CUDA Driver API | 低层 API,需要手动加载 libcuda.so,写驱动级代码用 |

🧩 1. 显卡 vs 显卡驱动

-

显卡 = 硬件

你花 5499 元买来的 RTX 4070 Super,核心代号 AD104,12 GB GDDR6X。 -

显卡驱动 = 软件

官网下载的NVIDIA-Linux-x86_64-535.54.03.run或 Windows 的531.79-desktop-win10-win11-64bit-international-dch-whql.exe。

装完你就能在设备管理器看到 “NVIDIA GeForce RTX 4070”。

🧩 2. CUDA Driver:驱动里的“小模块”

驱动安装后会释放两个关键文件:

- Linux:

/usr/lib/x86_64-linux-gnu/libcuda.so.535.54.03 - Windows:

C:\Windows\System32\nvcuda.dll

只要驱动版本 ≥ 470.xx,就能跑 CUDA 11.4 程序;驱动 535.xx,向下兼容 CUDA 12.x/11.x/10.x。

🧩 3. CUDA Toolkit:开发者的瑞士军刀

官方离线包 cuda_12.4.0_550.54.15_linux.run 里包含:

| 目录 | 作用 |

|---|---|

bin/nvcc | 把 .cu 编译成 GPU 可执行文件 |

lib64/libcublas.so | 矩阵乘法 |

lib64/libcudnn.so | 深度学习卷积、RNN |

samples/ | 官方 100+ 个 CUDA Demo |

PyTorch/TensorFlow 的 pip wheel 已经自带了精简版 Toolkit,所以日常训练无需再装!

🧩 4. cuDNN:深度学习“外挂”

- 本质:Toolkit 下的一个 动态库 文件(

libcudnn.so.8)。 - 功能:给卷积、池化、RNN、Attention 做 汇编级优化,速度比手撸 CUDA kernel 快 2~10×。

- 安装:官网下压缩包 → 把

include/cudnn*.h和lib/libcudnn*拷进/usr/local/cuda-12.4/。

🧩 5. nvcc & nvidia-smi

| 工具 | 所属 | 典型用法 |

|---|---|---|

nvcc --version | Toolkit | 查看编译器版本 |

nvidia-smi | 驱动 | 实时监控 GPU 温度/显存/进程 |

示例输出:

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 535.54.03 Driver Version: 535.54.03 CUDA Version: 12.2 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

|===============================+======================+======================|

| 0 RTX 4070 Super Off | 00000000:01:00.0 Off | N/A |

| 0% 36C P8 12W / 220W| 1345MiB / 12282MiB| 0% Default |

+-----------------------------------------------------------------------------+

注意:这里的 CUDA Version: 12.2 只是 驱动能兼容的最高 Runtime 版本,不代表你装了 Toolkit 12.2。

🧩 6. Runtime API vs Driver API

| 维度 | Runtime API | Driver API |

|---|---|---|

| 头文件 | cuda_runtime.h | cuda.h |

| 函数前缀 | cudaMalloc() | cuMemAlloc() |

| 库链接 | -lcudart(随框架自带) | 手动 -lcuda |

| 使用场景 | 99% 日常开发 | 写底层框架、多 GPU Context 管理 |

| 版本兼容 | 由 PyTorch/TF 内部处理 | 需自己检查驱动版本 |

🎯 一张思维导图

┌──────────────┐ ┌─────────────────┐

│ 显卡硬件 │◄─────┤ 显卡驱动 535 │

└────┬─────────┘ └──────┬──────────┘

│ │

┌────┴─────────┐ ┌──────┴──────────┐

│ CUDA Driver │ │ nvidia-smi │

└────┬─────────┘ └──────┬──────────┘

│ │

┌────┴──────────────┬────────┴──────────────┐

│ CUDA Toolkit 12.4 │

│ ┌─────────────┐ ┌──────────────┐ │

│ │ nvcc │ │ cuDNN 8.9 │ │

│ └─────────────┘ └──────────────┘ │

└────────────────────┬──────────────────────┘

│

┌───────────┴────────────┐

│ PyTorch / TensorFlow │

└────────────────────────┘

✅ 5 秒自检清单

- 设备管理器能看到显卡 ✅

nvidia-smi能列出 GPU ✅torch.cuda.is_available()返回 True ✅

满足以上 3 步,你就已经拥有 显卡 + 驱动 + CUDA Driver,可以放心跑模型了!

如果帮到你,记得点赞、收藏、关注三连!评论区欢迎提问~

2045

2045

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?