一、激光雷达(LDS)简介

1.激光雷达应用举例:

现在自主移动机器人领域非常火爆,无人车、无人飞机、水下机器人、仓储机器人、扫地机等应用层出不穷。激光雷达传感器是地面移动机器人的标配,一些空中机器人也必须使用激光雷达。

2.国内市面上激光雷达举例:

乐行天下(Inmotion)的激光雷达IMLidar,官方网址是

http://robot.imscv.com/

。其性能稳定可靠,国内前列。具体数据见下图。

图1.1 产品图

图1.2 雷达参数

二、测距模组原理分析及设计

1.三角测距原理

三角测距测量模型如下图。

图2.1 三角测距模型

从测距模型,根据相似三角形原理,我们可知,

其中,q为实测距离,s为激光头与镜头的距离,f为镜头的焦距,x与s对应;x该变量假设了角 度β是一个常量。

角度β和q的关系如下,

对函数(1) 求导,可得,

2.测距模块设计

测距模块的设计需要考虑多种因素。

我们测距模块设计的评价函数(标准)是:系统分辨率、测距的最小值和最大值。

评价函数对应的关键可控变量有:镜头焦距(图2.1中的f)、测距模块机械尺寸(图2.1中的s)、激光头中轴线与镜头中轴线夹角(图2.1中角度β的余角);除了关键变量外,还有比如镜头视场角、透光率、光圈,感光芯片的尺寸、分辨率等等。

先介绍一个概念,系统分辨率:一个像素的平移,对应的实测距离变化量。

由公式(3)可知, 当dx为一个像素大小时,dq就是系统分辨率,即系统分辨率 r = -k*q*q/(fs)。

下图中,绿色的线代表系统分辨率,蓝色的线代表最小测量距离,即盲区。

图2.2 系统分辨率与测距函数

图中的曲线对应的感光芯片的参数是:752个像素,每个像素6微米。

我们期望最小测距不大于20cm,那么f*s就得不大于900;系统分辨率在6m处不大于30cm,那么 f*s就得大于700;因此我们选择了 f*s = 800。考虑到镜头焦距的标准情况,以及激光雷达尺寸不能太大,我们选择f = 16mm,s = 50mm。

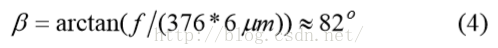

至于夹角β,取决于感光芯片的尺寸和分辨率,即

图2.3 IMLidar测距模块

三、测距模组工程实现

1.模组校准

测距模组的主要误差来源是系统分辨率和校准误差。

校准的目的是把实际模组尽可能匹配理想模型。见图2.3,激光头的指向角度、镜头的指向角度、镜头畸变都是需要调整的关键部分。其中,激光头和镜头可由机械装置调节达到理想位置。对于镜头的畸变,我们分两步处理:a、定位激光点的成像像素到亚像素级别。b、对于不同的实测距离,我们进行相应的距离补偿,适配曲线 1/x (详见公式(1))。

图3.1 校准曲线

图3.2 校准误差与测量距离的函数

从图3.2可知,测量距离越远,误差就越大。

以上讲到的校准方法是基于一个基本前提:热应力和机械振动都比较小。

实际实现过程中,热应力和机械振动都不可忽视。我们设计的时候需要选择刚性比较好、热应力影响小的材料。

2.测距算法

我们知道,光斑的能量分布可近似为一个高斯模型。因此,为了减小误差,我们选择灰度质心法来估算光斑成像点的像素位置。

以下是使用了该算法的测距效果:STD

图3.3 REVO测距效果

3.环境光干扰

我们使用了650nm的红激光做实验。选择激光的时候需要考虑:

a、对人眼的危害情况。b、测距信噪比。c、对环境光的抗干扰能力。

我们对IMLidar做了实测。IMLidar的激光安全等级是class-I。激光的功率越大,测距的信噪比就越高(有上限)。直视太阳光,IMLidar失效;但在非直视太阳光的室外、普通室内的环境下,环境光对测距效果没影响。

对于环境光的影响,我们通常采用两种方式处理,一是时间滤波,二是窄带滤波。

图3.4 激光功率

上图体现了激光脉宽与最大允许光强的关系。选择参数是一个博弈的结果,需要多方面权衡利弊。

4.

硬件逻辑

激光雷达的工作流程是:

a、发射激光,同时感光芯片曝光。

b、读取像素数据。

c、计算出像素的中心(质心)位置。

d、把c中的计算结果(像素位置)换算成距离信息。

硬件的逻辑详见下图:

图3.5 LDS硬件逻辑

5.测距性能

REVO测距性能情况如下:10%反射率和90%反射率的条件下的测距效果。

图3.6 REVO测距性能

针对IMLidar,我们测试发现它稳定工作后,误差可保持在测量距离的1%以内。

四、激光雷达扫描工程实现

1.

雷达旋转扫描

我们定义雷达测距的参考点为雷达的旋转中心。

图4.1 雷达旋转

由图4.1,我们可知:

也就是说,雷达旋转起来后,测距的参考点与原来不转的测距模组的参考点不同。因此,我们需要对测距数据做一个公式(6)的换算处理。

2.

角度与测距同步

激光雷达传感器对外提供的数据是距离和角度信息,也就是一个极坐标信息。

角度获取与测距需要同步,才能反映环境信息。

3.

寿命问题

以前的低成本激光雷达都采用滑环的方式给旋转体供电和通信。滑环的寿命比较短,只有大概 1000个小时,因此导致整个雷达的寿命受到影响。IMLidar采用无线供电方式,因此寿命会比较长。具 体数据难以实测。

4.

实测表现

下面是REVO的实测结果。IMLidar的性能实测更好。

图4.2 雷达实测

五、总结

文章主要参考了ICRA上的一篇论文“A Low-Cost Laser Distance Sensor”。

IMLidar的核心设计思想估计也是如此。从原理模型设计到消费级产品,这个过程非常艰难,但相信也很有意思。

作者:李少海。联系方式:QQ395217658。

60

60

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?