图基本特性代码

- 度

- 连通分量

- 图直径

- 度中心性

- 特征向量中心性

- closeness

- pagerank

- HITS

代码

#!/usr/bin/env python

# -*- coding:utf-8 -*-

# @FileName :1.图基础知识.py

# @Time :2022/1/18 10:53

# @Author :PangXZ

import numpy as np

import pandas as pd

import networkx as nx

edges = pd.DataFrame()

edges['sources'] = [1, 1, 1, 2, 2, 3, 3, 4, 4, 5, 5, 5]

edges['targets'] = [2, 4, 5, 3, 1, 2, 5, 1, 5, 1, 3, 4]

edges['weights'] = [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1]

if __name__ == "__main__":

print(nx.__version__)

G = nx.from_pandas_edgelist(edges, source='sources', target='targets', edge_attr='weights')

# degree

print(nx.degree(G))

# 连通分量

print(list(nx.connected_components(G)))

# 图直径

print(nx.diameter(G))

# 度中心性

print(nx.eigenvector_centrality(G))

# 特征向量中心性

print(nx.betweenness_centrality(G))

# closeness

print(nx.closeness_centrality(G))

# pagerank

print(nx.pagerank(G))

# HITS

print(nx.hits(G))

问题:

IndexError: tuple index out of range

解决办法:检查networkx的版本,这里的版本为2.5,将其升级到2.5.1即可。

pip install -U networkx

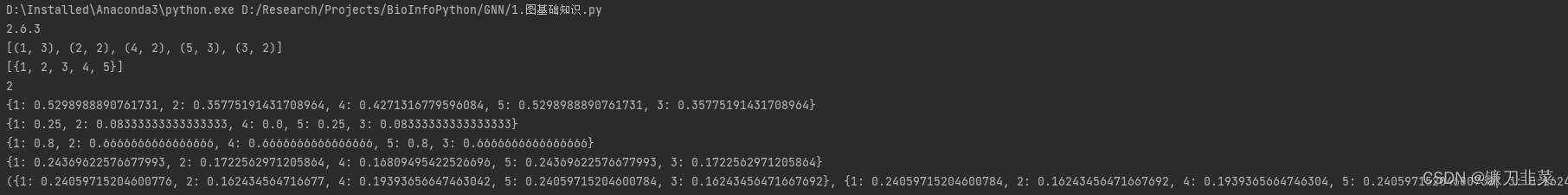

执行结果

参考资料

[1] https://github.com/erdogant/bnlearn/issues/24

图神经网络学习笔记

图神经网络学习笔记

本文介绍了使用Python和NetworkX库进行图神经网络的基础知识学习,包括图的基本特性如度、连通分量、图直径等,并提供了具体实现代码。同时针对代码运行中出现的问题给出了解决方案。

本文介绍了使用Python和NetworkX库进行图神经网络的基础知识学习,包括图的基本特性如度、连通分量、图直径等,并提供了具体实现代码。同时针对代码运行中出现的问题给出了解决方案。

584

584

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?