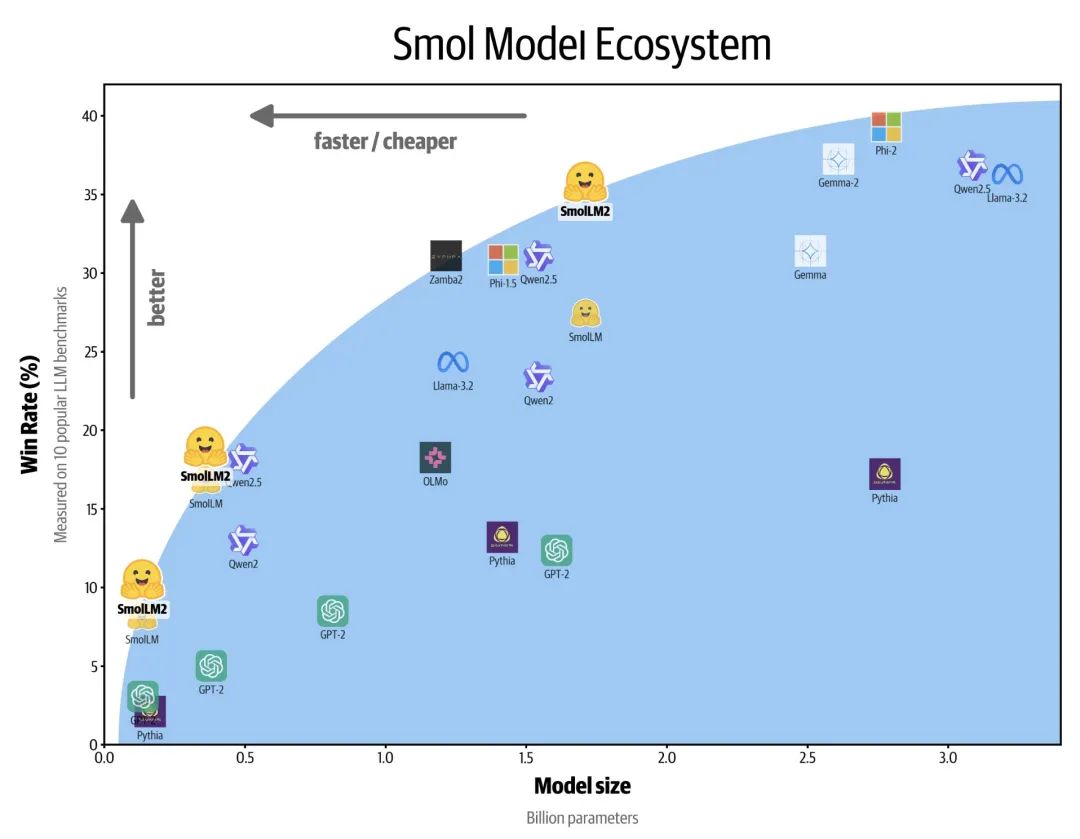

SmolLM2开源了:更快、更好、更便宜, 包含三个尺寸:135M、360M 和 1.7B。

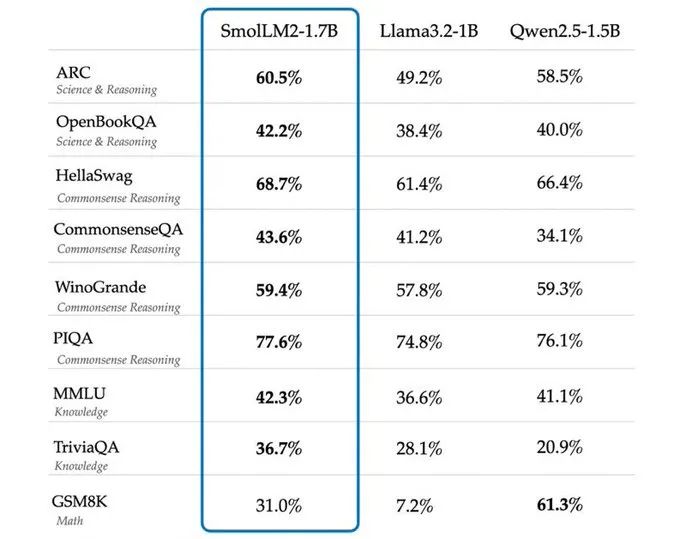

端侧小型语言模型新星——SmolLM2 1.7B击败了Qwen 2.5 1.5B和Llama 3.2 1B:

-

Apache 2.0许可

-

训练于11万亿个令牌

-

在FineWeb-Edu、DCLM、The Stack以及新的数学和编码数据集上训练

-

专门用于文本重写、总结和函数调用

-

使用 UltraFeedback 的直接偏好优化(DPO)

-

可以在Q4上用不到2GB的VRAM运行SmolLM2 1.7B

https://huggingface.co/collections/HuggingFaceTB/smollm2-6723884218bcda64b34d7db9https://hf-mirror.com/HuggingFaceTB/SmolLM2-1.7B-Instruc

来源 | PaperAgent

LLM热点Paper23

LLM热点Paper · 目录

上一篇o1背后的秘密:6种推理模式解析!

1183

1183

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?