CVPR2025开放注册的第一天,注册人数就已达数千人,火爆程度可见一斑。今年的投稿规则也有更新,开启半实名制并对投稿篇数做了限制。今年AAAI和ICLR都在CVPR截稿前rebuttal,想必CVPR的投稿数量会再创新高。想要从众多文章里脱颖而出,除了有一个精彩的idea,详实的实验数据也是必不可少的。

目前,距离CVPR截稿已进入倒计时,许多同学正进入实验和模型验证的关键阶段,压力逐步攀升。实验算力成了此刻最紧缺的资源,而算力的高效性不仅决定了实验进度,更影响整个论文工作的质量和完成度。如果你文章已写好但需要更丰富的实验数据,或者实验设备资源紧张只能熬夜赶工,又或者打定主意绝处逢生三周冲顶会,那么,你一定需要这个“加速神器”!

在论文截稿前,拥有高性价比的算力资源就像是“论文冲刺期的救命稻草”。每到这个时期,网上总有铺天盖地的抢不到卡的哀嚎。究其原因,还是小额随用随租的GPU资源量不够,无法满足学生群体日益增长的论文冲刺需求。没关系,潞晨云会出手。

先放网址,着急赶论文的朋友们可以先去把实验跑上:

【https://cloud.luchentech.com/】

实验上潞晨,效率大提升!潞晨云依托潞晨科技,拥有超强的技术实力,在大模型训练推理加速方面可谓一骑绝尘。潞晨云上提供的满血算力和高性能存储,将通讯、I/O等损耗降到最低,相比其他非独占GPU的平台,同等GPU型号速度更快。借助潞晨科技明星产品Colossal-AI深度学习框架,相同规格算力在潞晨云上可以获得更好的体验和更快的速度。此外利用平台提供的预设镜像和环境配置,可以跳过复杂的环境配置步骤,专注核心开发和实验工作。

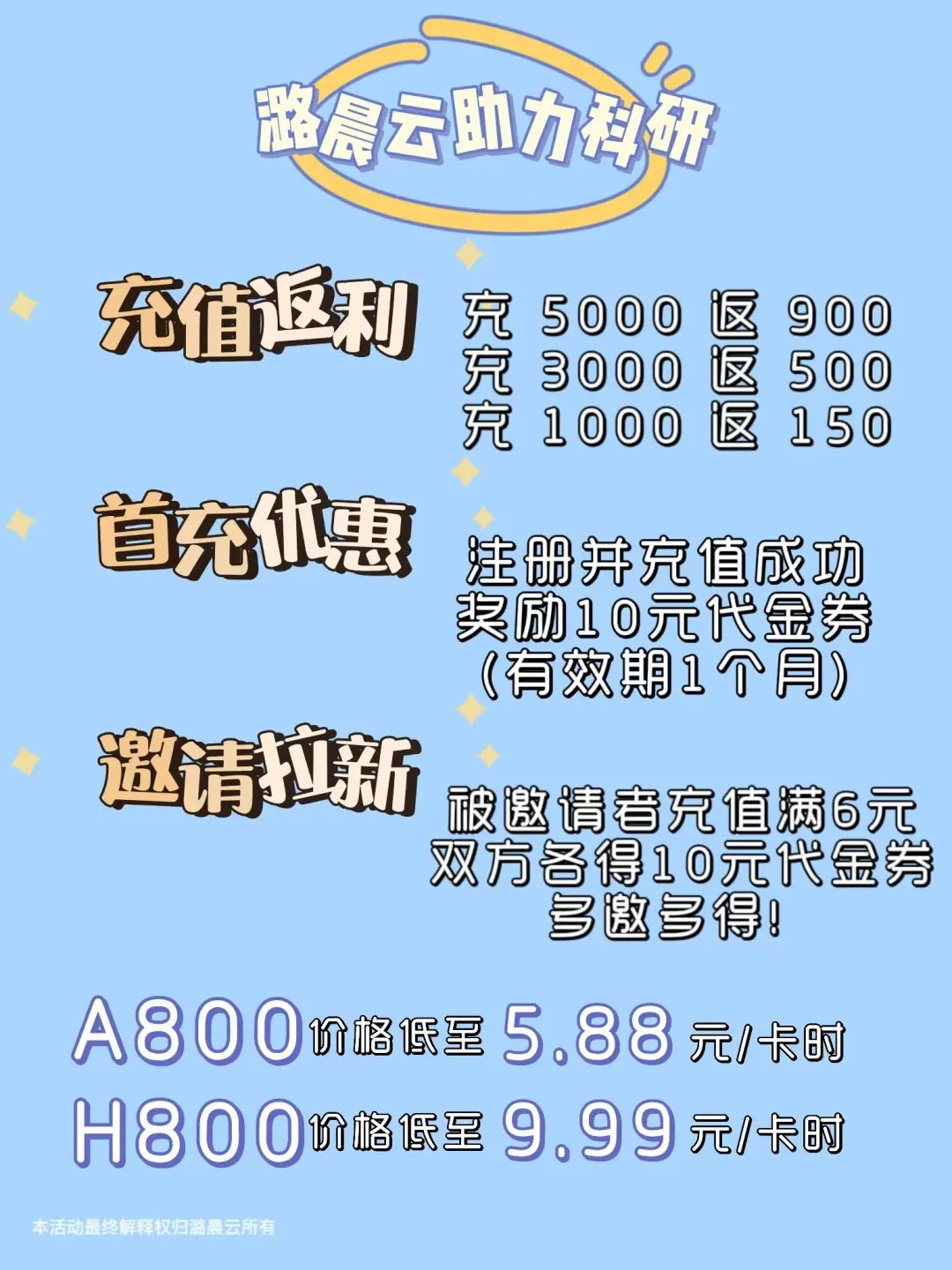

除了快人一步之外,潞晨云在价格方面也有很大优势。充值返利,首充优惠和特价机器层出不穷,赶紧叫上同实验室的小伙伴一起来潞晨云冲刺!

赶paper,最怕的就是服务器出问题。潞晨云上所有算力均经过多重测试验证,保证机器运行稳定,可以高效助力论文实验。另外,潞晨云拥有活跃的社群环境,超多小伙伴24小时在线讨论,更有客服和技术人员在线支持,快速响应,为你的实验保驾护航!

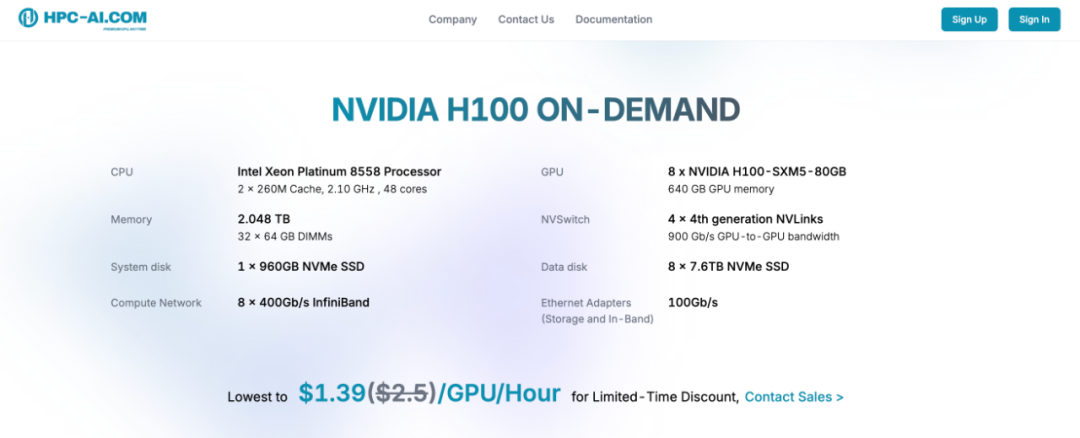

对于实验需要更高端算力支持的同学们,小编还搜刮到了H100算力,首台最低仅用8元可租赁一小时,Hugging Face直连下载速度逼近100MB/s,一台更比六台强。直戳HPC-AI.COM注册可免费领十刀。

最后,祝愿所有投稿的同学们在CVPR、ICML等学术会议中取得优异的成绩,在学术道路上不断进步,收获满满,早日实现自己的研究梦想~ 点击“阅读原文”马上补实验。

681

681

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?