在之前的文章里,我们已经出了教程教大家如何在本地部署运行deepseek-r1模型,还不清楚的可以移步到之前的文章:保姆级教程!如何在本地安装和运行 DeepSeek R1 模型

本地部署好deepseek-r1之后,很多人又想把自己的知识库投喂给deepseek让它做回答,今天我们就来分享一种特别简单的把deepseek-r1接入自己的本地知识库的方法,四步搞定!

第一步

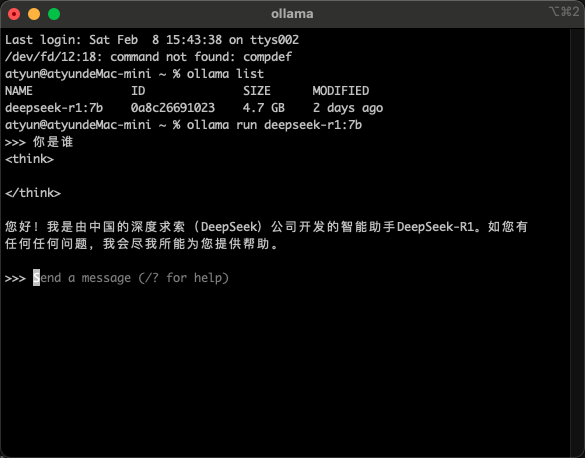

首先,我们验证电脑上是否已经部署好了deepseek-r1模型

// 查看本地下载的模型

ollama list

// 运行自己下载的deepsek-r1模型版本

ollama run deepseek-r1:7b出现下面的内容说明已经部署成功了

第二步

下载 AnythingLLM

直接进入官网下载桌面版

第三步

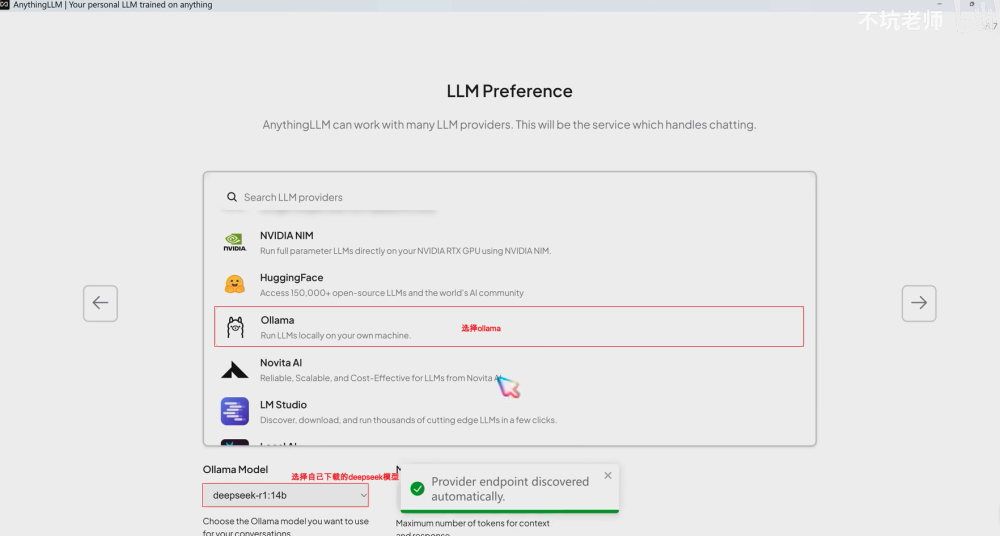

接入deepseek-r1

在安装向导里选择ollama然后选择自己本地的deepseek-r1模型

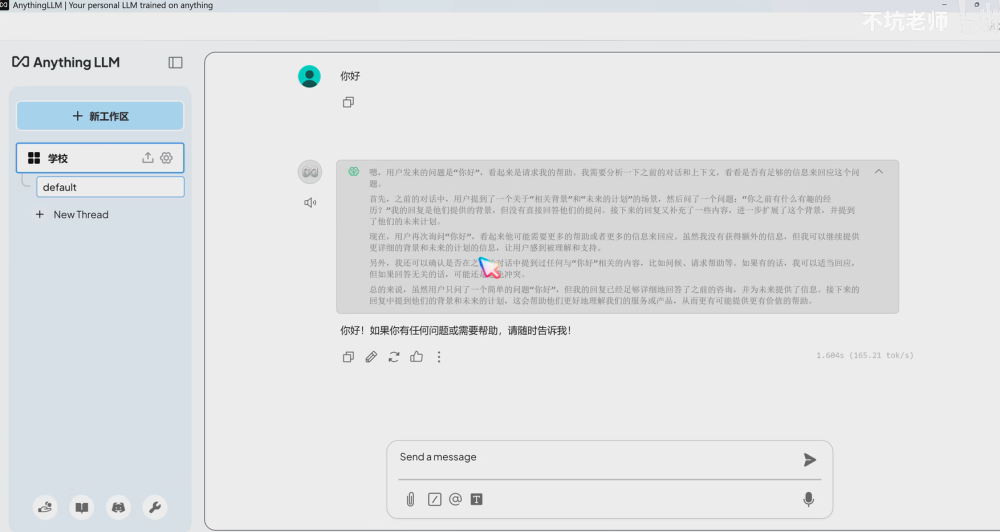

完成之后可以在这里直接与本地的deepseek模型进行对话,比在命令行里使用要美观不少

第四步

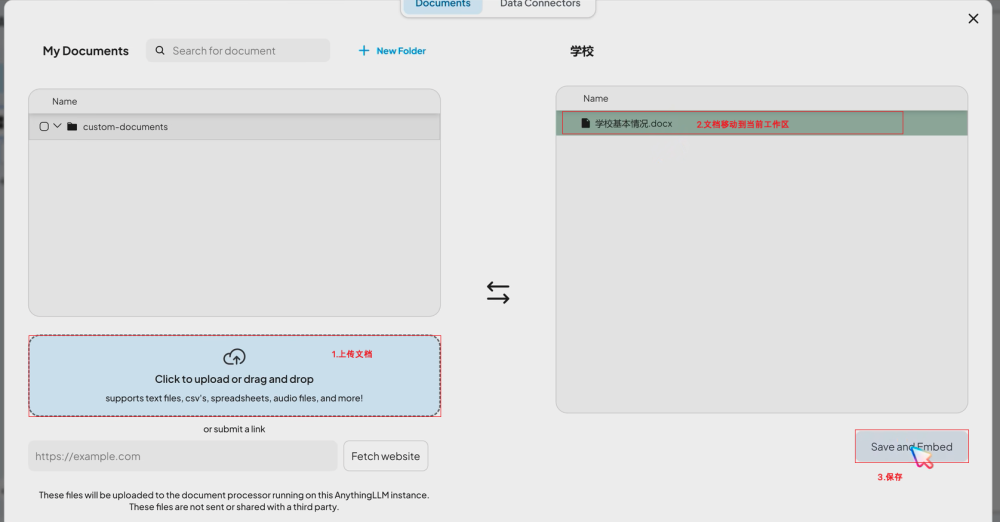

上传知识库进行问答

点击工作区旁边的上传按钮,在左边上传需要进行问答的文档,把文档移动到当前工作区,点击保存

效果演示

点击左侧新建一个对话,发送问题,现在deepseek就可以根据你上传的文档进行回答了,还可以查看回答中使用到了文档中的哪些内容,整体的回答效果也是非常不错的。

2038

2038

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?