预训练GNN借鉴了自然语言处理和计算机视觉领域中预训练模型的成功经验,旨在通过在大规模无标签图数据上进行预训练,学习到通用的图结构表示和特征提取能力。这些预训练模型就像是掌握了“基础知识”的学生,在面对特定的下游任务时,只需进行少量的微调,就能快速适应并展现出优异的性能。

通过预训练,GNN可以更有效地捕捉图中的节点关系、拓扑结构以及各种隐藏的特征模式,极大地提升了模型的泛化能力和学习效率,为解决实际应用中的复杂图分析问题提供了有力支持。

为此,我们精心整理了12篇顶刊前沿论文,从不同角度和方法对预训练GNN进行创新,希望对大家有所帮助!

点击【AI十八式】的主页,获取更多优质资源!

【论文1:WWW 2024】GraphPro: Graph Pre-training and Prompt Learning for Recommendation

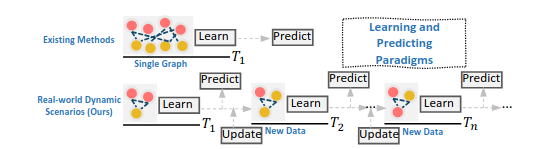

Dynamic recommendation setting compared to the vanilla single-graph training in existing methods.

1.研究方法

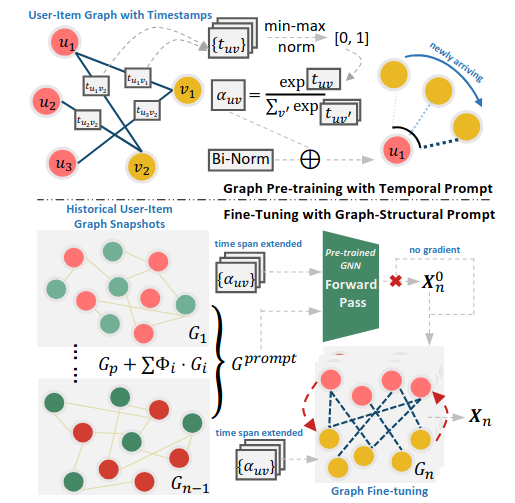

Overall framework of GraphPro.

该论文提出了 GraphPro 框架,将动态图预训练与提示学习相结合,以提升推荐系统对时间动态的适应性和可扩展性。GraphPro 先在大量历史交互数据上预训练图神经网络(GNN),学习长期用户偏好和物品相关性;微调阶段,通过时间提示机制和图结构提示学习机制,融入新数据的时间信息,快速适应变化的用户偏好,捕捉短期行为动态。

2.论文创新点

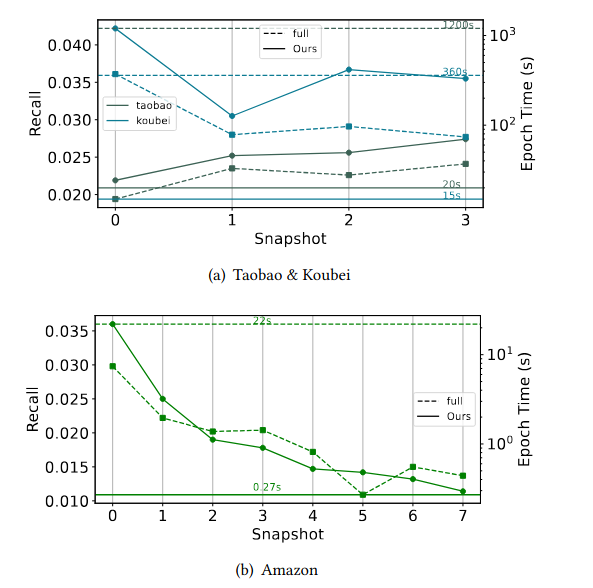

GraphPro v.s. full-data training using LightGCN.The results with the average training time for a single epochare being depicted by a horizontal line on the right Y-axis.

-

有效预训练和微调:强调有效且可扩展地预训练和微调图基推荐器的重要性,以适应用户偏好的变化,在动态环境中实现精准推荐。

-

引入GraphPro框架:通过GNN的预训练和微调,有效处理用户偏好的演变。提示学习范式从时间和结构上实现知识转移。

-

动态评估框架:提出基于快照的动态设置评估推荐系统,比传统方法更贴近现实推荐场景。

-

实验验证优势:在多种数据集上实验,展示了GraphPro在鲁棒性、效率和性能方面的优势,并进行行业部署验证。

论文链接:https://arxiv.org/abs/2311.16716

【论文2:AAAI 2024 】Empowering Dual-Level Graph Self-Supervised Pretraining with Motif Discovery

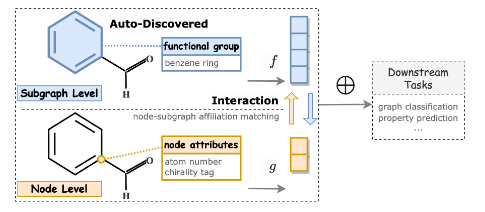

Toy example showing interactive dual-level graph pretraining.

1.研究方法

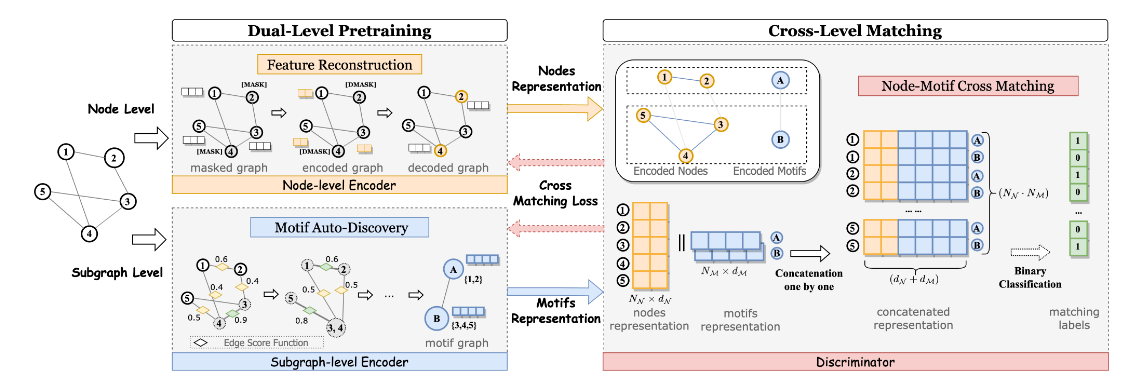

The DGPM framework comprises two main components: Dual-level pretraining and Cross-level matching. The Dual-level pretraining encompasses a node-level feature reconstruction task and a subgraph-level motif auto-discovery task.

这篇论文提出的 DGPM 模型针对图自监督预训练存在的问题,设计了双级预训练和跨级匹配任务来提升性能。DGPM 旨在学习图的节点级属性和子图级结构,通过节点特征重建任务捕捉局部节点信息;利用自定义的 EdgePool 层自动发现子图结构信息(motif),并通过图相似性损失对齐学习到的子图表示;还建立了节点 - 子图匹配任务,实现节点级和子图级训练的交互连接。

2.论文创新点

-

提出新的预训练架构:设计DGPM双级图预训练架构,是首个利用motif自动发现机制在自监督学习中利用子图结构信息的图预训练框架,解决现有图自监督预训练的拓扑学习有限、依赖人类知识和多层级交互不足的问题。

-

引入子图级预训练任务:提出子图级预训练的新任务,通过motif自动发现模块自主揭示图结构中的关键模式,增强图预训练模型的泛化能力,并提供可视化motif,提升模型的可解释性。

-

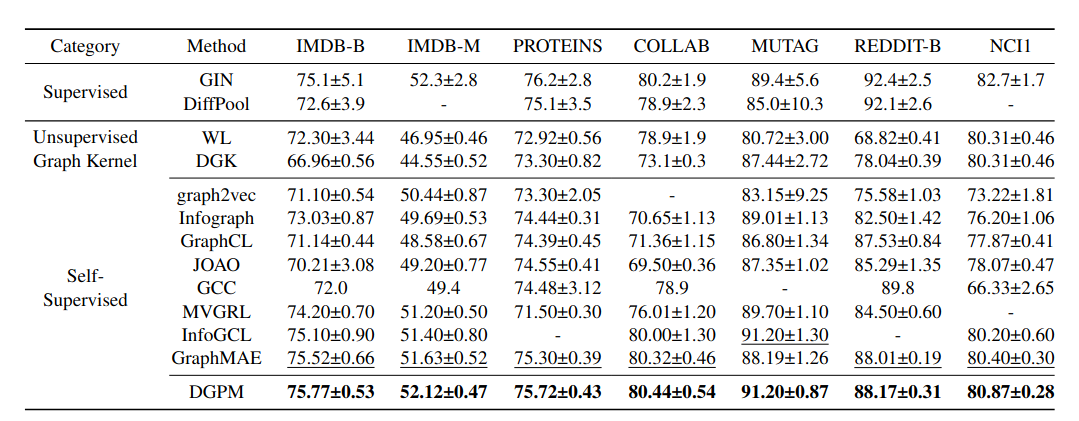

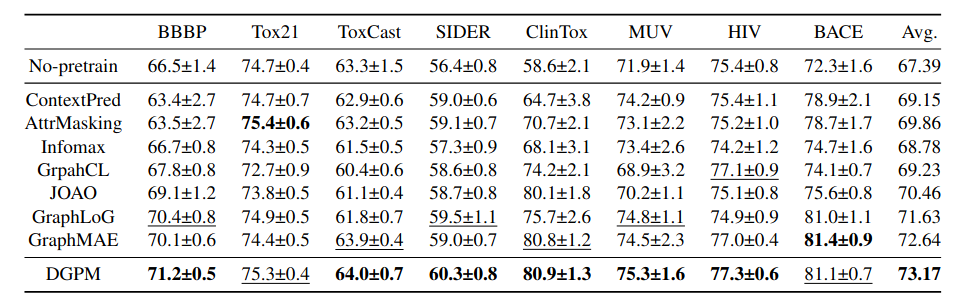

实验验证优越性:在15个基准数据集上进行广泛实验,与多个强基线模型对比,证明了DGPM的优越性和泛化能力。通过对学习到的motif分析,进一步证明其提升可解释性的潜力。

论文链接:https://arxiv.org/abs/2312.11927

点击【AI十八式】的主页,获取更多优质资源!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?