Stability AI又放大招!

现在,Stable Diffusion也能生成视频了。AI届,实在是太卷了。

Stability AI发布了一款专为艺术家和开发人员设计的工具——Stable Animation

SDK。用户可以通过多种方式创建令人惊叹的动画效果。

此前,Runway的Gen-2就相当炸裂,宣传词非常霸气——「say it,see it」。

现在,Stability AI也有比肩Gen-2的视频生成工具了!

Stable Diffusion能做视频了

借助Stability AI的动画端点,美术师可以使用所有Stable Difusion模型来生成动画,包括Stable Diffusion

2.0和Stable Diffusion XL。

不过,有别于之前发布的开源模型,Stable Animation目前仅能通过SDK和付费API使用。

现在,用这三种方式,都可以创建动画了——

- 经典的prompt

就像使用Stable Diffusion、Midjourney或DALL-E

2一样,用文本生成动画。

输入prompt,调整各种参数,就能生成动画。

- prompt+图像

提供一个初始图像,作为动画的基础。之后,结合prompt和这个初始图像,就能生成最终输出的动画。

- prompt+视频

提供一个初始视频,作为动画的基础。同样,通过各种参数的调整,外加prompt的引导,最终得到输出的动画。

1块钱,就能生成100帧动画

该软件似乎仍处于测试阶段。Stability

AI并没有通过他们的浏览器平台(如DreamStudio或ClipDrop)提供,而是仅提供软件开发套件(SDK)和付费API。

当然,这并不妨碍第三方通过服务提供这种动画模型。

不过,目前想试用这个功能的话,门槛还比较高,因为SDK和API要通过Python脚本来调用。

与Stability AI的图像模型类似,Stable

Animation也可以设置许多参数,例如step、sampler、scale或seed。此外,还提供了诸如outpainting或prompt

interpolation等功能。

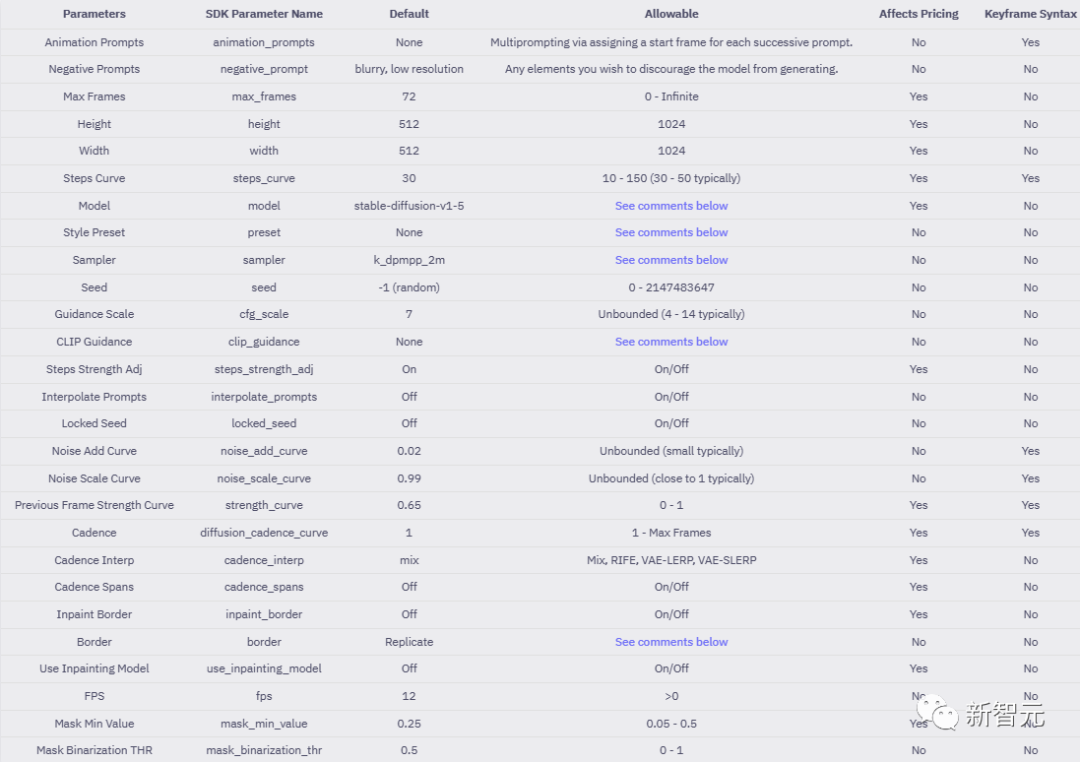

不同的参数也会影响价格。所以创建一个视频要花费多少钱,并不确定。

Stability给出的报价范围是,在不同设置下,每100帧的价格从3美分到18美分不等。

Stability AI以输出动画的积分值作为收费的依据,用户生成的动画会被换算成一个积分,每1000个积分消耗1美元。

小编算了一下,根据官方公布的积分计算方法,一块钱人民币大概能生成一段100帧的1024*1024分辨率的动画。

但是其他的参数也会影响价格,官方给了一个表来说明支持调整的参数,以及是否会影响到生成动画的价格。

与Stable Diffuision XL兼容

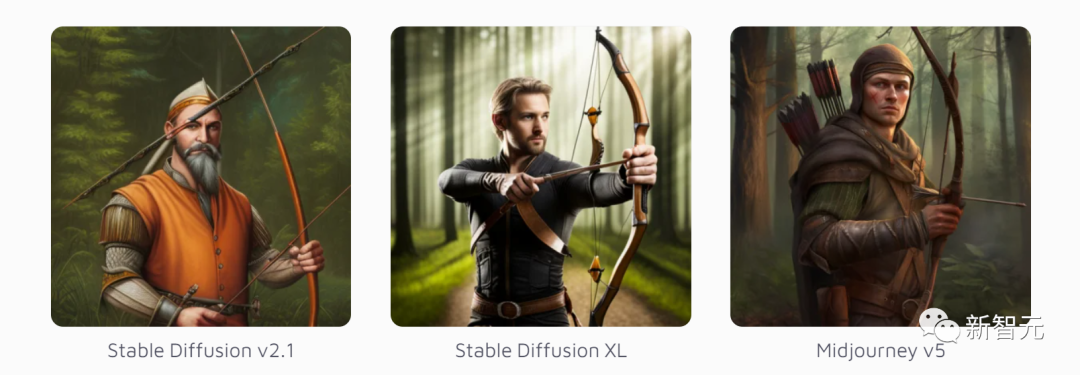

Stable Animation可以与每个版本的Stable Diffusion结合使用。

它的默认版本是1.5,但我们也可以选择使用新版的Stable Diffusion XL。

里面有很多样板,包括动漫、漫画书、低多边形、像素艺术。

原始分辨率是512 x 512像素,可以增加到1,024 x 1,024像素。此外,可以使用升频器。

Stable Animation的默认值是72 帧(12帧每秒),但根据说明,它可以增加到无穷大。

此前,Stability AI就已经有了基于Stable Diffusion的动画工具,比如,我们可以通过prompt

interpolation(不断改变prompt的某些属性)生成一小段动图。

这次的升级的不同之处在于,table Animation生成视频的能力更全面、更成熟。

虽然现在,AI还没进化到让我们按个按钮就能生成电影,但Stable Animation、Runway ML、Phenaki、Imagen

Video等模型的超强进化,已经预示了视觉生成AI的视频生成功能,会越来越惊艳。

网友实测

Stable Animation一发布,网友们就按捺不住自己渴望尝试的小手。

比如,npaka就分享了自己的使用体验。

首先,将DreamStudio的API密钥设置为本机的环境变量。

然后,准备Python虚拟环境,并安装stability_sdk并启动Animation GUI。

$ pip install 'stability_sdk[anim_ui]' $ python -m stability_sdk animate --gui

* 1

Running on local URL: http://127.0.0.1:7860

* 1

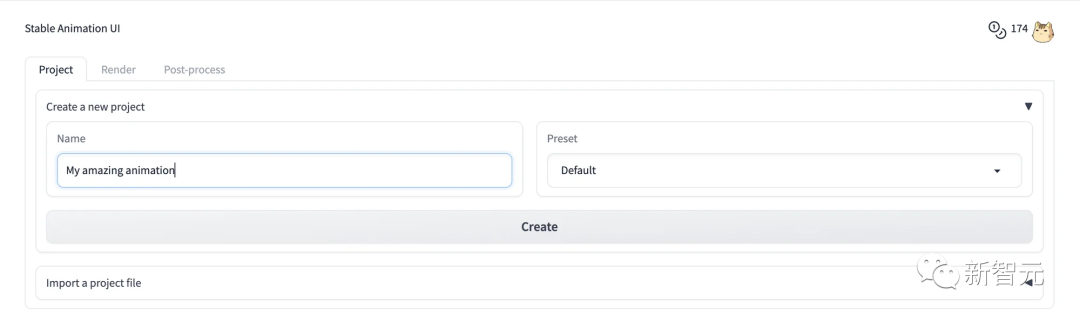

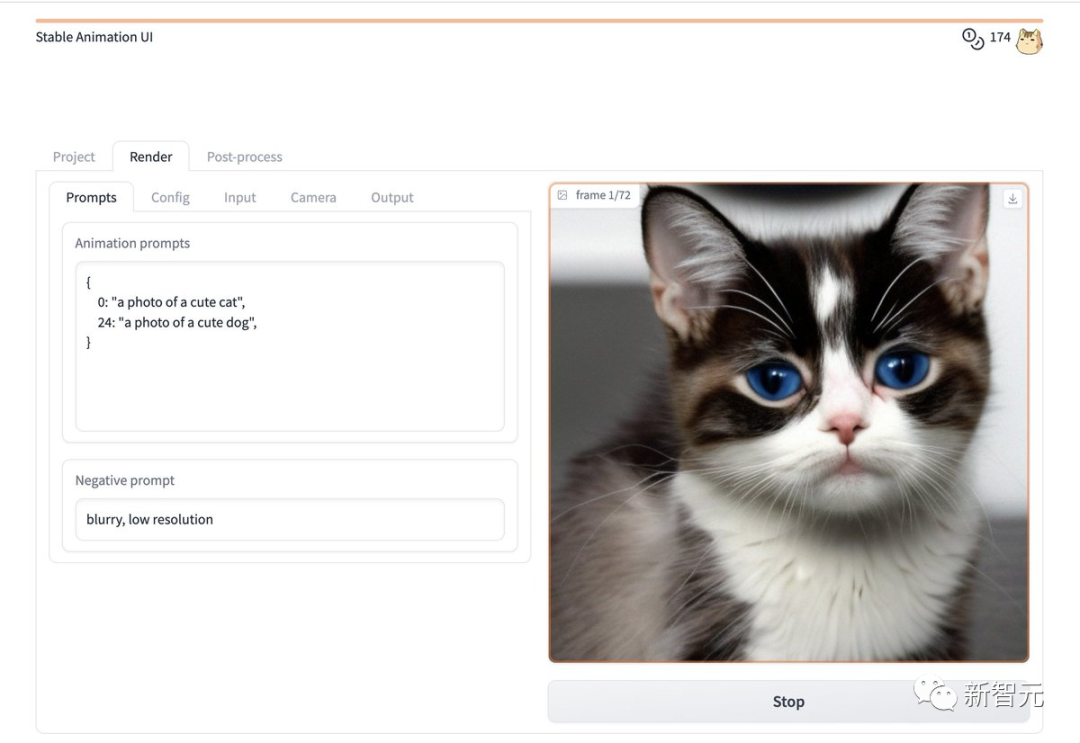

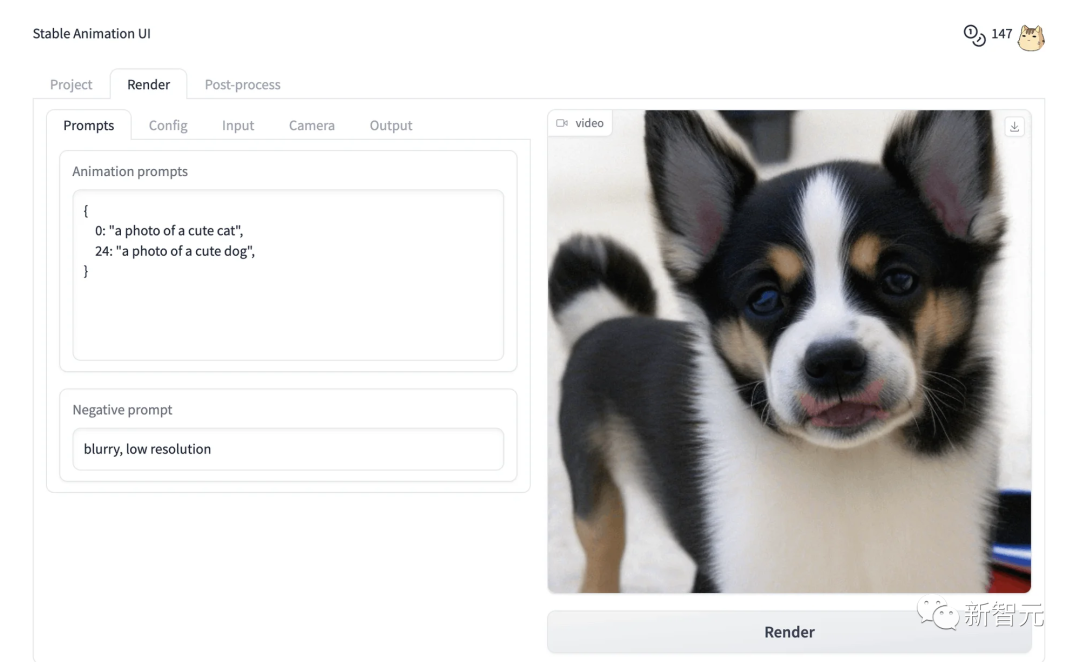

用浏览器打开显示的网址后,就可以在「Project」选项卡中创建项目了。

在「Render」选项卡中设置文本提示,然后按「Render」按钮。

最后,动画就做好啦。

此外,还有一些网友也分享了自己的作品。

AI离生成电影还有多远

AI生成视频的功能如此强大,已经有网友打算投资AI动画工作室了。

这位表示,脑洞已准备好,就等一个用户友好的动画工具了。

网友们的畅想并不遥远,最近,Wes Anderson的《指环王》的新预告片中,就用到了不少AI工具。

,时长01:30

OpenAI前AI主管Andrej Karpathy猜测,这部预告片中至少用到了Midjourney/Stable

Diffusion、ControlNet、 ElevenLabs、D-Id、ChatGPT、Adobe等工具。

看来,AI视觉工具再这么进化下去,取代好莱坞大导不会太远了。

这是一位SD资深大神整理的,100款Stable Diffusion超实用插件,涵盖目前几乎所有的,主流插件需求。

全文超过4000字。

我把它们整理成更适合大家下载安装的【压缩包】,无需梯子,并根据具体的内容,拆解成一二级目录,以方便大家查阅使用。

单单排版就差不多花费1个小时。

希望能让大家在使用Stable Diffusion工具时,可以更好、更快的获得自己想要的答案,以上。

如果感觉有用,帮忙点个支持,谢谢了。

想要原版100款插件整合包的小伙伴,可以来点击下方插件直接免费获取

100款Stable Diffusion插件:

面部&手部修复插件:After Detailer

在我们出图的时候,最头疼的就是出的图哪有满意,就是手部经常崩坏。只要放到 ControlNet 里面再修复。

现在我们只需要在出图的时候启动 Adetailer 就可以很大程度上修复脸部和手部的崩坏问题

AI换脸插件:sd-webui-roop

换脸插件,只需要提供一张照片,就可以将一张脸替换到另一个人物上,这在娱乐和创作中非常受欢迎。

模型预设管理器:Model Preset Manager

这个插件可以轻松的创建、组织和共享模型预设。有了这个功能,就不再需要记住每个模型的最佳 cfg_scale、实现卡通或现实风格的特定触发词,或者为特定图像类型产生令人印象深刻的结果的设置!

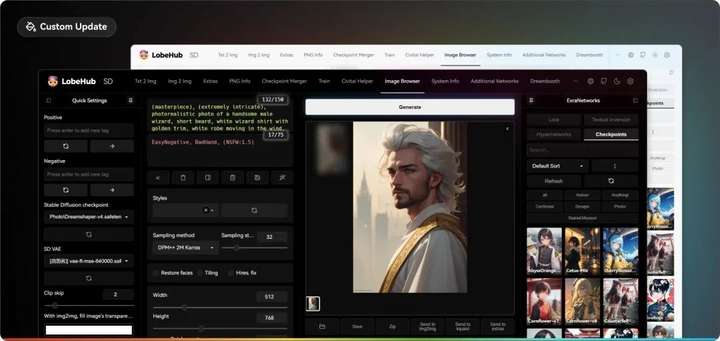

现代主题:Lobe Theme

已经被赞爆的现代化 Web UI 主题。相比传统的 Web UI 体验性大大加强。

提示词自动补齐插件:Tag Complete

使用这个插件可以直接输入中文,调取对应的英文提示词。并且能够根据未写完的英文提示词提供补全选项,在键盘上按↓箭头选择,按 enter 键选中

提示词翻译插件:sd-webui-bilingual-localization

这个插件提供双语翻译功能,使得界面可以支持两种语言,对于双语用户来说是一个很有用的功能。

提示词库:sd-webui-oldsix-prompt

提供提示词功能,可能帮助用户更好地指导图像生成的方向。

上千个提示词,无需英文基础快速输入提示词,该词库还在不断更新。

以后再也不担心英文写出不卡住思路了!

由于篇幅原因,有需要完整版Stable Diffusion插件库的小伙伴,点击下方插件即可免费领取

4451

4451

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?