在 AI 技术飞速渗透企业场景的今天,选择大型语言模型(LLM)还是小型语言模型(SLM),已成为困扰众多国内开发者和技术决策者的核心问题。前者凭借海量参数横扫通用场景,后者却以"小而专"的优势在垂直领域异军突起。本文结合两篇权威报告的核心观点,从定义、差异、实战案例到选型建议,全方位解析 SLM 与 LLM 的应用逻辑,助力国内开发者精准匹配业务需求。

1 核心概念:SLM 与 LLM 的本质区别

- 小型语言模型(SLM):精准适配特定场景的"轻量专家"

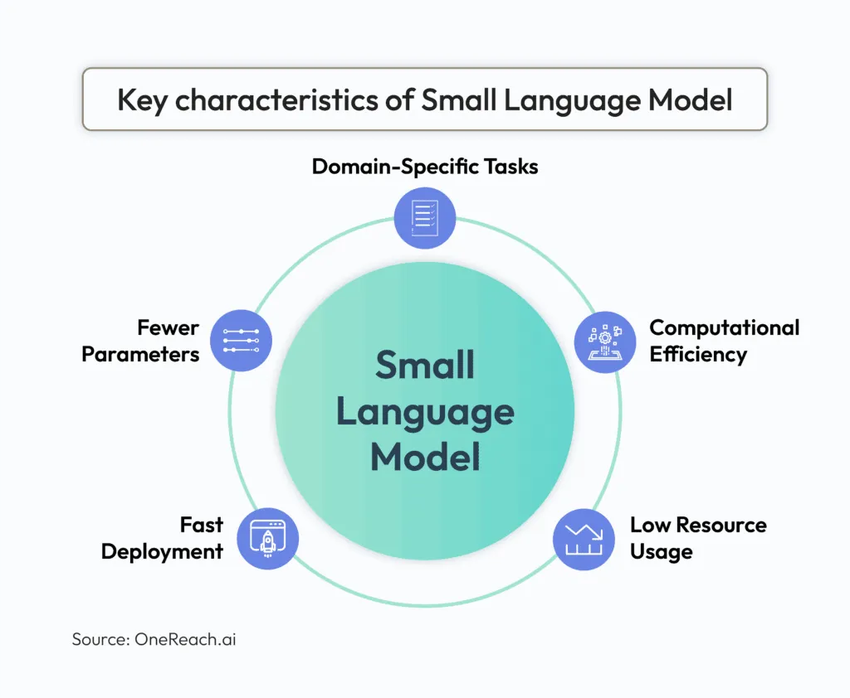

SLM 是一类针对细分语言任务优化设计的 AI 模型,核心特点是资源需求低、部署灵活、领域专精。其参数规模通常在数千万到数亿之间(远低于 LLM 的百亿级甚至万亿级参数),通过聚焦特定领域数据训练,实现对目标任务的高精度响应。

关键特征包括:

-

参数精简:参数量从数千万到数亿不等(如微软 Phi-3 Mini 仅 38 亿参数、阿里 Qwen2.5-1.5B 为 15 亿参数);

-

任务聚焦:专为 niche 场景设计,例如发票数据解析、客服工单分类、法律条款分析等;

-

推理高效:优化后的架构使响应速度更快,支持边缘设备实时处理;

-

资源友好:低能耗、低算力需求,可部署于手机、边缘网关等资源受限设备;

-

成本可控:训练与部署成本显著低于 LLM,适合中小企业规模化应用。

- 大型语言模型(LLM):覆盖通用场景的"全能选手"

LLM 以海量参数和广谱训练数据为基础,擅长开放式推理与创造性任务,是通用 AI 能力的核心载体。其优势在于跨领域理解能力强,能处理复杂的自然语言交互、内容生成等任务,但同时存在资源消耗大、领域精度不足等局限。

- 核心差异对比表

| 对比维度 | 小型语言模型(SLM) | 大型语言模型(LLM) |

| 参数规模 | 数千万-数亿 | 百亿-万亿 |

| 训练数据 | 小体量、领域专属数据集 | 大体量、多领域混合数据集 |

| 计算需求 | 低(支持 CPU/边缘设备,内存占用小) | 高(依赖 GPU 集群,内存占用为参数 3-6 倍) |

| 定制能力 | 可通过私有数据微调,适配特定任务 | 可微调但成本高,适合复杂场景定制 |

| 成本投入 | 训练/部署成本低 | 训练/部署成本极高 |

| 领域能力 | 垂直领域精度高,专业度强 | 通用知识广博,领域深度不足 |

| 简单任务表现 | 优秀(精度达标且响应更快) | 优秀-卓越(但性价比低) |

| 复杂任务表现 | 能力有限(如长文本理解、创意生成) | 能力突出(支持开放式对话、复杂推理) |

| 可解释性 | 高(架构精简,易于调试) | 低(黑箱特性明显) |

| 典型模型 | Phi-3 Mini、Llama3.2-1B、Qwen2.5-1.5B、Gemma3-4B | GPT-4、Mistral、Claude 系列 |

| 部署场景 | 边缘设备、本地服务器、中小企业应用 | 云端集群、大型企业定制化平台 |

2 SLM 超越 LLM 的关键场景:为何"小模型"能赢"大模型"?

IDC 预测 2028 年全球 AI 支出将达 6320 亿美元,但 Gartner 指出 30%的生成式 AI 项目将在 2025 年底前终止,核心原因在于 LLM 的"通用性陷阱"——高成本与低精度的矛盾。而 SLM 通过以下优势,成为企业级 AI 的务实选择:

- 领域精度更高:避免"大而不精"的幻觉问题

LLM 的核心缺陷是"幻觉现象"(生成虚假信息),而 SLM 通过领域专属数据训练,能显著提升响应的准确性。例如医疗领域的 Diabetica-7B(一款 70 亿参数的 SLM),在糖尿病相关测试中的精度甚至超越 GPT-4,完美体现了"专精优于广谱"的价值。

- 部署更灵活:适配国内企业的多样化环境

国内大量中小企业面临算力有限、数据隐私合规严格等问题,SLM 的边缘部署能力恰好解决这一痛点:

-

无需依赖云端算力,降低网络延迟(如 Phi-3 Mini 可直接运行于手机端);

-

数据本地处理,符合 GDPR、HIPAA 及国内数据安全法规,尤其适合医疗、金融等敏感领域;

-

支持模块化集成,可与 API、工具链组合构建 AI Agent 系统。

- 成本优势显著:降低 AI 落地门槛

LLM 的训练与微调需消耗巨量算力(仅优化器状态和激活值存储就需 3-6 倍于参数的内存),即使采用 LoRA/QLoRA 等技术,成本仍远超中小企业承受范围。而 SLM 不仅训练成本低,还可运行于普通 CPU(如 Cohere 的 Command R7B),大幅降低企业 AI 转型的资金门槛。

- 适配 Agentic AI:成为智能代理的核心引擎

Agentic AI(智能代理)作为下一代 AI 形态,需要具备环境感知、自主规划、实时响应等能力,而 SLM 的轻量特性使其成为理想载体:

-

低延迟推理支持实时交互(如机器人控制、日程管理);

-

模块化设计可灵活组合工具链;

-

多模态能力(如 Gemma3-4B 支持文本、图像、音频处理)能丰富代理交互方式。

3 实战案例:SLM 在企业场景的落地成效

- 多智能体系统:30 亿参数模型超越行业标杆

H 公司基于 SLM 构建的多智能体系统 Runner H(仅 30 亿参数),在复杂任务场景中实现 67%的任务完成率,显著超越 Anthropic 的大模型(52%完成率),证明 SLM 在协同任务中的高效性。

- 跨语言企业应用:CPU 部署支持 23 种语言

Cohere 的 Command R7B(70 亿参数 SLM)可运行于标准 CPU,在 23 种语言的问答任务中表现优异,完美解决跨国企业的多语言客服、文档处理需求,同时将算力成本降低 80%以上。

- 移动端 AI:性能比肩主流大模型

微软 Phi-3 Mini(38 亿参数)通过 3.3 万亿精选数据训练,在 MMLU 基准测试中得分 69%,MT-Bench 评分 8.38,不仅可流畅运行于手机端,在对话 AI 和代码生成任务中还超越了 Mixtral 8x7B 和 GPT-3.5。

- 国内场景适配:阿里 Qwen2.5-1.5B 的多语言优势

阿里推出的 Qwen2.5-1.5B(15 亿参数)作为多语言 SLM,在中文处理任务中表现突出,可广泛应用于电商客服、中文文本分类、短文本翻译等场景,部署成本仅为同类 LLM 的 1/10。

4 选型指南:SLM 与 LLM 的适用场景边界

- 优先选择 SLM 的场景

中小企业的低成本 AI 转型(如客服机器人、数据分类);

边缘设备部署需求(如工业传感器数据处理、移动端 AI 功能);

垂直领域高精度任务(如医疗报告分析、金融票据识别、法律条款提取);

数据隐私敏感场景(如本地文档处理、涉密信息分析);

实时响应需求(如实时客服、语音助手)。

具体应用示例:

-

自动回复常见客户咨询(FAQ 机器人);

-

社交媒体情感分析与关键词提取;

-

邮件分类(垃圾邮件、重要邮件筛选);

-

会议纪要生成与关键任务提取;

-

表单填写辅助与数据校验。

- 优先选择 LLM 的场景

开放式创意任务(如长篇内容生成、广告文案创作);

复杂推理需求(如科学研究分析、战略规划);

跨领域知识整合(如企业知识库问答、多学科咨询);

高复杂度自然语言处理(如技术白皮书翻译、法律合同审查)。

代码生成与调试、技术文档撰写;

海量医疗数据的治疗方案提取;

金融报告深度分析与投资建议生成;

危机公关沟通策略制定;

长篇小说、剧本创作。

- 关键提醒:RAG 技术的互补价值

需注意 SLM/LLM 与 RAG(检索增强生成)的本质区别:前者是模型规模与能力的定义,后者是系统架构(通过外部文档检索提升事实准确性)。两者可结合使用——SLM+RAG 能以低成本实现高精度事实问答,LLM+RAG 则可增强通用推理的可靠性。

5 挑战与未来展望

- SLM 的局限性需理性认知

跨领域适应性弱:离开专属领域后性能大幅下降;

上下文窗口有限:处理长文档(如百页合同)和多轮复杂对话能力不足;

涌现能力欠缺:在高阶推理、创意生成等任务中难以媲美 LLM。

- LLM 的不可替代之处

LLM 虽存在成本高、精度不足等问题,但在开放式理解、符号推理等方面仍有不可替代性。需明确:无辅助的 LLM 无法实现真实世界的自主决策,必须结合工具链、检索系统和安全护栏才能可靠运行。

- 国内发展趋势:SLM 将成企业 AI 主流

随着国产化算力提升和边缘计算普及,SLM 凭借"低成本、高适配、易部署"的优势,将成为国内中小企业 AI 转型的首选。未来趋势包括:

-

垂直领域 SLM 加速涌现(如制造业质检、政务数据处理专用模型);

-

多模态 SLM 融合文本、图像、语音能力,适配更多终端场景;

-

轻量化微调工具普及,降低企业定制 SLM 的技术门槛。

6 结语

SLM 的崛起并非意味着 LLM 的衰落,而是 AI 技术从"追求全能"向"精准适配"的理性回归。对于国内开发者而言,无需盲目追逐大模型参数规模,而应根据业务场景、资源预算和合规需求,选择最适合的技术路径——中小企业可从 SLM 切入快速实现 AI 落地,大型企业则可构建"LLM+SLM"混合架构(通用场景用 LLM,垂直场景用 SLM),最大化 AI 价值。

从通用大模型到专用小模型,AI 技术正变得更务实、更高效,而这正是企业数字化转型最需要的核心动力。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

598

598

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?