第三十一部分 创意文字和图案设计

31.1 通过AI生成各类艺术字图片

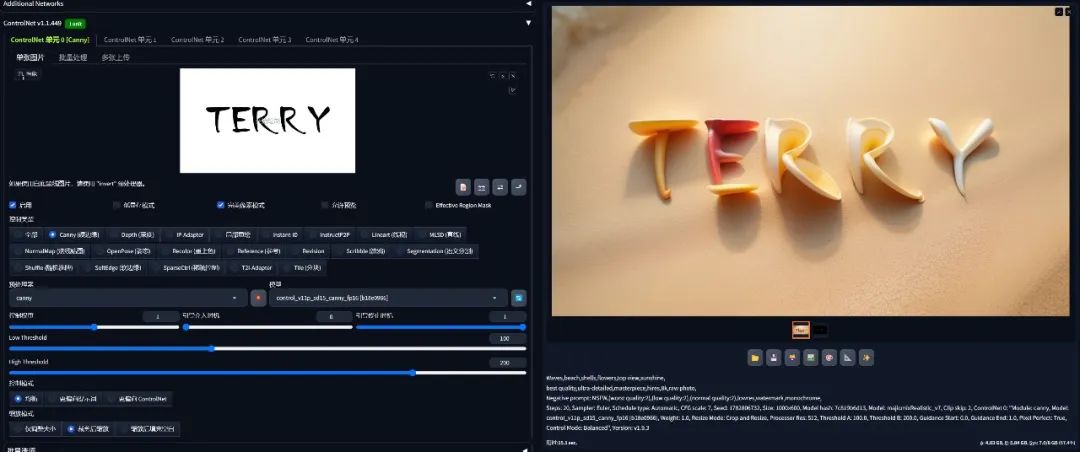

首先通过各类绘图软件或者office软件来生成一张白底黑字的图片

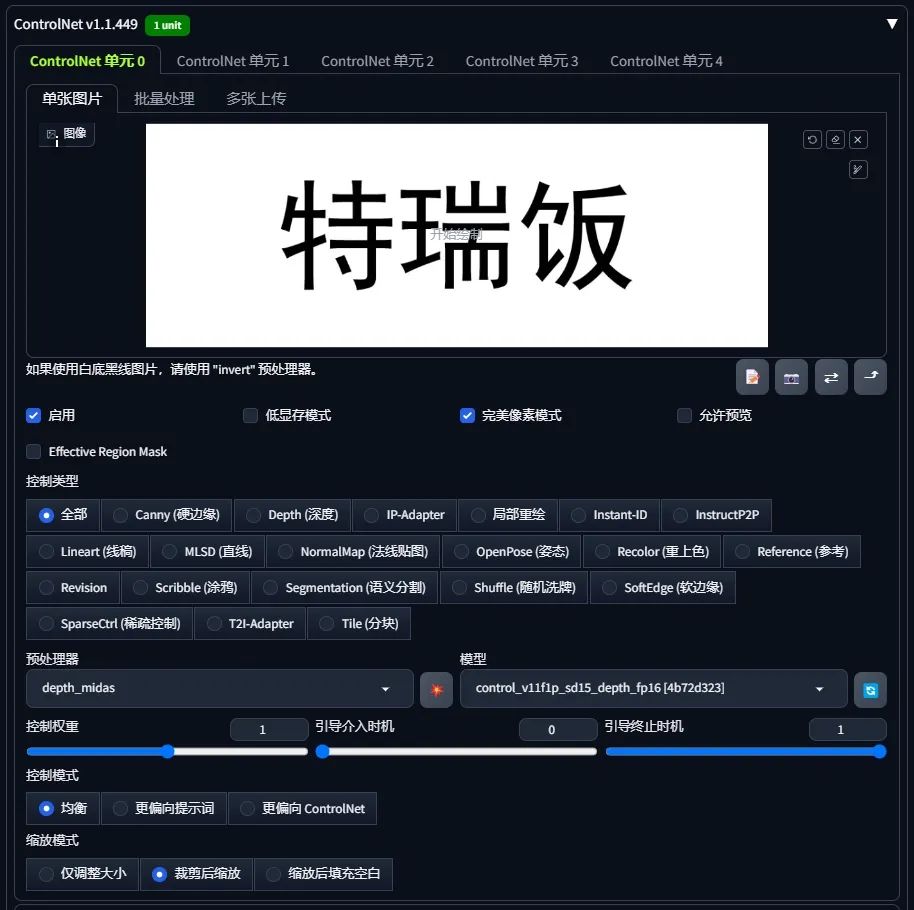

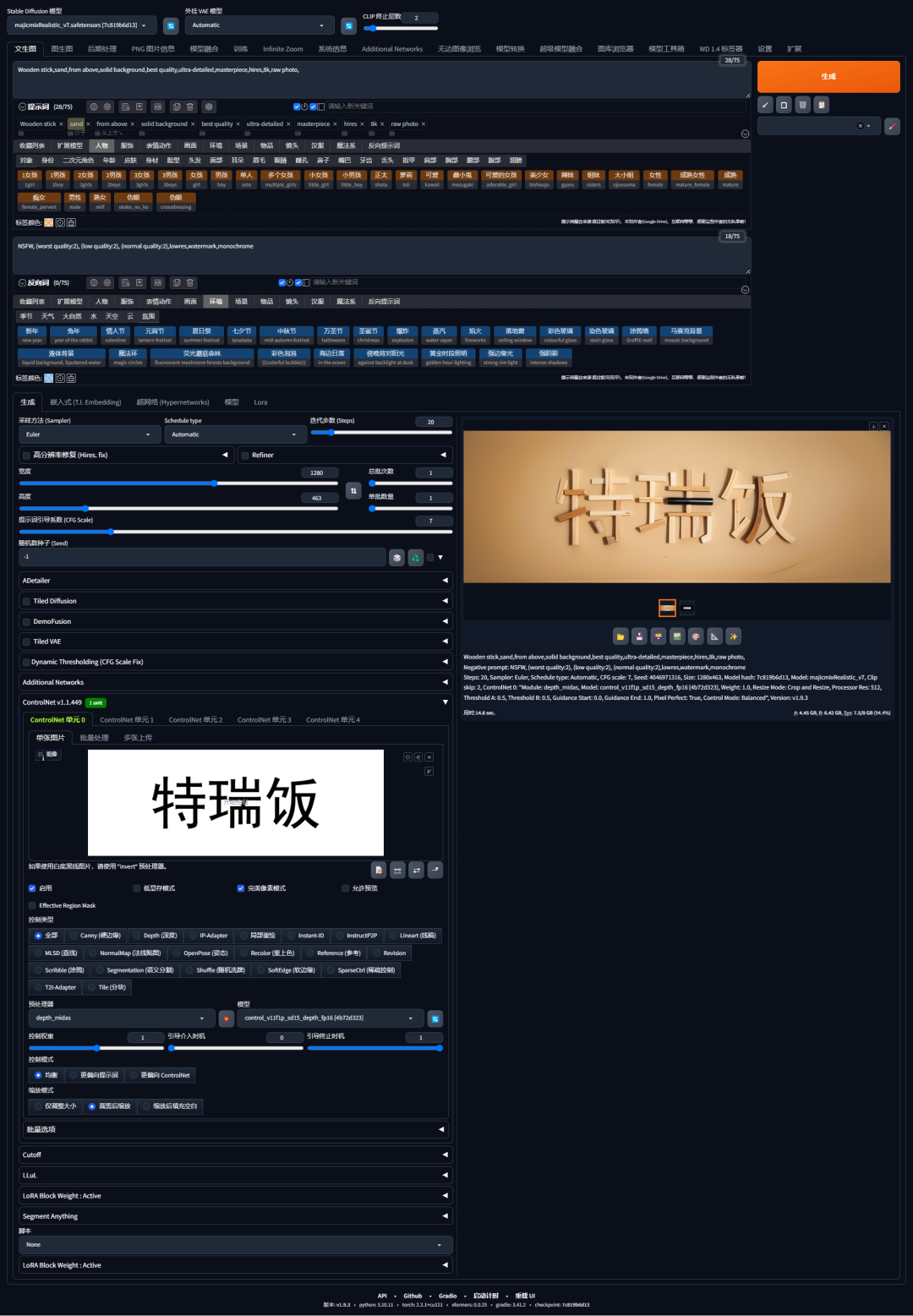

在Stable Diffusion WebUI中选择文生图,启用ControlNet,加载这张图,勾选"完美像素模式",选择Depth模型和Depth_midas预处理器,

然后选择一个checkpoint大模型,选择对应合适的采样方法,宽高比和原图一致,并书写提示词,示例:

正向提示词:

Wooden stick,sand,from above,solid background,best quality,ultra-detailed,masterpiece,hires,8k,raw photo,

反向提示词:

NSFW, (worst quality:2), (low quality:2), (normal quality:2),lowres,watermark,monochrome

点击生成,便生成了由一些木块所组成的示例文字,你也可以更改提示词来用其他材质和元素来生成。

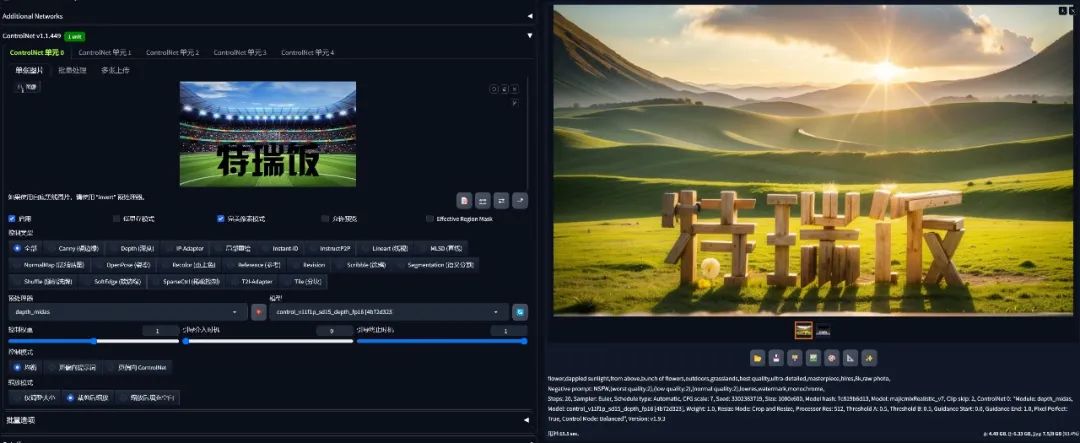

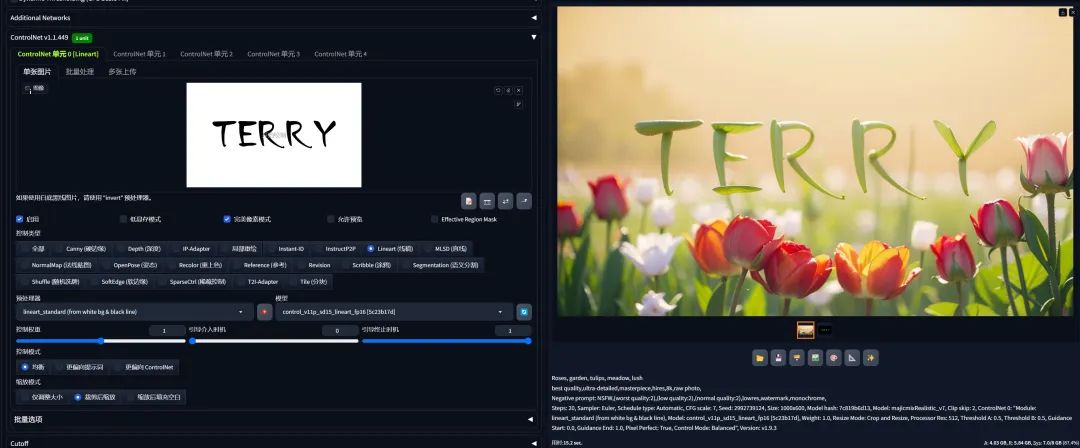

我们也可以加载一些不同的图案背景结合文字作为ControlNet的输入来生成图片,示例:

正向提示词:

flower,dappled sunlight,from above,bunch of flowers,outdoors,grasslands,best quality,ultra-detailed,masterpiece,hires,8k,raw photo,

反向提示词:

NSFW, (worst quality:2), (low quality:2), (normal quality:2),lowres,watermark,monochrome

31.2 参数组合和详解

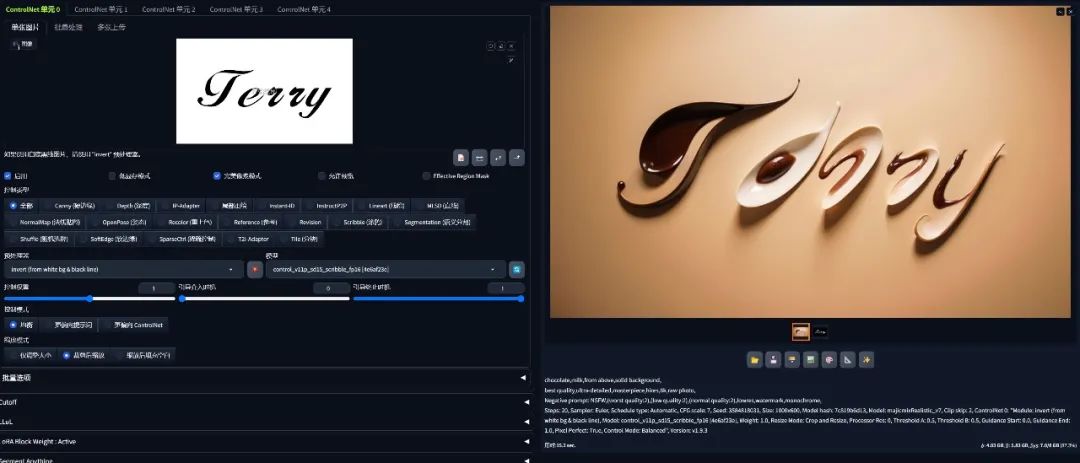

由于不同的预处理器和模型的组合可以使AI变换读取我们含文字的图片的方式,所以我们可以尝试变化不同的预处理器和模型的组合方式。

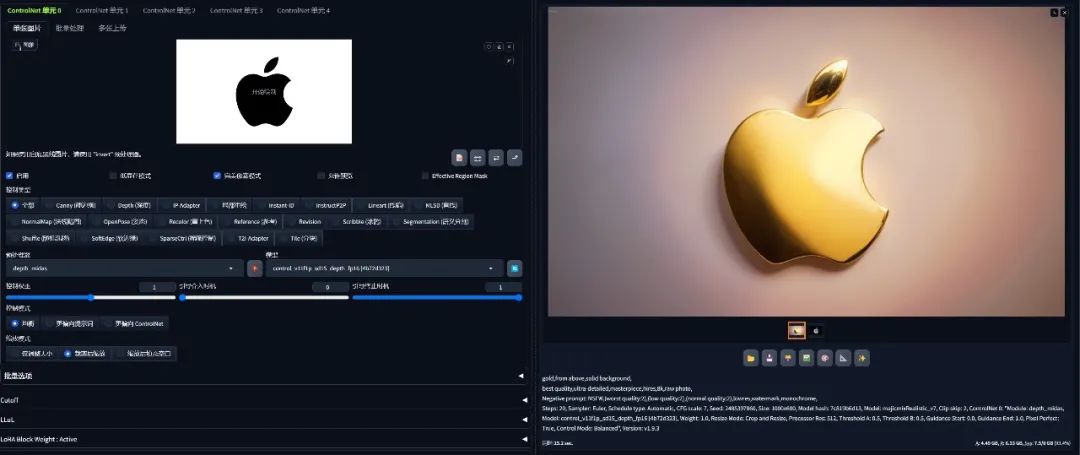

使用各类材质生成文字:Depth_midas预处理器+Depth模型。

如果你想把元素生成在文字以外的元素上,而文字部分镂空出来,只需要将预处理器设置为"无"即可。

如果你想让文字和画面融合在一起,可以使用Candy相关的预处理器和模型。

也可以使用Lineart相关的预处理器和模型。

对于一些线条较细的字体,我们可以使用invert+scribble。

由此看来,通过不同的组合可以实现各种不同的惊艳效果,那到底底层控制的核心参数是什么呢?

1.控制权重

如果你希望生成的图片形状严格参照你的加载图,那就调高一些,如果你希望让AI有一定自由发挥的空间,就可以适当调低这个权重。

2.引导介入时机

这个参数是指AI在生成图片的整个过程中,ControlNet什么时候开始介入工作,0是代表整个工作流程时间轴的起点,你可以调到0.1,那就是图片生成过程的10%的时候ControlNet开始工作。和控制权重类似,介入时机越晚,AI自由发挥的空间就越大。

3.引导终止时机

这个参数是指AI在生成图片的整个过程中,ControlNet什么时候终止工作,1是代表整个工作流程时间轴的终点,你可以调到0.9,那就是图片生成过程的90%的时候ControlNet终止工作。和控制权重类似,终止时机越早,AI自由发挥的空间就越大。

另外,我们不仅可以生成文字形状的图案,也可以利用各类Logo来生成类似形状图案。

31.3 生成融合文字

我们可以把文字或图案通过ControlNet来融合到图片中。

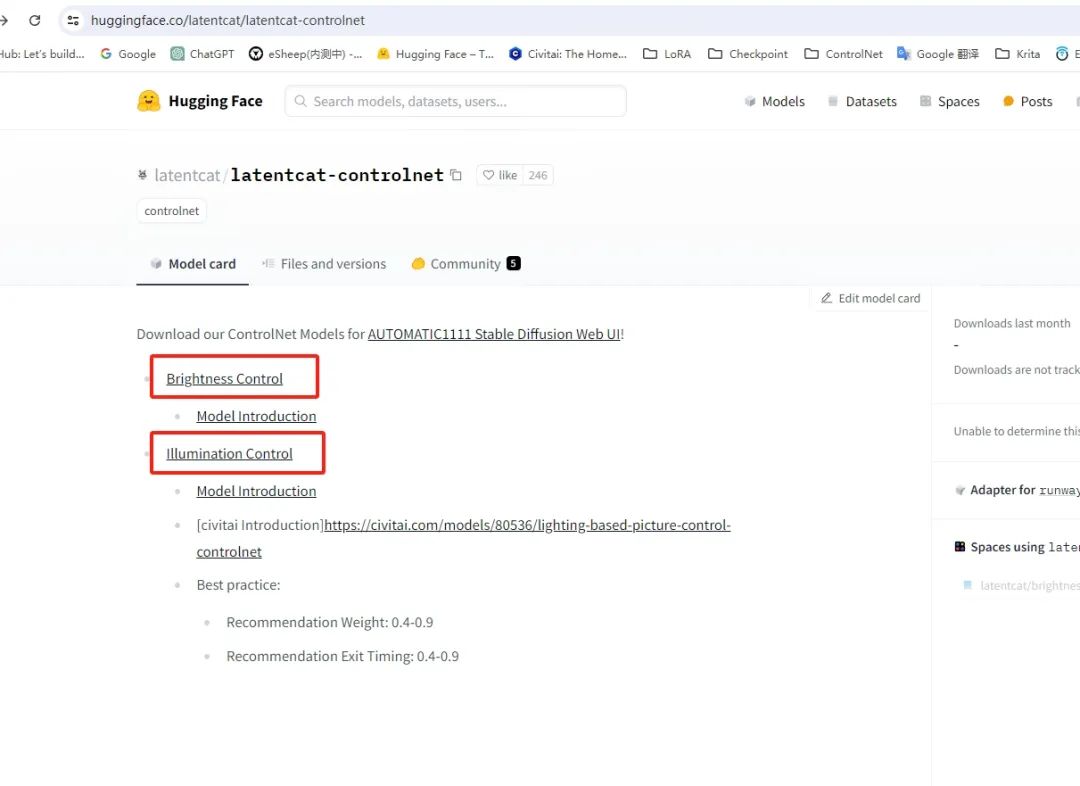

首先需要下载两个ControlNet模型,并放到\extensions\sd-webui-controlnet\models文件夹中。

下载地址:

https://huggingface.co/latentcat/latentcat-controlnet

这份完整版的学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

brightness示例

首先选择你需要的checkpoint大模型,并输入你需要生成内容的正向提示词和反向提示词。

正向提示词:

1girl,(solo),ligh beige hair,blue eyes,cat ears,(cat girl:1.1),parted lips,hair between eyes,(low twintails:1.2),long hair,hair ribbon,hair ornament,smooth skin,bowtie,china dress,qi lolita,white thighhighs,standing,upper body,

反向提示词:

NSFW, (worst quality:2), (low quality:2), (normal quality:2), lowres,normal quality,((monochrome)), ((grayscale)), skin spots, acnes,skin blemishes, age spot, (ugly:1.331), (duplicate:1.331),(morbid:1.21),(mutilated:1.21), (tranny:1.331), mutated hands,(poorly drawn hands:1.5), blurry, (bad anatomy:1.21), (badproportions:1.331), extra limbs, (disfigured:1.331), (missingarms:1.331),(extra legs:1.331), (fused fingers:1.61051),(too many fingers:1.61051), (unclear eyes:1.331), lowers, bad hands,missing fingers, extra digit,bad hands, missing fingers, (((extraarms and legs)))

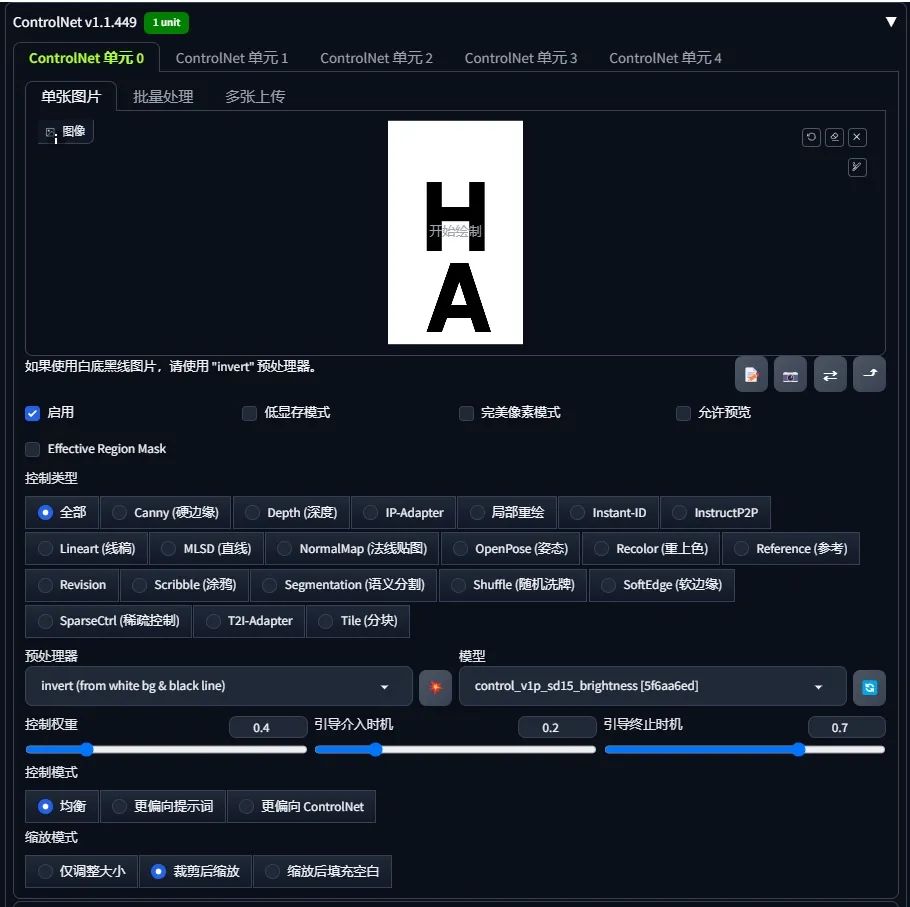

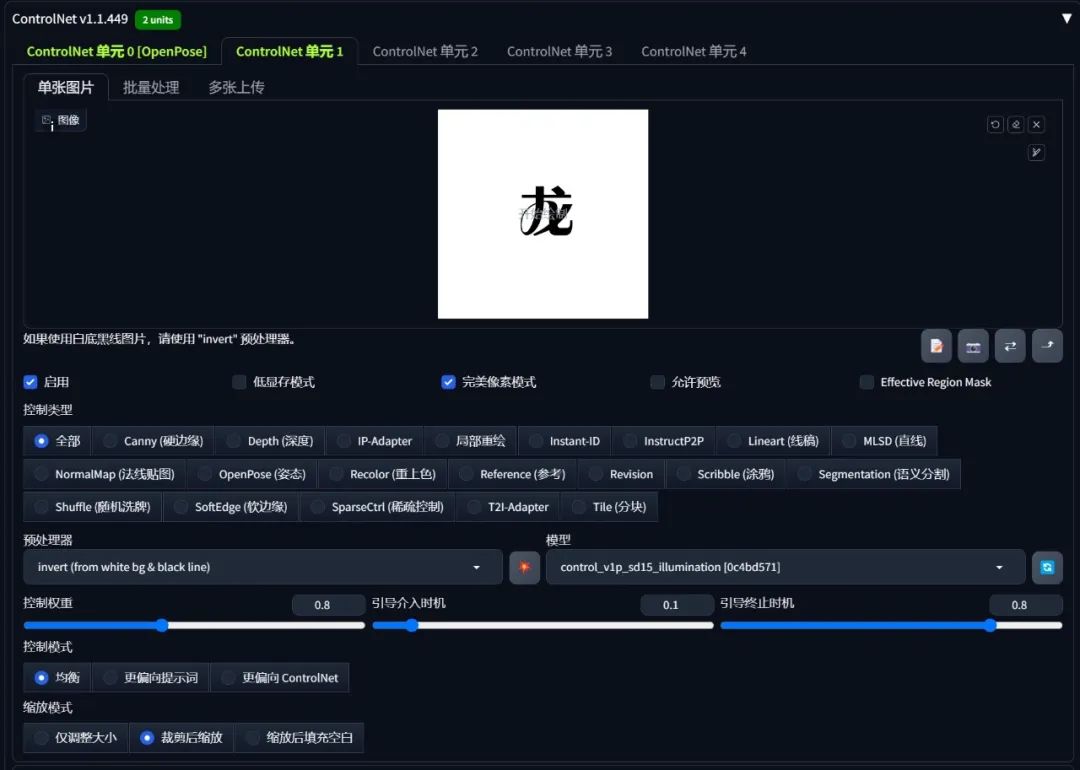

然后启用ControlNet并加载你需要的文字图片,预处理器选择"invert",模型选择"control_vlp_sd15_brightness",控制权重我设置为0.4,引导介入时机我设置为0.2,引导终止时机我设置为0.7,你也可以根据实际效果进行调整,使文字自然融入图片,然后图片的分辨率尽量和加载的图片比例一致。

点击生成,我们便可以看到文字融合进了图片。

我们预处理器之所以选择"invert",是因为invert预处理器会交换我们图片的黑白部分,突出亮度显示我们黑色部分,如果你希望的是让黑色部分变暗、而周围变两,那你可以将预处理器选择为"无"。

其他预处理器也可以实现类似的效果,如Canny、SoftEdge HED、Depth。

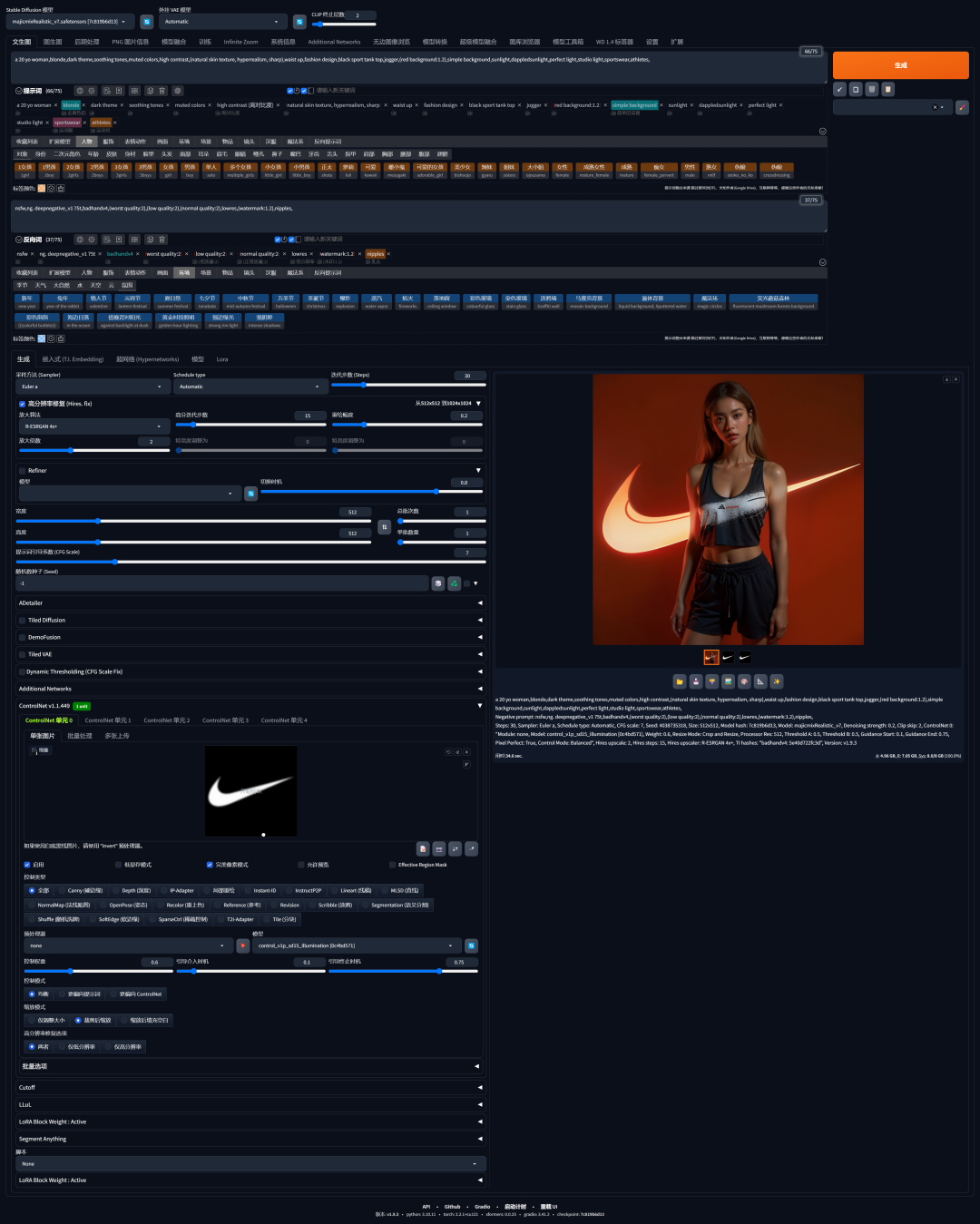

Illumination示例

Illumination的光影效果会比brightness更强烈,除了文字,我们也可以尝试融合图片、Logo等信息。

当你降低权重时候,生成的图片更偏向光影的效果,当你提升权重的时候,生成的图片会更偏向物体。

openpose+Illumination示例

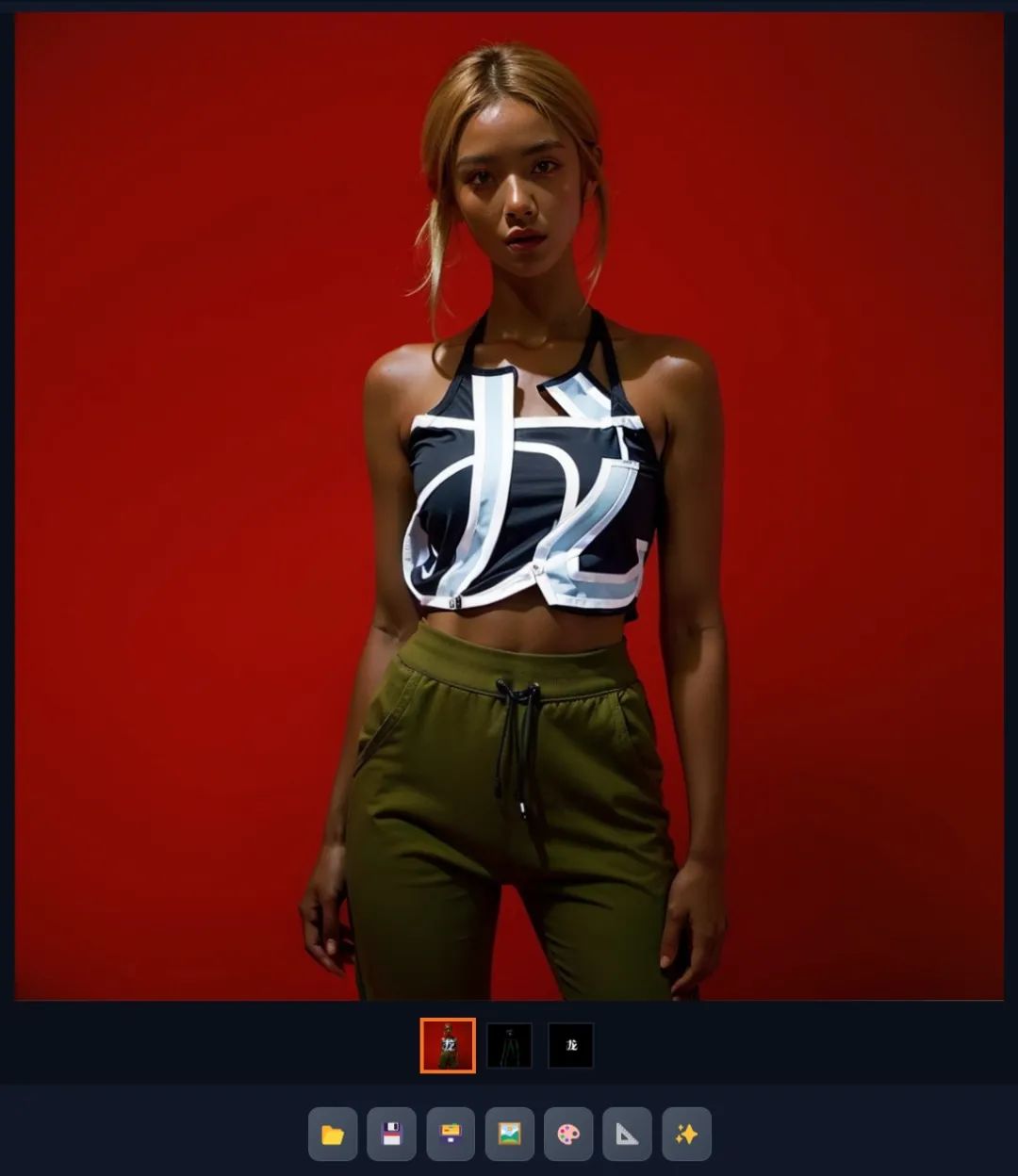

由于我们加载的图片内的信息位置是固定的,而生成的主体在图片中所在的位置是随机的,所以当我们需要将加载图片内的信息特定生成到主体上时就会比较困难了,当你生成一个人物时经常一部分文字在人物身上,一部分在背景中。所以我们就需要利用openpose来固定人物的位置。

拿刚才生成的那张图为例,在绘图软件中将你需要加载的文字信息移动到主体人物图片中所对应的位置,然后将文字和人物的图片分别保存。

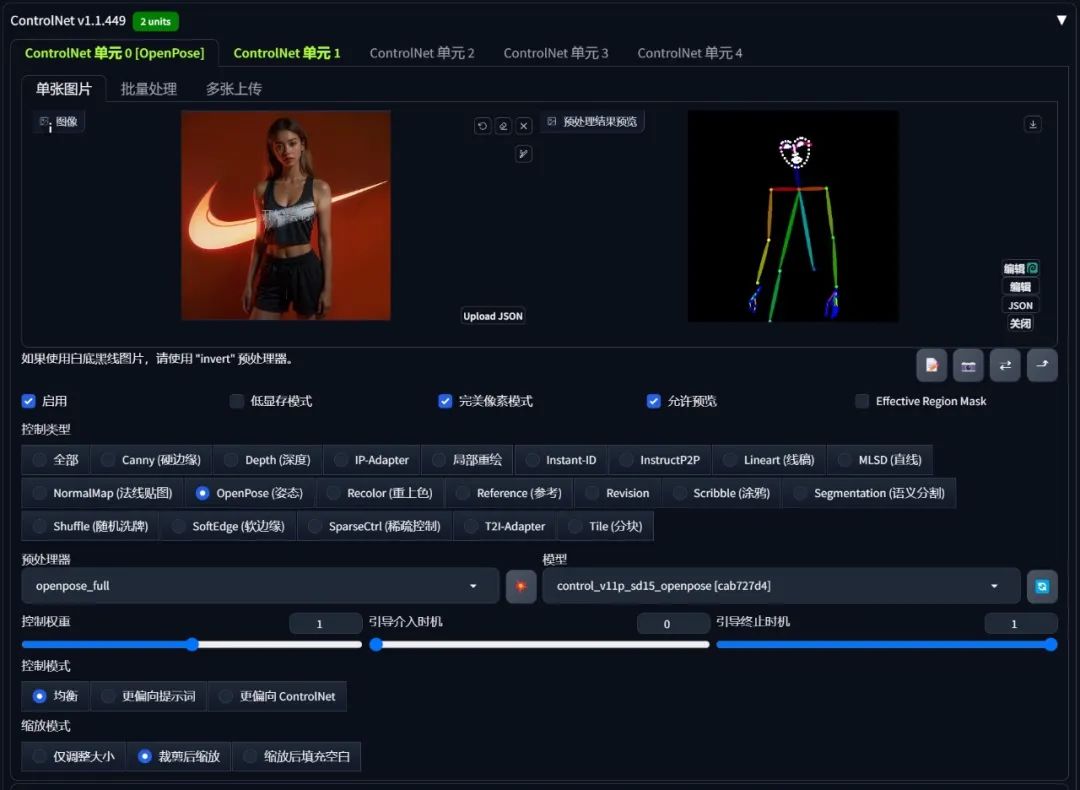

然后在ControlNet单元0中加载人物图片并开启Openpose的预处理器和模型。

在ControlNet单元1中加载文字信息图片并开启invert预处理器和illumination模型,并且调整好合适的权重和时机。

匹配你需要生成图像的提示词和尺寸、模型等参数后点击生成,便可以生成一张文字完全融入人物的衣服的图片了。

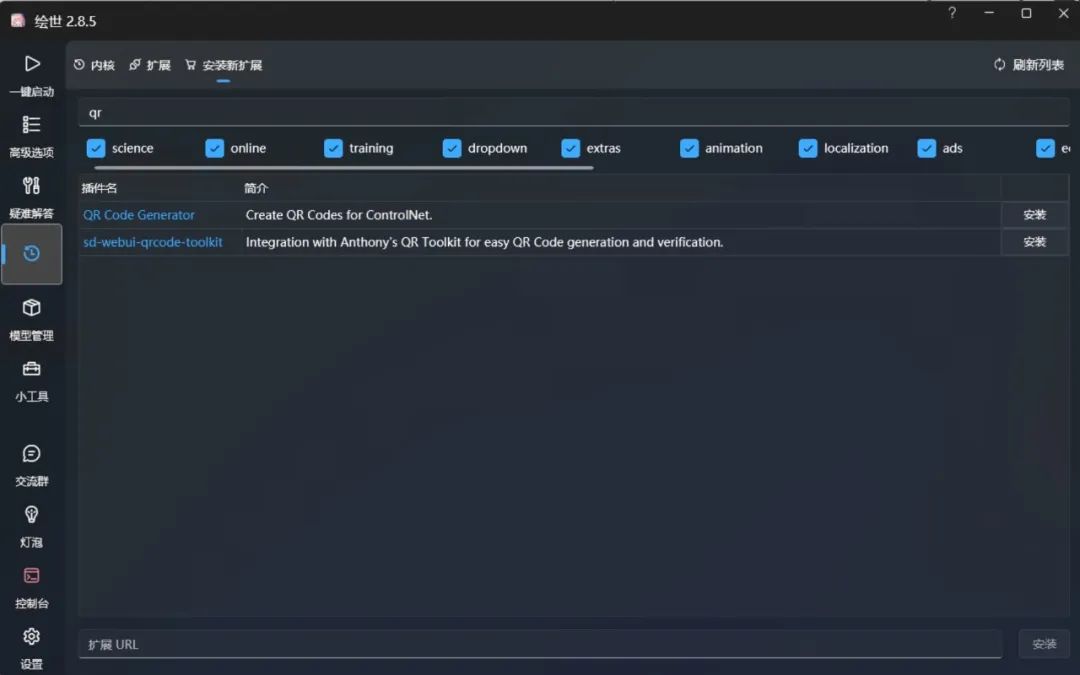

31.4 生成艺术二维码

二维码原理:

二维码(Quick Response Code, QR Code)是一种能够快速读取的条码技术,广泛用于存储网址、联系方式等信息。通过摄像头识别二维码图片中深浅区域的差异来获得其内在的信息,我们同样可以让图片获取的深浅区分,通过ControlNet可以将二维码嵌入到AI作品中,使其既具备艺术性又保留二维码的功能。

关于怎么生成二维码:

1.有很多网站和在线工具可以帮你把链接生成二维码,比如:草料二维码生成器

2.你也可以安装SD中的QR Code插件

下载地址:

GitHub - missionfloyd/webui-qrcode-generator

模型下载:

对于生成艺术二维码,这里推荐control_v1p_sd15_qrcode_monster这个模型

下载地址:

https://huggingface.co/monster-labs/control_v1p_sd15_qrcode_monster/tree/main

生成艺术二维码示例:

先将二维码图片导入至ControlNet单元0,由于需要精确识别二维码,所以控制权重一定要精准,不能低于1,引导介入时机和终止时机可以适当放宽,模型选择"control_v1p_sd15_qrcode_monster",预处理器可以不用选择。然后在ControlNet单元1中再次导入该二维码,模型选择illumination,这里的控制权中可以放松,我选择0.5。最后在提示词中输入想要呈现的内容即可。

正向提示词:

grassland,best quality,ultra-detailed,masterpiece,hires,8k,raw photo,(photorealistic:1.4),

反向提示词:

NSFW, (worst quality:2), (low quality:2), (normal quality:2), lowres,normal quality,((monochrome)), ((grayscale)), skin spots, acnes,skin blemishes, age spot, (ugly:1.331), (duplicate:1.331),(morbid:1.21),(mutilated:1.21), (tranny:1.331), mutated hands,(poorly drawn hands:1.5), blurry, (bad anatomy:1.21), (badproportions:1.331), extra limbs, (disfigured:1.331), (missingarms:1.331),(extra legs:1.331), (fused fingers:1.61051),(too many fingers:1.61051), (unclear eyes:1.331), lowers, bad hands,missing fingers, extra digit,bad hands, missing fingers, (((extraarms and legs)))

如果你对该二维码艺术图满意,你也可以将其发送至图生图,通过Tiled Diffusion来放大分辨率以获得更精细的图片和更丰富的细节,重绘幅度记得调低。

同时再次将该二维码加载至ControlNet中,预处理器选择"inpaint_global",模型选择"illumination",权重控制在0.2-0.3,引导时机适当放松,这样可以使图片高清放大的同时让二维码也更容易识别。

当然,你也可以通过局部重绘来修改你不满意的地方,每次生成后记得试着扫一下看看有没有问题,如果扫不出的可以适当收紧权重和引导时机

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。 二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

零基础AI绘画学习资源介绍

👉stable diffusion新手0基础入门PDF👈

(全套教程文末领取哈)

👉AI绘画必备工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉AI绘画基础+速成+进阶使用教程👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉12000+AI关键词大合集👈

这份完整版的学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

735

735

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?