# #单词统计计数

from pyspark import SparkConf, SparkContext

import os

os.environ['pyspark_python'] = "D:/python/JIESHIQI/python.exe"

#创建一个sparkconf类对象

conf = SparkConf().setMaster("local[*]").setAppName("test_spark_app")

#基于sparkconf类对象创建sparkcontext类对象

sc = SparkContext(conf=conf)

#读取文件信息

rdd = sc.textFile("D:/hello.txt")

#取出全部的单词

word_rdd = rdd.flatMap(lambda x: x.split(" "))

print(word_rdd.collect())

#['apple', 'bean', 'banana', 'spark', 'haoop', 'python', 'java', 'go', 'c++']

#将所有单词都转换成二元元组,单词为key,value设置为1

rdd2 = word_rdd.map(lambda word: (word, 1))

print(rdd2.collect())

#[('apple', 1), ('bean', 1), ('banana', 1), ('spark', 1), ('haoop', 1), ('python', 1), ('java', 1), ('go', 1), ('c++', 1)]

#分组并求和

rdd3 = rdd2.reduceByKey(lambda a, b: a+b)

print(rdd3.collect())

filter方法

功能:过滤想要的数据进行保留

from pyspark import SparkConf, SparkContext

import os

os.environ['pyspark_python'] = "D:/python/JIESHIQI/python.exe"

#创建一个sparkconf类对象

conf = SparkConf().setMaster("local[*]").setAppName("test_spark_app")

#基于sparkconf类对象创建sparkcontext类对象

sc = SparkContext(conf=conf)

#准备一个rdd

rdd = sc.parallelize([1,2,3,4,5])

#对rdd的数据进行过滤

rdd2 = rdd.filter(lambda num: num % 2 == 0)

print(rdd2.collect()) #[2, 4]

distinct算子

功能:对rdd数据进行去重,返回新rdd

from pyspark import SparkConf, SparkContext

import os

os.environ['pyspark_python'] = "D:/python/JIESHIQI/python.exe"

#创建一个sparkconf类对象

conf = SparkConf().setMaster("local[*]").setAppName("test_spark_app")

#基于sparkconf类对象创建sparkcontext类对象

sc = SparkContext(conf=conf)

#准备一个rdd

rdd = sc.parallelize([1,2,3,4,5,2,1,3,4,5])

#对rdd的数据进行过滤

# rdd2 = rdd.filter(lambda num: num % 2 == 0)

print(rdd.distinct().collect())

#[1, 2, 3, 4, 5]

sortby算子

功能:对rdd数据进行排序,基于你指定的排序依据

from pyspark import SparkConf, SparkContext

import os

os.environ['pyspark_python'] = "D:/python/JIESHIQI/python.exe"

#创建一个sparkconf类对象

conf = SparkConf().setMaster("local[*]").setAppName("test_spark_app")

#基于sparkconf类对象创建sparkcontext类对象

sc = SparkContext(conf=conf)

#读取文件信息

rdd = sc.textFile("D:/hello.txt")

#取出全部的单词

word_rdd = rdd.flatMap(lambda x: x.split(" "))

print(word_rdd.collect())

#['apple', 'bean', 'banana', 'spark', 'haoop', 'python', 'java', 'go', 'c++']

#将所有单词都转换成二元元组,单词为key,value设置为1

rdd2 = word_rdd.map(lambda word: (word, 1))

print(rdd2.collect())

#[('apple', 1), ('bean', 1), ('banana', 1), ('spark', 1), ('haoop', 1), ('python', 1), ('java', 1), ('go', 1), ('c++', 1)]

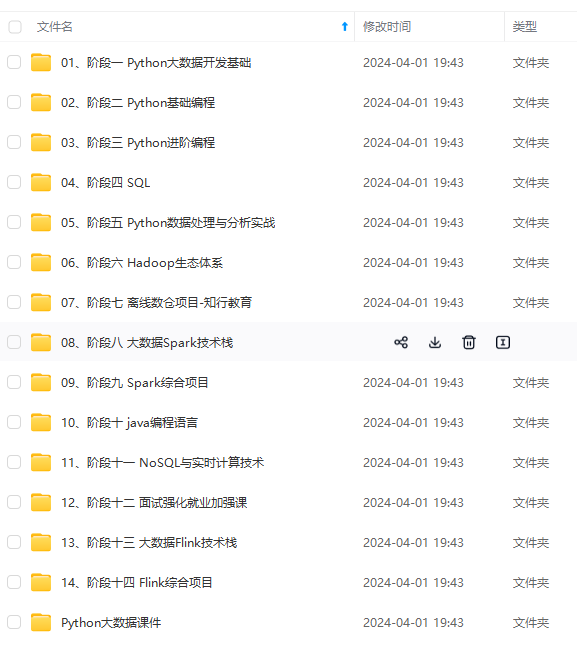

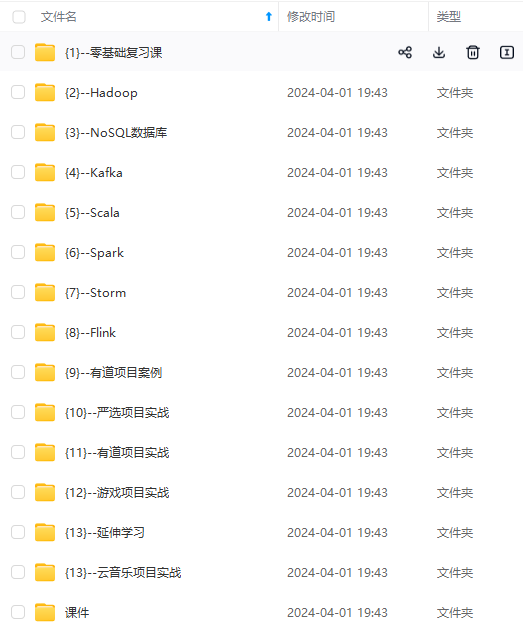

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.youkuaiyun.com/topics/618545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

8545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

814

814

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?