参考:https://morvanzhou.github.io/tutorials/machine-learning/tensorflow/

TensorFlow是Google开发的一款神经网络的Python外部的结构包, 也是一个采用数据流图来进行数值计算的开源软件库.TensorFlow 让我们可以先绘制计算结构图, 也可以称是一系列可人机交互的计算操作, 然后把编辑好的Python文件 转换成 更高效的C++, 并在后端进行计算.

TensorFlow 无可厚非地能被认定为神经网络中最好用的库之一. 它擅长的任务就是训练深度神经网络.通过使用TensorFlow我们就可以快速的入门神经网络, 大大降低了深度学习(也就是深度神经网络)的开发成本和开发难度. TensorFlow 的开源性, 让所有人都能使用并且维护, 巩固它. 使它能迅速更新, 提升.

Tensorflow例子1

拟合曲线:机器学习其实就是让电脑不断的尝试模拟已知的数据. 他能知道自己拟合的数据离真实的数据差距有多远, 然后不断地改进自己拟合的参数,提高拟合的相似度.

拟合参数:如果红色曲线的表达式为:y = a*x + b 其中x代表inputs, y代表outputs, a和b是神经网络训练的参数. 模型训练好了以后,a和b的值将会被确定, 比如 a=0.5, b=2,当我们再输入x=3时, 我们的模型就会输出 0.5*3 + 2 的结果. 模型通过学习数据, 得到能表达数据的参数, 然后对我们另外给的数据所作出预测.

处理结构:Tensorflow 首先要定义神经网络的结构, 然后再把数据放入结构当中去运算和 training.

Tensorflow编写神经网络

Tensorflow 是非常重视结构的, 我们得建立好了神经网络的结构, 才能将数字放进去, 运行这个结构.这个例子简单的阐述了 tensorflow 当中如何用代码来运行我们搭建的结构.

创建数据

首先, 我们这次需要加载 tensorflow 和 numpy 两个模块, 并且使用 numpy 来创建我们的数据.

import tensorflow as tf

import numpy as np #科学计算的模块

# create data

x_data = np.random.rand(100).astype(np.float32) #TensorFlow中数据类型以float32为主

y_data = x_data*0.1 + 0.3

接着, 我们用 tf.Variable 来创建描述 y 的参数. 我们可以把 y_data = x_data*0.1 + 0.3 想象成 y=Weights * x + biases, 然后神经网络也就是学着把 Weights 变成 0.1, biases 变成 0.3.

搭建模型

Weights = tf.Variable(tf.random_uniform([1], -1.0, 1.0)) #定义参数变量,[1]一维结构,初始范围是-1.0到1.0

biases = tf.Variable(tf.zeros([1])) #初始值定义为0

y = Weights*x_data + biases

计算误差

接着就是计算 y 和 y_data 的误差:

loss = tf.reduce_mean(tf.square(y-y_data)) #计算预测值和实际值的差

传播误差

反向传递误差的工作就教给optimizer了, 我们使用的误差传递方法是梯度下降法: Gradient Descent 让后我们使用 optimizer 来进行参数的更新.

optimizer = tf.train.GradientDescentOptimizer(0.5) #选择随机梯度下降作为优化器,0.5表示学习效率,要小于1

train = optimizer.minimize(loss)

训练

到目前为止, 我们只是建立了神经网络的结构, 还没有使用这个结构. 在使用这个结构之前, 我们必须先初始化所有之前定义的Variable, 所以这一步是很重要的!

# init = tf.initialize_all_variables() # tf 马上就要废弃这种写法

init = tf.global_variables_initializer() # 替换成这样就好

接着,我们再创建会话 Session. 我们会在下一节中详细讲解 Session. 我们用 Session 来执行 init 初始化步骤. 并且, 用 Session 来 run 每一次 training 的数据. 逐步提升神经网络的预测准确性.

sess = tf.Session()

sess.run(init) # Very important 激活init

for step in range(201):

sess.run(train) #指向train 开始训练

if step % 20 == 0:

print(step, sess.run(Weights), sess.run(biases))

session

Session会话控制Session 是 Tensorflow 为了控制,和输出文件的执行的语句. 运行 session.run() 可以获得你要得知的运算结果, 或者是你所要运算的部分.首先,我们这次需要加载 Tensorflow ,然后建立两个 matrix ,输出两个 matrix 矩阵相乘的结果。

import tensorflow as tf

# create two matrixes

matrix1 = tf.constant([[3,3]]) # 一行两列的矩阵

matrix2 = tf.constant([[2],

[2]]) #两行一列的矩阵

product = tf.matmul(matrix1,matrix2) #矩阵的乘法

因为 product 不是直接计算的步骤, 所以我们会要使用 Session 来激活 product 并得到计算结果. 有两种形式使用会话控制 Session 。

# method 1

sess = tf.Session() # Session是一个object,首字母要大写

result = sess.run(product)

print(result)

sess.close()

# [[12]]

# method 2

with tf.Session() as sess: #运行完会自动关掉,不用写sess.close

result2 = sess.run(product)

print(result2)

# [[12]]

以上就是我们今天所学的两种 Session 打开模式

Variable变量

在 Tensorflow 中,定义了某字符串是变量,它才是变量,这一点是与 Python 所不同的。

定义语法: state = tf.Variable()

import tensorflow as tf

state = tf.Variable(0, name='counter') #变量初值是0 名字叫counter

# 定义常量 one

one = tf.constant(1) #常量1

# 定义加法步骤 (注: 此步并没有直接计算)

new_value = tf.add(state, one)

# 将 State 更新成 new_value

update = tf.assign(state, new_value) #将new_value的值加载到state上

如果你在 Tensorflow 中设定了变量,那么初始化变量是最重要的!!所以定义了变量以后, 一定要定义 init = tf.initialize_all_variables() .

到这里变量还是没有被激活,需要再在 sess 里, sess.run(init) , 激活 init 这一步.

# 如果定义 Variable, 就一定要 initialize

# init = tf.initialize_all_variables() # tf 马上就要废弃这种写法

init = tf.global_variables_initializer() # 替换成这样就好

# 使用 Session

with tf.Session() as sess:

sess.run(init)

for _ in range(3):

sess.run(update)

print(sess.run(state))

注意:直接 print(state) 不起作用!!一定要把 sess 的指针指向 state 再进行 print 才能得到想要的结果!

Placeholder传入值

这一次我们会讲到 Tensorflow 中的 placeholder , placeholder 是 Tensorflow 中的占位符,暂时储存变量.

Tensorflow 如果想要从外部传入data, 那就需要用到 tf.placeholder(), 然后以这种形式传输数据 sess.run(***, feed_dict={input: **}).示例:

import tensorflow as tf

#在 Tensorflow 中需要定义 placeholder 的 type ,一般为 float32 形式

input1 = tf.placeholder(tf.float32)

input2 = tf.placeholder(tf.float32)

# mul = multiply 是将input1和input2 做乘法运算,并输出为 output

ouput = tf.multiply(input1, input2)

接下来, 传值的工作交给了 sess.run() , 需要传入的值放在了feed_dict={} 并一一对应每一个 input. placeholder 与 feed_dict={} 是绑定在一起出现的。

with tf.Session() as sess:

print(sess.run(ouput, feed_dict={input1: [7.], input2: [2.]})) #字典的形式传入

# [ 14.]

激励函数

这里的 AF 就是指的激励函数. 激励函数拿出自己最擅长的”掰弯利器”, 套在了原函数上用力一扭, 原来的 Wx 结果就被扭弯了.

其实这个 AF, 掰弯利器, 也不是什么触不可及的东西. 它其实就是另外一个非线性函数. 比如说relu, sigmoid, tanh. 将这些掰弯利器嵌套在原有的结果之上, 强行把原有的线性结果给扭曲了. 使得输出结果 y 也有了非线性的特征. 举个例子, 比如我使用了 relu 这个掰弯利器, 如果此时 Wx 的结果是1, y 还将是1, 不过 Wx 为-1的时候, y 不再是-1, 而会是0.

你甚至可以创造自己的激励函数来处理自己的问题, 不过要确保的是这些激励函数必须是可以微分的, 因为在 backpropagation 误差反向传递的时候, 只有这些可微分的激励函数才能把误差传递回去.

想要恰当使用这些激励函数, 还是有窍门的. 比如当你的神经网络层只有两三层, 不是很多的时候, 对于隐藏层, 使用任意的激励函数, 随便掰弯是可以的, 不会有特别大的影响. 不过, 当你使用特别多层的神经网络, 在掰弯的时候, 玩玩不得随意选择利器. 因为这会涉及到梯度爆炸, 梯度消失的问题. 因为时间的关系, 我们可能会在以后来具体谈谈这个问题.

最后我们说说, 在具体的例子中, 我们默认首选的激励函数是哪些. 在少量层结构中, 我们可以尝试很多种不同的激励函数. 在卷积神经网络 Convolutional neural networks 的卷积层中, 推荐的激励函数是 relu. 在循环神经网络中 recurrent neural networks, 推荐的是 tanh 或者是 relu (这个具体怎么选, 我会在以后 循环神经网络的介绍中在详细讲解).

添加层

在 Tensorflow 里定义一个添加层的函数可以很容易的添加神经层,为之后的添加省下不少时间.

神经层里常见的参数通常有weights、biases和激励函数。

首先,我们需要导入tensorflow模块。

import tensorflow as tf

然后定义添加神经层的函数def add_layer(),它有四个参数:输入值、输入的大小、输出的大小和激励函数,我们设定默认的激励函数是None。

def add_layer(inputs, in_size, out_size, activation_function=None):

接下来,我们开始定义weights和biases。

因为在生成初始参数时,随机变量(normal distribution)会比全部为0要好很多,所以我们这里的weights为一个in_size行, out_size列的随机变量矩阵。

Weights = tf.Variable(tf.random_normal([in_size, out_size]))

在机器学习中,biases的推荐值不为0,所以我们这里是在0向量的基础上又加了0.1。

biases = tf.Variable(tf.zeros([1, out_size]) + 0.1)

下面,我们定义Wx_plus_b, 即神经网络未激活的值。其中,tf.matmul()是矩阵的乘法。

Wx_plus_b = tf.matmul(inputs, Weights) + biases

当activation_function——激励函数为None时,输出就是当前的预测值——Wx_plus_b,不为None时,就把Wx_plus_b传到activation_function()函数中得到输出。

if activation_function is None:

outputs = Wx_plus_b

else:

outputs = activation_function(Wx_plus_b)

最后,返回输出,添加一个神经层的函数——def add_layer()就定义好了。

return outputs

构造神经网络

import tensorflow as tf

import numpy as np

def add_layer(inputs, in_size, out_size, activation_function=None):

Weights = tf.Variable(tf.random_normal([in_size, out_size]))

biases = tf.Variable(tf.zeros([1, out_size]) + 0.1)

Wx_plus_b = tf.matmul(inputs, Weights) + biases

if activation_function is None:

outputs = Wx_plus_b

else:

outputs = activation_function(Wx_plus_b)

return outputs

导入数据

构建所需的数据。 这里的x_data和y_data并不是严格的一元二次函数的关系,因为我们多加了一个noise,这样看起来会更像真实情况。

x_data = np.linspace(-1,1,300, dtype=np.float32)[:, np.newaxis]

noise = np.random.normal(0, 0.05, x_data.shape).astype(np.float32)

y_data = np.square(x_data) - 0.5 + noise

利用占位符定义我们所需的神经网络的输入。 tf.placeholder()就是代表占位符,这里的None代表无论输入有多少都可以,因为输入只有一个特征,所以这里是1。

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

接下来,我们就可以开始定义神经层了。 通常神经层都包括输入层、隐藏层和输出层。这里的输入层只有一个属性, 所以我们就只有一个输入;隐藏层我们可以自己假设,这里我们假设隐藏层有10个神经元; 输出层和输入层的结构是一样的,所以我们的输出层也是只有一层。 所以,我们构建的是——输入层1个、隐藏层10个、输出层1个的神经网络。

搭建网络

下面,我们开始定义隐藏层,利用之前的add_layer()函数,这里使用 Tensorflow 自带的激励函数tf.nn.relu。

l1 = add_layer(xs, 1, 10, activation_function=tf.nn.relu)

接着,定义输出层。此时的输入就是隐藏层的输出——l1,输入有10层(隐藏层的输出层),输出有1层。

prediction = add_layer(l1, 10, 1, activation_function=None)

计算预测值prediction和真实值的误差,对二者差的平方求和再取平均。

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - prediction),

reduction_indices=[1]))

接下来,是很关键的一步,如何让机器学习提升它的准确率。tf.train.GradientDescentOptimizer()中的值通常都小于1,这里取的是0.1,代表以0.1的效率来最小化误差loss。

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

使用变量时,都要对它进行初始化,这是必不可少的。

# init = tf.initialize_all_variables() # tf 马上就要废弃这种写法

init = tf.global_variables_initializer() # 替换成这样就好

定义Session,并用 Session 来执行 init 初始化步骤。 (注意:在tensorflow中,只有session.run()才会执行我们定义的运算。)

sess = tf.Session()

sess.run(init)

训练

下面,让机器开始学习。

比如这里,我们让机器学习1000次。机器学习的内容是train_step, 用 Session 来 run 每一次 training 的数据,逐步提升神经网络的预测准确性。 (注意:当运算要用到placeholder时,就需要feed_dict这个字典来指定输入。)

for i in range(1000):

# training

sess.run(train_step, feed_dict={xs: x_data, ys: y_data})

每50步我们输出一下机器学习的误差。

if i % 50 == 0:

# to see the step improvement

print(sess.run(loss, feed_dict={xs: x_data, ys: y_data}))

在电脑上运行本次代码的结果为:

通过上图可以看出,误差在逐渐减小,这说明机器学习是有积极的效果的。

结果可视化

matplotlib 可视化

构建图形,用散点图描述真实数据之间的关系。 (注意:plt.ion()用于连续显示。)

# plot the real data

fig = plt.figure()

ax = fig.add_subplot(1,1,1)

ax.scatter(x_data, y_data)

plt.ion()#本次运行请注释,全局运行不要注释

plt.show()

散点图的结果为:

接下来,我们来显示预测数据。

每隔50次训练刷新一次图形,用红色、宽度为5的线来显示我们的预测数据和输入之间的关系,并暂停0.1s。

for i in range(1000):

# training

sess.run(train_step, feed_dict={xs: x_data, ys: y_data})

if i % 50 == 0:

# to visualize the result and improvement

try:

ax.lines.remove(lines[0])

except Exception:

pass

prediction_value = sess.run(prediction, feed_dict={xs: x_data})

# plot the prediction

lines = ax.plot(x_data, prediction_value, 'r-', lw=5)

plt.pause(0.1)

最后,机器学习的结果为:

加速神经网络训练

越复杂的神经网络 , 越多的数据 , 我们需要在训练神经网络的过程上花费的时间也就越多. 原因很简单, 就是因为计算量太大了. 可是往往有时候为了解决复杂的问题, 复杂的结构和大数据又是不能避免的, 所以我们需要寻找一些方法, 让神经网络聪明起来, 快起来.

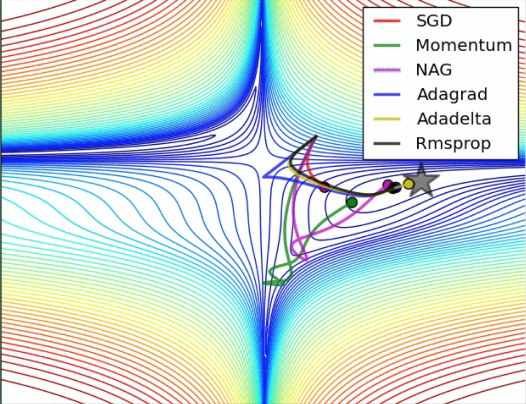

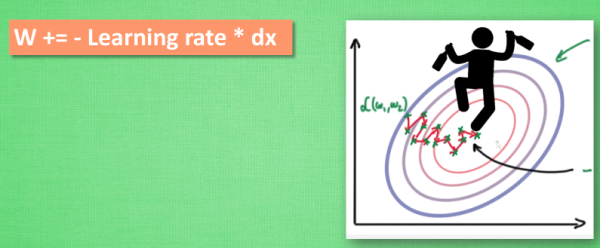

Stochastic Gradient Descent (SGD)

所以, 最基础的方法就是 SGD 啦, 想像红色方块是我们要训练的 data, 如果用普通的训练方法, 就需要重复不断的把整套数据放入神经网络 NN训练, 这样消耗的计算资源会很大.

我们换一种思路, 如果把这些数据拆分成小批小批的, 然后再分批不断放入 NN 中计算, 这就是我们常说的 SGD 的正确打开方式了. 每次使用批数据, 虽然不能反映整体数据的情况, 不过却很大程度上加速了 NN 的训练过程, 而且也不会丢失太多准确率.如果运用上了 SGD, 你还是嫌训练速度慢, 那怎么办?

没问题, 事实证明, SGD 并不是最快速的训练方法, 红色的线是 SGD, 但它到达学习目标的时间是在这些方法中最长的一种. 我们还有很多其他的途径来加速训练.

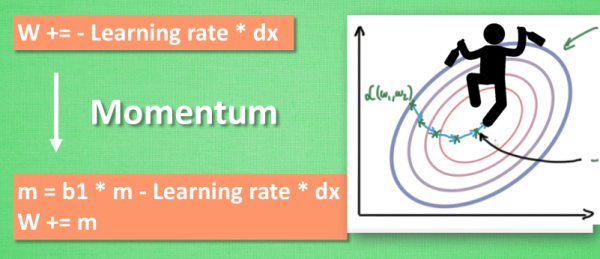

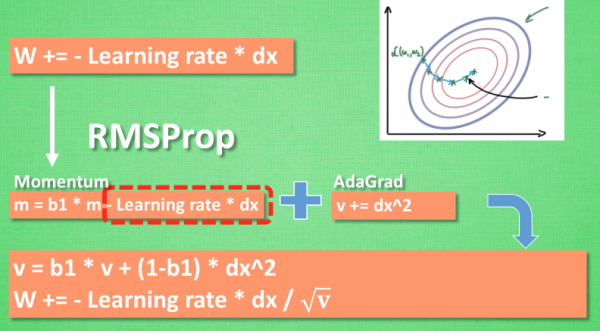

Momentum 更新方法

大多数其他途径是在更新神经网络参数那一步上动动手脚. 传统的参数 W 的更新是把原始的 W 累加上一个负的学习率(learning rate) 乘以校正值 (dx). 这种方法可能会让学习过程曲折无比, 看起来像 喝醉的人回家时, 摇摇晃晃走了很多弯路.

所以我们把这个人从平地上放到了一个斜坡上, 只要他往下坡的方向走一点点, 由于向下的惯性, 他不自觉地就一直往下走, 走的弯路也变少了. 这就是 Momentum 参数更新. 另外一种加速方法叫AdaGrad.

AdaGrad 更新方法

这种方法是在学习率上面动手脚, 使得每一个参数更新都会有自己与众不同的学习率, 他的作用和 momentum 类似, 不过不是给喝醉酒的人安排另一个下坡, 而是给他一双不好走路的鞋子, 使得他一摇晃着走路就脚疼, 鞋子成为了走弯路的阻力, 逼着他往前直着走. 他的数学形式是这样的. 接下来又有什么方法呢? 如果把下坡和不好走路的鞋子合并起来, 是不是更好呢? 没错, 这样我们就有了 RMSProp 更新方法.

RMSProp更新方法

有了 momentum 的惯性原则 , 加上 adagrad 的对错误方向的阻力, 我们就能合并成这样. 让 RMSProp同时具备他们两种方法的优势. 不过细心的同学们肯定看出来了, 似乎在 RMSProp 中少了些什么. 原来是我们还没把 Momentum合并完全, RMSProp 还缺少了 momentum 中的 这一部分. 所以, 我们在 Adam 方法中补上了这种想法.

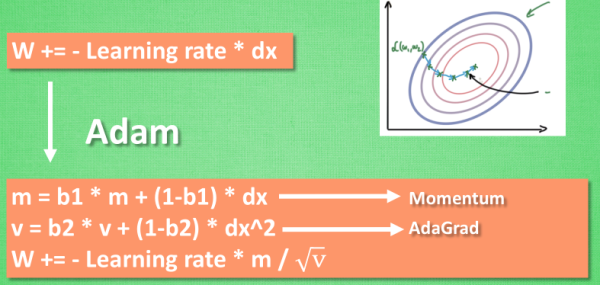

Adam更新方法

计算m 时有 momentum 下坡的属性, 计算 v 时有 adagrad 阻力的属性, 然后再更新参数时 把 m 和 V 都考虑进去. 实验证明, 大多数时候, 使用 adam 都能又快又好的达到目标, 迅速收敛. 所以说, 在加速神经网络训练的时候, 一个下坡, 一双破鞋子, 功不可没.

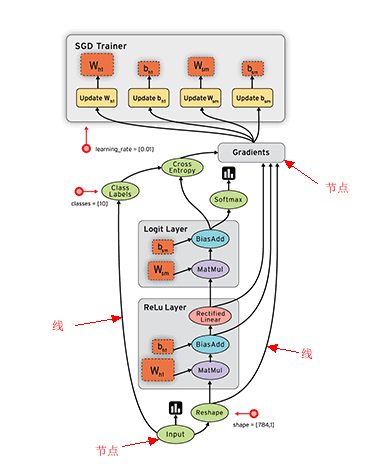

Tensorboard

学会用 Tensorflow 自带的 tensorboard 去可视化我们所建造出来的神经网络是一个很好的学习理解方式. 用最直观的流程图告诉你你的神经网络是长怎样,有助于你发现编程中间的问题和疑问.

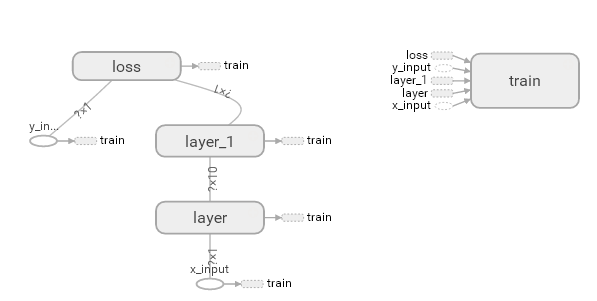

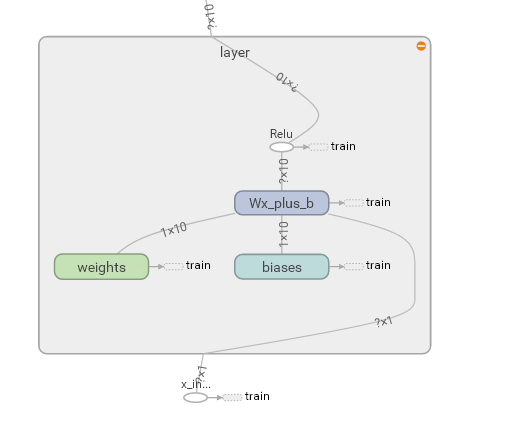

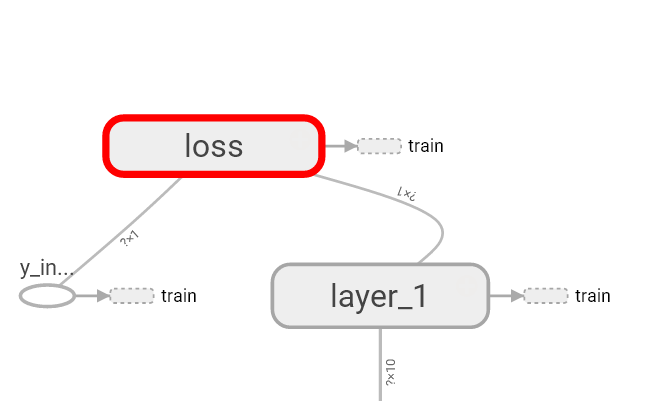

这次我们会介绍如何可视化神经网络。因为很多时候我们都是做好了一个神经网络,但是没有一个图像可以展示给大家看。这一节会介绍一个TensorFlow的可视化工具 — tensorboard :) 通过使用这个工具我们可以很直观的看到整个神经网络的结构、框架。 以前几节的代码为例:相关代码 通过tensorflow的工具大致可以看到,今天要显示的神经网络差不多是这样子的

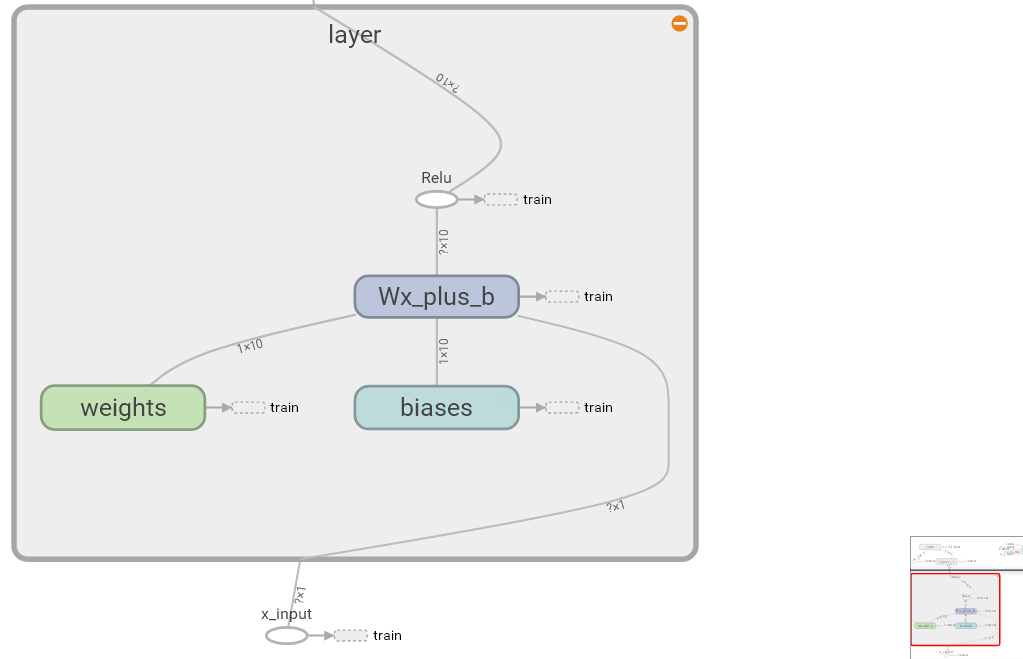

同时我们也可以展开看每个layer中的一些具体的结构:

好,通过阅读代码和之前的图片我们大概知道了此处是有一个输入层(inputs),一个隐含层(layer),还有一个输出层(output) 现在可以看看如何进行可视化.

首先从 Input 开始:

# define placeholder for inputs to network

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

对于input我们进行如下修改: 首先,可以为xs指定名称为x_in:

xs= tf.placeholder(tf.float32, [None, 1],name='x_in')

然后再次对ys指定名称y_in:

ys= tf.placeholder(tf.loat32, [None, 1],name='y_in')

这里指定的名称将来会在可视化的图层inputs中显示出来

使用with tf.name_scope('inputs')可以将xs和ys包含进来,形成一个大的图层,图层的名字就是with tf.name_scope()方法里的参数。

with tf.name_scope('inputs'):

# define placeholder for inputs to network

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

接下来开始编辑layer , 请看编辑前的程序片段 :

def add_layer(inputs, in_size, out_size, activation_function=None):

# add one more layer and return the output of this layer

Weights = tf.Variable(tf.random_normal([in_size, out_size]))

biases = tf.Variable(tf.zeros([1, out_size]) + 0.1)

Wx_plus_b = tf.add(tf.matmul(inputs, Weights), biases)

if activation_function is None:

outputs = Wx_plus_b

else:

outputs = activation_function(Wx_plus_b, )

return outputs

这里的名字应该叫layer, 下面是编辑后的:

def add_layer(inputs, in_size, out_size, activation_function=None):

# add one more layer and return the output of this layer

with tf.name_scope('layer'):

Weights= tf.Variable(tf.random_normal([in_size, out_size]))

# and so on...

在定义完大的框架layer之后,同时也需要定义每一个’框架‘里面的小部件:(Weights biases 和 activation function): 现在现对 Weights 定义: 定义的方法同上,可以使用tf.name.scope()方法,同时也可以在Weights中指定名称W。 即为:

def add_layer(inputs, in_size, out_size, activation_function=None):

#define layer name

with tf.name_scope('layer'):

#define weights name

with tf.name_scope('weights'):

Weights= tf.Variable(tf.random_normal([in_size, out_size]),name='W')

#and so on......

接着继续定义biases , 定义方式同上。

def add_layer(inputs, in_size, out_size, activation_function=None):

#define layer name

with tf.name_scope('layer'):

#define weights name

with tf.name_scope('weights')

Weights= tf.Variable(tf.random_normal([in_size, out_size]),name='W')

# define biase

with tf.name_scope('Wx_plus_b'):

Wx_plus_b = tf.add(tf.matmul(inputs, Weights), biases)

# and so on....

activation_function 的话,可以暂时忽略。因为当你自己选择用 tensorflow 中的激励函数(activation function)的时候,tensorflow会默认添加名称。 最终,layer形式如下:

def add_layer(inputs, in_size, out_size, activation_function=None):

# add one more layer and return the output of this layer

with tf.name_scope('layer'):

with tf.name_scope('weights'):

Weights = tf.Variable(

tf.random_normal([in_size, out_size]),

name='W')

with tf.name_scope('biases'):

biases = tf.Variable(

tf.zeros([1, out_size]) + 0.1,

name='b')

with tf.name_scope('Wx_plus_b'):

Wx_plus_b = tf.add(

tf.matmul(inputs, Weights),

biases)

if activation_function is None:

outputs = Wx_plus_b

else:

outputs = activation_function(Wx_plus_b, )

return outputs

效果如下:(有没有看见刚才定义layer里面的“内部构件”呢?)

最后编辑loss部分:将with tf.name_scope()添加在loss上方,并为它起名为loss

# the error between prediciton and real data

with tf.name_scope('loss'):

loss = tf.reduce_mean(

tf.reduce_sum(

tf.square(ys - prediction),

eduction_indices=[1]

))

这句话就是“绘制” loss了, 如下:

使用with tf.name_scope()再次对train_step部分进行编辑,如下:

with tf.name_scope('train'):

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

我们需要使用 tf.summary.FileWriter() (tf.train.SummaryWriter() 这种方式已经在 tf >= 0.12 版本中摒弃) 将上面‘绘画’出的图保存到一个目录中,以方便后期在浏览器中可以浏览。 这个方法中的第二个参数需要使用sess.graph , 因此我们需要把这句话放在获取session的后面。 这里的graph是将前面定义的框架信息收集起来,然后放在logs/目录下面。

sess = tf.Session() # get session

# tf.train.SummaryWriter soon be deprecated, use following

writer = tf.summary.FileWriter("logs/", sess.graph)

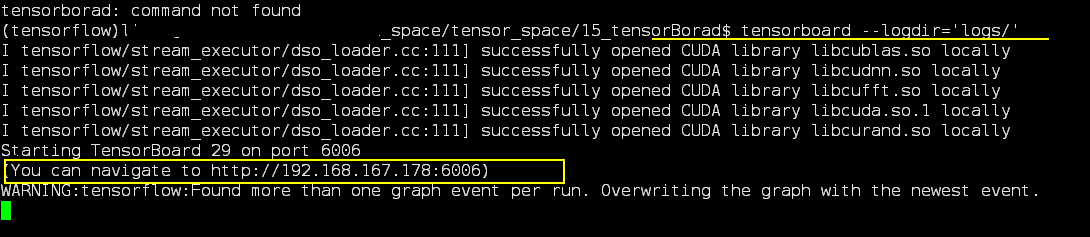

最后在你的terminal(终端)中 ,使用以下命令

tensorboard --logdir logs

同时将终端中输出的网址复制到浏览器中,便可以看到之前定义的视图框架了。

tensorboard 还有很多其他的参数,希望大家可以多多了解, 可以使用 tensorboard --help 查看tensorboard的详细参数

可能会遇到的问题

(1) 而且与 tensorboard 兼容的浏览器是 “Google Chrome”. 使用其他的浏览器不保证所有内容都能正常显示.

(2) 同时注意, 如果使用 http://0.0.0.0:6006 网址打不开的朋友们, 请使用 http://localhost:6006, 大多数朋友都是这个问题.

(3) 请确保你的 tensorboard 指令是在你的 logs 文件根目录执行的. 如果在其他目录下, 比如 Desktop 等, 可能不会成功看到图. 比如在下面这个目录, 你要 cd 到 project 这个地方执行 /project > tensorboard --logdir logs

- project

- logs

model.py

env.py

(4) 讨论区的朋友使用 anaconda 下的 python3.5 的虚拟环境, 如果你输入 tensorboard 的指令, 出现报错: "tensorboard" is not recognized as an internal or external command...

解决方法的关键就是需要激活TensorFlow. 管理员模式打开 Anaconda Prompt, 输入 activate tensorflow, 接着按照上面的流程执行 tensorboard 指令.

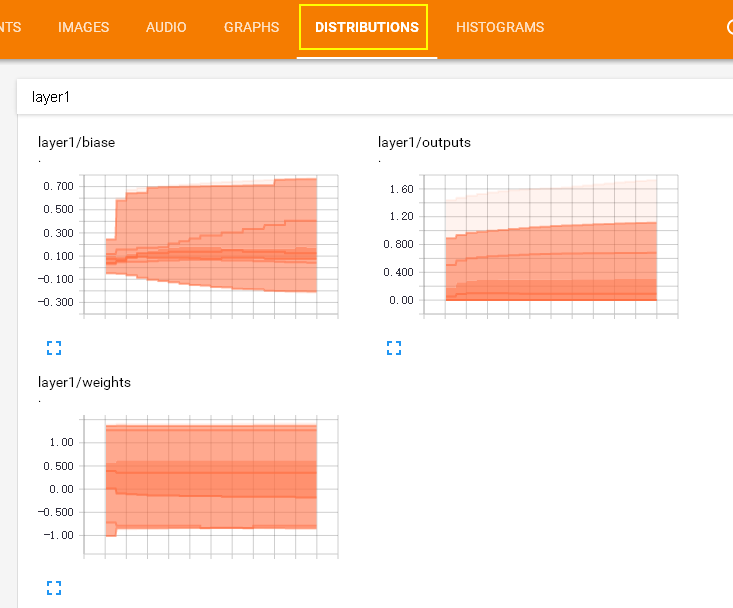

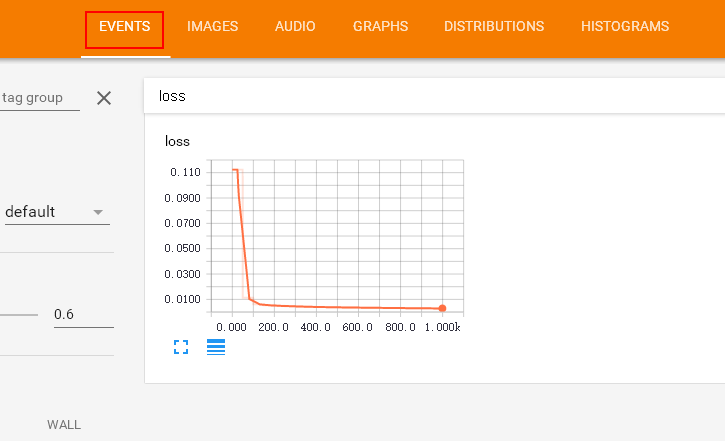

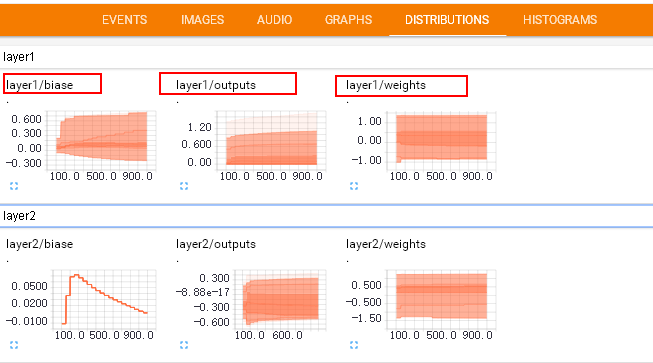

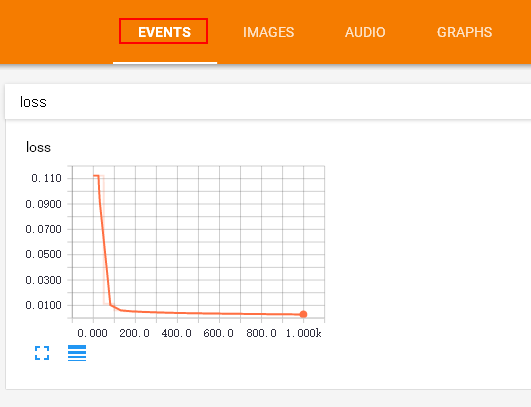

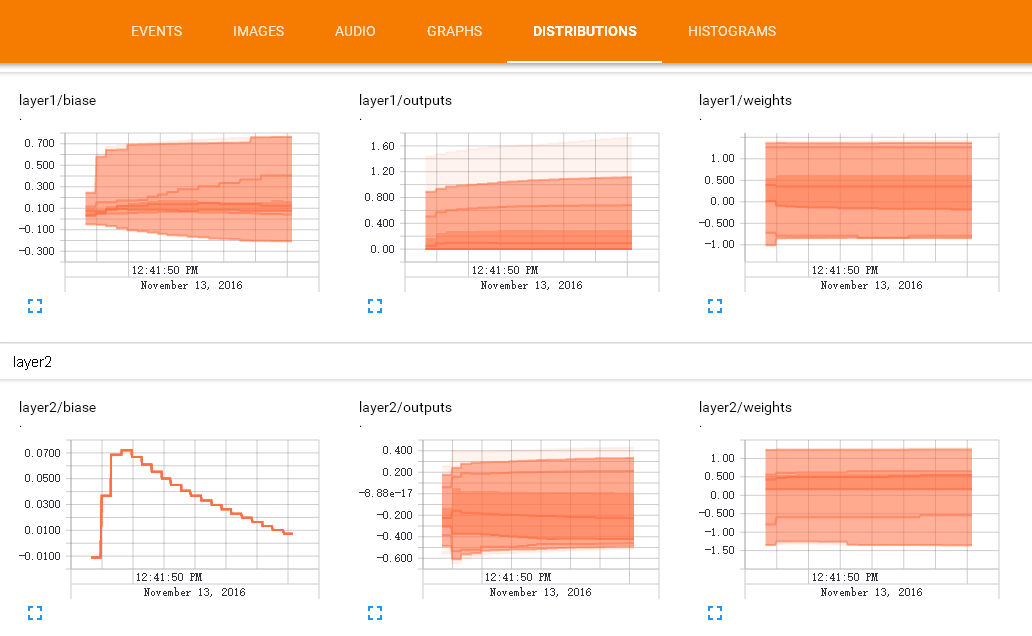

刚才讲到了 如何可视化TesorBorad整个神经网络结构的过程。 其实tensorboard还可以可视化训练过程( biase变化过程) , 这节重点讲一下可视化训练过程的图标是如何做的 。请看下图, 这是如何做到的呢?

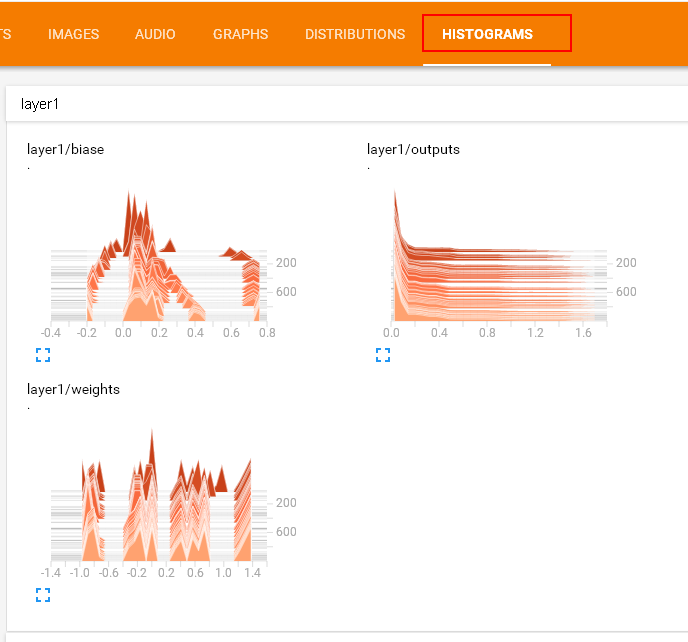

在histograms里面我们还可以看到更多的layers的变化:

(P.S. 灰猫使用的 tensorflow v1.1 显示的效果可能和视频中的不太一样, 但是 tensorboard 的使用方法的是一样的。)

这里还有一个events , 在这次练习中我们会把 整个训练过程中的误差值(loss)在event里面显示出来, 甚至你可以显示更多你想要显示的东西.

好了, 开始练习吧, 本节内容包括:

制作输入源

由于这节我们观察训练过程中神经网络的变化, 所以首先要添一些模拟数据. Python 的 numpy 工具包可以帮助我们制造一些模拟数据. 所以我们先导入这个工具包:

import tensorflow as tf

import numpy as np

然后借助 np 中的 np.linespace() 产生随机的数字, 同时为了模拟更加真实我们会添加一些噪声, 这些噪声是通过 np.random.normal() 随机产生的.

## make up some data

x_data= np.linspace(-1, 1, 300, dtype=np.float32)[:,np.newaxis]

noise= np.random.normal(0, 0.05, x_data.shape).astype(np.float32)

y_data= np.square(x_data) -0.5+ noise

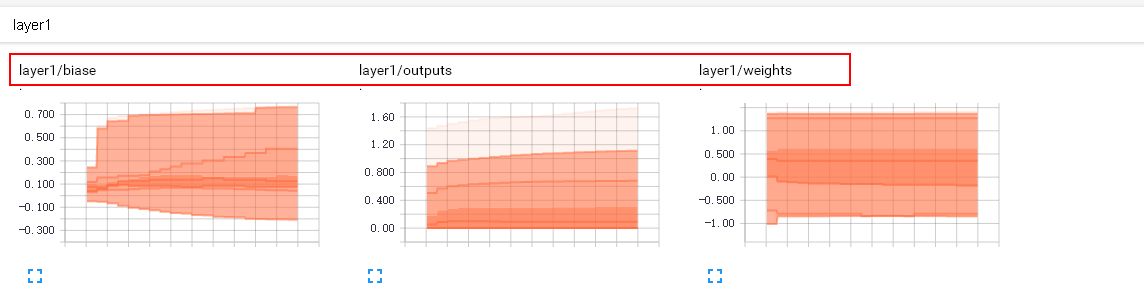

输入源的问题解决之后, 我们开始制作对Weights和biases的变化图表吧. 我们期望可以做到如下的效果, 那么首先从 layer1/weight 做起吧

这个效果是如何做到的呢,请看下一个标题

在 layer 中为 Weights, biases 设置变化图表

通过上图的观察我们发现每个 layer 后面有有一个数字: layer1 和layer2

于是我们在 add_layer() 方法中添加一个参数 n_layer,用来标识层数, 并且用变量 layer_name 代表其每层的名名称, 代码如下:

def add_layer(

inputs ,

in_size,

out_size,

n_layer,

activation_function=None):

## add one more layer and return the output of this layer

layer_name='layer%s'%n_layer ## define a new var

## and so on ……

接下来,我们层中的Weights设置变化图, tensorflow中提供了tf.histogram_summary()方法,用来绘制图片, 第一个参数是图表的名称, 第二个参数是图表要记录的变量

def add_layer(inputs ,

in_size,

out_size,n_layer,

activation_function=None):

## add one more layer and return the output of this layer

layer_name='layer%s'%n_layer

with tf.name_scope('layer'):

with tf.name_scope('weights'):

Weights= tf.Variable(tf.random_normal([in_size, out_size]),name='W')

# tf.histogram_summary(layer_name+'/weights',Weights) # tensorflow 0.12 以下版的

tf.summary.histogram(layer_name + '/weights', Weights) # tensorflow >= 0.12

##and so no ……

同样的方法我们对biases进行绘制图标:

with tf.name_scope('biases'):

biases = tf.Variable(tf.zeros([1,out_size])+0.1, name='b')

# tf.histogram_summary(layer_name+'/biase',biases) # tensorflow 0.12 以下版的

tf.summary.histogram(layer_name + '/biases', biases) # Tensorflow >= 0.12

至于activation_function 可以不绘制. 我们对output 使用同样的方法:

# tf.histogram_summary(layer_name+'/outputs',outputs) # tensorflow 0.12 以下版本

tf.summary.histogram(layer_name + '/outputs', outputs) # Tensorflow >= 0.12

最终经过我们的修改 , addlayer()方法成为如下的样子:

def add_layer(inputs ,

in_size,

out_size,n_layer,

activation_function=None):

## add one more layer and return the output of this layer

layer_name='layer%s'%n_layer

with tf.name_scope(layer_name):

with tf.name_scope('weights'):

Weights= tf.Variable(tf.random_normal([in_size, out_size]),name='W')

# tf.histogram_summary(layer_name+'/weights',Weights)

tf.summary.histogram(layer_name + '/weights', Weights) # tensorflow >= 0.12

with tf.name_scope('biases'):

biases = tf.Variable(tf.zeros([1,out_size])+0.1, name='b')

# tf.histogram_summary(layer_name+'/biase',biases)

tf.summary.histogram(layer_name + '/biases', biases) # Tensorflow >= 0.12

with tf.name_scope('Wx_plus_b'):

Wx_plus_b = tf.add(tf.matmul(inputs,Weights), biases)

if activation_function is None:

outputs=Wx_plus_b

else:

outputs= activation_function(Wx_plus_b)

# tf.histogram_summary(layer_name+'/outputs',outputs)

tf.summary.histogram(layer_name + '/outputs', outputs) # Tensorflow >= 0.12

return outputs

修改之后的名称会显示在每个tensorboard中每个图表的上方显示, 如下图所示:

由于我们对addlayer 添加了一个参数, 所以修改之前调用addlayer()函数的地方. 对此处进行修改:

# add hidden layer

l1= add_layer(xs, 1, 10 , activation_function=tf.nn.relu)

# add output layer

prediction= add_layer(l1, 10, 1, activation_function=None)

添加n_layer参数后, 修改成为 :

# add hidden layer

l1= add_layer(xs, 1, 10, n_layer=1, activation_function=tf.nn.relu)

# add output layer

prediction= add_layer(l1, 10, 1, n_layer=2, activation_function=None)

设置loss的变化图

Loss 的变化图和之前设置的方法略有不同. loss是在tesnorBorad 的event下面的, 这是由于我们使用的是tf.scalar_summary() 方法.

观看loss的变化比较重要. 当你的loss呈下降的趋势,说明你的神经网络训练是有效果的.

修改后的代码片段如下:

with tf.name_scope('loss'):

loss= tf.reduce_mean(tf.reduce_sum(

tf.square(ys- prediction), reduction_indices=[1]))

# tf.scalar_summary('loss',loss) # tensorflow < 0.12

tf.summary.scalar('loss', loss) # tensorflow >= 0.12

给所有训练图合并

接下来, 开始合并打包。 tf.merge_all_summaries() 方法会对我们所有的 summaries 合并到一起. 因此在原有代码片段中添加:

sess= tf.Session()

# merged= tf.merge_all_summaries() # tensorflow < 0.12

merged = tf.summary.merge_all() # tensorflow >= 0.12

# writer = tf.train.SummaryWriter('logs/', sess.graph) # tensorflow < 0.12

writer = tf.summary.FileWriter("logs/", sess.graph) # tensorflow >=0.12

# sess.run(tf.initialize_all_variables()) # tf.initialize_all_variables() # tf 马上就要废弃这种写法

sess.run(tf.global_variables_initializer()) # 替换成这样就好

训练数据

假定给出了x_data,y_data并且训练1000次.

for i in range(1000):

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

以上这些仅仅可以记录很绘制出训练的图表, 但是不会记录训练的数据。 为了较为直观显示训练过程中每个参数的变化,我们每隔上50次就记录一次结果 , 同时我们也应注意, merged 也是需要run 才能发挥作用的,所以在for循环中写下:

if i%50 == 0:

rs = sess.run(merged,feed_dict={xs:x_data,ys:y_data})

writer.add_summary(rs, i)

最后修改后的片段如下:

for i in range(1000):

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

if i%50 == 0:

rs = sess.run(merged,feed_dict={xs:x_data,ys:y_data})

writer.add_summary(rs, i)

在 tensorboard 中查看效果

程序运行完毕之后, 会产生logs目录 , 使用命令 tensorboard --logdir logs

注意: 本节内容会用到浏览器, 而且与 tensorboard 兼容的浏览器是 “Google Chrome”. 使用其他的浏览器不保证所有内容都能正常显示.

同时注意, 如果使用 http://0.0.0.0:6006 或者 tensorboard 中显示的网址打不开的朋友们, 请使用 http://localhost:6006, 大多数朋友都是这个问题.

会有如下输出:

将输出中显示的URL地址粘贴到浏览器中便可以查看. 最终的效果如下:

本文介绍了TensorFlow的基本概念,演示了如何使用TensorFlow构建神经网络,并详细解释了如何通过TensorBoard进行可视化,包括网络结构和训练过程。

本文介绍了TensorFlow的基本概念,演示了如何使用TensorFlow构建神经网络,并详细解释了如何通过TensorBoard进行可视化,包括网络结构和训练过程。

3602

3602

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?