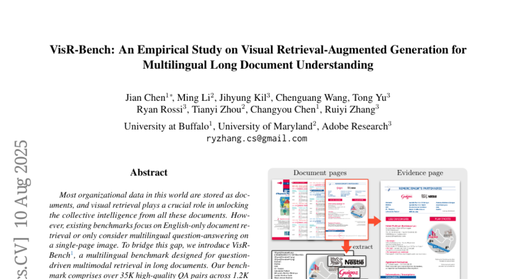

这项由美国斯坦福大学、马里兰大学以及Adobe Research联合开展的研究于2025年8月发表,论文标题为《VisR-Bench: An Empirical Study on Visual Retrieval-Augmented Generation for Multilingual Long Document Understanding》。研究团队包括来自Buffalo大学的Jian Chen、马里兰大学的Ming Li和Tianyi Zhou、Adobe Research的Jihyung Kil、Tong Yu、Ryan Rossi和Ruiyi Zhang等知名学者。完整论文可通过arXiv:2508.07493v1访问,为理解多语言视觉检索技术的最新进展提供了宝贵参考。

在我们日常生活中,无论是公司的产品手册、政府的政策文件,还是学术研究报告,绝大部分重要信息都以文档形式存储。然而,当你需要从一份几十页的外语技术手册中快速找到特定问题的答案时,或者要从包含复杂图表和表格的多语言报告中提取关键数据时,传统的搜索方法往往显得力不从心。这正是这项研究要解决的核心问题。

研究团队发现了一个令人惊讶的现状:尽管人工智能在理解单一语言的简单文档方面已经相当出色,但面对真实世界中的多语言、多页面、包含图表的复杂文档时,现有的AI系统表现却大打折扣。就如同一位只会英语的图书管理员突然面对一座收藏着十六种语言书籍的国际图书馆,不仅要理解文字内容,还要准确识别各种图表、表格和图片中的信息。

为了解决这个问题,研究团队创建了一个名为VisR-Bench的全新测试平台。这个平台就像是为AI系统专门设计的"多语言文档理解能力考试",包含了超过35000个精心设计的问答对,涵盖1286份来自16种不同语言的真实文档。这些文档不是简单的文本页面,而是包含了图表、表格、图片等多种视觉元素的复杂材料,平均每份文档长达18页。

这项研究的创新之处在于它首次系统性地评估了AI系统在多语言视觉检索方面的真实能力。研究团队就像是为AI系统设计了一场全面的"体检",不仅要测试它们能否找到正确的信息页面,还要验证它们是否真正理解了页面内容并能准确回答问题。更重要的是,他们特意设计了一些"陷阱题"——即使问题中包含某些关键词,但真正的答案却在看似无关的页面中,这样就能测试AI是否真的在进行深层理解,而不是简单的关键词匹配。

一、多语言文档世界的挑战——为什么现有AI束手无策

传统的文档检索系统就像是配备了放大镜的图书管理员,它们主要依靠识别和匹配文字信息来工作。当你向这样的系统提问"第一班火车什么时候发车"时,它会寻找包含"火车"、"发车"、"时间"等关键词的页面。然而,真正的答案可能隐藏在一个复杂的火车时刻表中,而这个表格中可能根本不包含"第一班"这样的明确字眼。

更复杂的情况是,当文档使用非英语语言时,问题变得更加棘手。研究团队发现,大多数现有的AI检索系统都是基于英语数据训练的,就像一位只接受过英语教育的学生突然要参加多语种考试一样,结果可想而知。即使是一些声称支持多语言的系统,在面对真实的多语言文档时,表现也远不如在单一语言环境下那样出色。

研究团队特别关注了三种类型的信息检索挑战。第一类是图表信息检索,比如从一个显示销售数据的柱状图中找到特定月份的销售额。第二类是表格信息检索,需要从复杂的数据表格中提取和计算特定信息。第三类是文本信息检索,但这种文本往往嵌入在复杂的文档布局中,与图表和表格交织在一起。

现有系统的另一个重大缺陷是它们往往依赖表面的视觉相似性进行检索。当系统看到一个关于"火车"的问题时,它可能会返回一张火车图片所在的页面,而不是包含火车时刻表的页面,尽管后者才是真正能回答问题的信息源。这就像是问路人"最近的银行在哪

斯坦福大学等:VisR-Bench突破多语言视觉检索

最新推荐文章于 2025-12-06 20:37:58 发布

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5838

5838

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?