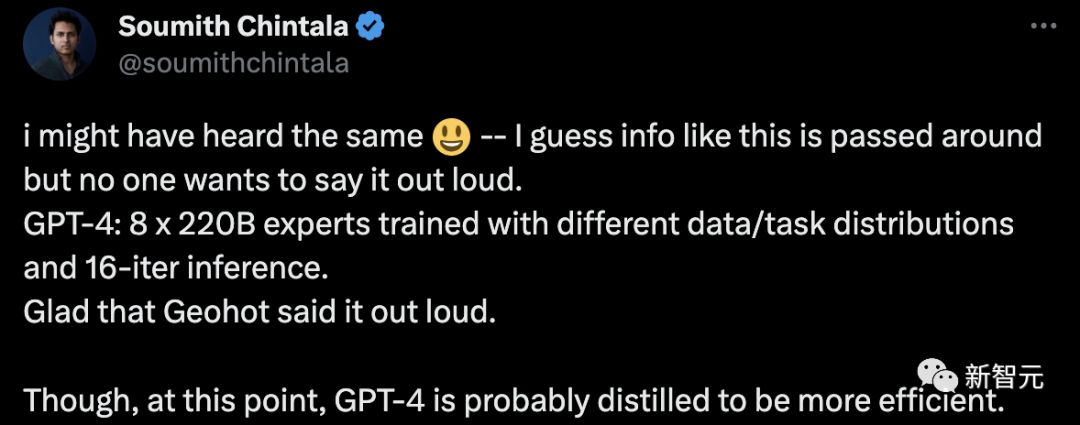

家人们,GPT-4的参数可能还真不止1万亿!近来,美国知名骇客George Hotz在接受采访时透露,GPT-4由8个220B模型组成。这么算来,8 x 220B = 1.76万亿。就连PyTorch的创建者Soumith Chintala对此也深信不疑。GPT-4:8 x 220B专家模型用不同的数据/任务分布和16-iter推理进行训练。如果真是这样的话,GPT-4的训练可能更加有效。

1.76万亿「八头蛇」?

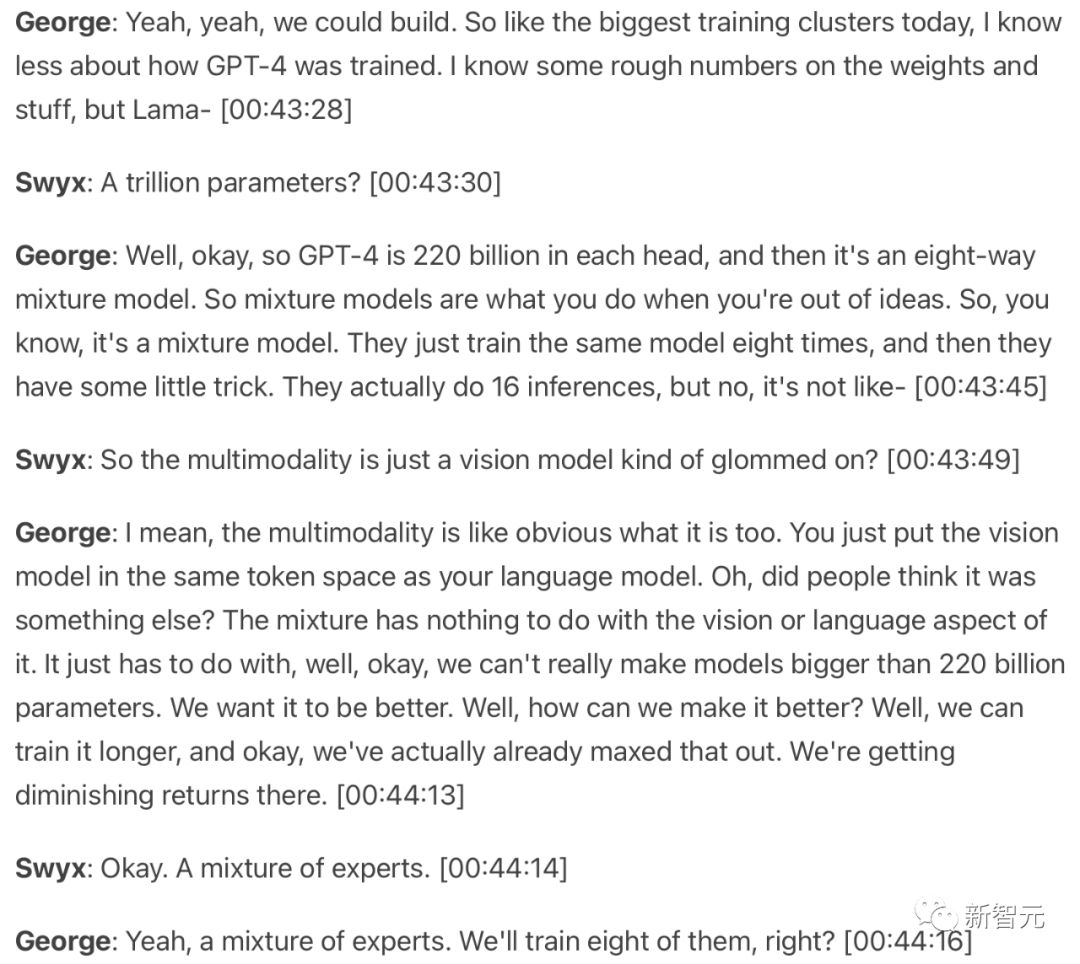

而George在接受Latent Space的采访时,对GPT4架构的描述着实让人震惊。他的部分原话如下:

而George在接受Latent Space的采访时,对GPT4架构的描述着实让人震惊。他的部分原话如下:他特别强调,OpenAI做了8个混合专家模型,任何人可以花8倍资金都能训练出来。也就是说,人们能够训练更小模型更长时间,微调后,就能找到这些技巧。OpenAI曾经发表类似关于让计算量不变的情况下,让训练更好的算法,比较像BatchNorm和NoBatchNorm。GPT-4每个head都有2200亿参数,是一个8路的混合模型。所以,混合模型是当你想不出办法的时候才会做的。OpenAI训练了相同模型8次,他们有一些小技巧。他们实际上进行了16次推断。

一起看看George Hotz具体的介绍视频:

一起看看George Hotz具体的介绍视频:网友热评

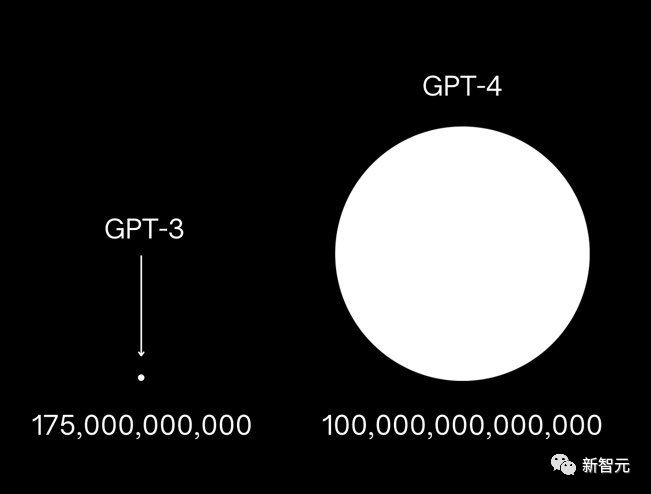

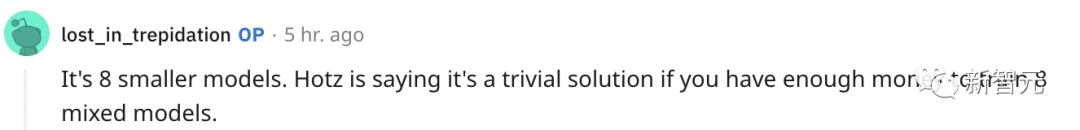

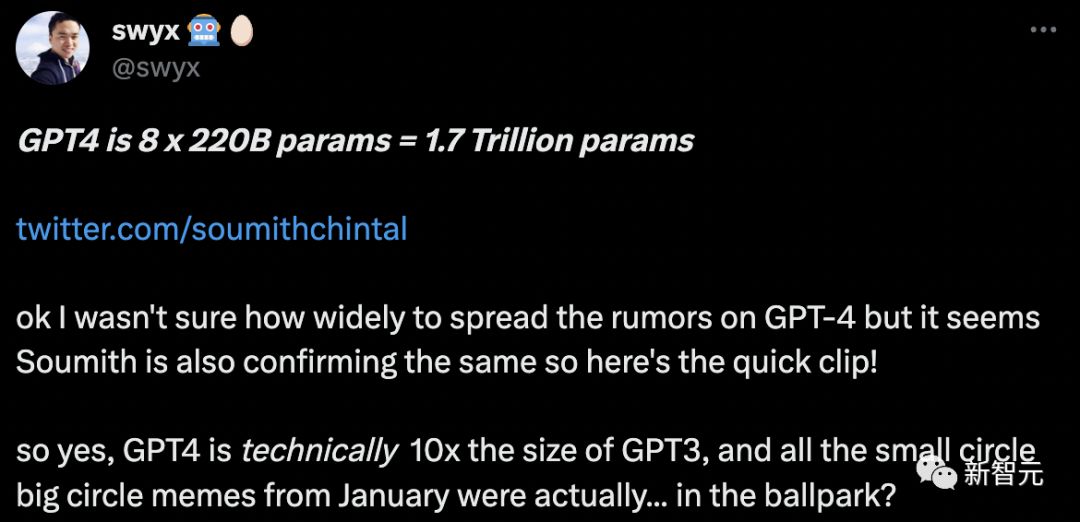

就像George所说,这是8个较小的模型,如果有足够资金训练8个混合模型,这是一个微不足道的解决方案。 所以,GPT-4是GPT-3的10倍,而1月份的所有小圈圈大圈圈的meme实际上是......真的?!

所以,GPT-4是GPT-3的10倍,而1月份的所有小圈圈大圈圈的meme实际上是......真的?! 网友得知秘诀后,打算自己也要训练一个LLaMA集合体与GPT-4竞争。

网友得知秘诀后,打算自己也要训练一个LLaMA集合体与GPT-4竞争。 还有网友称,这有点像LLM-Blender。

还有网友称,这有点像LLM-Blender。 我早就听到了稍微可信的传言,说GPT-4将是MoE,但从未得到证实。MoE和大约1万亿个参数不会让我感到惊讶,这听起来极为合理。

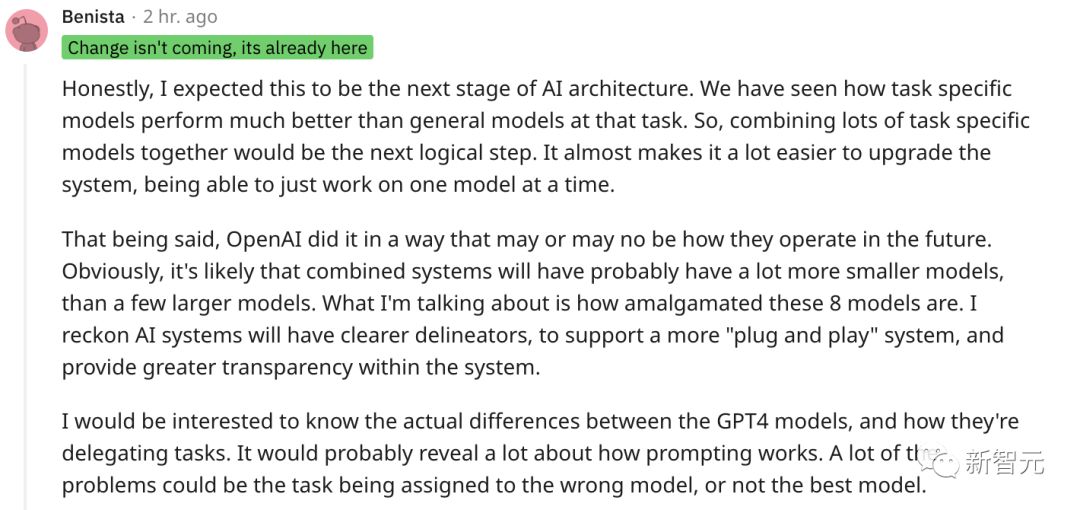

我早就听到了稍微可信的传言,说GPT-4将是MoE,但从未得到证实。MoE和大约1万亿个参数不会让我感到惊讶,这听起来极为合理。 还有网友进行深度分析:老实说,我预计这将是人工智能架构的下一阶段。我们已经看到特定任务模型在任务中的表现比一般模型好得多。因此,将许多特定任务模型组合在一起将是下一个合乎逻辑的步骤。这几乎使升级系统变得容易得多,一次只能处理一个模型。话虽如此,OpenAI以一种未来可能会,也可能不会的方式做到了这一点。显然,组合系统可能会有更多的小模型,而不是几个更大的模型。

还有网友进行深度分析:老实说,我预计这将是人工智能架构的下一阶段。我们已经看到特定任务模型在任务中的表现比一般模型好得多。因此,将许多特定任务模型组合在一起将是下一个合乎逻辑的步骤。这几乎使升级系统变得容易得多,一次只能处理一个模型。话虽如此,OpenAI以一种未来可能会,也可能不会的方式做到了这一点。显然,组合系统可能会有更多的小模型,而不是几个更大的模型。 如果这是真的,这是否意味着每个220B模型也有32K的上下文长度?

如果这是真的,这是否意味着每个220B模型也有32K的上下文长度?

据GeorgeHotz透露,GPT-4可能是由8个220B参数的模型组成的混合专家模型,总参数量达到1.76万亿。OpenAI的这种训练策略涉及多次推断和不同数据分布,使得训练更为高效。网友对此表示惊讶,并讨论了这种类似于MoE(混合专家模型)的架构对未来AI发展的影响。

据GeorgeHotz透露,GPT-4可能是由8个220B参数的模型组成的混合专家模型,总参数量达到1.76万亿。OpenAI的这种训练策略涉及多次推断和不同数据分布,使得训练更为高效。网友对此表示惊讶,并讨论了这种类似于MoE(混合专家模型)的架构对未来AI发展的影响。

1638

1638

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?