1 Hive环境搭建---Hive on Spark配置

注意:官网下载的Hive3.1.2和Spark3.0.0默认是不兼容的。因为Hive3.1.2支持的Spark版本是2.4.5,所以需要我们重新编译Hive3.1.2版本。

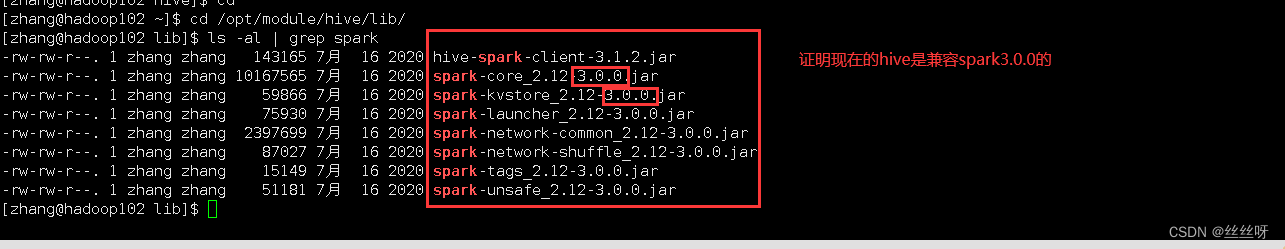

[zhang@hadoop102 ~]$ cd /opt/module/hive/lib/

[zhang@hadoop102 lib]$ ls -al | grep spark

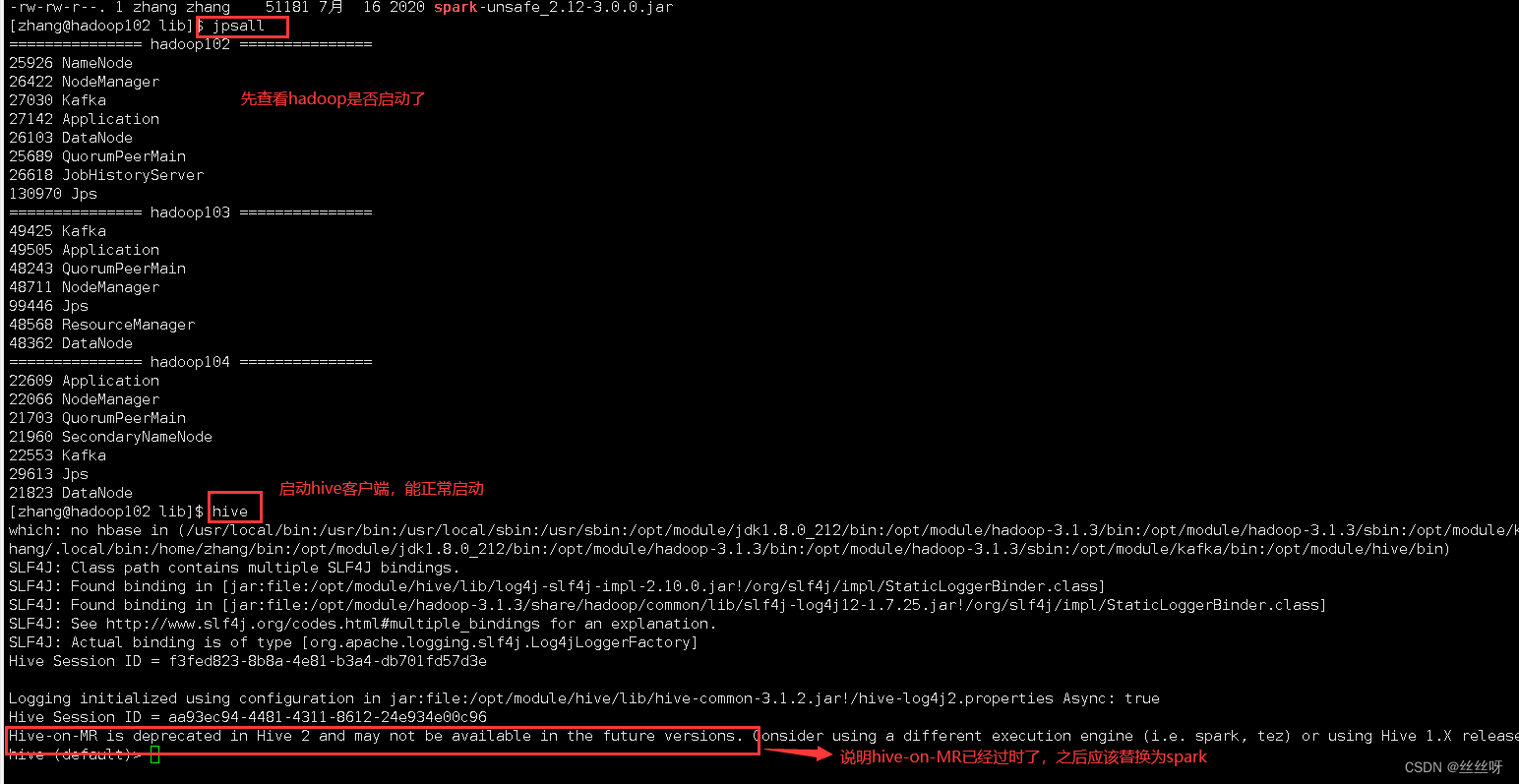

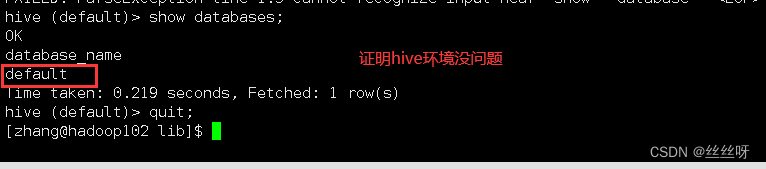

现在就可以正式部署Hive on Spark的环境了。

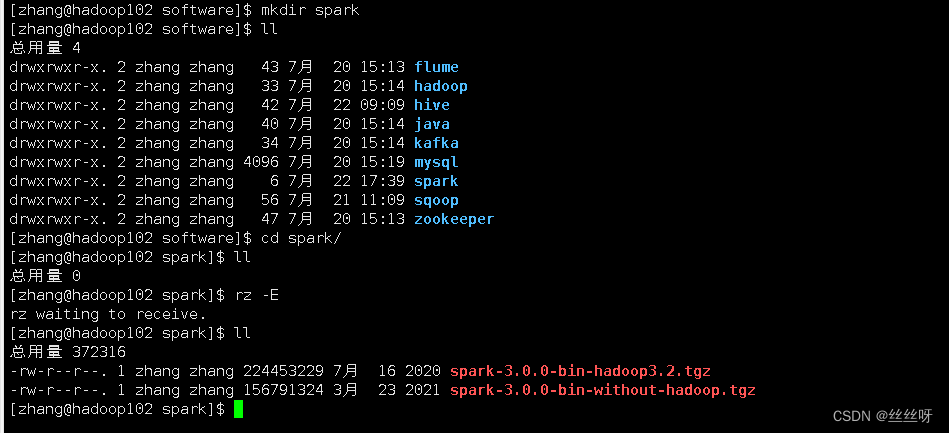

1.1 在Hive所在节点部署Spark

上传压缩包到/opt/software/spark

[zhang@hadoop102 software]$ mkdir spark

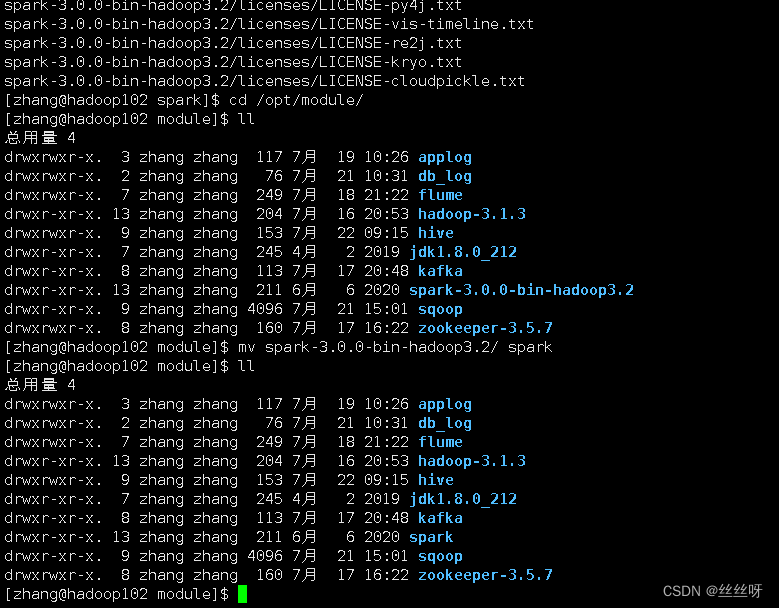

[zhang@hadoop102 spark]$ tar -zxvf spark-3.0.0-bin-hadoop3.2.tgz -C /opt/module/

[zhang@hadoop102 module]$ mv spark-3.0.0-bin-hadoop3.2/ spark

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

620

620

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?