官方文档

http://hadoop.apache.org/docs/r3.0.3/hadoop-project-dist/hadoop-common/SingleCluster.html

hadoop单机搭建

172.25.33.1----server1

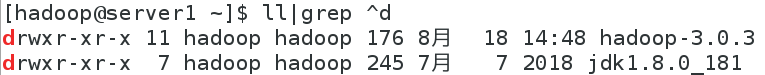

创建普通用户hadoop,获取hadoop包和jdk包

useradd hadoop

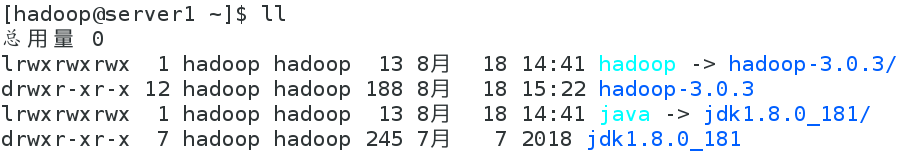

创建软链接

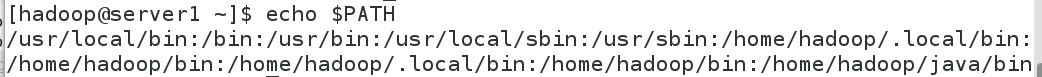

添加java环境变量并生效

vim .bash_profile

source .bash_profile

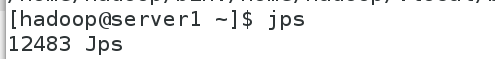

jps命令查看java相关进程

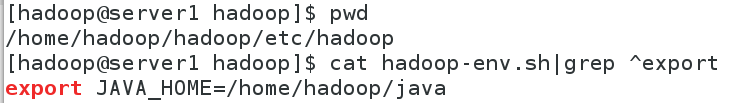

hadoop文件中添加java路径

cd /home/hadoop/hadoop/etc/hadoop

vim hadoop-env.sh

cat hadoop-env.sh|grep ^export

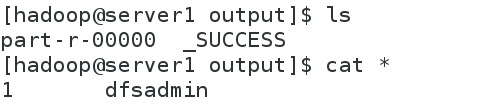

测试

cd /home/hadoop/hadoop

mkdir input

cp etc/hadoop/*.xml input/

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.0.3.jar grep input/ output 'dfs[a-z.]+'

cd output/

ls

part-r-00000 _SUCCESS

伪分布式搭建

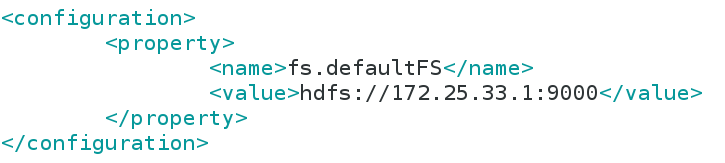

编辑配置文件

cd /home/hadoop/hadoop/etc/hadoop

vim core-site.xml

添加文件内容

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

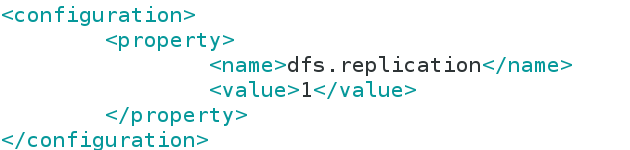

编辑配置文件

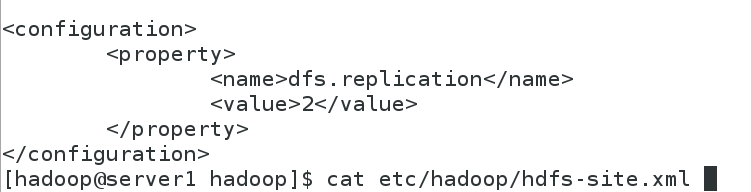

vim hdfs-site.xml

文件编辑内容如下:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value> ##自己充当节点

</property>

</configuration>

设置工作节点

vim hadoop/etc/hadoop/workers

对自己做免密,并格式化

ssh-keygen

ssh-cpoy-id localhost

bin/hdfs namenode -format

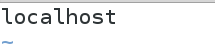

启动,查看结果

hadoop/sbin/start-dfs.sh

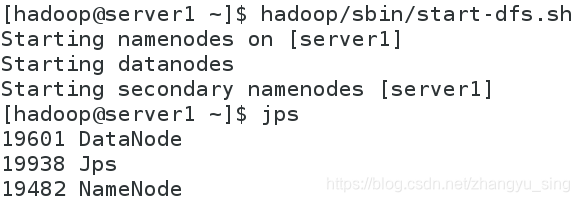

测试

bin/hdfs dfs -put README.txt

bin/hdfs dfs -ls

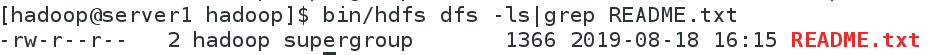

网页查看

分布式文件系统搭建

添加主机

172.25.33.2-----server2

172.25.33.3-----server3

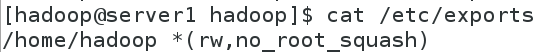

在主节点安装nfs-utils,设置共享目录

/home/hadoop *(rw,no_root_squash)

exportfs -rv

systemctl start rpcbind

systemctl start nfs

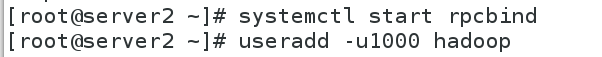

其余节点均添加普通用户,注意UID与主节点一致,并打开rpc端口

systemctl start rpcbind

useradd -u1000 hadoop

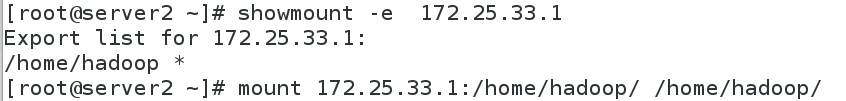

查看并挂载目录

showmount -e 172.25.33.1

mount 172.25.33.1:/home/hadoop/ /home/hadoop/

停止服务(先停止服务,再修改文件)

sbin/stop-dfs.sh

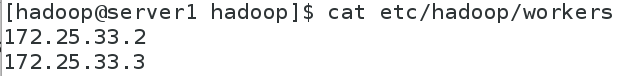

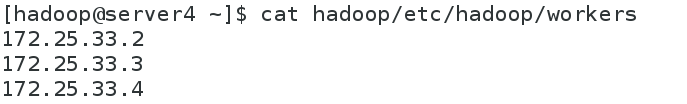

修改配置文件etc/hadoop/workers

修改配置文件etc/hadoop/hdfs-site.xml

重新启动服务,推送文件,查看结果

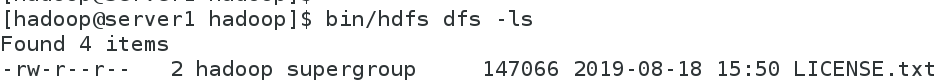

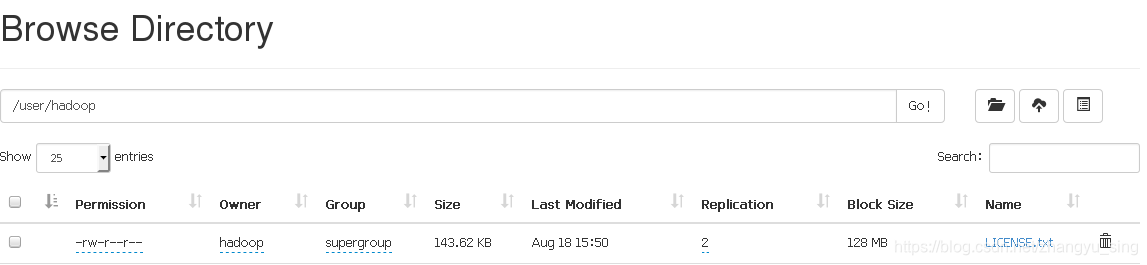

bin/hdfs dfs -put LICENSE.txt

bin/hdfs dfs -ls

网页查看备份也为两份

热添加节点

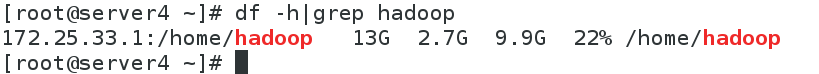

添加节点172.25.33.4------server4

同样打开rrcbind端口,同时创建新用户保持UID一致

systemctl start rpcbind

useradd -u1000 hadoop

showmount -e 172.25.33.1

挂载相应目录

修改worker文件/etc/hadoop/workers

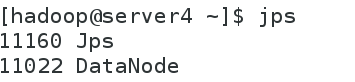

热添加操作

bin/hdfs --daemon start datanode

查看结果

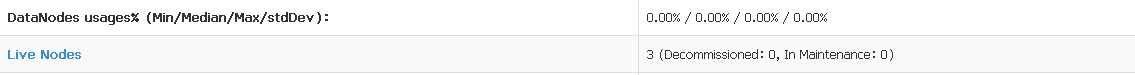

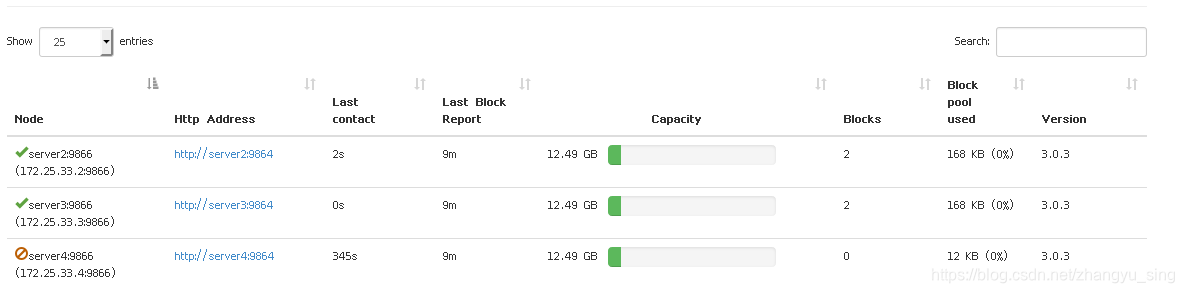

网页查看节点数目为3

删除节点

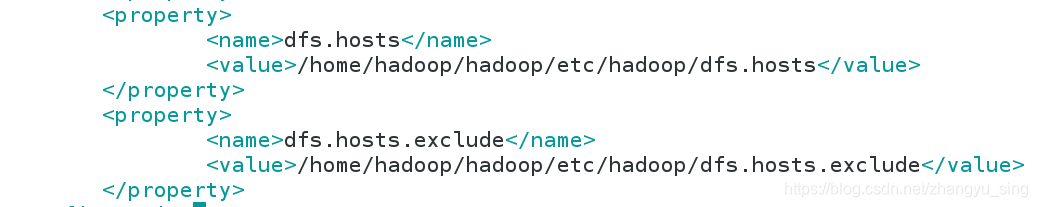

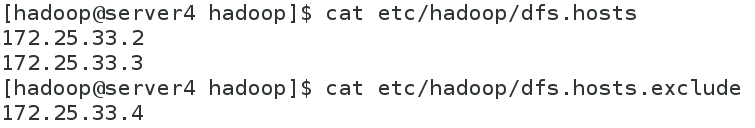

编辑配置文件etc/hadoop/hdfs-site.xml,添加参数

dfs.hosts/dfs.hosts.exclude

编辑这两个文件,内容如下

使用节点刷新命令进行刷新

bin/hdfs dfsadmin -refreshNodes

刷新结果

server4节点处于停止使用状态

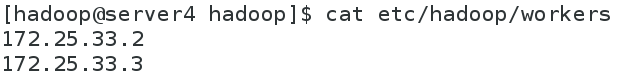

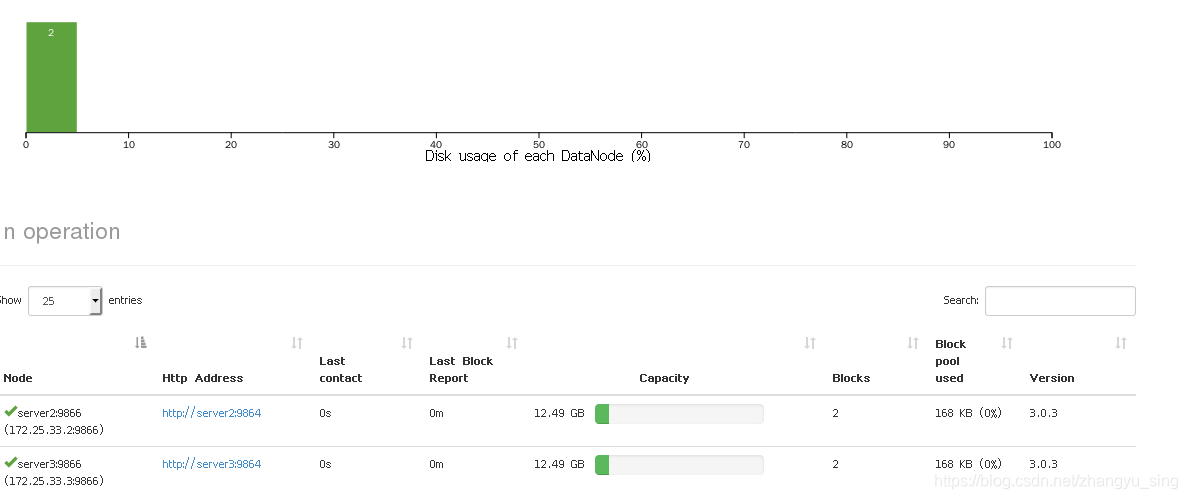

删除worker中的server4

再次进行刷新

44万+

44万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?