配置集群

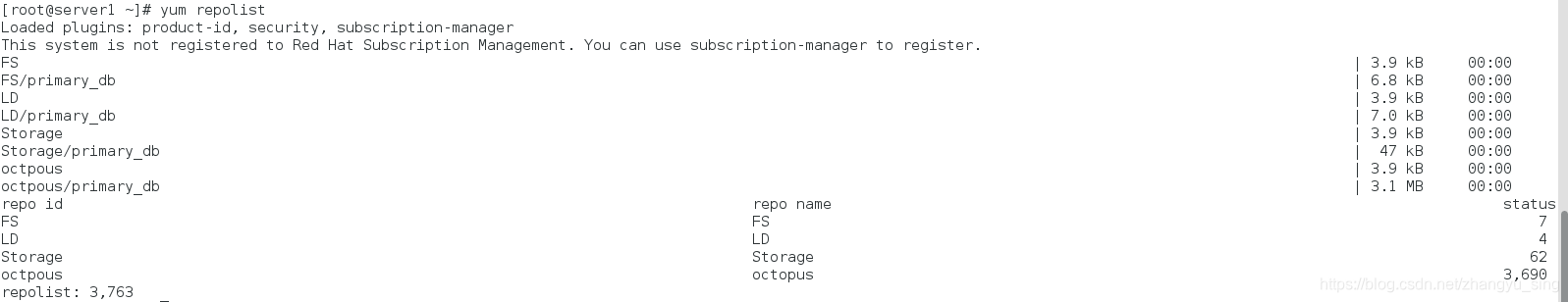

配置YUM源

[octpous]

name=octopus

baseurl=http://172.25.41.254/octopus

gpgcheck=0

[Storage]

name=Storage

baseurl=http://172.25.41.254/octopus/ResilientStorage

gpgcheck=0

[FS]

name=FS

baseurl=http://172.25.41.254/octopus/ScalableFileSystem

gpgcheck=0

[LD]

name=LD

baseurl=http://172.25.41.254/octopus/LoadBalancer

gpgcheck=0

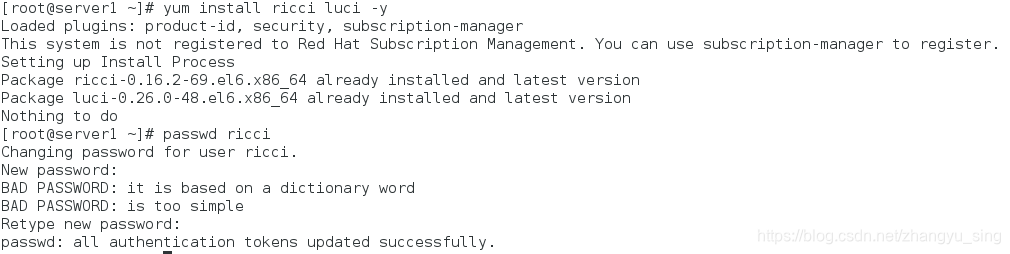

服务端安装ricci以及luci, 启动并设置开机自启动,配置用户密码

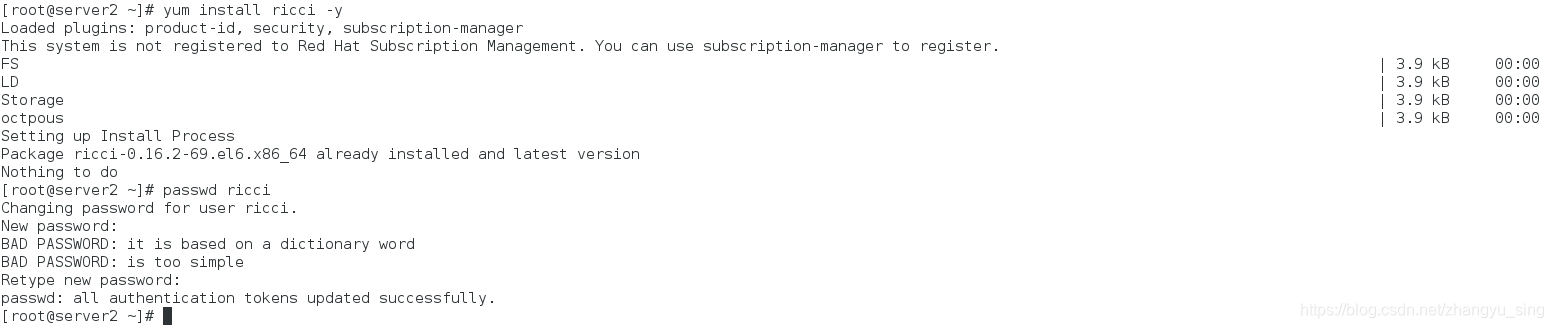

客户端安装ricci,设置相同的root密码

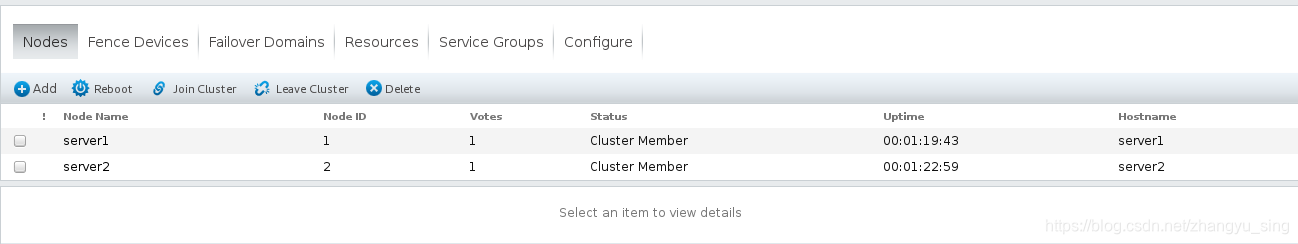

打开网页添加节点,信息如下

cman cluster manager

rgmanager resourece manager

ricci 用户节点

modclusterd 集群模块

clvmd 集群lvm使用域

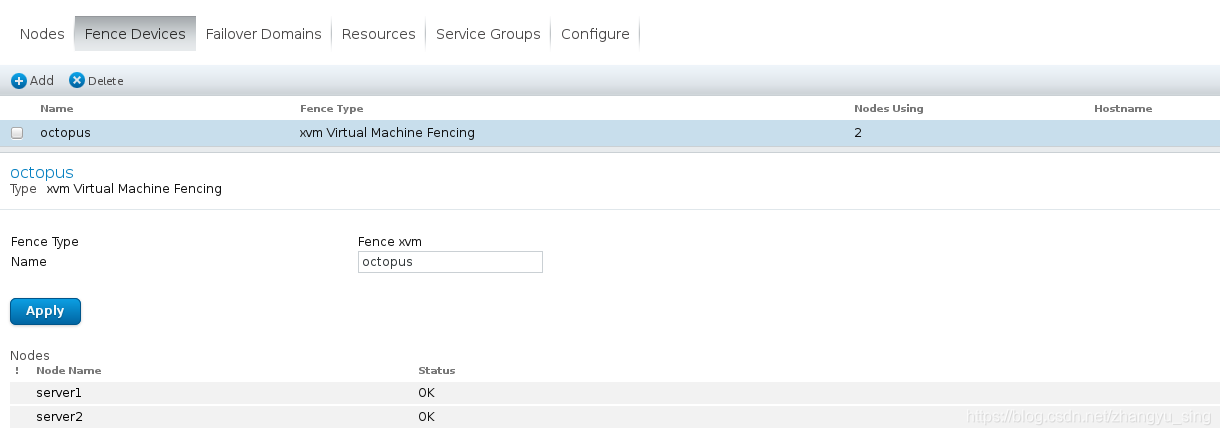

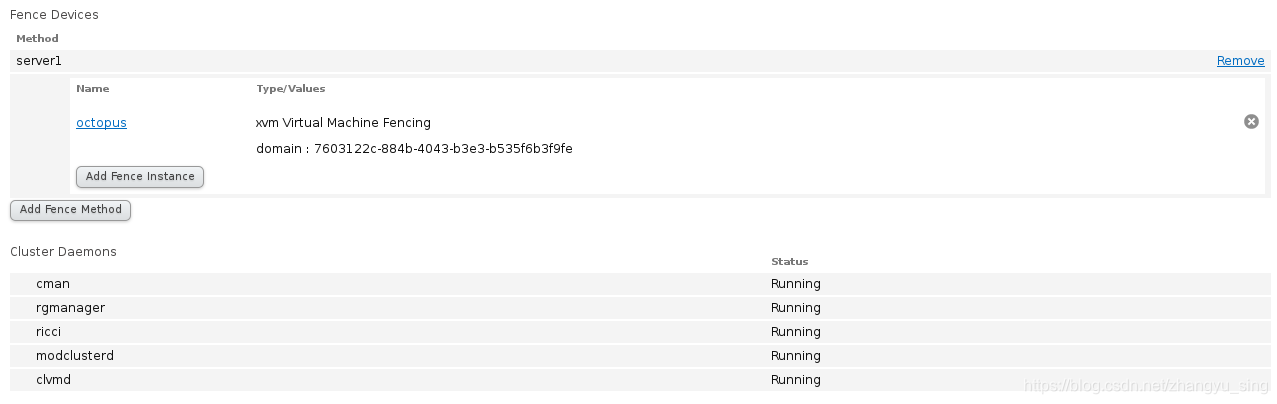

设置fence防止资源争夺

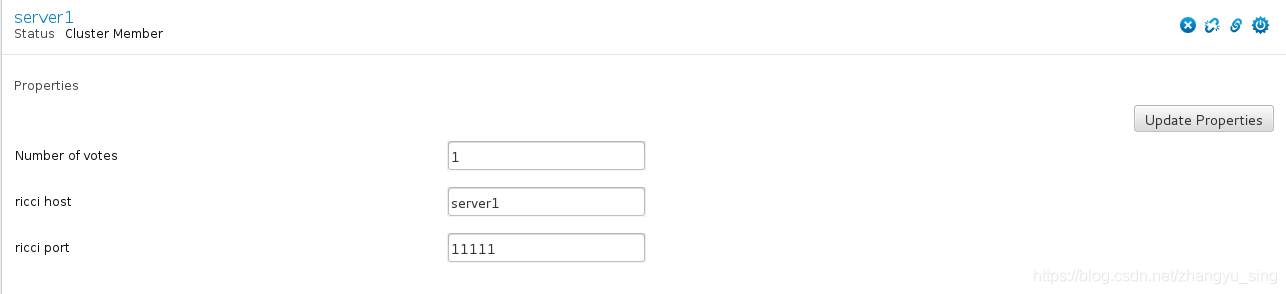

server1信息

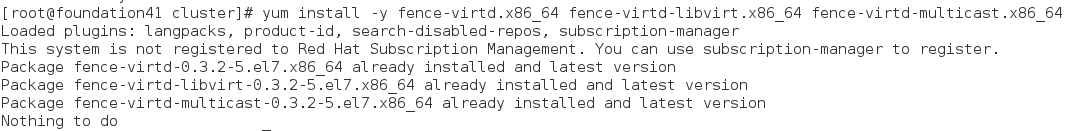

外部主机安装fence

yum install -y fence-virtd.x86_64 fence-virtd-libvirt.x86_64 fence-virtd-multicast.x86_64

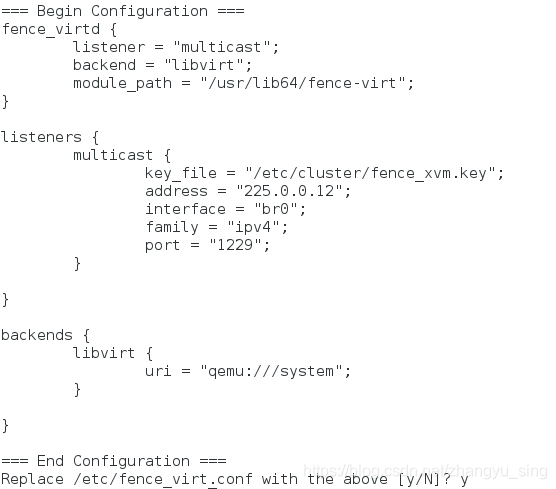

fence_virtd -c进行编译操作

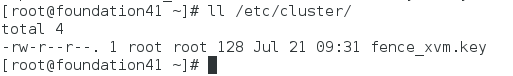

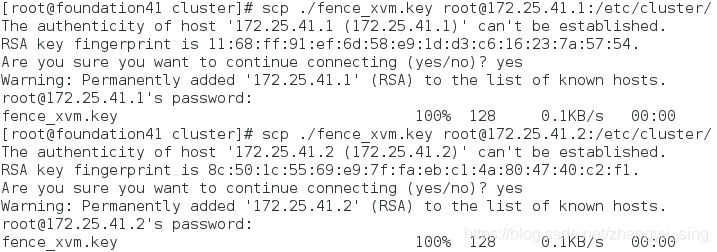

配置key

mkdir /etc/cluster

dd if=/dev/urandom of=/etc/cluster/fence_xvm.key bs=128 count=1

分发key至两台主机

scp ./fence_xvm.key root@172.25.41.1:/etc/cluster/

scp ./fence_xvm.key root@172.25.41.2:/etc/cluster/

网页配置添加fence,信息如下

添加完毕之后 启动服务

systemctl start fence_virtd.service

server1测试

fence_node sever2

结果:server2重新启动

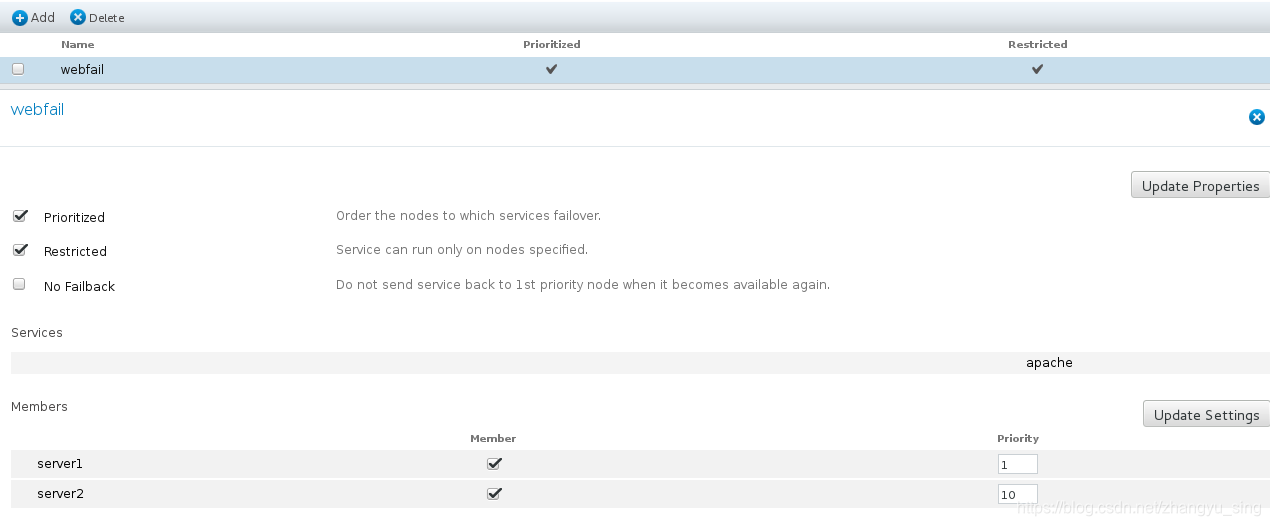

添加错误应对策略

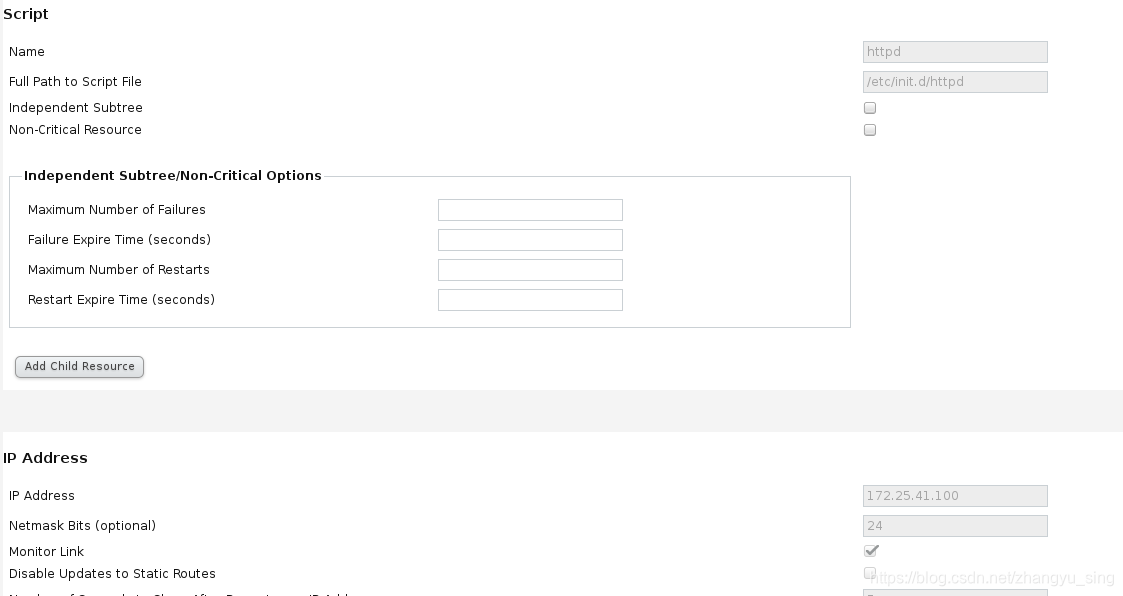

配置集群网页服务

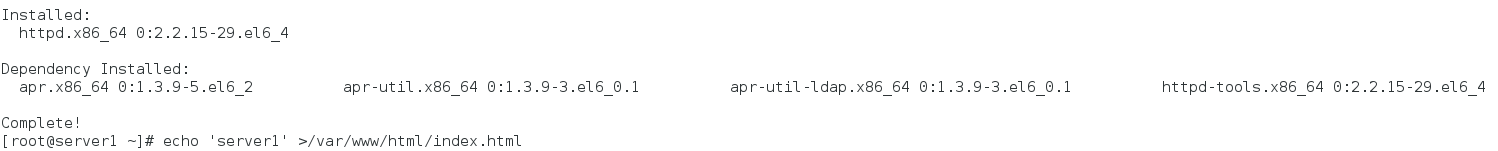

在server1,2上安装apache服务,同时编写主文件

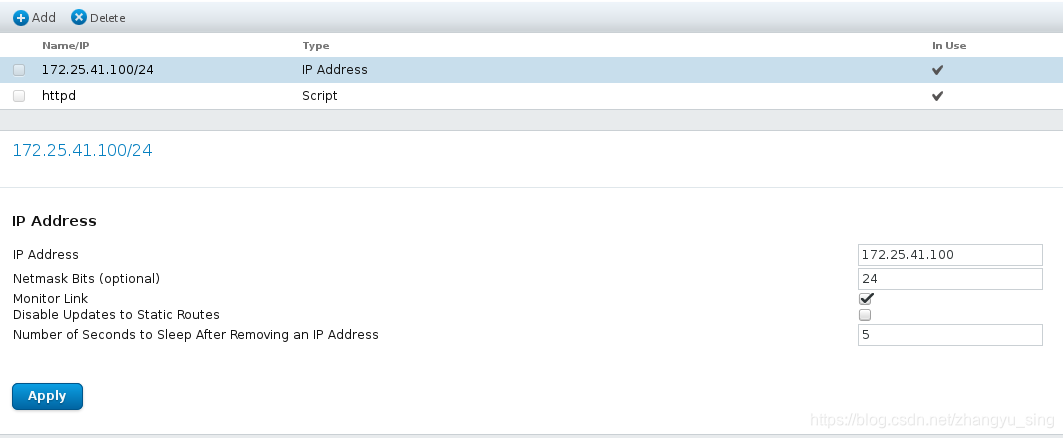

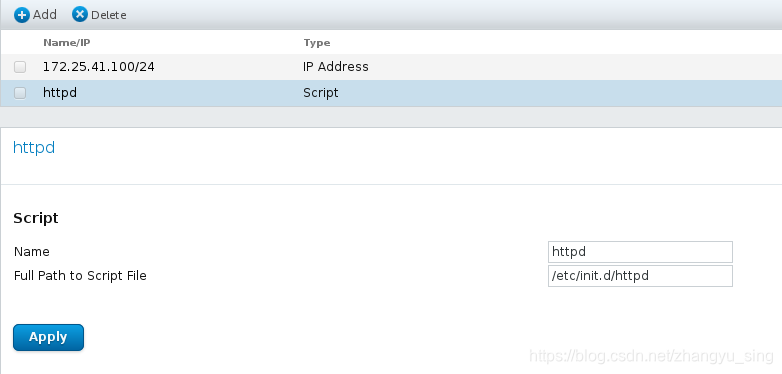

添加可用资源

1.IP地址

2.网页服务

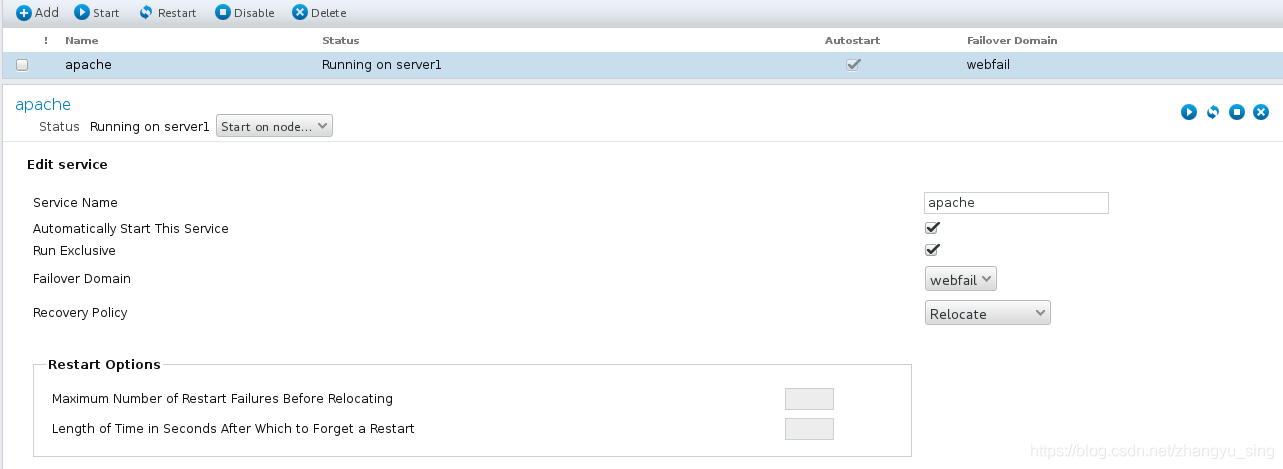

添加服务组,整合资源

添加组

添加可用资源

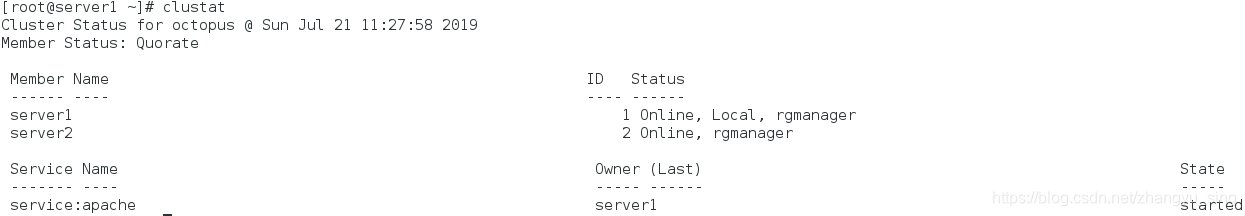

查看结果

添加共享存储

新建虚拟机server3,添加硬盘,配置共享存储

安装scsi

yum install scsi-*

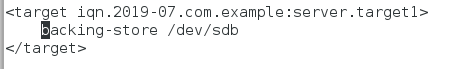

编辑/etc/tgt/targets.conf配置共享存储为/dev/sdb

<target iqn.2019-07.com.example:server.target1>

backing-store /dev/sdb

</target>

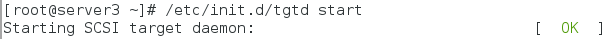

启动服务

/etc/init.d/tgtd start

在server1和2上使用该共享存储

连接共享存储,分区并格式化(可不分区)

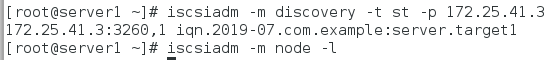

iscsiadm -m discovery -t st -p 172.25.41.3

iscsiadm -m node -l

格式化存储

mkfs.ext4 /dev/sdb

server1和server2两台主机安装mysql-server

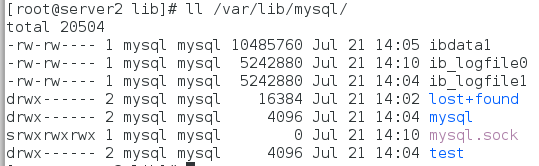

挂载/dev/sdb至/var/lib/mysql

开启mysql,产生文件后关闭mysql将共享存储卸载

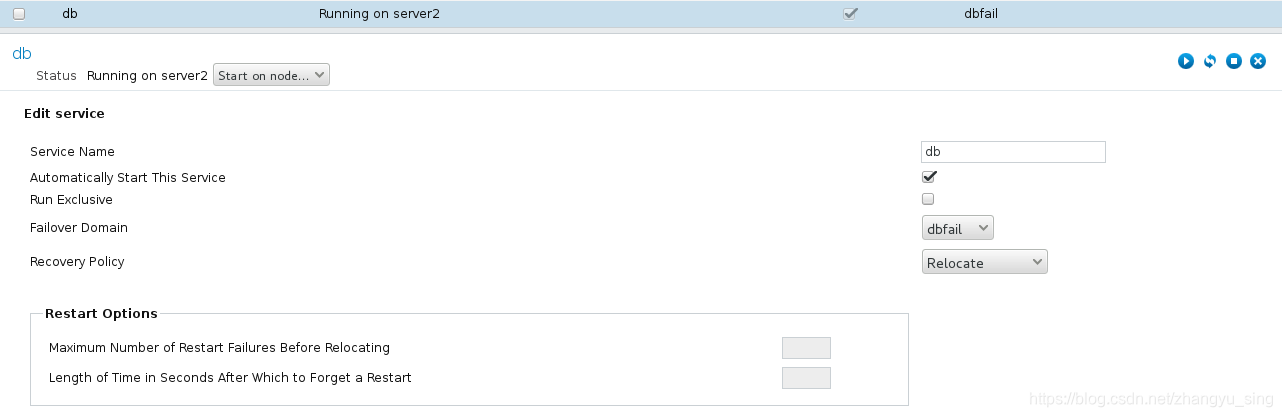

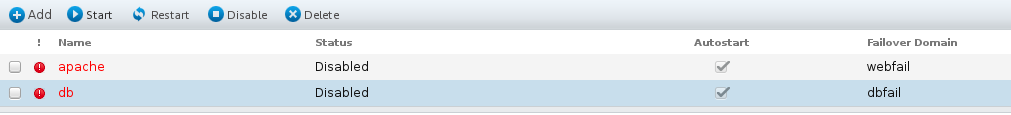

网页配置共享存储

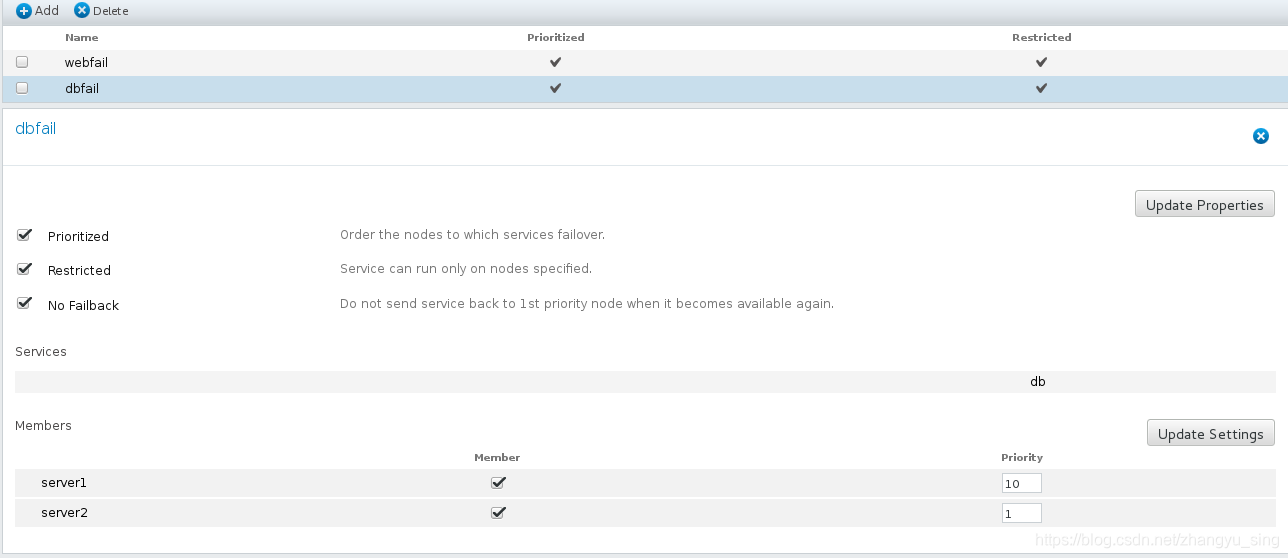

添加错误解决策略

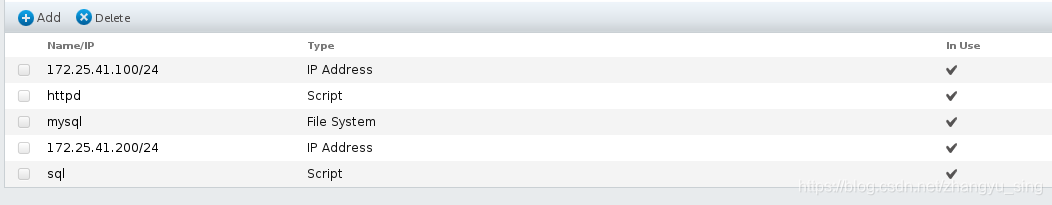

添加网络资源(存储,IP,服务启动脚本)

添加资源组整合添加的存储资源(注意是否开启独占模式)

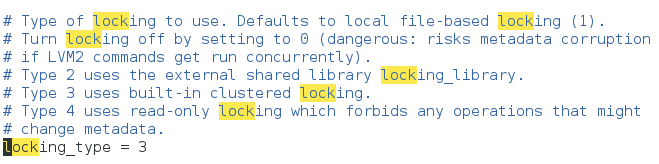

设置全局文件系统

关闭集群

卸载共享存储

确定集群文件系统使用权限

lvsconf --enable-cluster

建立lvm

pvcreate /dev/sdb

vgcreate octopus /dev/sdb

lvcreate -L 4G -n dbdata octopus

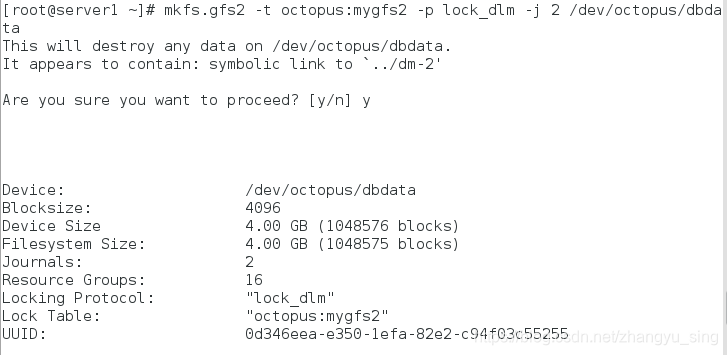

格式化文件系统

mkfs.gfs2 -t octopus:mygfs2 -p lock_dlm -j 2 /dev/octopus/dbdata

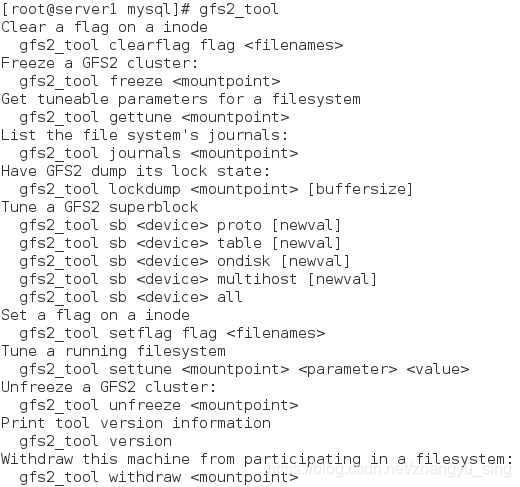

gfs2文件系统管理

gfs2_tool

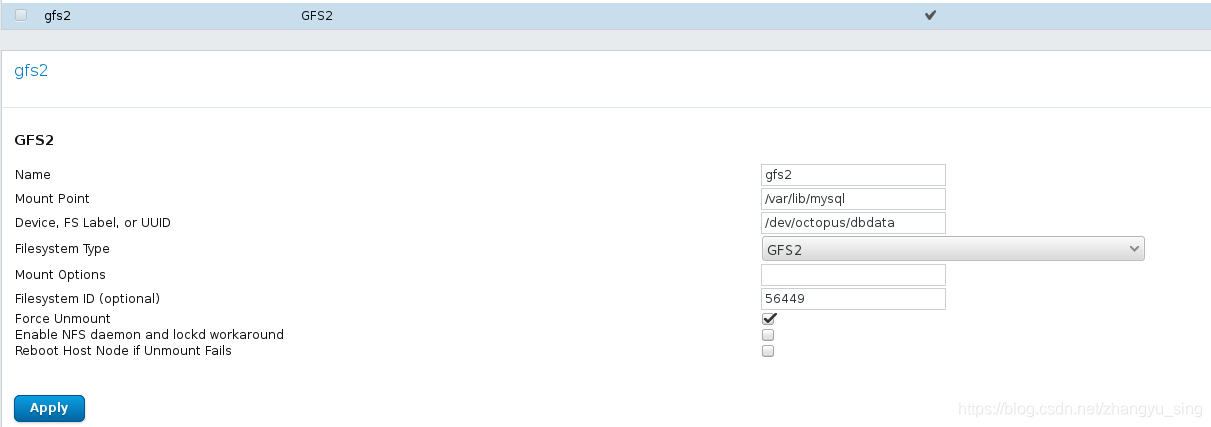

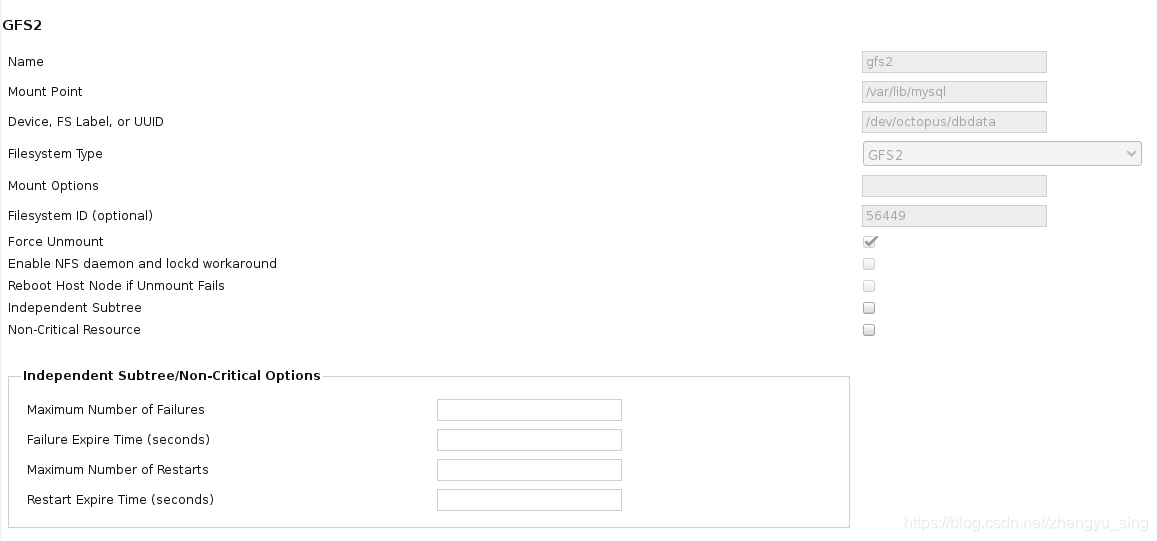

网页添加gfs2文件系统

添加服务组

启动存储部分

本文详细介绍了一个高可用集群的搭建过程,包括配置YUM源、安装和配置关键组件如ricci和luci,设置fence机制防止资源争夺,安装并配置共享存储及数据库服务等步骤。

本文详细介绍了一个高可用集群的搭建过程,包括配置YUM源、安装和配置关键组件如ricci和luci,设置fence机制防止资源争夺,安装并配置共享存储及数据库服务等步骤。

713

713

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?