机器学习的定义

Arthur Samuel 传统定义

Arthur Samuel: “the field of study that gives computers the ability to learn without being explicitly programmed.” This is an older, informal definition.

让计算机无需明确编程,就有学习能力。

Tom Mitchell 现代定义

Tom Mitchell: “A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E.”

若一个程序能从某任务T的经验E中学习后,提高任务T的性能P,就可以成之为机器学习。

比如下棋的例子:

E:下许多盘棋的经验

T:下棋

P:下一盘棋的胜率

通常,机器学习算法可分为两大类:有监督学习和无监督学习。

有监督学习(Supervised Learning)

有监督学习:提供了正确答案。

主要分为回归和分类。

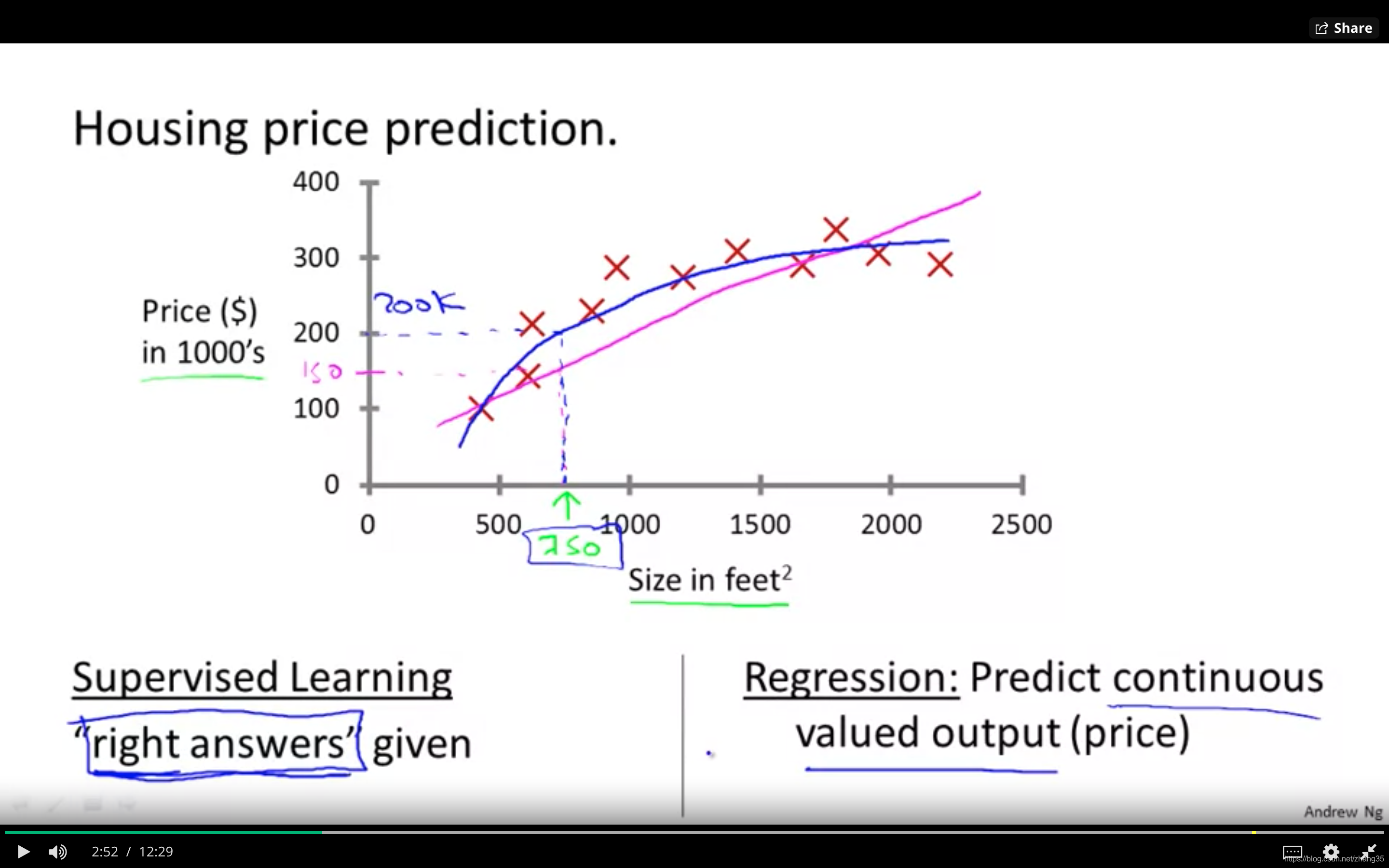

回归(Regression)

需预测的目标变量连续时,比如房价和面积的关系,为线性回归问题;

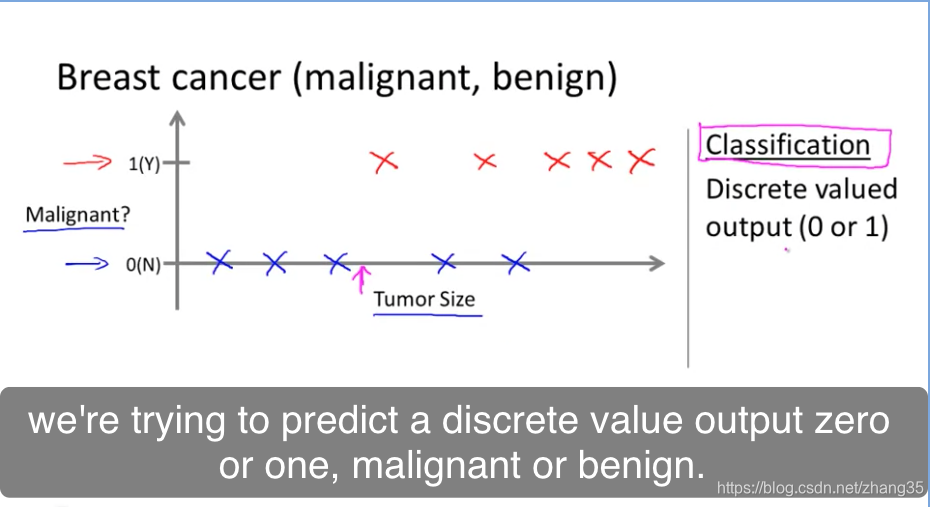

分类(Classification)

只有离散的几种取值时,比如肿瘤是否是良性,则为分类问题。

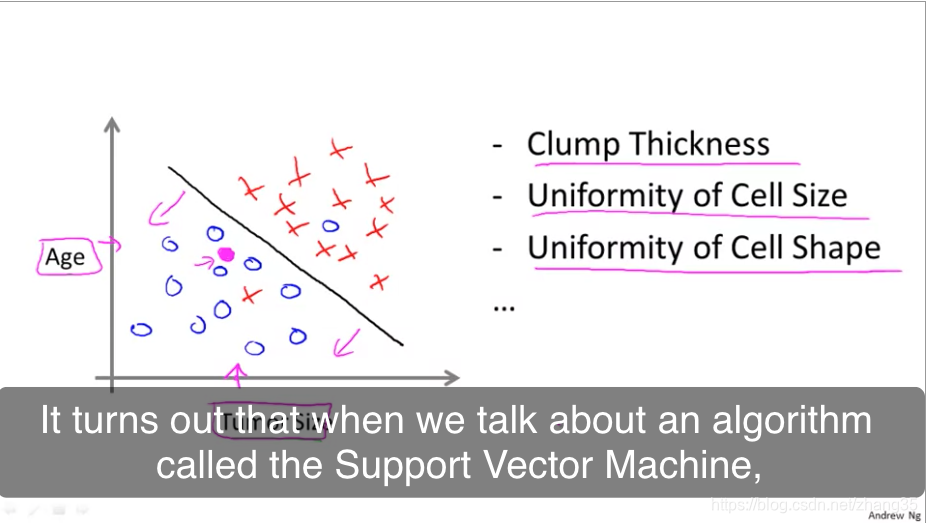

需要分类的属性太多,就需要用到支持向量机:

无监督学习(Unsupervised Learning)

无监督学习:不提供参考答案。只能从数据本身的关联中提取模式。

聚类: 给你1,000,000个不同的基因,通过不同的变量如寿命、位置、角色等,将它们自动分类。

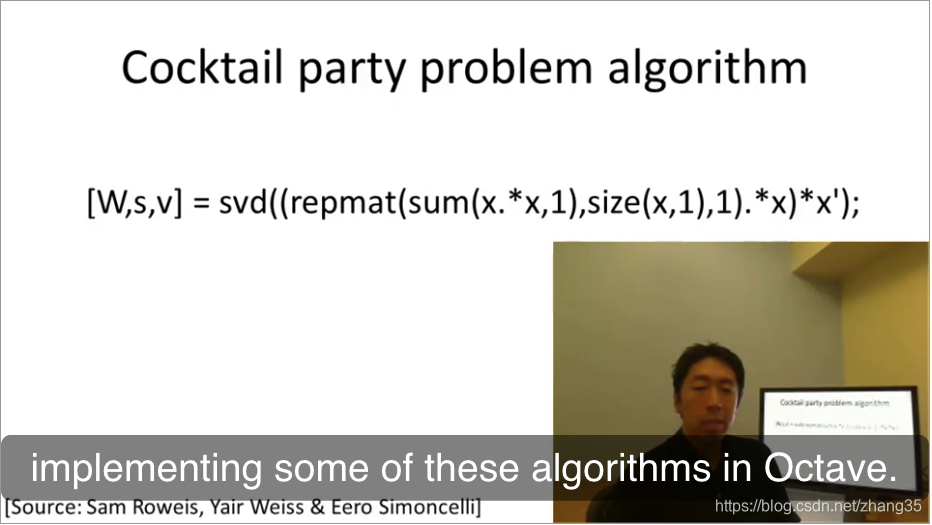

非聚类:鸡尾酒聚会算法,能在嘈杂环境中识别出背景音乐和不同个体的声音。

鸡尾酒聚会问题,一行代码解决:

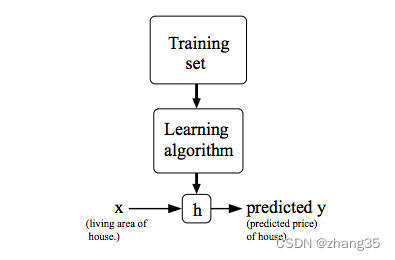

模型

x(i) : 输入变量

y(i) : 目标变量

h(x) :hypothesis,假设的目标函数

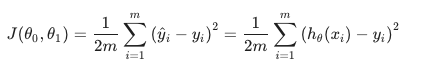

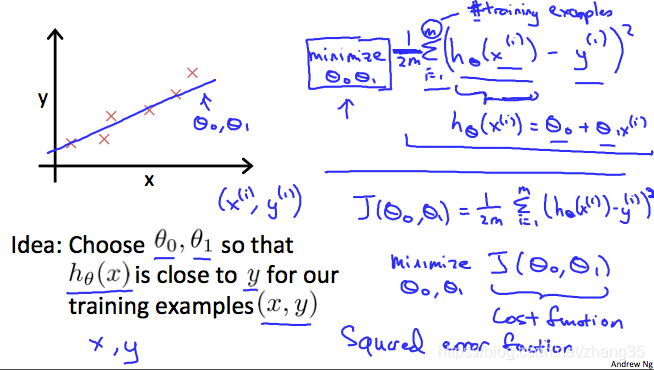

代价函数

J(θ) 代表目标函数和原始函数见的差距,即代价函数。

使得J(θ)最小的那个h(x)就是预期的目标函数。

最常用的J(θ)表示如下,也叫做均方差函数:

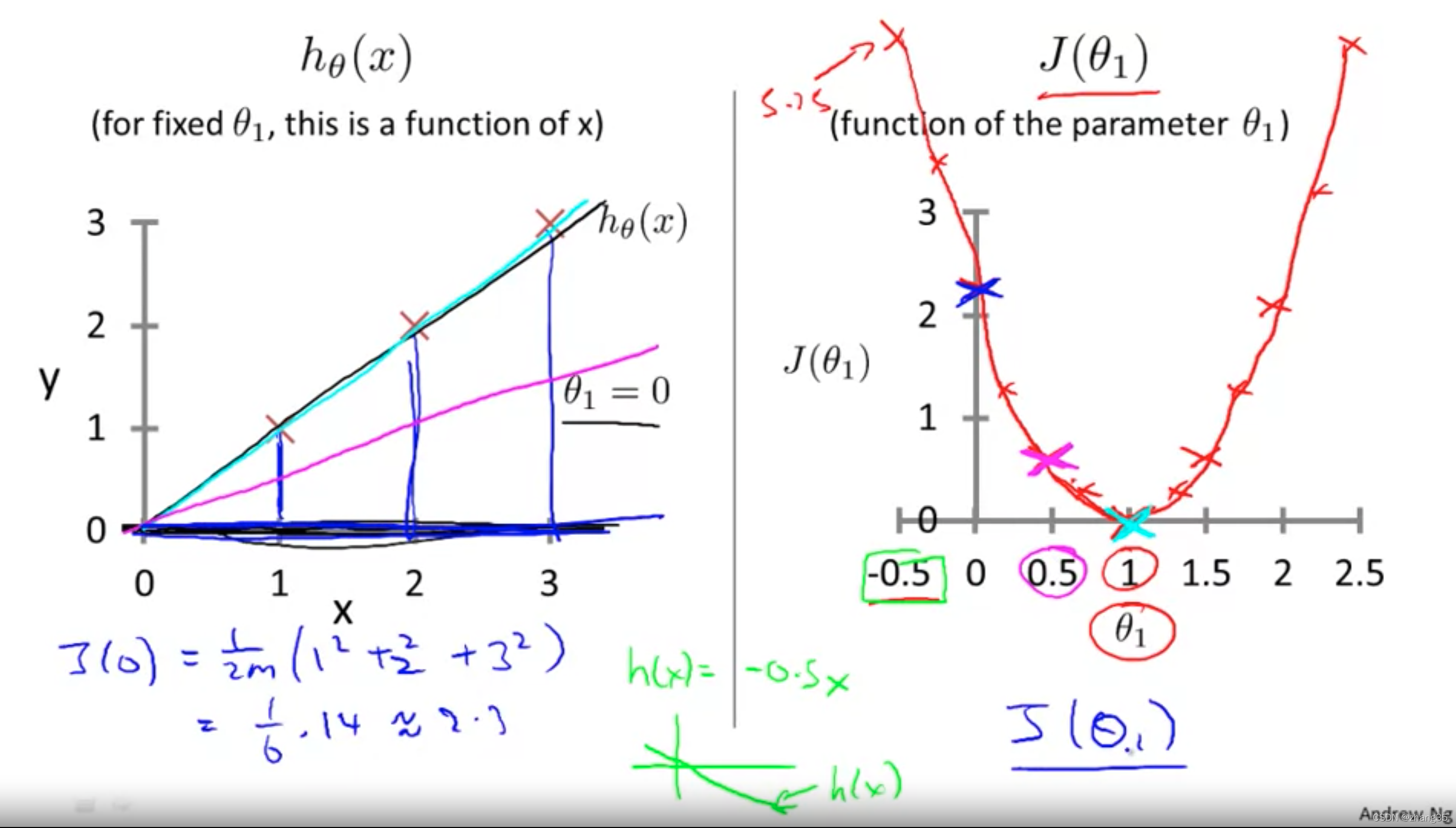

当J(θ0)只有一个变量时,J随θ的变化是二维图像:

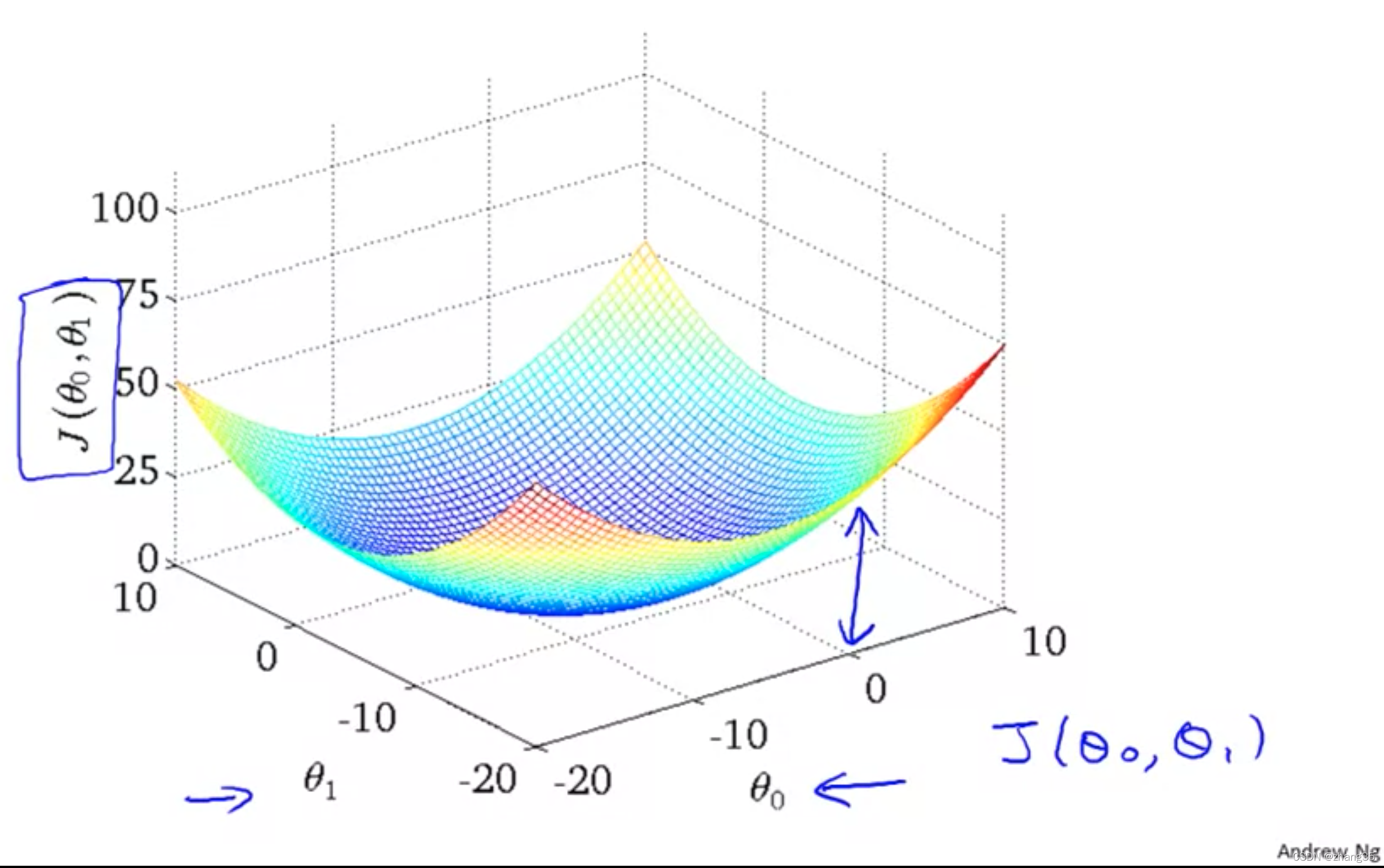

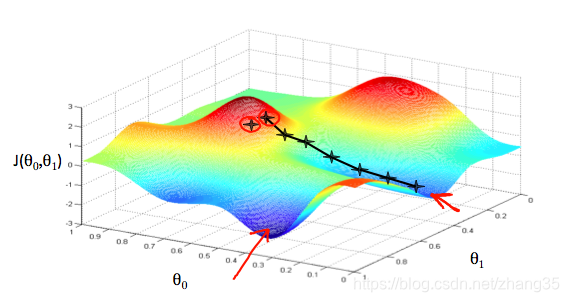

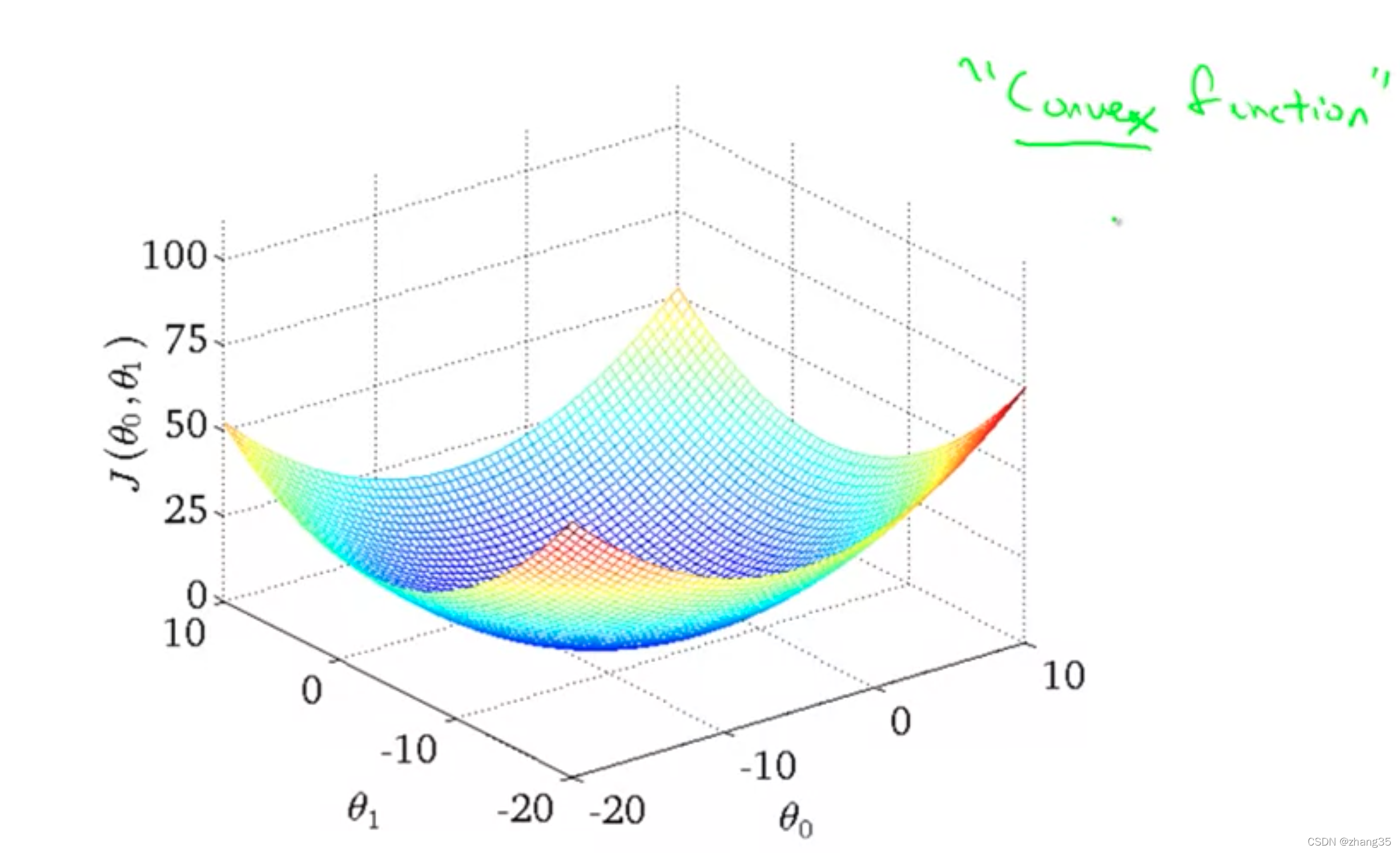

当J(θ0, θ1)有两个变量时,函数图是三维的:

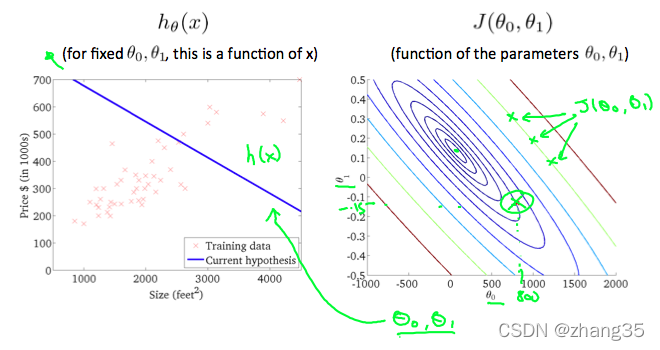

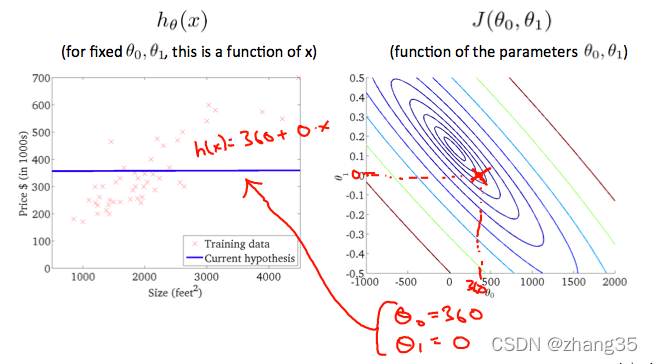

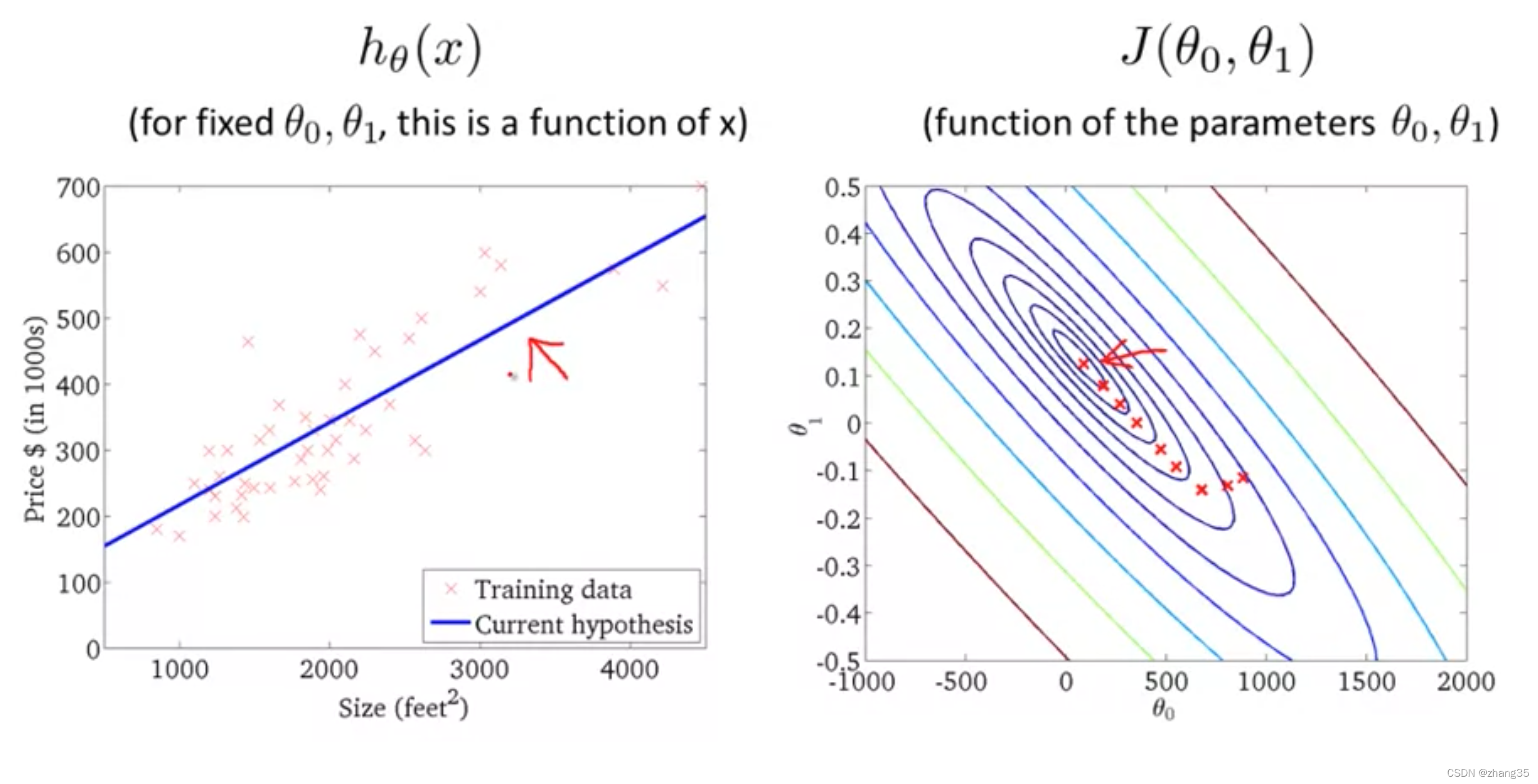

可以用等高线来表示取得相同J值的θ0和θ1。

右图从等高线外围到中心,J的值越来越小,可以看到对应左侧的h(x)越来越靠谱:

梯度下降(gradient descent)

寻找最佳目标函数h(x)的过程,也即最小化代价函数J(θ)的过程。

目标就是找到让J(θ)最小的θ值。

寻找最小θ值,一般用梯度下降法。

这里需要认识一些术语:

derivative term 导数项

Partial Derivative 偏导数

multivariate 多元

convergent 收敛

calculus 微积分

tangent 切线;正切

convex function 凸函数(碗状的)

Quadratic function:二次函数

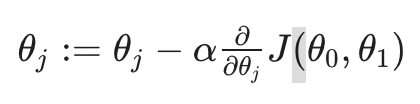

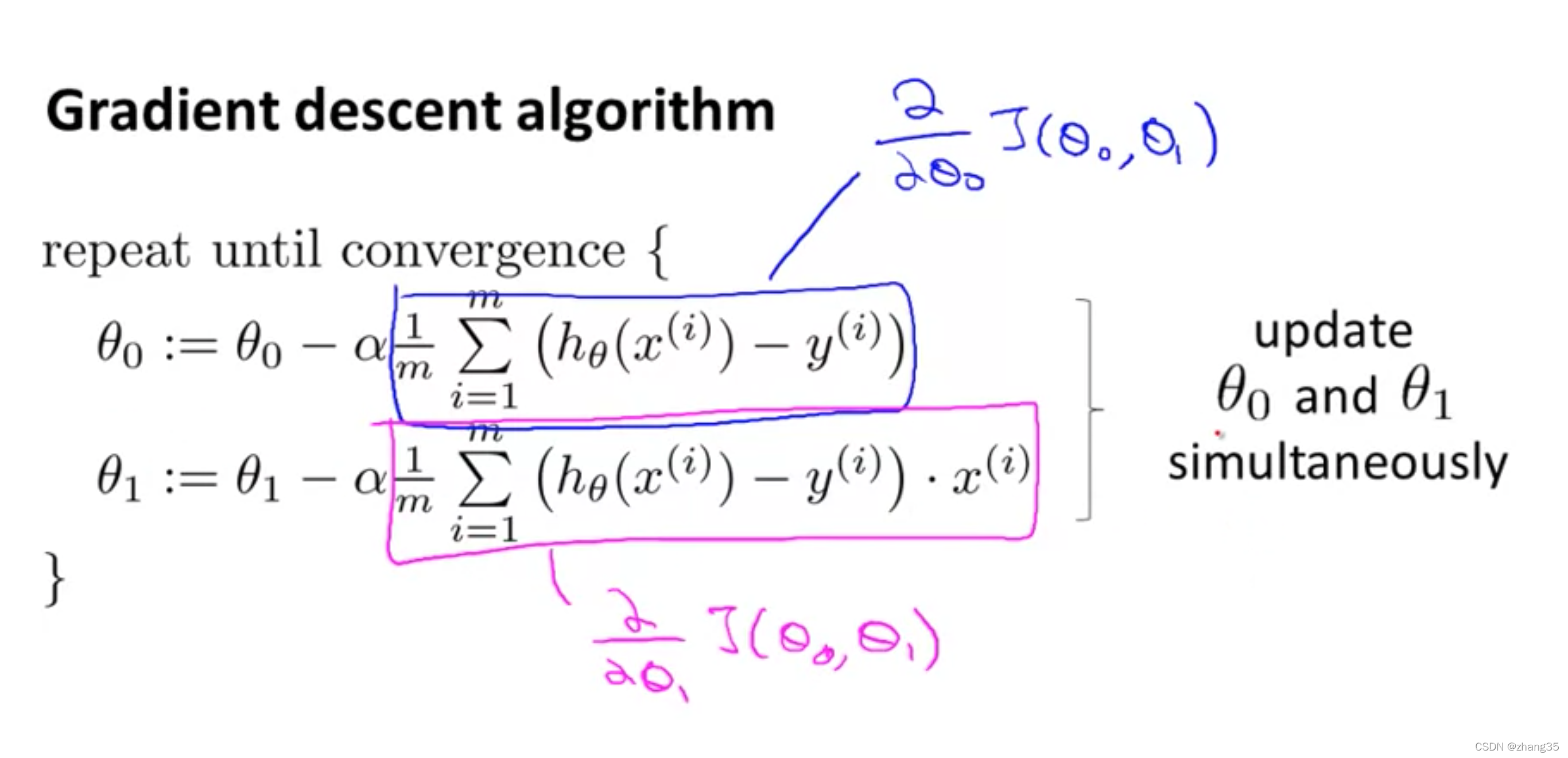

梯度下降法公式:重复以下式子,直到收敛。

求解过程如下图,每个星星是一步。

α:学习率,α越大,步子越大;

J的偏导数,从几何意义上讲,就是函数变化增加最快的地方。朝着下降最多的方向进行;

不同的起点,会带来不同的下降方向,如下图:

θ0, θ1的起始值其实无关紧要,一般均初始化为0。

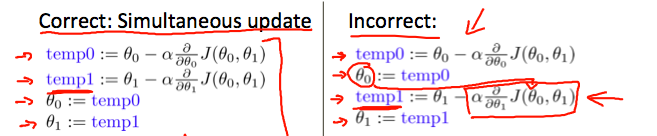

梯度下降,一定要同步更新多个变量,否则就会出错:

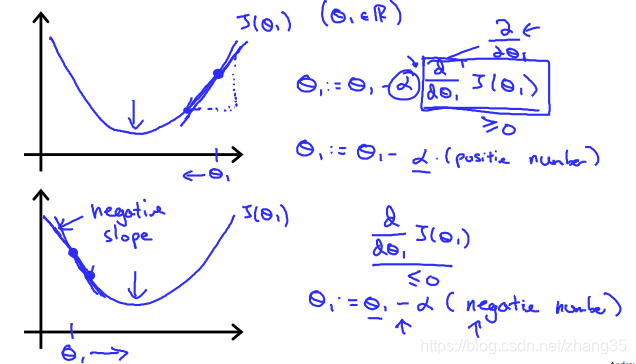

朝着梯度下降的方向逐渐收敛,在斜率为正的地方会减小,斜率为负的地方会增大,就是为了滑到谷底。

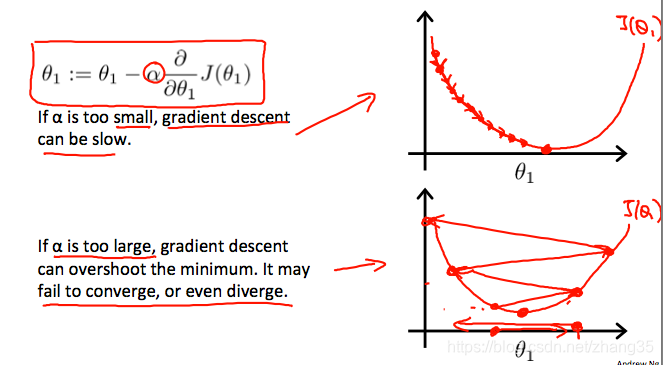

a过小时,收敛速度会过慢;

a过大时,步子迈得太大,甚至可能会发散。

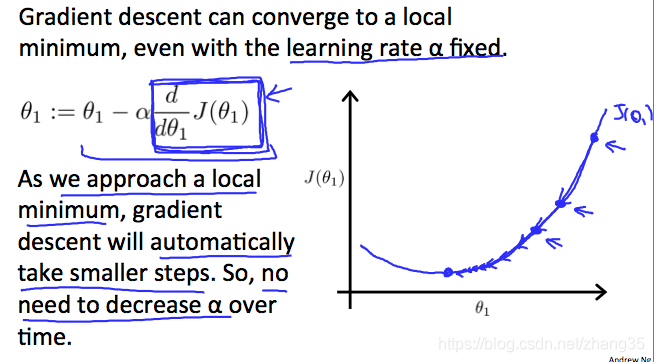

固定的a也能自动减小step,因为导数在逐渐减小:

所以不用手动减小a。

例子:线性回归中的梯度下降

线性回归中,J是一个凸函数,所以总是能到达全局最优解:

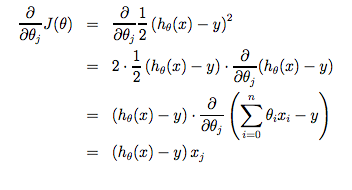

偏导数如下:

此时梯度下降公式就变成了:

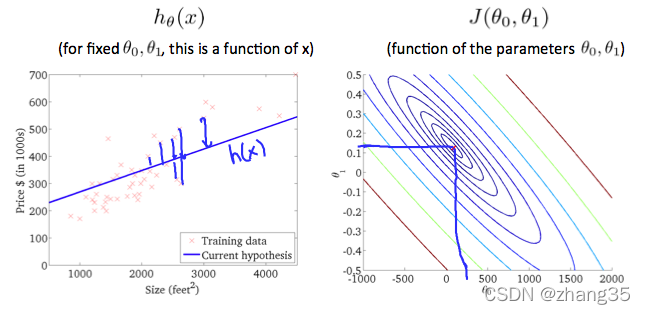

每步梯度下降,对应的图像化表示为:

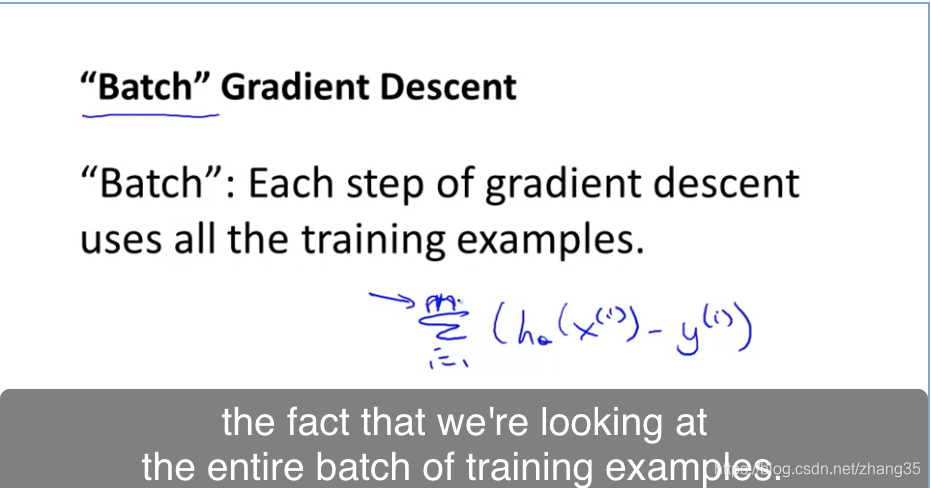

线性回归使用了批量梯度下降:即每步都使用所有的训练集。

其它梯度下降算法可能仅使用一个子集的训练数据。

至此学习了第一个机器学习算法,

这篇博客介绍了机器学习的基本定义,包括Arthur Samuel和Tom Mitchell的观点,并详细讲解了有监督学习中的回归和分类。此外,还涵盖了无监督学习、模型、代价函数、梯度下降及其在线性回归中的应用。最后,文章回顾了线性代数的基础知识,如矩阵运算和向量。

这篇博客介绍了机器学习的基本定义,包括Arthur Samuel和Tom Mitchell的观点,并详细讲解了有监督学习中的回归和分类。此外,还涵盖了无监督学习、模型、代价函数、梯度下降及其在线性回归中的应用。最后,文章回顾了线性代数的基础知识,如矩阵运算和向量。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1398

1398

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?