1 简介

Prophet:先知。ProphetNet,先知网络,名字起的牛。

本文根据2020年《ProphetNet: Predicting Future N-gram for Sequence-to-Sequence Pre-training》翻译总结。

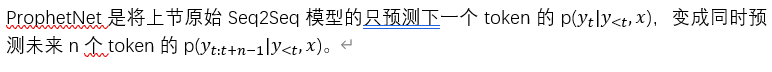

ProphetNet:将在XLNet中提到的two-stream 自注意力扩展到n-strean 自注意力。

ProphetNet可以同时预测未来的n-gram,而原始的transformer只预测未来的一个单词。

2 ProphetNet

ProphetNet基于transformer encoder-decoder结构。相比最初的transformer Seq2Seq model,ProphetNet进行了如下3个修改:

1)引入了自监督目标:n-gram 预测;

2)引入了n-gram自注意力机制;

3) mask based autoencoder denoising task for Seq2Seq pre-training。

2.1 Sequence-to-Sequence Learning

2.2 未来N-gram的预测

如上图,encoder不变,还是原始transformer的encoder。

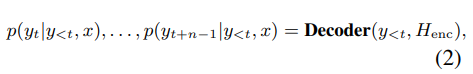

ProphetNet Decoder变成同时预测未来n个token。

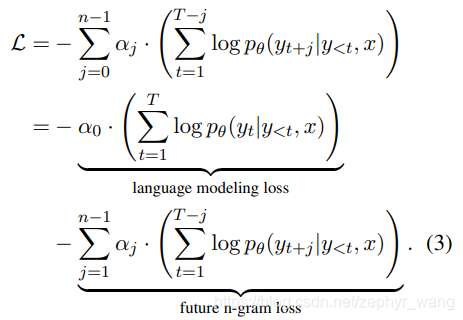

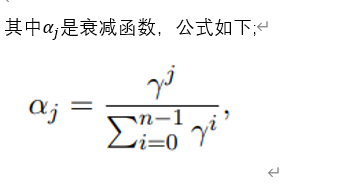

n-gram 预测目标函数如下,包括两部分,第一部分language modeling loss,同原来transformer的;第二部分是n-1 未来token预测损失函数,使模型预测未来的tokens:

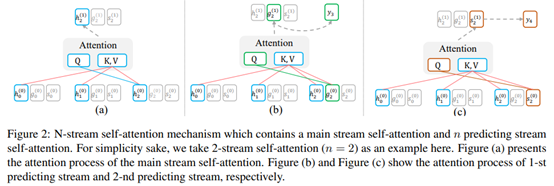

2.3 N-Stream 自注意力

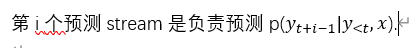

如下图,h stream是主要的stream,g stream是未来第1个token的预测stream,s stream是未来第2个token的预测stream.

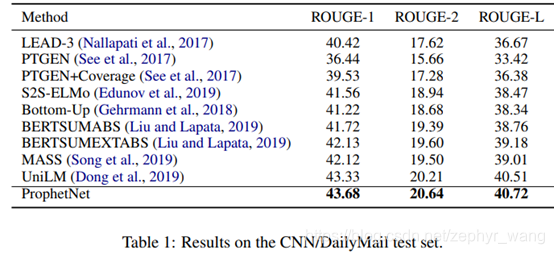

3 实验结果

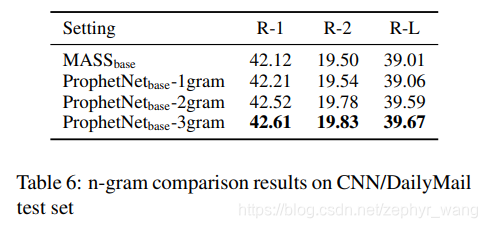

不同n-gram比较,如下表,可以看到3gram比2gram好。:

ProphetNet是基于transformer的Seq2Seq模型改进版,通过引入n-gram预测目标和n-stream自注意力机制,能预测未来的多个token。相比传统的transformer,ProphetNet在n-gram预测上表现更优,特别是在3-gram预测上。该模型增加了自监督学习任务,提升了预训练效果。

ProphetNet是基于transformer的Seq2Seq模型改进版,通过引入n-gram预测目标和n-stream自注意力机制,能预测未来的多个token。相比传统的transformer,ProphetNet在n-gram预测上表现更优,特别是在3-gram预测上。该模型增加了自监督学习任务,提升了预训练效果。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?