一、介绍

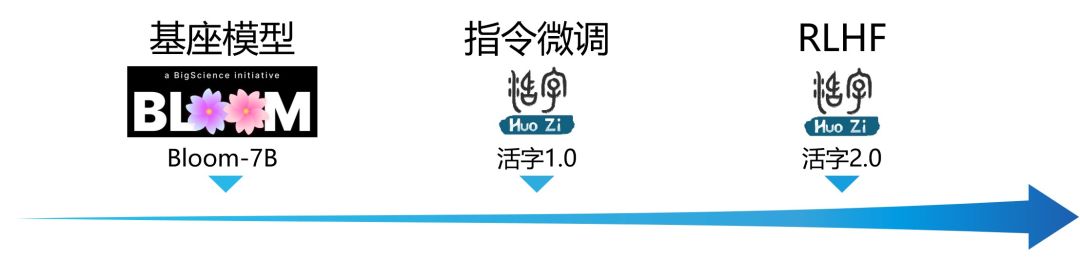

大规模语言模型(LLM)在自然语言处理的通用领域已取得了令人瞩目的成功。对于广泛的应用场景,这种技术展示了强大的潜力,学术界和工业界的兴趣也持续升温。哈工大自然语言处理研究所30余位老师和学生参与开发了通用对话大模型活字1.0,哈工大社会计算与信息检索研究中心(哈工大-SCIR)研发了活字2.0,致力于为自然语言处理的研究和实际应用提供更多可能性和选择。

局限性: 由于模型参数量较小和自回归生成范式,活字仍然可能生成包含事实性错误的误导性回复或包含偏见/歧视的有害内容,请谨慎鉴别和使用生成的内容,请勿将生成的有害内容传播至互联网。若产生不良后果,由传播者自负。

二、模型特色

活字1.0

- 活字1.0 由哈工大自然语言处理研究所30余位老师和学生研发

- 在BLOOM-7B基础上,通过指令微调后,获得更加通用的完成任务的能力

- 支持中英双语:在标准的中/英文基准与主观测评上均取得优异的效果,同时支持多语言对话能力

- 更丰富的指令微调数据:人工构造了更多指令微调模板,以及一些列的Self-instruction指令构造的SFT数据,使得指令微调的数据更加丰富

- 取得更好的指令遵循能力

- 支持生成代码以及表格

- 更高质量的安全数据:基于多轮对抗攻击,以SFT形式手动设计安全数据,强化模型回复的安全性和合规性

- 安全性指标达到 84.4%,在特定测试集上超越了ChatGPT

活字2.0

- 活字2.0由哈工大社会计算与信息检索研究中心(SCIR)完成研发

- 在活字1.0基础上,通过人类反馈的强化学习 (RLHF)进一步优化了模型回复质量,使其更加符合人类偏好

- 融合多种trick的稳定PPO训练:训练更加稳定高效

- 训练过程中保持数据分布一致

- 在奖励函数中加入KL-散度罚值

- Actor权重滑动平均

- 多维度标注的中文偏好数据:回答更丰富,遵从指令的能力更强,逻辑更加清晰

- 针对Instru

- 融合多种trick的稳定PPO训练:训练更加稳定高效

哈工大开源大语言模型活字:性能与局限,

哈工大开源大语言模型活字:性能与局限,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

835

835

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?