分词器

Analysis 和 Analyzer

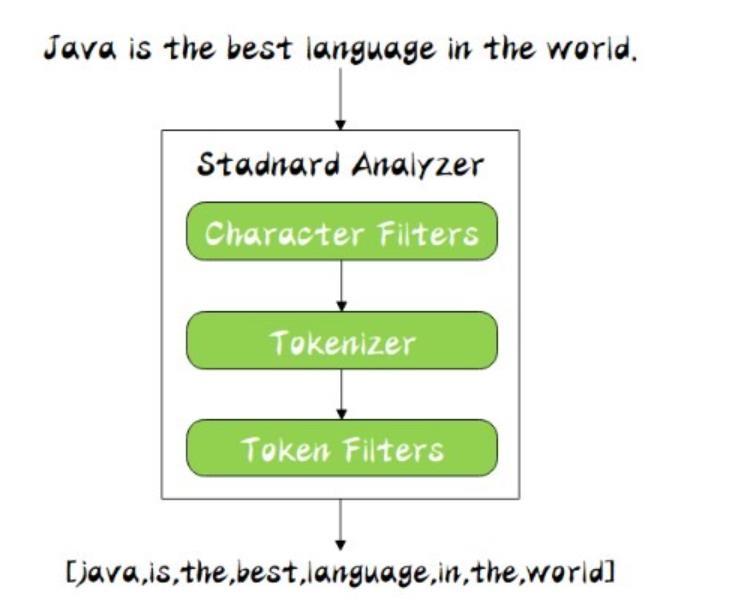

Analysis: 文本分析是把全文本转换一系列单词(term/token)的过程,也叫分词(Analyzer)。Analysis是通过Analyzer来实现的。分词就是将文档通过Analyzer分成一个一个的Term(关键词查询),每一个Term都指向包含这个Term的文档。

Analyzer 组成

-

注意: 在ES中默认使用标准分词器: StandardAnalyzer 特点: 中文单字分词 单词分词

我是中国人 this is good man----> analyzer----> 我 是 中 国 人 this is good man

分析器(analyzer)都由三种构件组成的:

character filters,tokenizers,token filters。

-

character filter字符过滤器-

在一段文本进行分词之前,先进行预处理,比如说最常见的就是,过滤html标签( hello --> hello),& --> and(I&you --> I and you)

-

-

tokenizers分词器-

英

-

本文介绍了ElasticSearch的文本分析过程,分析器Analyzer由字符过滤器、分词器和Token过滤器组成。讨论了内置的Standard、Simple、Stop和Whitespace Analyzer,并详细讲解了中文分词器IK的安装、使用以及扩展词和停用词的配置。

本文介绍了ElasticSearch的文本分析过程,分析器Analyzer由字符过滤器、分词器和Token过滤器组成。讨论了内置的Standard、Simple、Stop和Whitespace Analyzer,并详细讲解了中文分词器IK的安装、使用以及扩展词和停用词的配置。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2632

2632

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?