Import

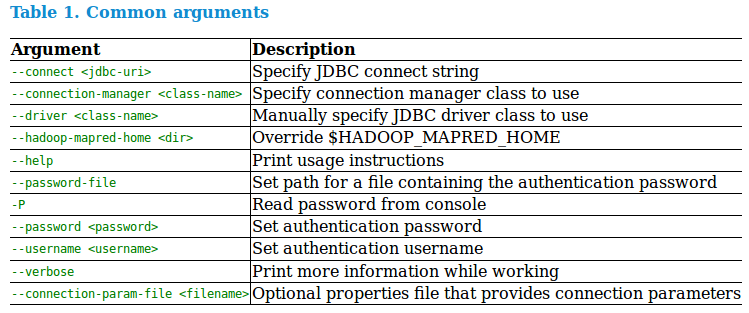

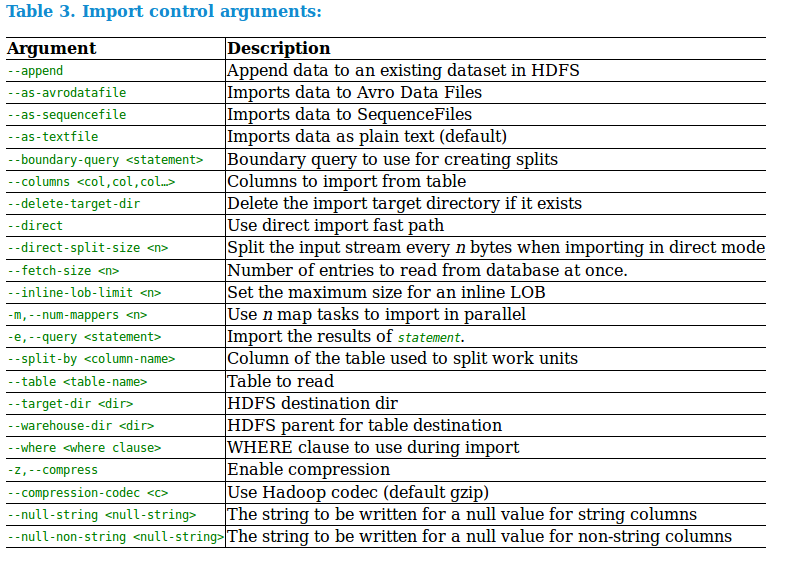

import --connect jdbc:mysql://192.168.122.1:3306/sample

--username zhj --password 123456

--table actor

--columns "id, name, birthday"

--where "id>40"

--m 3

--target-dir /user/zhj/sqoop/actor // or --warehouse-dir /user/zhj/sqoop

import --query 'SELECT a.*, b.* FROM a JOIN b on (a.id == b.id) WHERE $CONDITIONS'

--split-by a.id --target-dir /user/foo/joinresults

本文介绍如何使用 Sqoop 工具从 MySQL 导入数据到 HDFS,包括连接配置、指定表及列、条件筛选等操作,并展示了通过 SQL 查询进行复杂数据加载的方法。

本文介绍如何使用 Sqoop 工具从 MySQL 导入数据到 HDFS,包括连接配置、指定表及列、条件筛选等操作,并展示了通过 SQL 查询进行复杂数据加载的方法。

1361

1361

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?