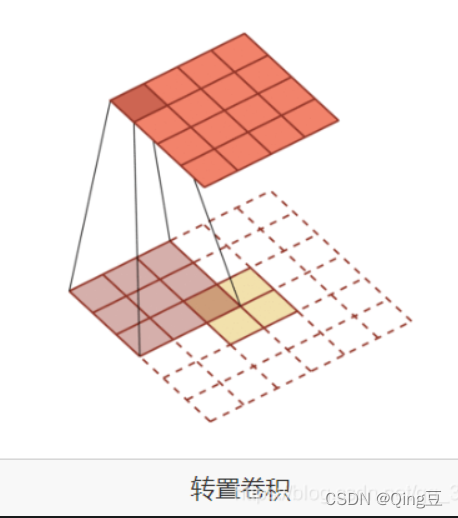

1.转置卷积:

转置卷积为卷积的逆操作,即通过转置卷积后实现图像的上采样

Z = W·X

X = W.T·Z

4*4的图片经过kernal_size=3,stride=1,padding=0的卷积操作得到2*2的特征

2*2的特征想要经过kernal_size=3的反卷积得到4*4的图片需要(kernal_size-1)的padding后进行卷积操作

2.微步卷积

微步卷积是转置卷积的特殊情况,即stride>1的卷积操作后,其转置卷积的trans_stride=1/stride

如图5*5的图片经过kernal_size=3,stride=2,padding=0的卷积操作后得到的1特征为2*2

反卷积时,特征值间插值(stride-1),做(kernal_size-1)padding,得到7*7图像,然后通过kernal_size=3,stride=1进行卷积得到5*5特征

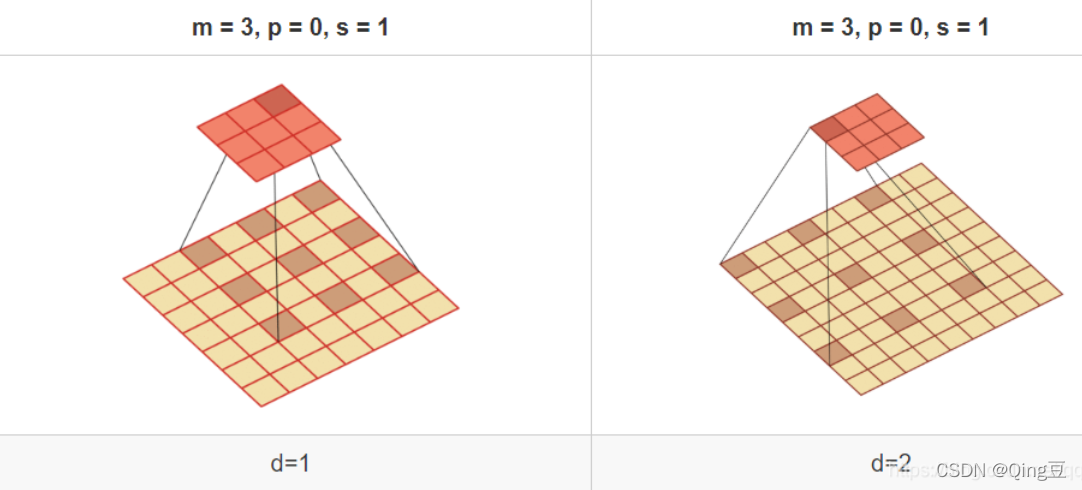

3. 空洞卷积

3.1 意义:增加输出特征的感受野

3.2 感受野:卷积神经网络每一层输出的特征图(feature map)上的像素点在输入图片上映射的区域大小。再通俗点的解释是,特征图上的一个点对应输入图上的区域

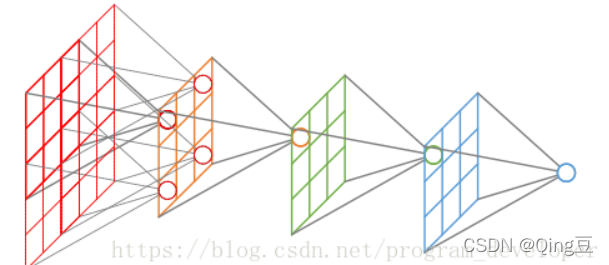

3.3 可以增加感受野的方式:

3.3.1增加卷积核大小:对于每个特征像素输出卷的像素多

3.3.2增加层数:卷的次数多,对应最后特征像素映射的图片像素也多

3.3.3增加pooling层:压缩像素,相当于感受野增大

方法1和方法2会增加参数信息,即需要学习的参数增多,方法三会丢失信息

3.4 空洞卷积

如果卷积核每两个元素之间插入d-1个空洞,那么卷积核的有效大小为:M = m + (m-1)*(d-1)

本文详细介绍了深度学习中三种重要的卷积操作:转置卷积用于图像上采样,微步卷积是特殊情况,适用于快速增大输出尺寸;空洞卷积则通过增加感受野来提升特征提取能力,避免参数过多和信息丢失。理解这些概念对于优化卷积神经网络模型至关重要。

本文详细介绍了深度学习中三种重要的卷积操作:转置卷积用于图像上采样,微步卷积是特殊情况,适用于快速增大输出尺寸;空洞卷积则通过增加感受野来提升特征提取能力,避免参数过多和信息丢失。理解这些概念对于优化卷积神经网络模型至关重要。

1381

1381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?