目录:

- 操作流程:

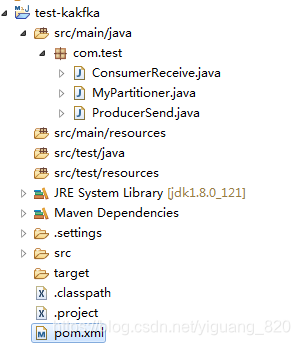

- 创建一个maven项目,项目结构目录

- 生产者代码(往主题test-1,key为139开头的号码(此号码属于移动)生产消息,并在参数配置中使用自定义分区)

消费者代码(消费主题test-1的消息)

自定义分区类(作用:根据手机号码类型分区:联通号的消息放到分区0,移动号的消息放到分区1,电信号的消息放到分区2) - 开启zookeeper和kafka

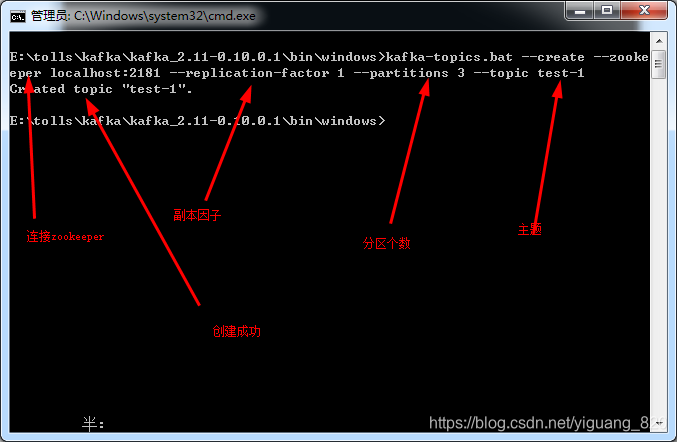

- 使用kafka创建主题test-1,并分区个数为3

- 测试

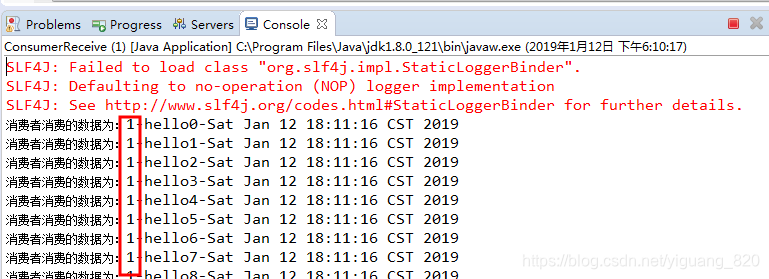

- 运行消费者代码

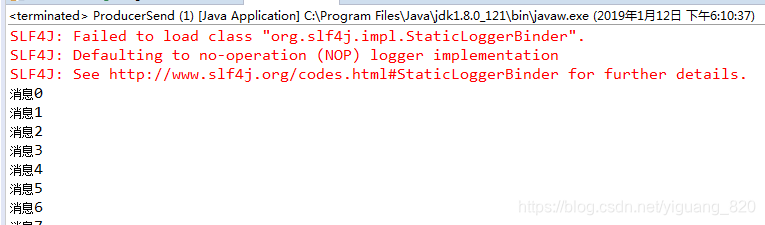

- 运行生产者代码

- 结果:符合期望

1.创建一个maven项目,项目结构目录

2.具体代码

2.1 pom.xml:先添加依赖:

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.yiguang.kafka2</groupId>

<artifactId>test-kakfka</artifactId>

<version>0.0.1-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>0.10.0.0</version>

</dependency>

</dependencies>

</project>

2.2 生产者代码:

package com.test;

import java.util.Properties;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

public class ProducerSend {

public static void main(String args[]) {

//1.属性配置:端口、缓冲内存、最大连接数、key序列化、value序列化等等

Properties props=new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("partitioner.class", "com.test.MyPartitioner");//使用自定义分区

//2.创建生产者对象,并建立连接,通过我们自己创建的 PropertiesUtil 工具类获得配置文件(根据传入的值,获得相对应的properties文件)

Producer<String, String> producer = new KafkaProducer<>(props);

//3.在my-topic主题下,发送消息

for(int i = 0; i < 100; i++) {

//1.可根据主题和内容发送,当没有key的时候,生产者生产的数据会放在该主题的所有分区,并均衡分布。

//2.可根据主题、key和内容发送,当有key的时候,key相同,数据会放在同一个分区中。

//3.可根据主题、分区、key和内容发送

//4.可根据主题、分区、时间戳、key和内容发送

//第2种方式:根据主题、key和内容发送

producer.send(new ProducerRecord<String, String>("test-1", "13973041937", "hello"+i));

System.out.println("消息"+i);

}

//4.关闭

producer.close();

}

}

2.3 消费者代码:

package com.test;

import java.util.Arrays;

import java.util.Date;

import java.util.Properties;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.common.TopicPartition;

public class ConsumerReceive {

public static void main(String args[]) {

//1.参数配置:不是每一非得配置

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("auto.commit.interval.ms", "1000");

props.put("group.id", "test");//因为每一个消费者必须属于某一个消费者组,所以必须还设置group.id

props.put("enable.auto.commit", "true");

props.put("session.timeout.ms", "30000");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

//2.创建消费者对象,并建立连接

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

//3.设置从"test-1"主题下拿取数据

consumer.subscribe(Arrays.asList("test-1"));

//3.设置从"test-1"主题的0号分区拿数据

//TopicPartition tp01=new TopicPartition("test-1", 1);

//consumer.assign(Arrays.asList(tp01));

//4.消费数据

while (true) {

//阻塞时间,从kafka中取出100毫秒的数据,有可能一次性去除0-n条

ConsumerRecords<String, String> records = consumer.poll(100);

//遍历

for (ConsumerRecord<String, String> record : records)

//打印结果

//System.out.printf("offset = %d, key = %s, value = %s", record.offset(), record.key(), record.value());

System.out.println("消费者消费的数据为:"+record.value()+"-"+new Date());

//手动提交

consumer.commitAsync();

}

}

}

2.4 自定义分区代码

package com.test;

import java.util.Map;

import org.apache.kafka.clients.producer.Partitioner;

import org.apache.kafka.common.Cluster;

public class MyPartitioner implements Partitioner{

public int partition(String topic, Object key, byte[] bytes, Object value, byte[] bytes1, Cluster cluster) {

//拿到主题下的分区个数

//如果分区数不为3,那么可以进入到0号分区

Integer count=cluster.partitionCountForTopic(topic);

String keyString=key.toString();

if(count==3&&keyString!=null) {

if(keyString.startsWith("156")) {//以156开头的手机号属于联通运营商,放入分区0

return 0;

}else if(keyString.startsWith("139")) {//以139开头的手机号属于移动运营商,放入分区1

return 1;

}else if(keyString.startsWith("133")){//以133开头的手机号属于电信运营商,放入分区2

return 2;

}

}

return 0;

}

public void close() {

}

public void configure(Map<String, ?> map) {

}

}

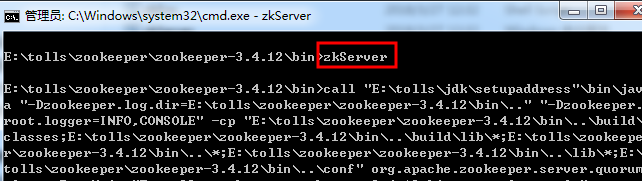

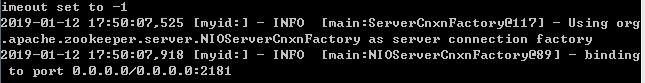

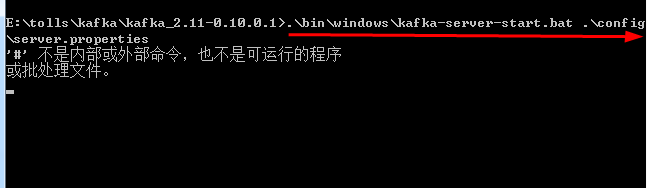

3.开启zookeeper和kafka

开启zookeerper

开启kafka

4.使用kafka创建主题test-1,并分区个数为3

5.测试

- 运行消费者代码

- 运行生产者代码

- 可以在消费者控制看到在生产者在主题test-1,key为13973041937(此号码属于移动)的消息,都放在分区1下了,测试成功

本文详细介绍了一个基于Maven项目的Kafka消息传递系统实例,包括生产者和消费者代码的编写,自定义分区器的实现,以及如何根据手机号运营商将消息分配到不同分区。通过具体步骤和代码示例,展示了如何在Kafka中进行高级分区策略的配置。

本文详细介绍了一个基于Maven项目的Kafka消息传递系统实例,包括生产者和消费者代码的编写,自定义分区器的实现,以及如何根据手机号运营商将消息分配到不同分区。通过具体步骤和代码示例,展示了如何在Kafka中进行高级分区策略的配置。

590

590

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?