Hadoop------Hive安装&部署

安装包 :apache-hive-1.2.1-bin.tar.gz

一 Hive安装地址

1.Hive官网地址

http://hive.apache.org/

2.文档查看地址

https://cwiki.apache.org/confluence/display/Hive/GettingStarted

3.下载地址

http://archive.apache.org/dist/hive/

4.github地址

https://github.com/apache/hive

二 Hive安装部署

1.Hive安装及配置

(1)把apache-hive-1.2.1-bin.tar.gz上传到linux的/opt/software目录下

(2)解压apache-hive-1.2.1-bin.tar.gz到/opt/module/目录下面

[@hadoop102 software]$ tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /opt/module/

(3)修改apache-hive-1.2.1-bin.tar.gz的名称为hive

[@hadoop102 module]$ mv apache-hive-1.2.1-bin/ hive

(4)修改/opt/module/hive/conf目录下的hive-env.sh.template名称为hive-env.sh

[@hadoop102 conf]$ mv hive-env.sh.template hive-env.sh

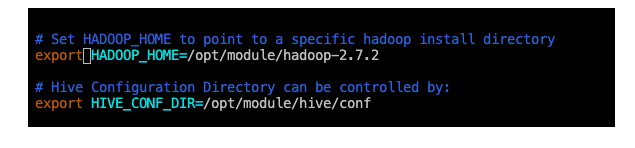

(5)配置hive-env.sh文件

(a)配置HADOOP_HOME路径

export HADOOP_HOME=/opt/module/hadoop-2.7.2

(b)配置HIVE_CONF_DIR路径

export HIVE_CONF_DIR=/opt/module/hive/conf

Hadoop集群配置

(1)必须启动hdfs和yarn

[root@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh

[root@hadoop103 hadoop-2.7.2]$ sbin/start-yarn.sh

(2)在HDFS上创建/tmp和/user/hive/warehouse两个目录并修改他们的同组权限可写

[root@hadoop102 hadoop-2.7.2]$ bin/hadoop fs -mkdir /tmp

[root@hadoop102 hadoop-2.7.2]$ bin/hadoop fs -mkdir -p /user/hive/warehouse

[root@hadoop102 hadoop-2.7.2]$ bin/hadoop fs -chmod g+w /tmp

[root@hadoop102 hadoop-2.7.2]$ bin/hadoop fs -chmod g+w /user/hive/warehouse

三 Hive基本操作

(1)启动hive

[root@hadoop102 hive]$ bin/hive

(2)查看数据库

hive> show databases;

(3)打开默认数据库

hive> use default;

(4)显示default数据库中的表

hive> show tables;

(5)创建一张表

hive> create table student(id int, name string);

(6)显示数据库中有几张表

hive> show tables;

(7)查看表的结构

hive> desc student;

(8)向表中插入数据

hive> insert into student values(1000,“ss”);

(9)查询表中数据

hive> select * from student;

(10)退出hive

hive> quit;

说明:(查看hive在hdfs中的结构)

数据库:在hdfs中表现为${hive.metastore.warehouse.dir}目录下一个文件夹

表:在hdfs中表现所属db目录下一个文件夹,文件夹中存放该表中的具体数据

四 将本地文件导入Hive案例

需求

将本地/opt/module/datas/student.txt这个目录下的数据导入到hive的student(id int, name string)表中。

1.数据准备

在/opt/module/datas这个目录下准备数据

(1)创建datas

[root@hadoop102 module]$ mkdir datas

(2)本地文件交互到hive

在/opt/module/datas/目录下创建student.txt文件并添加数据

本文详细介绍了Hadoop-Hive的安装、部署过程,包括Hive的环境配置,HDFS上的目录创建,以及Hive的基本操作,如启动、查看数据库、创建表、插入数据等。同时,通过案例展示了如何将本地文件导入Hive,并解决在操作过程中可能遇到的问题。

本文详细介绍了Hadoop-Hive的安装、部署过程,包括Hive的环境配置,HDFS上的目录创建,以及Hive的基本操作,如启动、查看数据库、创建表、插入数据等。同时,通过案例展示了如何将本地文件导入Hive,并解决在操作过程中可能遇到的问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

686

686

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?