引言

随着社交媒体的快速发展,微博等平台成为了信息传播的重要渠道。然而,虚假信息和谣言的传播也带来了严重的社会问题。为了应对这一挑战,自动化的谣言检测技术变得尤为重要。本文将介绍如何基于文本特征,结合深度学习模型(如LSTM、CNN)和传统机器学习模型(如SVM)来实现微博谣言检测,并对这些模型的性能进行对比分析。

1. 项目概述

本项目的核心目标是通过分析微博文本内容,自动检测其中的谣言。我们采用预训练的词向量(如sgns.weibo.bigram)进行文本表示,并使用交叉熵损失函数进行模型训练。项目的主要模块包括:

-

数据预处理:使用jieba和pkuseg进行分词,去除停用词,并将文本转换为词向量表示。

-

模型定义:实现了LSTM、CNN和SVM三种模型,分别用于谣言检测。

-

训练与测试:支持早停机制和模型保存,优化训练过程。

-

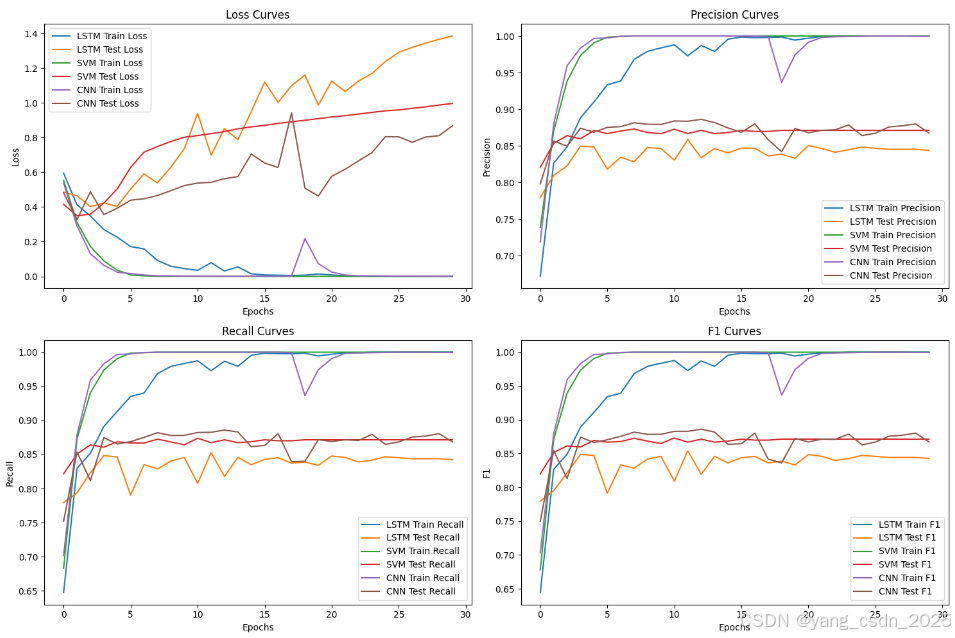

性能评估:通过准确率、精确率、召回率和F1分数对模型性能进行评估。

2. 数据预处理

数据预处理是谣言检测任务中的关键步骤。我们使用jieba和pkuseg对微博文本进行分词,并去除停用词。分词后的文本通过预训练的词向量转换为词向量表示,作为模型的输入。

def jieba_cut(contents):

contents_S = []

for line in contents:

current_segment = jieba.lcut(line)

contents_S.append(current_segment)

return contents_Sdef pkuseg_cut(contents, model_name="web"):

seg = pkuseg.pkuseg(model_name='web')

contents_S = []

for line in contents:

line = re.sub("[\s+\.\!\/_,$%^*(+\"\']+|[+——!,。?、~@#¥%……&*()]+", "", line)

current_segment = jieba.lcut(line)

contents_S.append(current_segment)

return contents_S

3. 模型定义

我们实现了三种谣言检测模型:LSTM、CNN和SVM。每种模型都有其独特的优势和适用场景。

3.1 LSTM模型

LSTM(长短期记忆网络)是一种经典的序列模型,能够捕捉文本中的长距离依赖关系。它特别适合处理微博中的长文本谣言。

class LSTM_Model(nn.Module):

def __init__(self):

super(LSTM_Model, self).__init__()

self.embedding = nn.Embedding.from_pretrained(utils.embedding, freeze=True)

self.lstm = nn.LSTM(input_size=config.embedding_dim,

hidden_size=config.lstm_hidden_size,

num_layers=config.lstm_num_layers,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1351

1351

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?