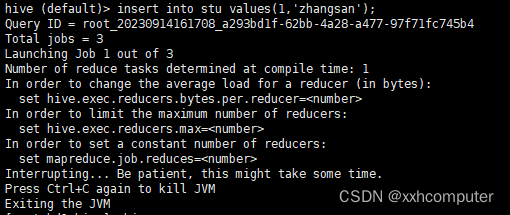

Query ID = root_20230914161708_a293bd1f-62bb-4a28-a477-97f71fc745b4

Total jobs = 3

Launching Job 1 out of 3

Number of reduce tasks determined at compile time: 1

In order to change the average load for a reducer (in bytes):

set hive.exec.reducers.bytes.per.reducer=<number>

In order to limit the maximum number of reducers:

set hive.exec.reducers.max=<number>

In order to set a constant number of reducers:

set mapreduce.job.reduces=<number>

Interrupting... Be patient, this might take some time.

当执行一条插入语句时,一直卡着,卡在这一步,没有任何反应只能自己手动杀死,并且查看hdfs也没有数据插入成功。找了很多都没有得到解决。

尝试过的解决方案有:

1 重启hadoop和yarn

2 查看是否是端口被占用netstat –anp | grep 8033

3 检查环境变量是否配置错误

4 查看hive和yarn的日志

这些方法都没有解决,可以参考一下

最后解决的方法是

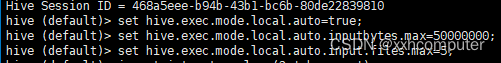

进入到hive后执行这3条指令

hive (default)> set hive.exec.mode.local.auto=true;

hive (default)> set hive.exec.mode.local.auto.inputbytes.max=50000000;

hive (default)> set hive.exec.mode.local.auto.input.files.max=5;

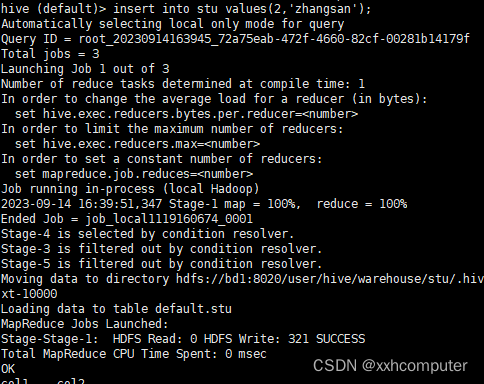

执行完再执行插入语句

完成插入,跑完MapReduce

博客讲述执行Hive插入语句时卡顿,手动杀死且HDFS无数据插入成功的问题。尝试重启Hadoop和Yarn、检查端口占用、环境变量配置及查看日志等方法均未解决,最终通过在Hive中执行三条指令解决问题,完成插入和MapReduce。

博客讲述执行Hive插入语句时卡顿,手动杀死且HDFS无数据插入成功的问题。尝试重启Hadoop和Yarn、检查端口占用、环境变量配置及查看日志等方法均未解决,最终通过在Hive中执行三条指令解决问题,完成插入和MapReduce。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?