XGBoost中的学习率(Learning Rate)是控制模型更新步长的核心超参数,其本质是通过调节每棵决策树对最终预测结果的贡献程度,平衡模型的学习速度与泛化能力。

训练的“步长”通常指的是学习率(learning_rate),也称为eta。学习率是一个关键参数,用于控制每次迭代的步长,即模型在每一轮训练中更新权重的幅度。它直接影响模型的收敛速度和性能。

控制更新幅度:学习率决定了每棵树对最终预测结果的影响程度。较大的学习率会导致模型更新较快,但可能容易过拟合;较小的学习率会使模型更新更保守,通常需要更多的迭代次数,但可以提高模型的泛化能力。

防止过拟合:通过缩小步长,学习率可以减少模型对单棵树的依赖,从而降低过拟合的风险。

平衡收敛速度与性能:过大的学习率可能导致模型在训练过程中发散,错过最优解;而过小的学习率可能使模型收敛过慢

以下从定义、作用机制、调参策略和实际影响四个维度详细解析:

一、定义与数学本质

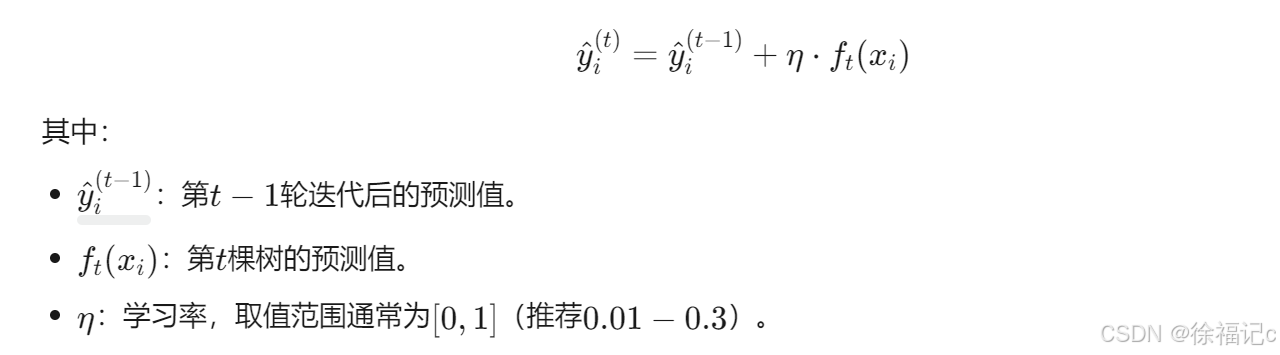

学习率(通常用eta或learning_rate表示)是梯度提升框架中的步长缩放因子,其数学定义为:

作用:学习率决定了每棵新树对模型更新的贡献比例。较小的学习率需要更多迭代次数,但能更精细地调整模型;较大的学习率加速收敛,但可能跳过最优解。

二、作用机制与影响

1. 梯度下降的步长控制

XGBoost采用梯度提升(Gradient Boosting)框架,通过迭代优化损失函数。学习率相当于梯度下降中的步长:

- 步长过大:可能跳过最优解,导致震荡或不收敛(如学习率=1时,模型可能无法收敛)。

- 步长过小:收敛速度慢,需更多迭代次数(如学习率=0.01时,需数千次迭代)。

2. 正则化协同

学习率与正则化参数(如lambda、alpha)共同控制模型复杂度:

- 低学习率+高正则化:模型更保守,适合高噪声数据。

- 高学习率+低正则化:模型更激进,适合简单数据分布。

3. 与树深度的交互

- 深树(max_depth大):单棵树拟合能力强,需更低学习率防止过拟合。

- 浅树(max_depth小):单棵树能力弱,可适当提高学习率。

三、调参策略与实践建议

1. 初始值选择

- 默认值:通常从

0.1开始(XGBoost官方推荐)。 - 快速验证:若训练时间允许,可尝试

0.05和0.2对比效果。

2. 学习率衰减

- 动态调整:随着迭代次数增加,逐步降低学习率(如

eta=0.3 → 0.1),提升收敛稳定性。 - 实现方式:通过

callbacks或自定义学习率调度器。

3. 与其他参数的联动

| 参数 | 联动关系 |

|---|---|

| n_estimators | 学习率越小,需更多树(迭代次数)补偿模型贡献。 |

| max_depth | 树越深,需更低学习率防止过拟合。 |

| subsample | 行采样比例低时,可适当提高学习率以增强模型响应。 |

4. 早停机制(Early Stopping)

- 作用:当验证集损失连续

early_stopping_rounds轮未改善时停止训练,避免过拟合。 - 配合学习率:早停可减少对学习率过高的依赖,自动选择最优迭代次数。

四、实际影响案例分析

案例1:二分类任务(信用卡欺诈检测)

- 场景:数据不平衡,欺诈样本仅占0.1%。

- 参数设置:

- 学习率

0.1+ 树深度3+ 迭代次数1000→ AUC=0.89。 - 学习率

0.05+ 树深度5+ 迭代次数2000→ AUC=0.91(更优)。

- 学习率

- 结论:降低学习率并增加树深度,通过更精细的调整提升模型性能。

案例2:回归任务(房价预测)

- 场景:特征非线性强,数据量较小(n=1000)。

- 参数设置:

- 学习率

0.3+ 树深度6→ 均方误差(MSE)=1200。 - 学习率

0.1+ 树深度4+ 早停(100轮) → MSE=1150(更优)。

- 学习率

- 结论:适当降低学习率并限制树深度,结合早停防止过拟合。

五、总结

- 核心作用:学习率是梯度提升步长的调节器,直接影响模型收敛速度和稳定性。

- 调参原则:

- 小步长+多迭代:适合复杂数据,但需权衡计算成本。

- 大步长+早停:适合简单数据或快速原型开发。

- 进阶技巧:

- 结合网格搜索(Grid Search)或贝叶斯优化(Bayesian Optimization)系统调参。

- 使用学习率衰减策略(如余弦退火)进一步提升收敛效果。

通过合理设置学习率,可在模型性能与训练效率之间找到最佳平衡点。

1309

1309

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?