目录

一、卷积神经网络:AI 的 “视觉大脑”

在当今的人工智能时代,你是否想过,当你使用手机的人脸识别解锁功能时,手机是如何瞬间识别出你的脸的?当你在搜索引擎中上传一张图片,它又是怎样迅速找到相似图片的?其实,这些神奇的功能背后,都离不开一个强大的技术 —— 卷积神经网络(Convolutional Neural Network,简称 CNN)。它就像是 AI 的 “视觉大脑”,赋予了机器感知和理解图像世界的能力,在人工智能领域中占据着举足轻重的地位。

二、什么是卷积神经网络

(一)定义与概念

卷积神经网络(Convolutional Neural Network,CNN)是一类包含卷积计算且具有深度结构的前馈神经网络 ,是深度学习的代表算法之一。它通过卷积层中的卷积核在输入数据上滑动,进行卷积操作,从而提取数据中的特征。这种独特的结构和运算方式,使得 CNN 能够自动学习数据中的特征,大大减少了人工特征工程的工作量。它就像是一个智能的图像翻译器,将原始的图像数据翻译成机器能够理解的特征语言。

(二)起源与发展历程

卷积神经网络的起源可以追溯到 20 世纪 80 年代。1987 年,Alexander Waibel 等提出了时间延迟网络(Time Delay Neural Network, TDNN),这是第一个卷积神经网络,它被应用于语音识别问题,使用 FFT 预处理的语音信号作为输入,其隐含层由 2 个一维卷积核组成,以提取频率域上的平移不变特征 。1989 年,Yann LeCun 构建了应用于图像分类的卷积神经网络 ——LeNet 的最初版本,它包含两个卷积层,2 个全连接层,共计 6 万个学习参数,规模远超 TDNN,且在结构上与现代的卷积神经网络十分接近 。1998 年,Yann LeCun 及其合作者构建了更加完备的卷积神经网络 LeNet - 5,并在手写数字的识别问题中取得成功,LeNet - 5 沿用了之前的学习策略并加入了池化层对输入特征进行筛选,它的成功使卷积神经网络的应用得到关注 。

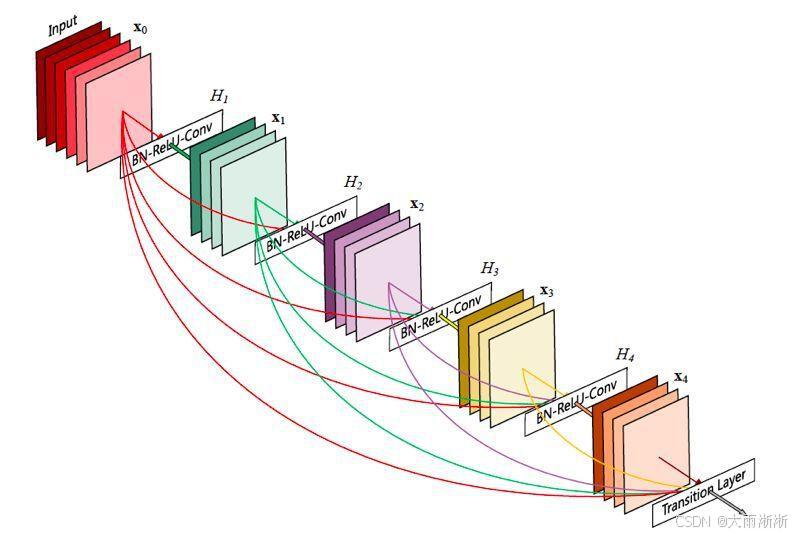

在随后的发展中,卷积神经网络不断演进。2012 年,AlexNet 在 ImageNet 比赛中大放异彩,它使用了深层网络并采用 ReLU 激活函数,显著提高了图像分类性能,其 Top - 5 错误率比前一年的冠军一下子下降了 10 个百分点,远远超过当年的第二名 。AlexNet 的成功,点燃了深度学习的热情,使得卷积神经网络在学术界和工业界都得到了广泛的研究和应用。此后,VGGNet 采用了更深的网络架构,使用 3x3 的卷积核和 2x2 的池化层;ResNet 提出了残差连接,解决了深层网络中的梯度消失问题,使得网络可以非常深;InceptionNet 通过使用不同大小的卷积核来提取多尺度特征,进一步提升了网络性能 。这些经典模型的出现,不断推动着卷积神经网络技术的发展和进步,使其在计算机视觉、自然语言处理等多个领域都取得了卓越的成果。

三、卷积神经网络的结构与原理

(一)基本结构剖析

卷积神经网络就像一个复杂而精密的工厂,由多个不同功能的 “车间” 组成,每个 “车间” 都在图像识别的过程中发挥着关键作用。这些 “车间” 主要包括输入层、卷积层、池化层和全连接层 。

输入层是这个工厂的原材料入口,它负责接收原始的图像数据。以一张彩色图像为例,它通常以三维数组的形式进入输入层,数组的三个维度分别代表图像的高度、宽度和颜色通道(如 RGB 三个通道) 。可以把输入层想象成一个装满各种图像原材料的仓库,等待着后续工序的加工。

卷积层是工厂的核心加工车间,它通过卷积核在输入数据上滑动,进行卷积操作,提取图像的特征 。卷积核就像是一个具有特定图案的印章,在图像上不断盖章,每一次盖章都能提取出图像局部区域的特征,比如边缘、纹理等 。不同的卷积核可以提取不同的特征,多个卷积核一起工作,就能全面地提取图像的各种特征 。例如,一个 3x3 的卷积核在图像上滑动,每次与图像上 3x3 大小的区域进行计算,就可以得到一个新的特征值,众多这样的特征值就构成了特征图 。

池化层则像是一个筛选车间,它对卷积层输出的特征图进行降采样,减少特征图的维度,降低计算复杂度 。常用的池化操作有最大池化和平均池化 。最大池化就像是在一堆水果中挑选出最大最甜的那个,它在每个局部区域内选择最大值作为输出;平均池化则像是计算这堆水果的平均甜度,它计算局部区域内元素的平均值作为输出 。通过池化操作,既能保留图像的关键特征,又能减少数据量,提高处理效率 。

全连接层是工厂的最终组装车间,它将前面卷积层和池化层提取到的特征进行整合,形成最终的输出结果 。全连接层中的每个神经元都与前一层的所有神经元相连,就像把所有的零件都紧密地组装在一起 。在图像分类任务中,全连接层的输出会通过 Softmax 函数进行归一化,得到每个类别的概率,从而判断图像属于哪个类别 。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?