难说| 读了几本书

前言

好久没在这个号上发表文章了,今天听群友说微信开放了私信功能,赶紧来试试。欢迎私信。

读了几本书

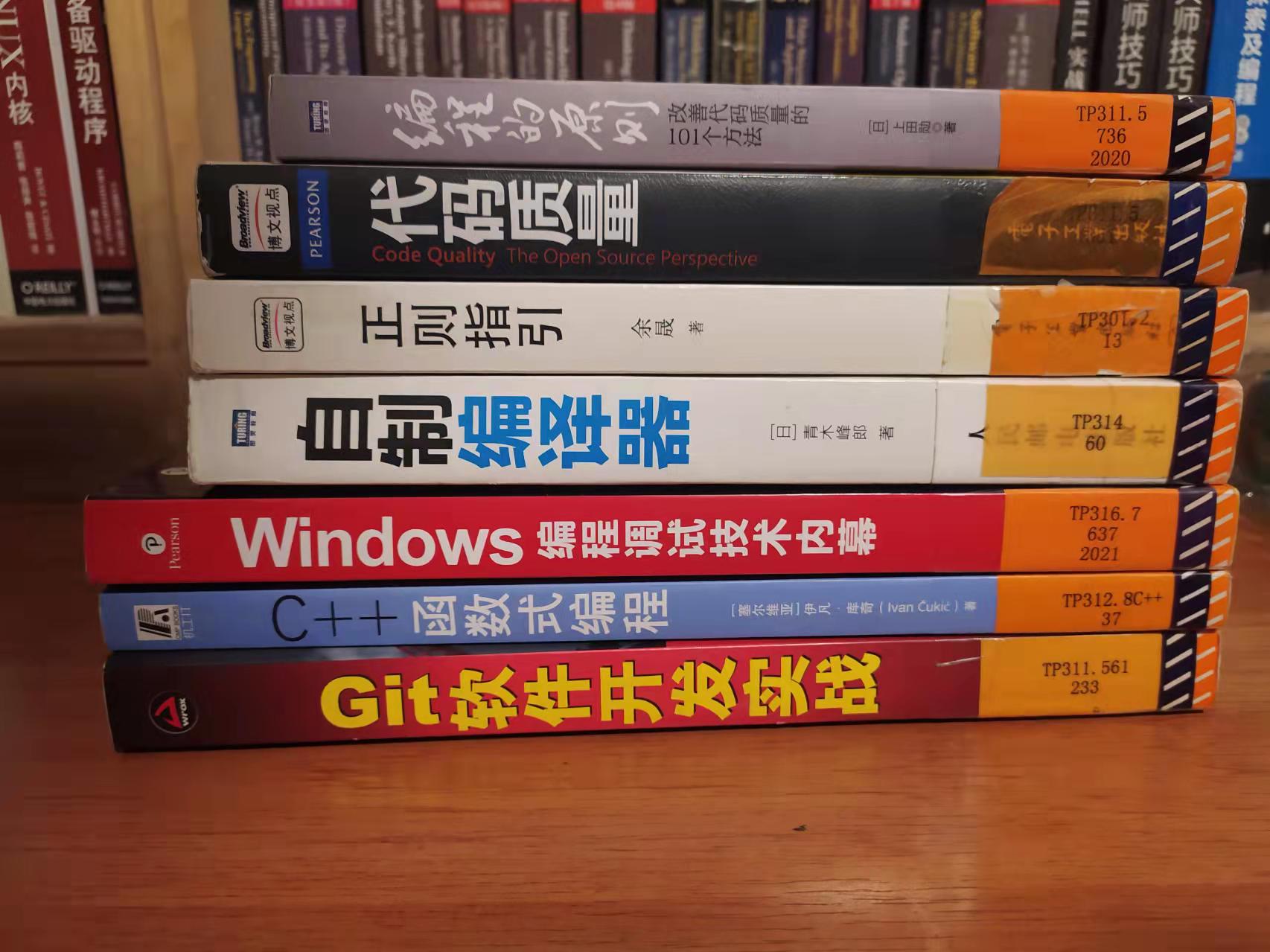

这个五一加了 4 天班,真是累啊,希望后面不要再卷了。最后一天陪娃去天津图书馆,又借了几本感兴趣的书,囫囵吞枣的看了好几本。简单聊聊感受。

-

《Windows 编程调试技术内幕》

在图书馆遇到这本书,想都没想,立刻拿到手里了。这本书我翻的比较块,应该会错过一些知识点。书里面的大部分的内容我已经有过了解了,就没细读。即使粗读,依然学到了几点。

- 通过设置注册表

Image File Excution Option下的BreakOnDllLoad, 可以在vs中做到加载指定dll的时候中断下来(在windbg就比较简单了,sxe ld:your_module_pattern搞定)。 - 创建进程的时候,内核会调用

nt!PspInsertProcess,又学到了一个中断的时机。 - 一个命令行程序总会有与之对应的

conhost.exe进程。这个进程会负责消息处理相关事宜。对,一个命令行程序也有消息需要处理,我之前以为控制台程序不会处理消息呢。 - 控制台程序是如何响应

ctrl + c的。 - ……

总体来说,这本书还是非常值得一读的,有机会一定买一本纸质版支持原作者。

当然,谈到调试,一定要提张银奎老师的《软件调试》(第二版已经出了两卷了),《格蠹汇编》。还有《windows 高级调试》(

Mario Hewardt和Daniel Pravat著,聂雪军 等译),《.net 高级调试》(Mario Hewardt著,聂雪军 等译) 。当然,还有熊力大佬的《Windows 用户态程序高效排错》,只可惜我知道这本书的时候,已经绝版了,如果有纸质版一定买一本支持作者。 - 通过设置注册表

-

《Git 软件开发实战》

之所以借这本是因为这是一本讲

git的书。这本书很快就翻完了,一是因为自己对git有了一定的了解,二是因为之前买了一本《精通 Git》(有开源的中文电子版,链接在这里)。这本《Git 软件开发实战》没有特别惊艳到我的地方。当然,没太细看,很可能错过了一些精彩的地方。相比而言,我更喜欢《精通 Git》。 -

《C++ 函数式编程》

这本书的名字吸引了我。相信大家一定知道

c++是面向对象的编程语言。使用c++进行函数式编程?有点意思。不过这本书我很快就翻完了,没太理解这本书的精髓。也许是我功力还不够,还得继续修炼。 -

《编程的原则》

借这本与借另外一本——《代码质量》的出发点是一样的,想看看有没有什么好的原则提高代码质量。这本书里的观点好是好,就是少了些代码的佐证,不太符合我的预期,所以没有精读。相对而言,《代码大全》更符合我的胃口。

-

《代码质量》

这本应该是一本好书,但是现在没心思细读,留到后面慢慢读吧。

-

《正则指引》

这本书是余晟大佬写的,之前买过他翻译的正则表达式的经典之作《精通正则表达式》。这次有幸在图书馆遇到这本书,必须借回来读一读。我本身了解简单的正则语法,可以写简单的正则表达式,但是稍微复杂一些的就得查资料了,之前在用正则的时候遇到了一个因为使用不当导致的运行缓慢的问题,还特意写了几篇水文记录。感兴趣的朋友可以看这里。

-

《自制编译器》

看名字就想读的一本书。希望能通过这本书对编译原理有更深层次的理解吧。接下来的重中之重!

-

《数学之美》

吴军大佬写的,非常非常值得一读。很早就买了,一直在书架上吃灰。偶然的机会翻出来读了读,越读越喜欢,能遇到这么好的书,真是三生有幸。对《浪潮之巅》也有了更高的期待,也得慢慢安排上了。

最后

请原谅我的懒惰吧

你对这几本书有什么看法吗?有什么好书推荐吗?欢迎私信我呀。

作者分享了五一期间的阅读经历,重点评述了《Windows编程调试技术内幕》、《软件调试》、《Git软件开发实战》等技术书籍,提及了学习到的调试技巧和推荐的其他相关书籍。

作者分享了五一期间的阅读经历,重点评述了《Windows编程调试技术内幕》、《软件调试》、《Git软件开发实战》等技术书籍,提及了学习到的调试技巧和推荐的其他相关书籍。

309

309

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?