1.简介

HuggingFace 是一个专注于自然语言处理(NLP)和机器学习领域的开源平台和社区,旨在为开发者和研究人员提供高效的工具和资源来构建、训练和部署人工智能模型。目前主流的两个开源大模型平台分别是HuggingFace、ModelScope。

HuggingFace:类似于github,模型比较全,但是需要科学上网;

ModelScope:阿里开源的大模型平台,模型不是很全,速度比较快;

HuggingFace的优点:

●丰富的预训练模型资源:

广泛的适用性:Hugging Face提供了大量的预训练模型,这些模型已经在海量的数据上进行了训练,能够处理各种自然语言处理任务,如文本分类、情感分析、问答、机器翻译等。无论您是从事学术研究、商业应用还是个人项目开发,都可以找到适合的预训练模型,节省大量从头训练模型的时间和资源。

高质量与不断更新:其预训练模型经过了专业的训练和优化,具有较高的性能和准确性。而且,Hugging Face平台不断更新和改进模型,以适应不断变化的自然语言处理需求和技术发展。

●方便的工具和库:

Transformers库:Hugging Face的Transformers库是自然语言处理领域的重要工具,它支持多种预训练模型的加载、使用和微调,如BERT、GPT、RoBERTa等。该库提供了简单易用的接口,使得开发者可以轻松地将这些强大的模型集成到自己的项目中,快速实现自然语言处理功能。

数据集管理工具:Hugging Face提供了方便的数据集管理工具,如Datasets库,可以帮助用户轻松地下载、处理和管理各种公开的数据集。这使得数据的准备工作变得更加高效,减少了数据处理过程中的繁琐操作。

2.模型下载

●在conda上创建虚拟环境

# 创建huggingface_env虚拟环境

conda create -n huggingface_env python=3.11

# 然后激活虚拟环境

conda activate huggingface_env

●安装huggingface_hub工具

# 安装huggingface_hub工具

pip install -U huggingface_hub

●配置huggingface镜像环境变量

配置huggingface镜像环境变量方式有永久跟临时两种:

◎可以查看环境变量

huggingface-cli env

◎临时配置

# 配置huggingface镜像环境变量

export HF_ENDPOINT=https://hf-mirror.com

export HF_HUB_DOWNLOAD_TIMEOUT=30

◎永久配置

# 编辑profile文件配置huggingface镜像环境变量

vi /etc/profile

# 配置huggingface镜像环境变量

export HF_ENDPOINT=https://hf-mirror.com

export HF_HUB_DOWNLOAD_TIMEOUT=30

# 刷新profile文件使huggingface镜像环境变量生效

source /etc/profile

# 查看huggingface镜像环境变量

echo $HF_ENDPOINT

●创建huggingface大模型目录

# 创建huggingface模型目录

mkdir -p /root/huggingface/models/deepseek-r1-distill-qwen-1.5b

●下载模型

# 模型下载

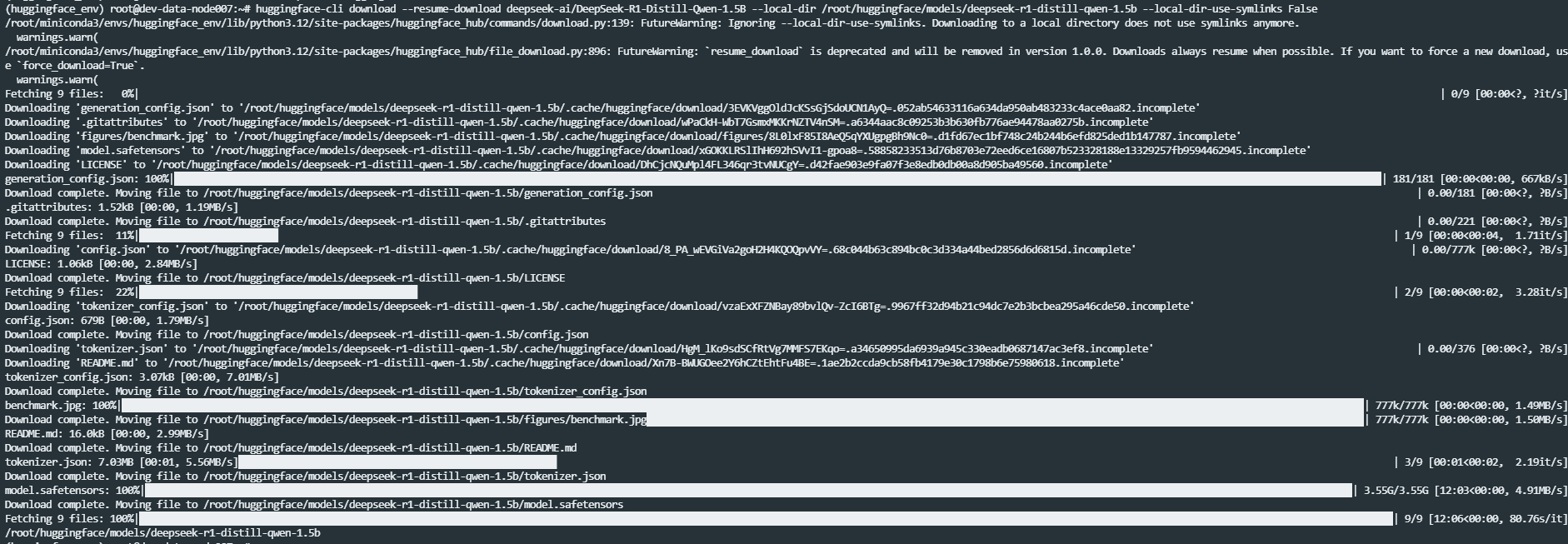

huggingface-cli download --resume-download deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B --local-dir /root/huggingface/models/deepseek-r1-distill-qwen-1.5b --local-dir-use-symlinks False

如图所示:

参考文献

HuggingFace:https://huggingface.co/

2070

2070

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?