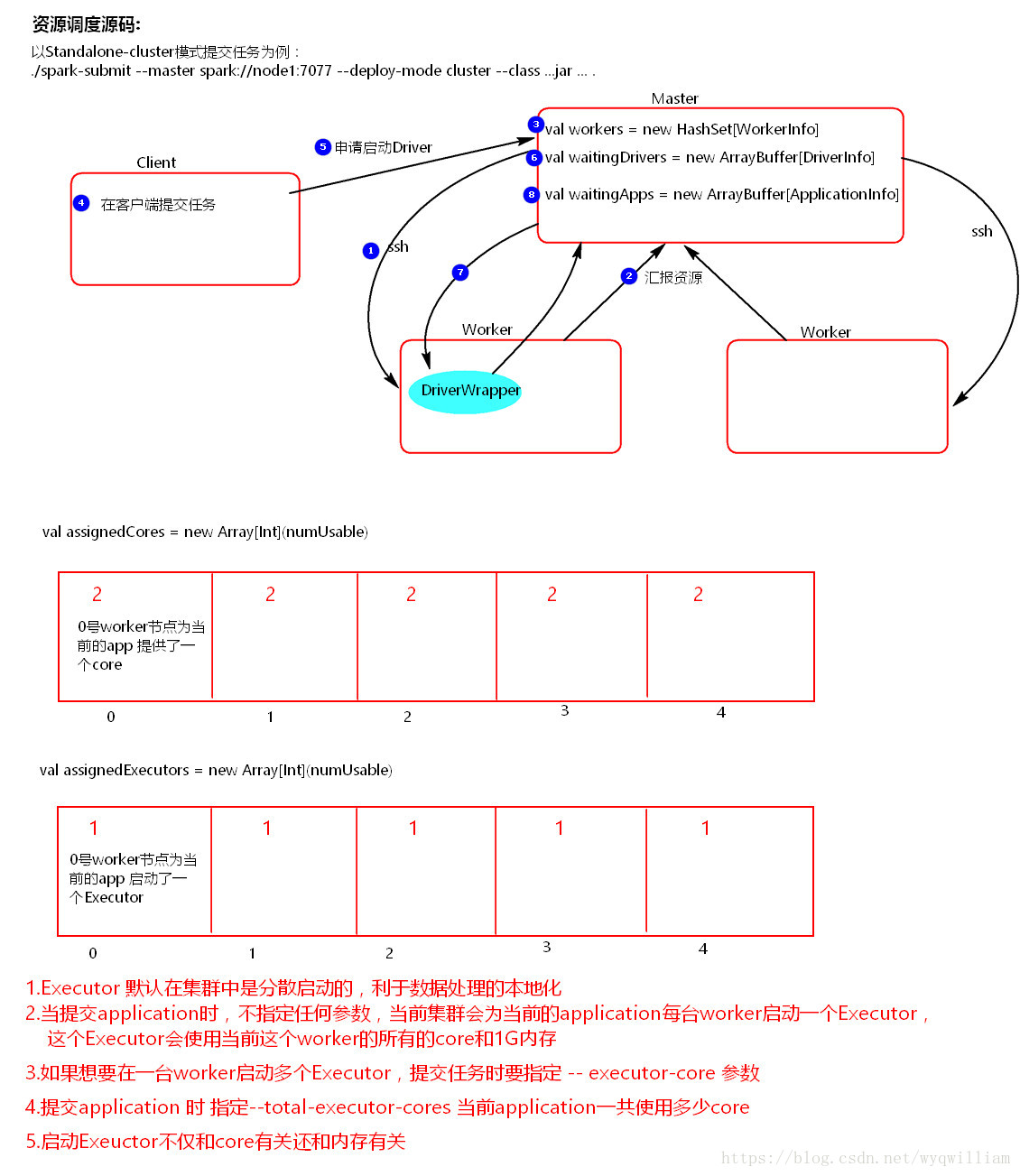

Spark资源调度:

1.启动集群,worker向master汇报资源,master掌握了集群资源

2.提交application时,会创建Driver,当new SparkContext时,会创建两个对象DAGScheduler和TaskScheduler

3.TaskScheduler向master申请资源

4.MAster找到满足资源的worker,启动executor

5.executor启动之后,反向注册给TaskScheduler

Spark的任务调度:

6.当代码中有action算子触发一个job,job中的RDD依赖关系形成一个DAG

7.DAG提交给DAGscheduler,DAGscheduler按照RDD之间的宽窄依赖关系切割job,划分stage,将stage封装到taskset提交到taskScheduler

8.taskscheduler收到taskset,遍历taskset拿到一个个的task,发送的到executor中的threadpool执行

9.Driver监控task执行,回收结果

总结:

1.Taskscheduler可以重试失败的task,重试3次,如果3次之后,依然没有task执行,那么就会由DAGscheduler重试task所在的stage,重试4次,如果还没有成功执行,那么stage所在的job就失败了,job失败,application就失败了。

2.taskScheduler还可以重试执行缓慢的task,就是spark的推测执行机制,默认是关闭的,对于ETL有入库行为的业务,要关闭推测机制

3.遇到数据一直执行不完,1)是否有数据倾斜;2)是否开启了推测执行机制

本文详细介绍了Apache Spark集群的资源调度流程,包括worker向master汇报资源、executor的启动及反向注册等过程。同时,深入探讨了Spark的任务调度机制,如DAGScheduler如何根据RDD依赖关系划分stage,TaskScheduler如何执行task及其重试机制。

本文详细介绍了Apache Spark集群的资源调度流程,包括worker向master汇报资源、executor的启动及反向注册等过程。同时,深入探讨了Spark的任务调度机制,如DAGScheduler如何根据RDD依赖关系划分stage,TaskScheduler如何执行task及其重试机制。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?