文章目录

书生·浦语大模型全链路开源体系-第4关

为了推动大模型在更多行业落地应用,让开发人员更高效地学习大模型的开发与应用,上海人工智能实验室重磅推出书生·浦语大模型实战营,为开发人员提供大模型学习和开发实践的平台。

本文是书生·浦语大模型全链路开源体系-开源开放体系课程的笔记。

相关资源

- InternLM项目地址

https://github.com/InternLM/InternLM

- InternLM2技术报告

https://arxiv.org/pdf/2403.17297.pdf

- 书生·万卷 数据

https://opendatalab.org.cn/

- 课程链接

https://space.bilibili.com/1293512903/channel/collectiondetail?sid=4017857

LlamaIndex+InternLM RAG 实践

本文将介绍如何使用 LlamaIndex + InternLM 构建 RAG 知识库。

前置知识

给模型注入新知识的方式,可以简单分为两种方式,一种是内部的,即更新模型的权重,另一个就是外部的方式,给模型注入格外的上下文或者说外部信息,不改变它的的权重。

第一种方式,改变了模型的权重即进行模型训练,这是一件代价比较大的事情,大语言模型具体的训练过程,可以参考InternLM2技术报告。

第二种方式,并不改变模型的权重,只是给模型引入格外的信息。类比人类编程的过程,第一种方式相当于你记住了某个函数的用法,第二种方式相当于你阅读函数文档然后短暂的记住了某个函数的用法。

对比两种注入知识方式,第二种更容易实现。RAG 正是这种方式。它能够让基础模型实现非参数知识更新,无需训练就可以掌握新领域的知识。本文选用了 LlamaIndex 框架。LlamaIndex 是一个上下文增强的 LLM 框架,旨在通过将其与特定上下文数据集集成,增强大型语言模型(LLMs)的能力。它允许您构建应用程序,既利用 LLMs 的优势,又融入您的私有或领域特定信息。

环境、模型准备

配置基础环境

创建新的conda环境,命名为 internlm,在命令行模式下运行:

conda create -n internlm python=3.10 -y

复制完成后,在本地查看环境。

conda env list

结果如下所示。

# conda environments:

#

base * /root/.conda

internlm /root/.conda/envs/internlm

运行 conda 命令,激活 internlm 然后安装相关基础依赖

python 虚拟环境:

conda activate internlm

安装python 依赖包

pip install einops==0.7.0 protobuf==5.26.1

安装 Llamaindex

安装 Llamaindex和相关的包

conda activate internlm

pip install llama-index==0.11.20

pip install llama-index-llms-replicate==0.3.0

pip install llama-index-llms-openai-like==0.2.0

pip install llama-index-embeddings-huggingface==0.3.1

pip install llama-index-embeddings-instructor==0.2.1

pip install torch==2.5.0 torchvision==0.20.0 torchaudio==2.5.0 --index-url https://download.pytorch.org/whl/cu121

下载 Sentence Transformer 模型

源词向量模型 Sentence Transformer:(我们也可以选用别的开源词向量模型来进行 Embedding,目前选用这个模型是相对轻量、支持中文且效果较好的,大家可以自由尝试别的开源词向量模型)

运行以下指令,新建一个python文件

cd ~

mkdir -p llamaindex_demo/model

cd ~/llamaindex_demo

touch download_hf.py

打开download_hf.sh 贴入以下代码

HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download --resume-download sentence-transformers/paraphrase-multilingual-MiniLM-L12-v2 --local-dir ./model/sentence-transformer

然后,在 /root/llamaindex_demo 目录下执行该脚本即可自动开始下载:

cd /root/llamaindex_demo

conda activate llamaindex

sh download_hf.sh

更多关于镜像使用可以移步至 HF Mirror 查看。

推荐大家从modelscope下载

https://modelscope.cn/models/Ceceliachenen/paraphrase-multilingual-MiniLM-L12-v2/summary

git lfs install

cd /root/model/

git clone https://www.modelscope.cn/Ceceliachenen/paraphrase-multilingual-MiniLM-L12-v2.git

mv paraphrase-multilingual-MiniLM-L12-v2 sentence-transformer

下载 NLTK 相关资源

我们在使用开源词向量模型构建开源词向量的时候,需要用到第三方库 nltk 的一些资源。正常情况下,其会自动从互联网上下载,但可能由于网络原因会导致下载中断,此处我们可以从国内仓库镜像地址下载相关资源,保存到服务器上。

我们用以下命令下载 nltk 资源并解压到服务器上:

cd /root

git clone https://gitee.com/yzy0612/nltk_data.git --branch gh-pages

cd nltk_data

mv packages/* ./

cd tokenizers

unzip punkt.zip

cd ../taggers

unzip averaged_perceptron_tagger.zip

之后使用时服务器即会自动使用已有资源,无需再次下载。

是否使用 LlamaIndex 前后对比

不使用 LlamaIndex RAG(仅API)

浦语官方 API:https://internlm.intern-ai.org.cn/api/document

运行以下指令,新建一个python文件

cd ~/llamaindex_demo

touch internlm_api.py

打开internlm_api.py 贴入以下代码

from openai import OpenAI

import os

base_url = "https://internlm-chat.intern-ai.org.cn/puyu/api/v1/"

api_key = os.getenv("INTERNLM_TOKEN")

model="internlm2.5-latest"

# base_url = "https://api.siliconflow.cn/v1"

# api_key = "sk-请填写准确的 token!"

# model="internlm/internlm2_5-7b-chat"

client = OpenAI(

api_key=api_key ,

base_url=base_url,

)

chat_rsp = client.chat.completions.create(

model=model,

messages=[{"role": "user", "content": "xtuner是什么?"}],

)

for choice in chat_rsp.choices:

print(choice.message.content)

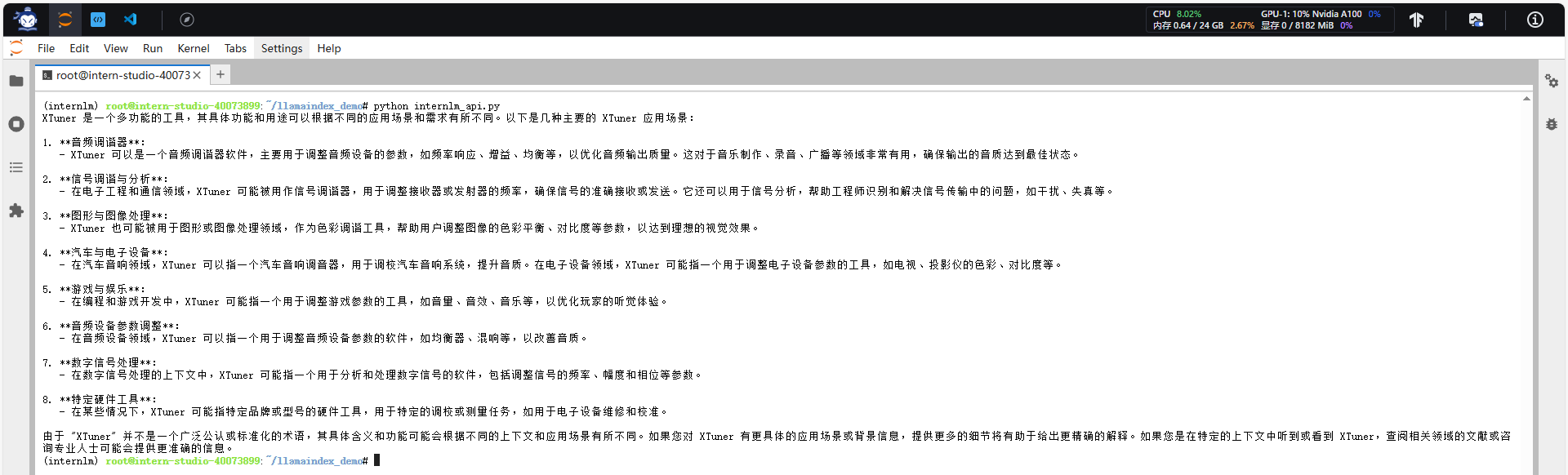

之后运行

conda activate internlm

cd ~/llamaindex_demo/

python internlm_api.py

结果为:

回答的效果并不好,并不是我们想要的xtuner。

使用 API+LlamaIndex

conda activate internlm

运行以下命令,获取知识库

cd ~/llamaindex_demo

mkdir data

cd data

git clone https://github.com/InternLM/xtuner.git

cp xtuner/README_zh-CN.md ./

运行以下指令,新建一个python文件

cd ~/llamaindex_demo

touch llamaindex_RAG.py

打开llamaindex_RAG.py贴入以下代码

import os

from llama_index.core import VectorStoreIndex, SimpleDirectoryReader

from llama_index.core.settings import Settings

from llama_index.embeddings.huggingface import HuggingFaceEmbedding

from llama_index.legacy.callbacks import CallbackManager

from llama_index.llms.openai_like import OpenAILike

# Create an instance of CallbackManager

callback_manager = CallbackManager()

api_base_url = "https://internlm-chat.intern-ai.org.cn/puyu/api/v1/"

api_key = os.getenv("INTERNLM_TOKEN")

model = "internlm2.5-latest"

# api_base_url = "https://api.siliconflow.cn/v1"

# model = "internlm/internlm2_5-7b-chat"

# api_key = "请填写 API Key"

llm =OpenAILike(model=model, api_base=api_base_url, api_key=api_key, is_chat_model=True,callback_manager=callback_manager)

#初始化一个HuggingFaceEmbedding对象,用于将文本转换为向量表示

embed_model = HuggingFaceEmbedding(

#指定了一个预训练的sentence-transformer模型的路径

model_name="./model/sentence-transformer"

)

#将创建的嵌入模型赋值给全局设置的embed_model属性,

#这样在后续的索引构建过程中就会使用这个模型。

Settings.embed_model = embed_model

#初始化llm

Settings.llm = llm

#从指定目录读取所有文档,并加载数据到内存中

documents = SimpleDirectoryReader("./data").load_data()

#创建一个VectorStoreIndex,并使用之前加载的文档来构建索引。

# 此索引将文档转换为向量,并存储这些向量以便于快速检索。

index = VectorStoreIndex.from_documents(documents)

# 创建一个查询引擎,这个引擎可以接收查询并返回相关文档的响应。

query_engine = index.as_query_engine()

response = query_engine.query("xtuner是什么?")

print(response)

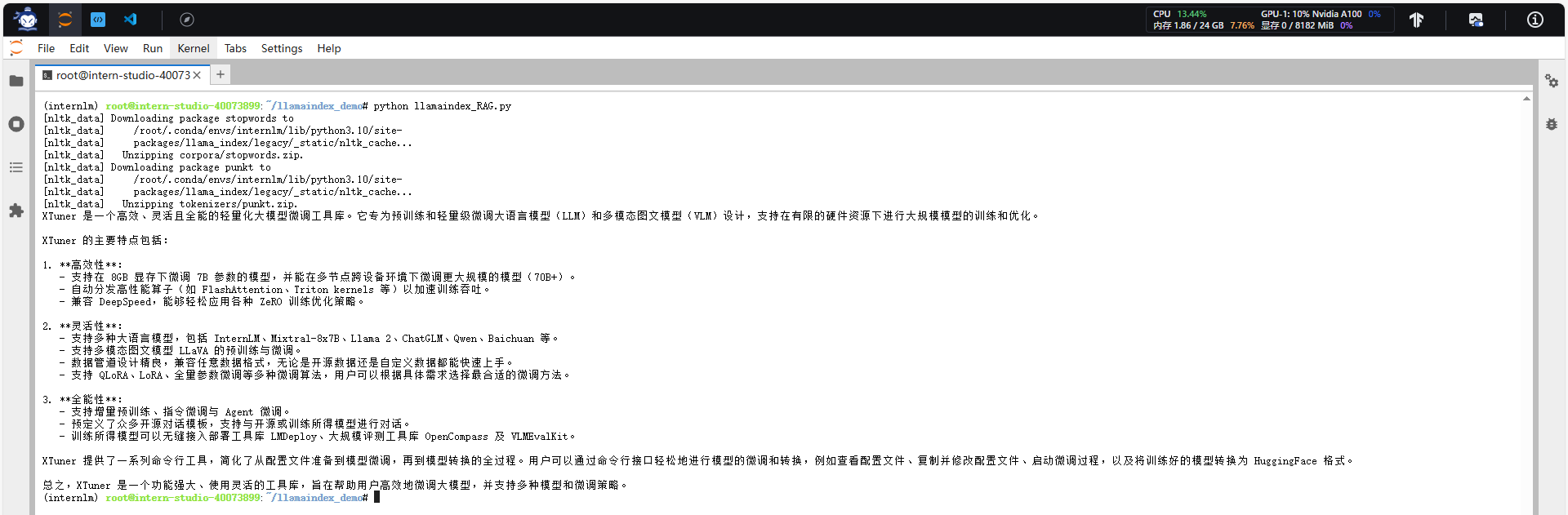

之后运行

conda activate internlm

cd ~/llamaindex_demo/

python llamaindex_RAG.py

注意:第一次运行会下载相关数据需要一段时间,请耐心等待,如中断可能导致第二次运行因为文件损坏报错!!!

结果为:

2238

2238

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?