<<<<<书接上文

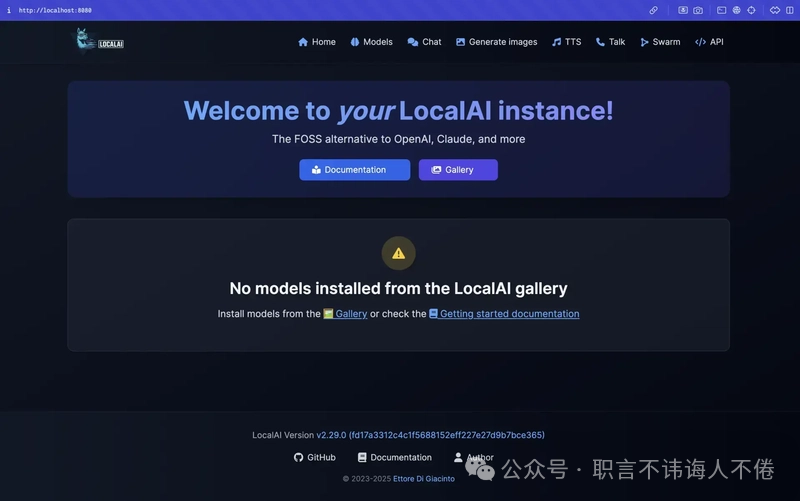

5. LocalAI

开发者的 API 集成首选方案

-

支持多种模型架构(GGUF、ONNX、PyTorch)

-

开箱即用的 OpenAI API 替代方案

-

支持 Docker,易于部署

通过 Docker 运行 LocalAI:

# CPU-only:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu

# Nvidia GPU support:

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

# Full CPU+GPU image:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest

在浏览器输入以下地址访问:

http://localhost:8080/browse/

-

最适合: 需要灵活、API兼容的本地LLM部署的开发者。

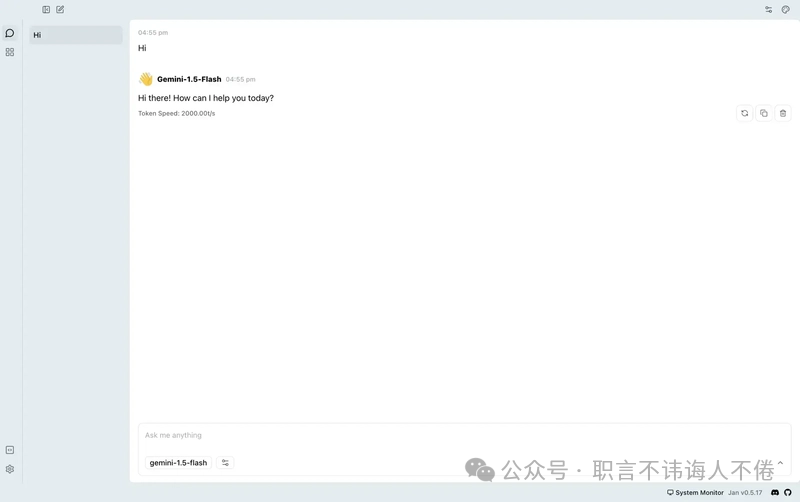

附赠工具:Jan

完全离线的ChatGPT的替代品

-

由Cortex AI引擎驱动

-

本地运行流行的LLM,如Llama、Gemma、Mistral、Qwen

-

兼容OpenAI的API和可扩展的插件系统

-

从jan.ai下载安装程序

-

启动并从内置库下载模型

-

使用聊天界面或启用API服务器进行集成

2025年推荐的本地LLM模型

|

模型 |

内存需求 |

优势 |

兼容工具 |

|---|---|---|---|

| Llama 3(8B) |

16GB |

通用知识,推理 |

Ollama,LM Studio, LocalAI,Jan |

| Llama 3(70B) |

高 |

商业级性能 |

所有工具 |

| Phi-3 Mini |

4Ktokens, 8GB |

编程,逻辑,简单回复 |

所有工具 |

| DeepSeek Coder(7B) |

16GB |

编程和调试 |

Ollama,LM Studio,text-gen-webui, Jan |

| Qwen2(7B/72B) |

多语言,总结 |

Ollama,LM Studio, LocalAI, Jan | |

| MistralNeMo (8B) |

16GB |

商业,文档分析 |

Ollama,LM Studio, text-gen-webui, Jan |

本专题完结

总结

2025年,本地大语言模型工具已高度成熟,为云AI服务提供了强有力的替代方案。无论是简单的命令行操作、图形界面、网页界面,还是完整的开发者API——都能找到适配的本地解决方案。本地运行大语言模型可确保隐私保护、零成本、离线运行能力以及更快的响应速度。

👨💻我是一名有十年以上经验的Java老码农,曾经沉迷于代码的世界,也曾在传统业务系统中摸爬滚打。但时代在变,AI 正在重塑技术格局。我不想被浪潮甩在身后,所以选择重新出发,走上 AI 学习与转型的旅程。

这个公众号,记录的不是鸡汤,也不是“割韭菜”的教程,而是我一个程序员真实的思考、学习、实战经验,以及从困惑到突破的全过程。

📌 如果你也是在技术瓶颈中思考转型、想了解 AI 如何与传统开发结合、又或仅仅想看一个普通工程师的进化之路,欢迎关注,一起探索,一起成长。

关注我 和我一起,紧跟着AI的步伐,不被时代抛弃。✨

1896

1896

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?