截止到本期MATLAB机器学习预测全家桶,一共发了24篇关于机器学习预测代码的文章。算上这一篇,一共25篇!参考文章如下:

2.机器学习预测全家桶,多步预测之BiGRU、BiLSTM、GRU、LSTM,LSSVM、TCN、CNN,光伏发电数据为例

3.机器学习预测全家桶,多步预测之组合预测模型,光伏发电数据为例

4.机器学习预测全家桶之Xgboost,交通流量数据预测为例

5.机器学习预测全家桶之CNN-RVM(相关向量机),风电功率预测

6.水N篇论文就靠它了!Adaboost风电功率预测,机器学习预测全家桶

7.机器学习预测全家桶之单变量输入单步预测,天气温度预测为例

8.2023年冠豪猪算法优化CNN-GRU-Attention多特征输入多步预测

9.机器学习预测全家桶之单变量输入多步预测,天气温度预测为例

10.机器学习预测全家桶新增VMD-TCN-GRU/BiGRU-Attention模型

11.金豺算法优化TCN-BiGRU-Attention多特征输入单步预测

13.12种算法优化CNN-BiLSTM-Attention多特征输入单步预测

14.新思路:TCN-RVM模型,你见过吗?机器学习预测全家桶新增模型

15.再添数十种回归模型!最全机器学习预测全家桶,MATLAB代码,这次千万别再错过了!

16.12种算法优化CNN-BiGRU-Attention单变量输入单步预测,持续更新

17.BiTCN、BiTCN-SVM、BiTCN-LSTM、BiTCN-BiGRU机器学习预测全家桶

18.机器学习预测全家桶再更新!CEEMDAN-VMD双分解CNN-BiLSTM预测,MATLAB代码

19.四种算法优化ELM,实现多变量输入超前24步预测功能,机器学习预测全家桶再更新!

20.7种2024年算法优化BP,实现回归,单/多变量输入,单/多步预测功能

21.电力负荷超前96步预测,采用2024最新鹭鹰算法优化ELM实现,MATLAB代码

22.一篇搞定分位数回归区间预测,机器学习预测全家桶MATLAB代码再更新!

23.Transformer实现风电功率/光伏功率预测,MATLAB预测全家桶再更新!

24.新英格兰2024年最新负荷数据预测,MATLAB预测全家桶再更新!

本期在全家桶内继续更新三种不同组成结构的Transformer-LSTM。

-

第一种:并行Transformer-LSTM。

-

第二种:串行Transformer-LSTM。

-

第三种:串行LSTM-Transformer。

以上三种格式,大家自行斟酌使用,这里只探讨代码实现方式,不对其合理性过多解释。

注意,此全家桶代码包含了自注意力机制(selfAttentionLayer)和Transformer模型,该函数只有2023b及以上版本的matlab才有,因此请小伙伴自行下载2023b及其以上版本的matlab。

一、Transformer 模型概述

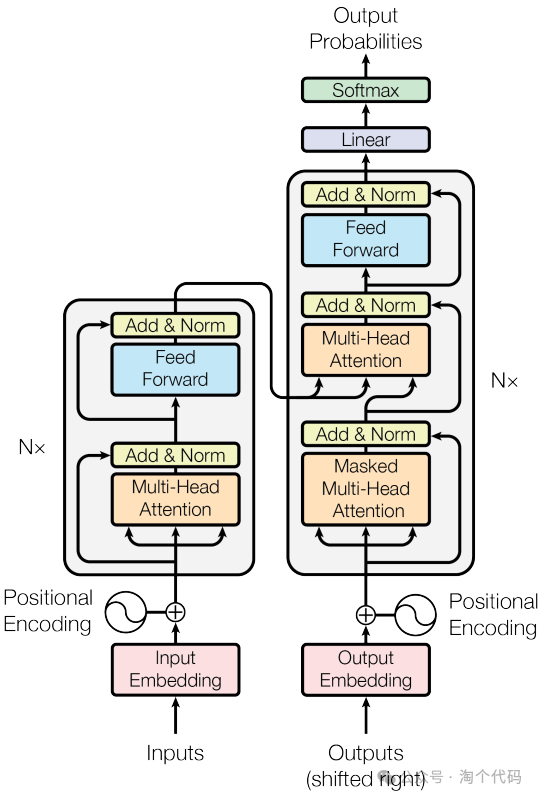

Transformer 作为一种创新的神经网络结构,深受欢迎。采用 Transformer 编码器对光伏、负荷数据特征间的复杂关系以及时间序列中的长短期依赖关系进行挖掘,可以提高光伏功率、负荷预测的准确性。Transformer 编码器一般由多个编码器层堆叠而成,具体架构如图所示。每个编 码器层包括注意力子层和前馈神经网络子层,其中注意力子层包括多头自注意力机制和残差连接与层归一化,前馈神经网络子层包括前馈神经网络和残差连接与层归一化。关于Transformer模型介绍网上有很多博主都讲解的不错,本期主要为代码实现。

Transformer架构

二、Transformer与LSTM的优缺点

LSTM和Transformer各自具有独特的优势,并在不同的任务中发挥着重要作用。LSTM通过门控机制有效捕捉长期依赖关系,适用于处理长序列数据;而Transformer则具有强大的并行化能力和全局信息捕捉能力,适用于处理大规模序列数据。在实际应用中,我们可以根据任务的特点和需求选择合适的模型。也可以将两种模型进行结合,取长补短,优势互补。

三、实验部分

本期实验实现三种结构的模型:多特征输入单步预测

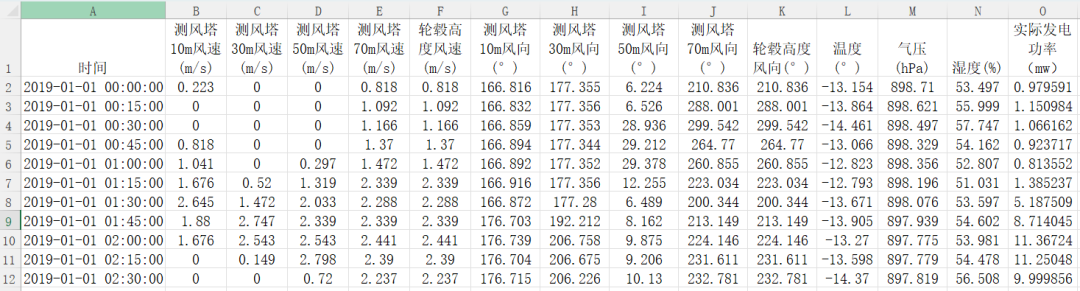

以《风电场功率预测.xlsx》为例进行介绍。数据格式如下:

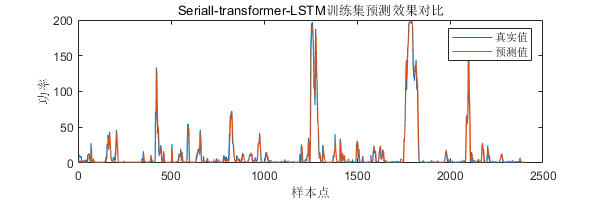

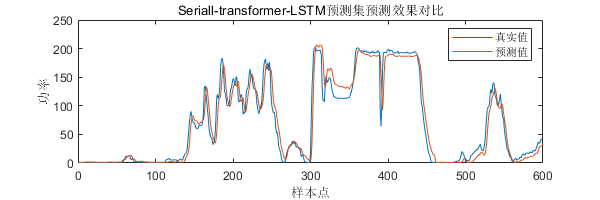

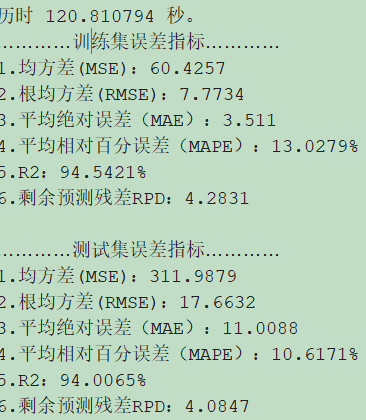

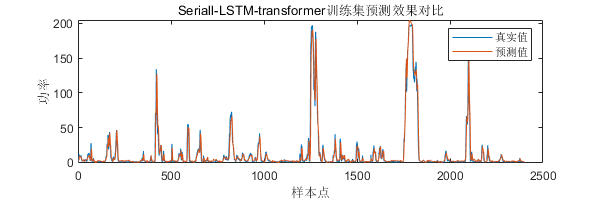

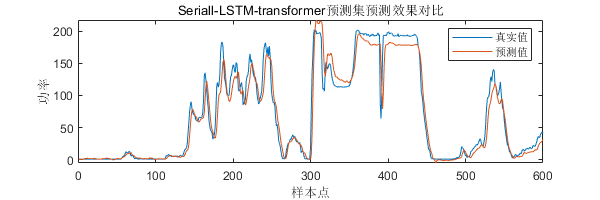

设置网络为多特征输入(所有的特征值,包括测风塔风速、温度、气压等数据),多步预测(把功率作为预测值)。采用前3个历史时刻的特征值预测未来1个时刻的功率值。一共设置了3000个样本,其中2400个用于训练,600个用于测试。结果如下:

-

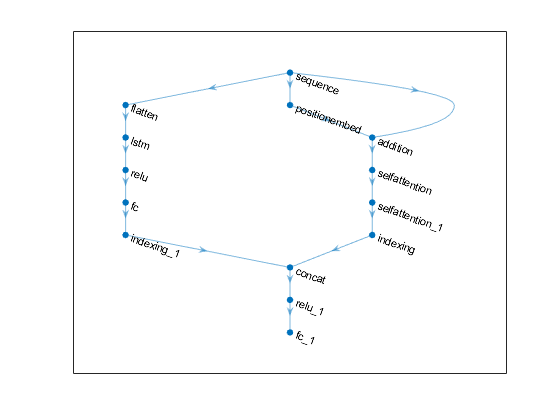

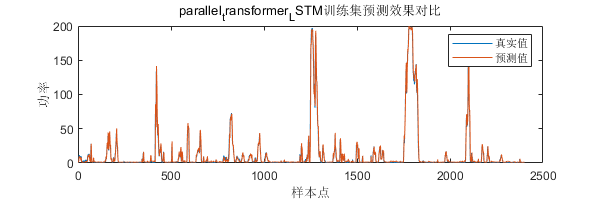

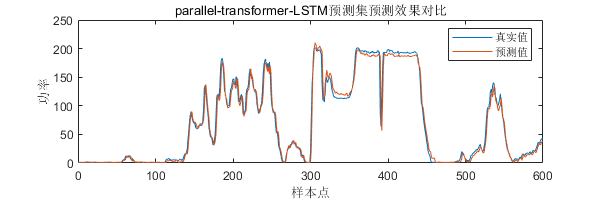

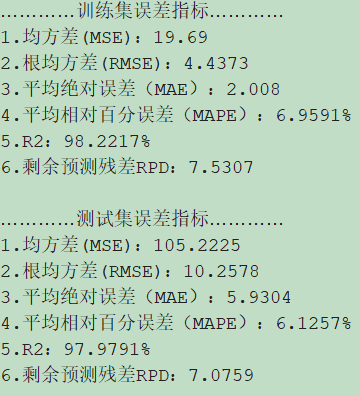

第一种:并行Transformer-LSTM。

先看网络结构:

数据信号同时输入LSTM层(左侧),Transformer网络(右侧),最后对Indexing层的输出进行拼接,再经过一个全连接层,最后进行输出。

预测结果展示:

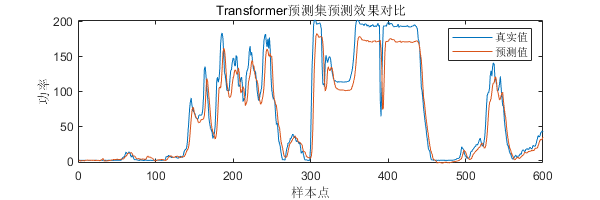

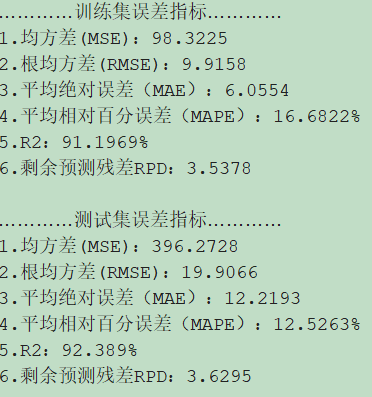

为了有个更好的对比,这里附上单独的Transformer预测效果(单独的Transformer参数设置与Transformer-LSTM中的参数设置一致。):

-

第二种:串行Transformer-LSTM。

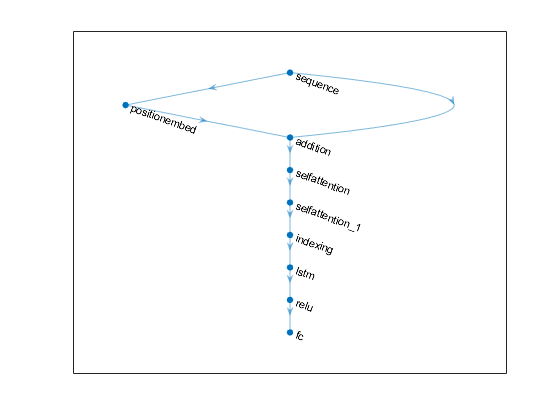

先看网络结构:

预测结果展示:

-

第三种:串行LSTM-Transformer。

先看网络结构:

预测结果展示:

以上三种网络结构,只探讨代码实现,至于结合的原理与效果,还有待进一步研究。

点击下方卡片获取代码。

319

319

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?