引言

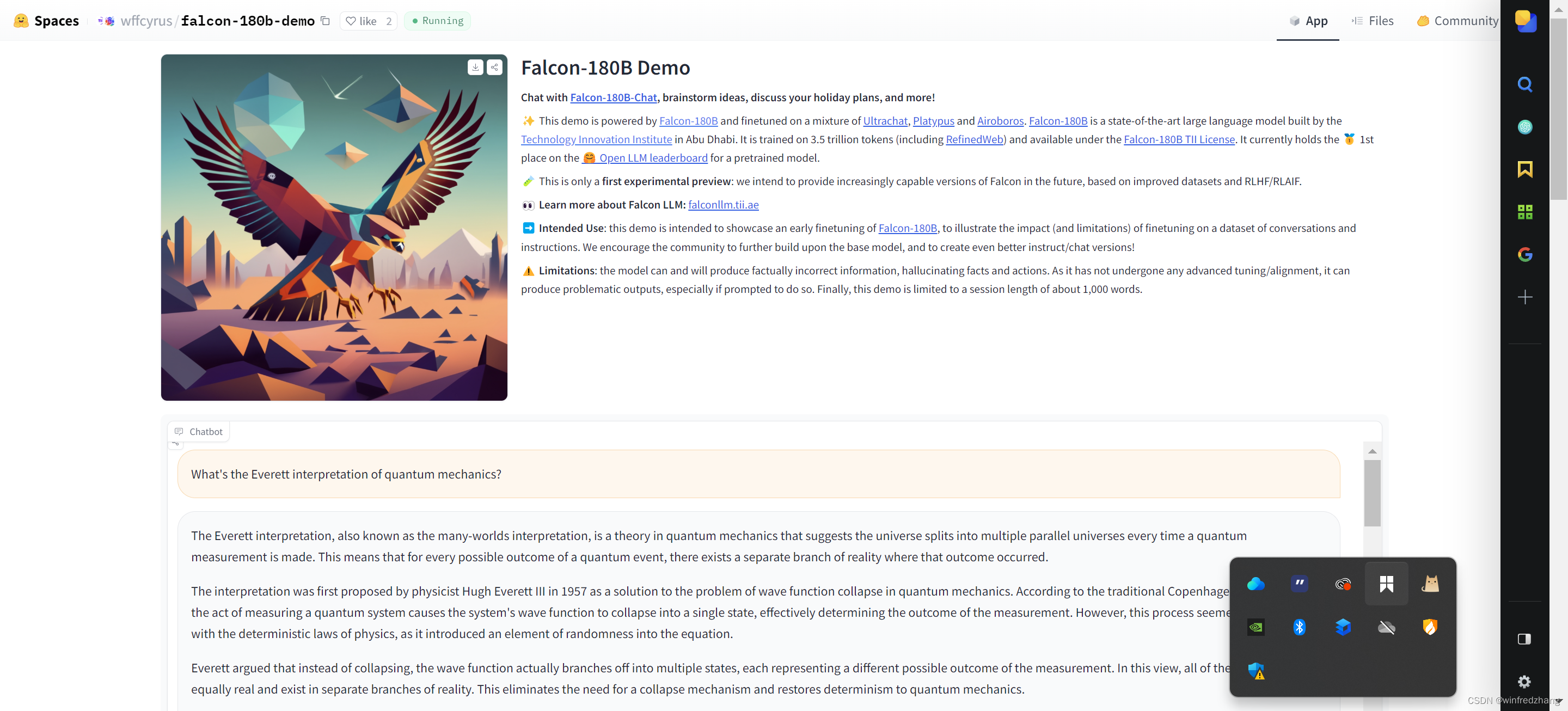

由Technology Innovation Institute(T四训练的开源大模型Falcon 180B登陆Hugging Face!Falcon180B为开源大模型树立了全新的标杆。作为当前最大的开源大模型,有l80B参数并且是在在3.5万亿token的TII RefinedWeb数据集上进行训练,这也是目前开源模型里最长的单波段预训练。

你可以在Hugging Face Hub中查阅其基础模型、聊天模型,以及其Space应用。

从表现能力上来看,Falcon180B在自然语言任务上的表现十分优秀。它在开源模型排行榜(预训练)上名列前茅,并可与PLM-2等专有模型相差无几。虽然目前还很难给出明确的排名,但它被认为与 PalM2 Large不相上下,这也使得它成为目前公并的能力最强的LLM之一。

demo:https://huggingface.co/spaces/wffcyrus/falcon-180b-demo

埃弗雷特对量子力学的解释是什么?

没有检索到标题

没有检索到标题

Falcon180B,一款拥有180亿参数的开源大模型,在TIIRefinedWeb数据集上训练,表现出色,跻身开源模型排行榜前列,与专有模型如PLM-2相当,成为最强LLM之一。

Falcon180B,一款拥有180亿参数的开源大模型,在TIIRefinedWeb数据集上训练,表现出色,跻身开源模型排行榜前列,与专有模型如PLM-2相当,成为最强LLM之一。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1540

1540

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?