在工业4.0时代,海量的非结构化数据,如设备日志、维护报告、工单记录等,蕴含着巨大的价值。如何高效地从这些文本中提取关键信息,并将其转化为结构化的知识,是实现智能运维、故障预测和决策支持的关键。本文以智能制造场景为例,深入探讨如何利用大语言模型(LLMs)将非结构化的设备日志,转化为一个可交互、可视化的知识图谱。

目标读者:

对自然语言处理(NLP)、知识图谱和LLMs感兴趣的初中级Python开发者和AI工程师。核心方法:

我们采用一个高度模块化、循序渐进的方法。每一步都将执行一个明确的步骤,并立即展示其输出结果,让读者清晰地看到数据在每个阶段的演变,最终构建出一个动态的、可交互的知识图谱。

一、 核心技术原理

在深入实践之前,我们首先需要理解两个核心概念:知识图谱(Knowledge Graph)和SPO三元组(Subject-Predicate-Object Triples),以及LLM在其中扮演的关键角色。

1.1 什么是知识图谱?

知识图谱是一种用图结构来表示现实世界中实体(Entities)及其相互关系(Relationships)的知识库。它由节点(Nodes)和边(Edges)组成:

- 节点 (Nodes):

代表实体,如一台具体的设备(“CNC-A500机床”)、一个故障现象(“主轴转速异常”)或一个解决方案(“重新紧固连接线”)。 - 边 (Edges):

代表实体间的关系,通常带有方向和标签,描述了实体间的具体联系。例如:(CNC-A500机床) -[发生故障]-> (主轴转速异常)。

通过知识图谱,我们可以直观地理解复杂的因果关系、进行根因分析,并为智能问答系统提供结构化知识支持。

1.2 SPO三元组:知识图谱的原子构建块

从文本中构建知识图谱,最基础的单元是 主-谓-宾(Subject-Predicate-Object, SPO) 三元组。它以一种简洁的结构捕获一个独立的事实:

- 主体 (Subject): 事实陈述的核心实体。

- 谓词 (Predicate): 描述主体和客体之间关系或动作的词语。

- 客体 (Object): 与主体通过谓词相关联的另一个实体。

示例: “CNC-A500型机床报告了’主轴转速异常’警报” ->(CNC-A500型机床, 报告警报, 主轴转速异常)。

LLM的强大之处在于其卓越的自然语言理解能力,能够从复杂的句子中准确识别出这些SPO三元组。

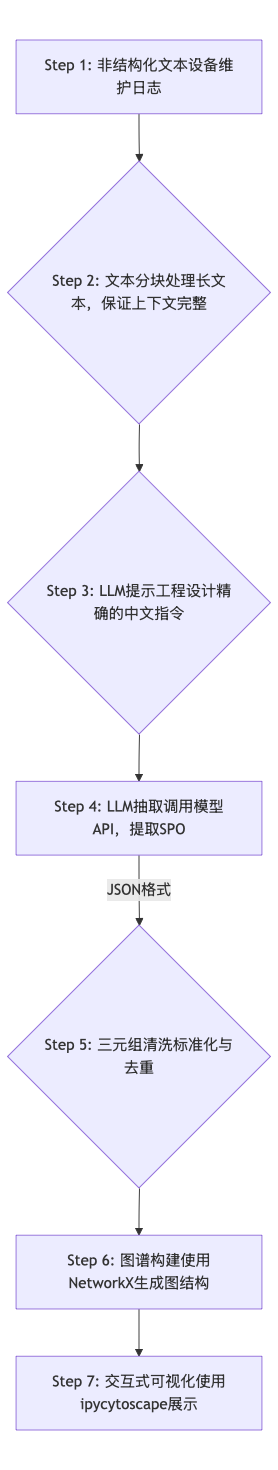

1.3 整体技术流程

我们将遵循以下流程,将原始文本转化为知识图谱:

二、 实战演练:从设备日志到故障知识图谱

Step 1: 环境准备 - 安装依赖库

首先,我们需要安装所有必要的Python库。我们将使用 openai 与LLM交互,networkx 构建图数据结构,以及 ipycytoscape 进行交互式可视化。

进阶分析:库选择考量

- NetworkX:

轻量级且功能强大的图论库,非常适合在内存中快速构建、操作和分析中小型图谱。其API直观,易于上手。 - ipycytoscape:

专为Jupyter环境设计,它将强大的Cytoscape.js可视化引擎带入Notebook,实现了真正的"所见即所得"的交互式分析,远胜于静态图片。 - Pandas:

虽然不是核心,但在数据处理的中间环节,使用DataFrame来展示和检查数据(如分块结果、提取的三元组)极为方便,增强了代码的可读性和可调试性。

# 仅需运行一次

%pip install openai networkx "ipycytoscape>=1.3.1" ipywidgets pandas

# 在经典的Jupyter Notebook中,可能需要额外启用ipywidgets扩展

# jupyter nbextension enable --py widgetsnbextension

# --- 重要提示:运行此单元后,请重启Jupyter内核! ---

Step 2: 导入所需库

安装完成后,我们将所有需要的模块导入到当前环境中。

import openai

import json

import networkx as nx

import ipycytoscape

import pandas as pd

import os

import re

import warnings

# 配置Pandas显示选项和忽略警告,以获得更好的输出体验

warnings.filterwarnings('ignore', category=DeprecationWarning)

pd.set_option('display.max_rows', 100)

pd.set_option('display.max_colwidth', 150)

print("库导入成功。")

Step 3: 配置LLM访问凭证

配置对大语言模型的API访问。强烈建议使用环境变量来存储API密钥,避免硬编码在代码中。

# --- 定义你希望使用的LLM模型 ---

# 示例: 'gpt-4o', 'gpt-3.5-turbo', 'llama3', 'deepseek-ai/DeepSeek-Coder-V2-Lite-Instruct'

llm_model_name = "deepseek-ai/DeepSeek-V3" # <-- *** 请替换为你自己的模型 ***

# --- 从环境变量中获取凭证 ---

api_key = os.getenv("OPENAI_API_KEY")

base_url = os.getenv("OPENAI_API_BASE") # 如果使用非OpenAI官方服务,如Ollama或私有部署

# --- 验证并初始化客户端 ---

if not api_key:

print("错误:未设置OPENAI_API_KEY环境变量。")

raise SystemExit("API密钥配置失败。")

else:

client = openai.OpenAI(

base_url=base_url,

api_key=api_key

)

print("OpenAI客户端初始化成功。"

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1449

1449

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?