【先导】:

-

填充可以增加输出的高度和宽度。这常用来使输出与输入具有相同的高和宽。

-

步幅可以减小输出的高和宽,例如输出的高和宽仅为输入的高和宽的(是一个大于的整数)。

-

填充和步幅可用于有效地调整数据的维度。

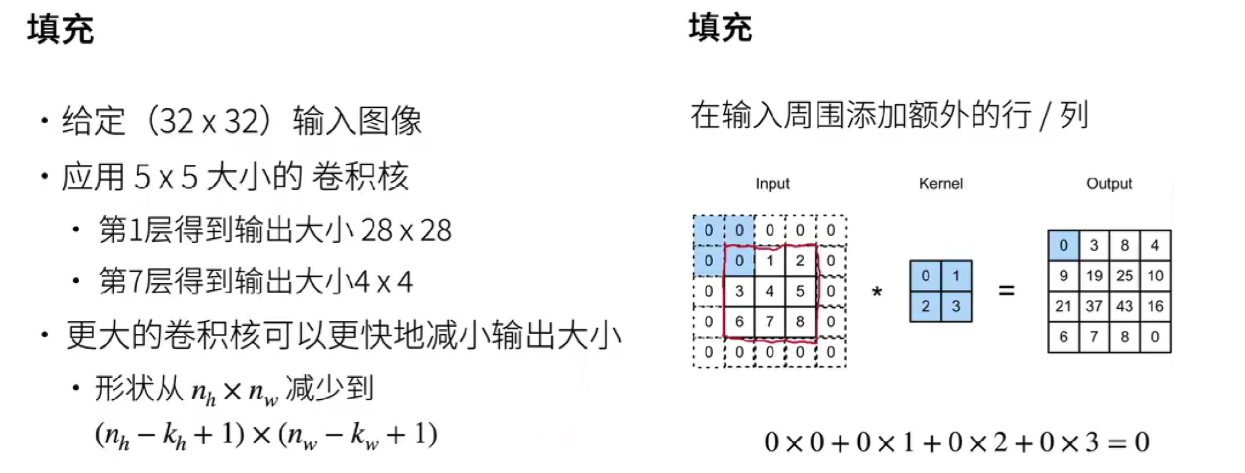

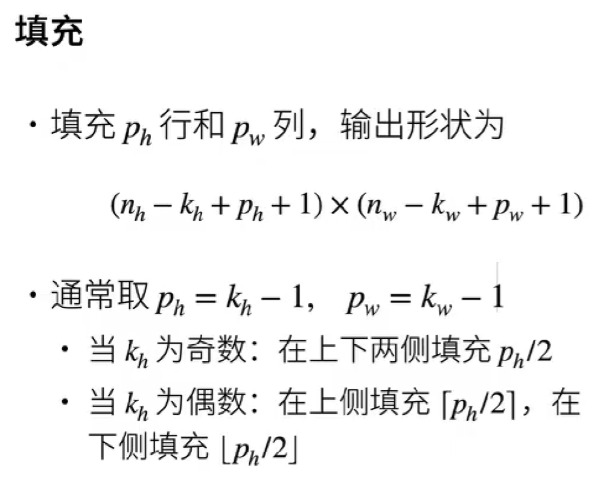

1. 填充

填充是在输入数据的周围添加额外的像素值,通常是零像素,以调整输入数据的大小。

在卷积神经网络(CNN)中,填充的使用主要是为了控制卷积操作后的输出特征图的尺寸。

作用:

-

保持空间信息 :在不使用填充的情况下,卷积操作会导致输出特征图的尺寸缩小,这可能会丢失一些边界像素的信息。通过添加填充,可以保持输入数据的空间分辨率,使边界像素也能被卷积核充分考虑,保留更多的空间信息。

-

控制输出尺寸 :根据具体的需求,可以通过调整填充的大小来控制输出特征图的尺寸。例如,在一些需要保持输入和输出尺寸相同的场景中,可以使用填充来实现。

当卷积核大小 Kh 为偶数时,可采用非对称填充方式。以核大小为 4 为例,可通过在上侧填充 2 行、下侧填充 1 行来实现特定效果,当然,也可以选择上侧填充 1 行、下侧填充 2 行的方案。

当卷积核大小 Kh 为奇数时,则通常采用对称填充。比如核大小为 3,此时可上下各填充 1 行,左右各填充 1 列,使填充后的区域在卷积核周围均匀分布,从而保持输出特征图的对称性与稳定性。

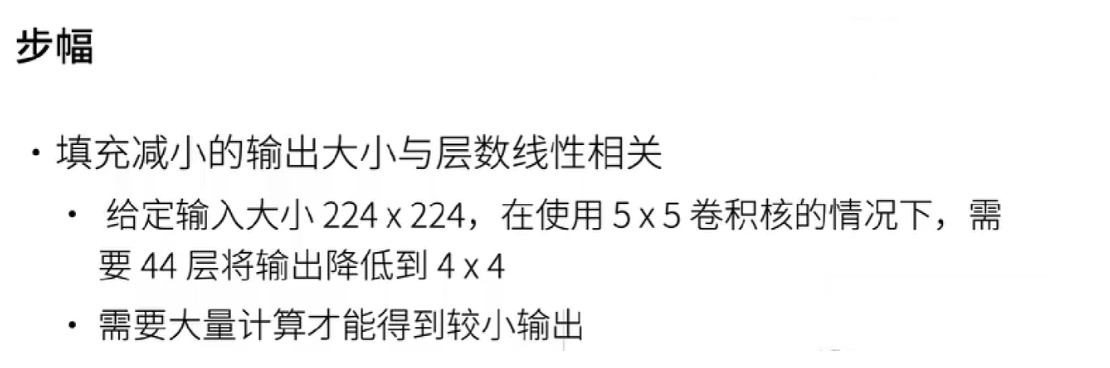

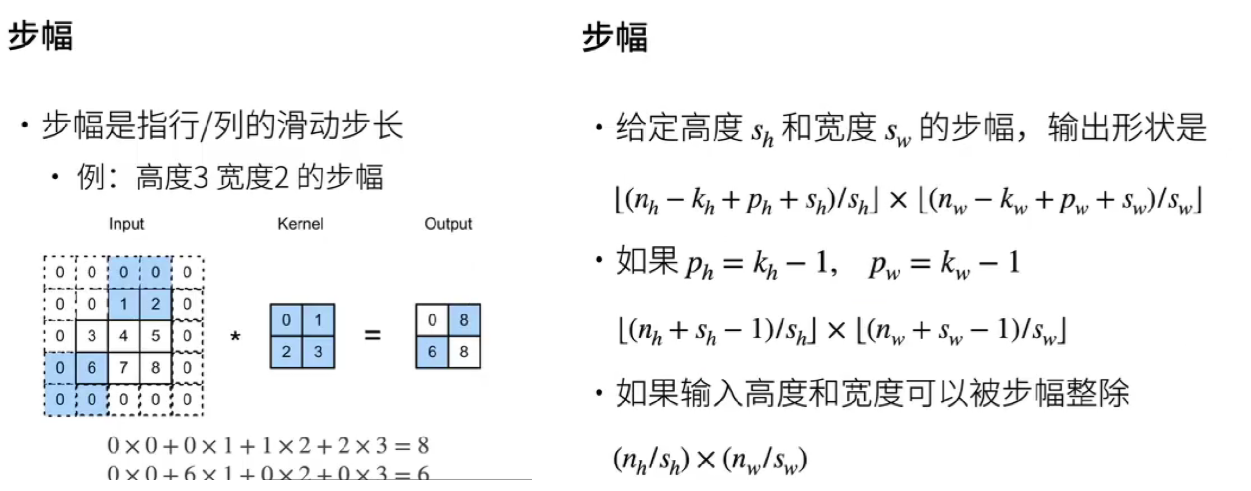

2. 步幅

步幅是指卷积核在输入数据上每次移动的步长。它决定了卷积核在进行卷积操作时的移动速度。

作用:

-

减少计算量和参数量 :较大的步幅会使卷积核在输入数据上移动得更快,从而减少输出特征图的尺寸,进而减少计算量和参数量。这对于处理大型数据集或构建深度网络时非常有用,可以提高计算效率并减轻模型的负担。

-

控制感受野 :步幅的大小会影响卷积神经网络的感受野。较大的步幅会使感受野增大,模型能够捕获到更广泛的上下文信息,但可能会丢失一些局部细节信息。较小的步幅则会使感受野相对较小,但能够更好地保留局部特征。

常见步幅设置:

-

步幅为 1 :这是最常用的步幅设置,卷积核每次移动一个像素。这种设置可以保持较高的空间分辨率,能够捕捉到输入数据中的细节信息。

-

步幅大于 1 :例如步幅为 2,卷积核每次移动两个像素。这种设置可以快速减小输出特征图的尺寸,减少计算量,同时也能使模型具有更大的感受野。在实际应用中,可以根据具体的需求和数据特点来选择合适的步幅大小。

3. 填充与步幅的应用

在下面的例子中,我们创建一个高度和宽度为3的二维卷积层,并在所有侧边填充1个像素。

给定高度和宽度为8的输入,则输出的高度和宽度也是8。

默认情况下,填充为0,步幅为1。

import torch

from torch import nn

# 为了方便起见,我们定义了一个计算卷积层的函数。

# 此函数初始化卷积层权重,并对输入和输出提高和缩减相应的维数

def comp_conv2d(conv2d, X):

# 这里的(1,1)表示批量大小和通道数都是1

X = X.reshape((1, 1) + X.shape)

Y = conv2d(X)

# 省略前两个维度:批量大小和通道

return Y.reshape(Y.shape[2:])

# 请注意,这里每边都填充了1行或1列,因此总共添加了2行或2列

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1)

X = torch.rand(size=(8, 8))

comp_conv2d(conv2d, X).shape

输出:torch.Size([8, 8])

卷积核的高度和宽度不同时,可以填充不同的高度和宽度,使输出和输入具有相同的高度和宽度。

在如下示例中,我们使用高度为5,宽度为3的卷积核,高度和宽度两边的填充分别为2和1。

conv2d = nn.Conv2d(1, 1, kernel_size=(5, 3), padding=(2, 1))

comp_conv2d(conv2d, X).shape

输出:torch.Size([8, 8])

下面,我们将高度和宽度的步幅设置为2,从而将输入的高度和宽度减半:

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1, stride=2)

comp_conv2d(conv2d, X).shape

# 注意,这里的X是(8,8)

输出:torch.Size([4, 4])

接下来,看一个稍微复杂的例子:

conv2d = nn.Conv2d(1, 1, kernel_size=(3, 5), padding=(0, 1), stride=(3, 4))

comp_conv2d(conv2d, X).shape

输出:torch.Size([2, 2])

9093

9093

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?