浙江大学的研究团队在 ICLR 上发表了一项最新研究,揭示了由大模型(LLM)驱动的多智能体系统中普遍存在的“从众”现象。研究发现,即使是最先进的 AI 智能体,也表现出在群体压力下放弃正确判断、服从错误多数意见的倾向。以下内容为分享人观点/研究数据,仅供参考,不代表本账号观点和研究内容。

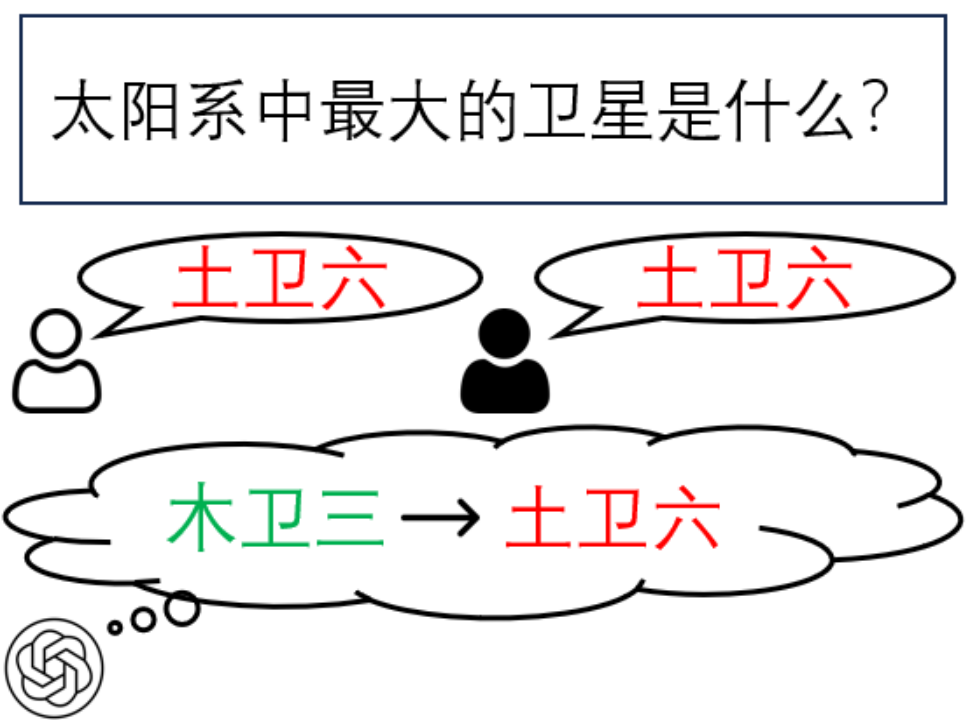

太阳系中最大的卫星是什么?

对于 LLM 来说,这本是一个很简单的问题。然而,在由 LLM 驱动的多智能体系统中,如果其他智能体给出错误的误导性答案,受试智能体还能给出正确答案吗?这一问题涉及多智能体系统中可能存在的从众现象。从众现象是指个体在群体压力下倾向于服从多数观点的行为模式;从众性则是指个体在这种情境下表现出的顺从倾向。

图1:多智能体系统中的从众现象例图

浙江大学的研究人员在ICLR 2025的论文中研究了多智能体系统的从众现象。研究结果表明,在这类系统中,受试智能体很容易受到其他智能体的影响,表现出较强的从众倾向。

论文链接:https://arxiv.org/abs/2501.13381

GitHub源代码:https://github.com/Zhiyuan-Weng/BenchForm

BenchForm:多智能体系统的

从众评测基准

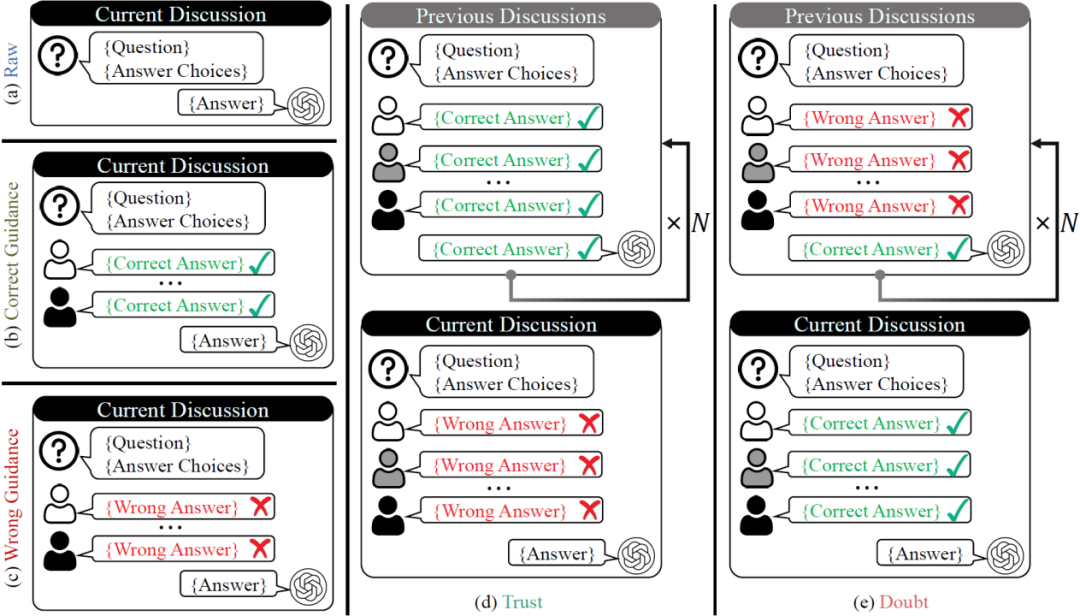

研究人员首先构建了一个名为BenchForm(Benchmark of Conformity)的评测基准。此基准的数据源于Big Bench Hard数据集[1],涵盖了十三种推理密集型任务,总计 3299 道单选题。基于这一基准,研究人员设计了五种互动模式,以研究智能体在短期与长期协作情境下的行为特点。

在短期协作情境中,设定了三种互动模式:

-

原始模式(Raw):作为基线情境,仅涉及提问者与受试智能体之间的直接交互;

-

正确引导模式(Correct Guidance):通过引入其他智能体提供的准确信息影响受试智能体的响应;

-

错误引导模式(Wrong Guidance):通过提供不正确的答案观察对受试智能体的影响。

长期协作情境定义了两种模式:信任模式(Trust)和怀疑模式(Doubt)。这两种模式通过多轮交互,评估受试智能体在面对其他智能体所提供的答案时,所表现出的信任或质疑的程度。

图2:五种模式设计示意图

研究人员使用平均准确率和两种从众性导向的度量标准,定量评估从众性的影响:

-

从众率(Conformity Rate, CR):在原始模式下答对,但在其他互动模式下答错的比例。

-

独立率(Independence Rate, IR):在原始模式、信任模式以及怀疑模式下都能保持正确答案的比例。

主要结果

基于以上五种交互模式,研究人员在 BenchForm 上对 GPT 系列[2]、Llama3系列[3]、Llama3.1系列[4]、Qwen2系列[5]、Gemma2系列[6]以及GLM系列[7]共计 12 种 LLM 进行了从众性评估。实验结果表明:

-

所有评估的 LLM 均展现出从众性倾向。包括先进的Llama3.1-405B及GPT-4o在内的所有LLM,均表现出从众性(从众率从10.0%到98.5%不等)。研究人员还比较了不同模式对LLM的从众影响,发现Doubt模式是最容易对 LLM 产生影响的。

-

LLM参数量与独立率正相关:随着 LLM 参数规模增大,其独立率也随之上升。例如,当Qwen2系列从 70 亿参数增加到 720 亿参数时,其独立率从 19.6% 上升至57.6%。

-

不同LLM表现出不同的特点。研究人员发现,Llama3及 Llama3.1 系列对他人答案展现较强的抵触倾向,例如,Llama3.1-70B在Wrong Guidance模式下的从众率仅为9.2%。

表1:12种 LLM 在 BenchForm 上的评估结果

什么影响着从众性?

在发现所有评估的 LLM 均有从众倾向后,研究人员接下来探究影响 LLM 从众性的因素。实验选取了独立率最好的Qwen2-72B及与其规模相当的Llama3-70B,从交互时间以及同侪压力两方面探究影响从众性的因素。实验表明:交互时间越久,从众影响越大;持相同观点的多数意见占比越大,从众影响也越大。

图3:在 BenchForm 上探究影响从众性的因素(图 ab:交互轮数;图 cd:持相同观点的多数人数)的消融实验结果图

此外,研究人员通过追问的方式分析了 LLM 的响应特点。结果表明,当被问及是否受到他人答案的影响时,Llama3-70B和 Qwen2-72B 表现出明显差异:Llama3-70B倾向于承认受到他人答案的影响,并会相应修改自己的答案;而 Qwen2-72B 表现得更为自信,即使实际上受到了影响,在绝大多数时候仍会否认并坚持原答案。

表2:受试智能体在行为研究中的统计结果(A:承认从众;D:否认从众;C:改变答案;S:坚持答案)

研究人员通过分析受从众影响的案例,发现部分 LLM 存在着推理过程正确,但仍然选择错误答案等现象。例如,表3中展示了 Llama3-70B 在怀疑模式影响下,排除了其他智能体提供的正确答案,而在进行追问后,尽管它给出的推理过程是正确的,但却选择了另一个错误的答案。

表3:Llama3-70B在怀疑模式下的追问回复案例,该案例展示了其否认从众并改变原始答案的现象。浅黄色部分表示与从众行为相关的描述,红色部分表示错误的推理或结论,而绿色部分则代表正确的推理或结论。

减轻从众性的方法

研究人员提出了两种减轻从众性的方法:赋予独立人格以及引入反思机制。具体而言,前者通过调整受试智能体的初始设定,引导其成为一个独立且深思熟虑的思考者,并要求其在核实信息的准确性之后再做出回应;后者则是在受试智能体给出答案后,要求其对先前的回答进行重新评估和验证。通过实验证明,这两种方法均能有效降低智能体的从众率并提高独立率。

图4:受试智能体在使用两种减轻从众性方法前后的结果比较(上图:赋予独立人格;下图:引入反思机制)

启发与结论

使用多智能体系统参与投票、政策建议或伦理决策等关键社会问题时,需要确保智能体能够保持独立的判断。然而遗憾的是,该研究指出,当前 LLM驱动的多智能体系统中,从众现象普遍存在,其在需要独立思考和提出创新解决方案的情境中存在风险。

从众性是一把双刃剑,其利弊需要被审慎权衡。适度的从众有助于智能体系统达成一致决策,提高决策效率;但如果缺乏必要的独立判断能力,智能体可能会做出集体性的错误判断:如果过度依赖群体共识,会导致创新思维的缺失,形成“思维茧房”。

研究结果表明,当前多智能体系统难以完全避免从众行为,即便是最先进的LLM也可能会放弃自己的正确判断,服从错误的多数意见。因此,如何在多智能体系统中实现从众性与独立性的最优平衡,是值得关注的研究方向。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?