后续需要将自己编写的Spark程序提交到相关的资源平台上,比如说: local yarn spark集群(standalone)

Spark为了方便任务的提交操作,专门提供了一个用于进行任务提交的脚本文件: spark-submit

spark-submit在提交的过程中,设置非常多参数,调整任务相关信息。如果忘记了,可以使用spark-submit --help进行查看

基本参数设置

Driver的资源配置参数

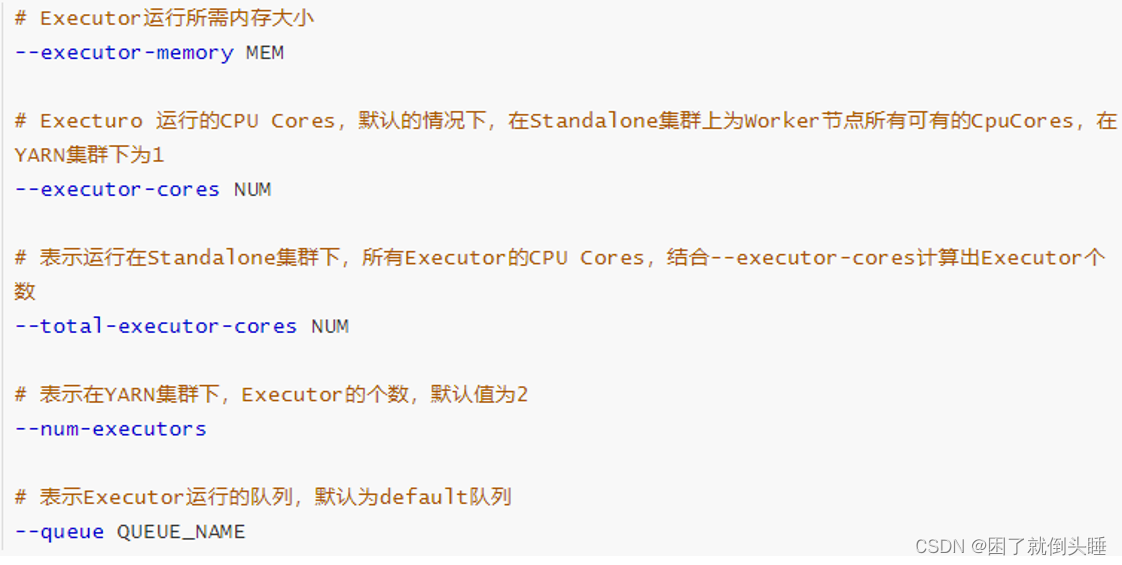

executor的资源配置参数

示例

官方圆周率示例

SPARK_HOME=/export/server/spark

${SPARK_HOME}/bin/spark-submit \

--master yarn \

--driver-memory 512m \

--executor-memory 512m \

--executor-cores 1 \

--num-executors 2 \

--queue default \

--conf "spark.pyspark.driver.python=/root/anaconda3/bin/python3" \

--conf "spark.pyspark.python=/root/anaconda3/bin/python3" \

${SPARK_HOME}/examples/src/main/python/pi.py \

10

自定义的python示例

./spark-submit --master yarn \ --deploy-mode cluster \ --conf "spark.pyspark.driver.python=/root/anaconda3/bin/python3" \ --conf "spark.pyspark.python=/root/anaconda3/bin/python3" \ --driver-memory 2048m \ --drvier-cores 2 \ --executor-memory 2048m \ --executor-cores 4 \ --num-executors 2 \ /export/data/spark_project/spark_base/05_词频统计案例_spark_on_yarn运行.py

952

952

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?