怎么查看查看源代码

1.鼠标右键(ctrl+u)

2.点击F12

3.在浏览器工具里找到开发者工具

robot协议是什么

robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。

域名后添加robots.txt可查看该协议。

1.如果允许所有搜索引擎访问网站的所有部分的话 我们可以建立一个空白的文本文档,命名为robots.txt放在网站的根目录下即可。

robots.txt写法如下:

User-agent: *

Disallow:

或者

User-agent: *

Allow: /

2.如果我们禁止所有搜索引擎访问网站的所有部分的话robots.txt写法如下:

User-agent: *

Disallow: /

3.如果我们禁止除Google外的一切搜索引擎索引我们的网站话写法如下:

User-agent: Googlebot

Disallow:

User-agent: *

Disallow: /

backup备份文件

backup文件也叫系统备份文件,它的做作用是:拷贝到存储介质上的文件,可以帮助保护数据,以防其在系统硬件或存储介质出现故障时受到破坏。

常见的备份文件后缀名有: .git .svn .swp .svn .~ .bak .bash_history

*.php~和 *.php.bak可以打开php的备份文件。

cookie是什么

Cookie是当主机访问Web服务器时,由 Web 服务器创建的,将信息存储在用户计算机上的文件。一般网络用户习惯用其复数形式 Cookies,指某些网站为了辨别用户身份、进行 Session 跟踪而存储在用户本地终端上的数据,而这些数据通常会经过加密处理,比如你的淘宝购物车。输入cookie.php进入。

(http响应包在网络里查看)

disabled-button

- 这个disabled 删去就可以按了。

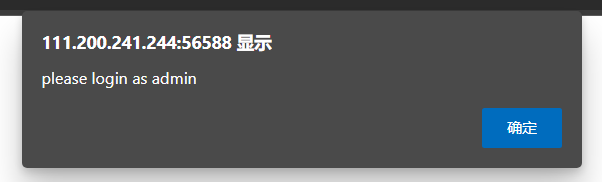

weak-auth

提示输入

- 随便输入后得到username=admin

- 抓包爆破

- 这个长度不一样的就是密码

brup-suite介绍

1.Target(目标)——显示目标目录结构的的一个功能

2.Proxy(代理)——拦截HTTP/S的代理服务器,作为一个在浏览器和目标应用程序之间的中间人,允许你拦截,查看,修改在两个方向上的原始数据流。

3.Spider(蜘蛛)——应用智能感应的网络爬虫,它能完整的枚举应用程序的内容和功能。

4.Scanner(扫描器)——高级工具,执行后,它能自动地发现web 应用程序的安全漏洞。

5.Intruder(入侵)——一个定制的高度可配置的工具,对web应用程序进行自动化攻击,如:枚举标识符,收集有用的数据,以及使用fuzzing 技术探测常规漏洞。

6.Repeater(中继器)——一个靠手动操作来触发单独的HTTP 请求,并分析应用程序响应的工具。

7.Sequencer(会话)——用来分析那些不可预知的应用程序会话令牌和重要数据项的随机性的工具。

8.Decoder(解码器)——进行手动执行或对应用程序数据者智能解码编码的工具。

9.Comparer(对比)——通常是通过一些相关的请求和响应得到两项数据的一个可视化的“差异”。

10.Extender(扩展)——可以让你加载Burp Suite的扩展,使用你自己的或第三方代码来扩展Burp Suit的功能。

11.Options(设置)——对Burp Suite的一些设置

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?