一、回归的基础概念

现有一些数据点,我们用 一条直线对这些点进行拟合,该线称为最佳拟合直线,这个拟合过程就称作回归。利用Logistic 回归进行分类的主要思想是:根据现有数据对分类边界线建立回归公式,以此进行分类。这里的 “回归”一词源于最佳拟合,表示要找到最佳拟合参数集。 训练分类器时的做法就是寻找最佳拟合参数,使用的是最优化算法。

Logistic回归的一般过程

(1) 收集数据:采用任意方法收集数据。

(2) 准备数据:由于需要进行距离计算,因此要求数据类型为数值型。另外,结构化数据格式则最佳。

(3) 分析数据:采用任意方法对数据进行分析。

(4) 训练算法:大部分时间将用于训练,训练的目的是为了找到最佳的分类回归系数。

(5) 测试算法:一旦训练步骤完成,分类将会很快。

(6) 使用算法:首先,我们需要输入一些数据,并将其转换成对应的结构化数值; 接着,基于训练好的回归系数就可以对这些数值进行简单的回归计算,判定它们属于哪个类别;在这之后,我们就可以在输出的类别上做一些其他分析工作。

二、基于Logistic回归和Sigmoid函数的分类

- 优点:计算代价不高,易于理解和实现。

- 缺点:容易欠拟合,分类精度可能不高。

- 适用数据类型:数值型和标称型数据。

Logistic回归来做分类问题,我们想要的函数应该是,能接受所有的输入然后预测出类别。例如,在两个类的情况下,上述函数输出0或1。例如海维塞德阶跃函数 (Heaviside step function),也称为单位阶跃函数。

海维塞德阶跃函数的问题在于: 该函数在跳跃点上从0瞬间跳跃到1(不连续、不可微),这个瞬间跳跃过程有时很难处理。但是在数学上,Sigmoid函数可以可以解决这个问题。Sigmoid函数具体的计算公式如下:

下图给出了Sigmoid函数在不同坐标尺度下的两条曲线图。当x为0时,Sigmoid函数值为0.5。 随着x的增大,对应的Sigmoid值将逼近于1;而随着x的减小,Sigmoid值将逼近于0。如果横坐标 刻度足够大,Sigmoid函数看起来很像一个阶跃函数。

所以,为了实现Logistic回归分类,我们可以在每个特征上都乘以一个回归系数,然后把 所有的结果值相加,将这个总和代入Sigmoid函数中,进而得到一个范围在0~1之间的数值。任何大于0.5的数据被分入1类,小于0.5即被归入0类。所以,Logistic回归也可以被看成是一种概率估计。

预测值与输出标记: ![]()

其中Sigmoid函数的输入值为z、向量x是分类器的输入数据,向量w是找到的最佳系数,b为常数。

运用Sigmoid函数:

对数几率(log odds):样本作为正例的相对可能性的对数 ![]()

![]()

因此有:

上面两个式子分别表示y=1和y=0的概率。通过![]() ,我们获得z值,再通过Sigmoid函数把z值映射到0~1之间,获得数值之后就可进行分类。比如定义,大于0.5的分类为1,反之,即分类为0。所以我们要解决的问题就是获得最佳回归系数,即求解w和b得值。

,我们获得z值,再通过Sigmoid函数把z值映射到0~1之间,获得数值之后就可进行分类。比如定义,大于0.5的分类为1,反之,即分类为0。所以我们要解决的问题就是获得最佳回归系数,即求解w和b得值。

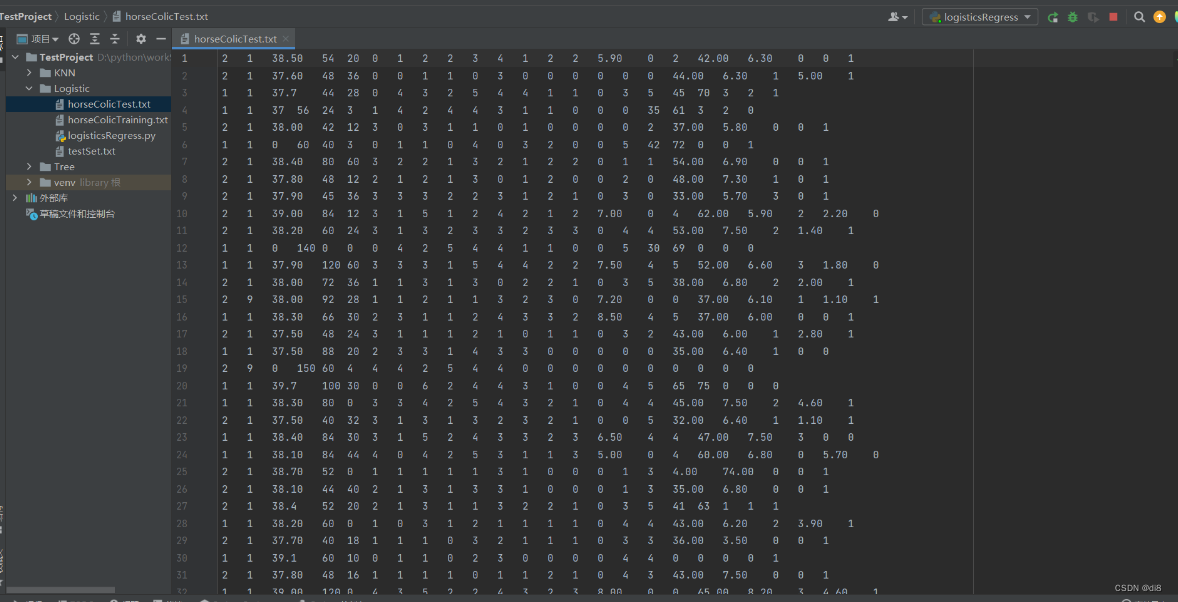

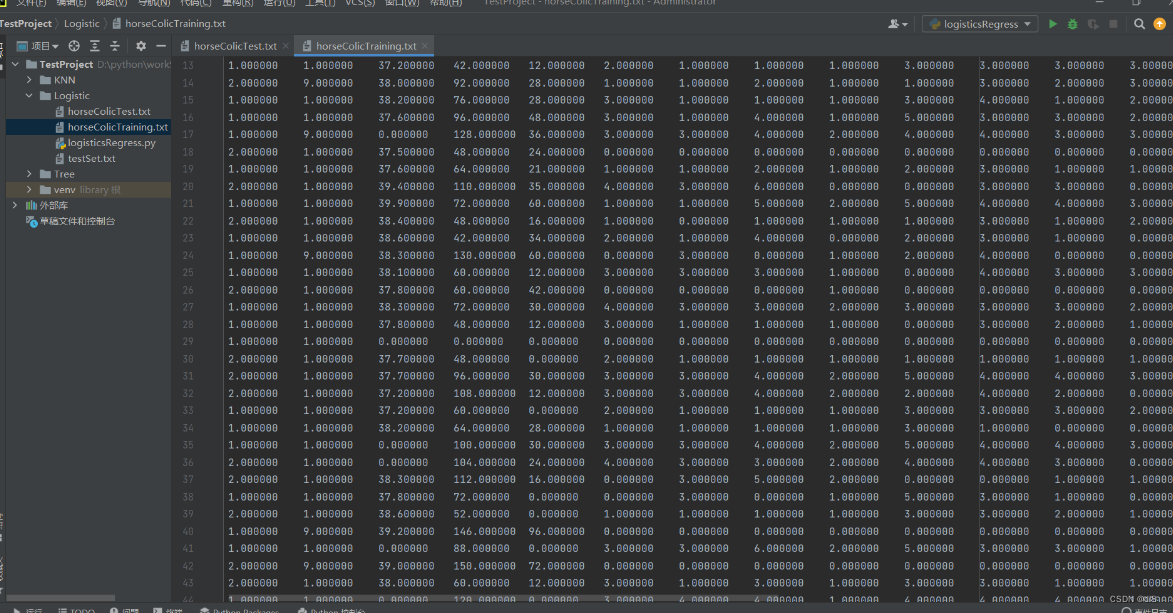

实例:从疝气病症状预测病马的死亡率

使用 Logistic 回归来预测患有疝病的马的存活问题。疝病是描述马胃肠痛的术语。然而,这种病不一定源自马的胃肠问题,其他问题也可能引发马疝病。这个数据集中包含了医院检测马疝病的一些指标,有的指标比较主观,有的指标难以测量,例如马的疼痛级别。

1、准备数据:处理数据中的缺失值

病马的训练数据,如下形式存储在文本文件中:

2、测试算法:使用梯度上升算法进行分类

# 分类函数

def classifyVector(inX, weights):

prob = sigmoid(sum(inX * weights)) # 计算sigmoid值

if prob > 0.5: # 概率大于0.5,返回分类结果1.0

return 1.0

else: # 概率小于等于0.5,返回分类结果0.0

return 0.0def colicTest1():

# 读取测试集和训练集,并对数据进行格式化处理

frTrain = open('horseColicTraining.txt') # 读取训练集文件

frTest = open('horseColicTest.txt') # 读取测试集文件

trainingSet = [] # 创建数据列表

trainingLabels = [] # 创建标签列表

for line in frTrain.readlines(): # 按行读取

currLine = line.strip().split('\t') # 分隔

lineArr = []

for i in range(21):

lineArr.append(float(currLine[i]))

trainingSet.append(lineArr)

trainingLabels.append(float(currLine[21]))

# 使用改进的随即上升梯度训练

trainWeights = gradAscent(array(trainingSet), trainingLabels)

errorCount = 0 # 错误数

numTestVec = 0.0

for line in frTest.readlines(): # 遍历每行数据

numTestVec += 1.0 # 测试集数量加1

currLine = line.strip().split('\t')

lineArr = []

for i in range(21):

lineArr.append(float(currLine[i]))

if int(classifyVector(array(lineArr), trainWeights)) != int(currLine[21]):

errorCount += 1 # 预测结果与真值不一致,错误数加1

errorRate = (float(errorCount) / numTestVec) # 计算错误率

print("测试的错误率为: %f" % errorRate)

return errorRate# 求结果的平均值

def multiTest():

numTests = 10

errorSum = 0.0

for k in range(numTests):

errorSum += colicTest1()

print("在 %d 迭代之后, 平均错误率为: %f" % (numTests, errorSum / float(numTests)))测试结果:

从上面的结果可以看到,10次迭代之后的平均错误率为28%。

3、测试算法:使用改进后的随机梯度上升算法进行分类

使用Logistic 回归方法进行分类并不需要做很多工作,所需做的只是把测试集上每个特征向量乘以最优化方法得来的回归系数,再将该乘积结果求和,最后输入到Sigmoid函数中即可。如果对应的Sigmoid值大于0.5就预测类别标签为1,否则为0。

# 分类函数

def classifyVector(inX, weights):

prob = sigmoid(sum(inX * weights)) # 计算sigmoid值

if prob > 0.5: # 概率大于0.5,返回分类结果1.0

return 1.0

else: # 概率小于等于0.5,返回分类结果0.0

return 0.0# 基于改进后的随机梯度上升算法的Logistic分类器

def colicTest():

# 读取测试集和训练集,并对数据进行格式化处理

frTrain = open('horseColicTraining.txt') # 读取训练集文件

frTest = open('horseColicTest.txt') # 读取测试集文件

trainingSet = [] # 创建数据列表

trainingLabels = [] # 创建标签列表

for line in frTrain.readlines(): # 按行读取

currLine = line.strip().split('\t') # 分隔

lineArr = []

for i in range(21):

lineArr.append(float(currLine[i]))

trainingSet.append(lineArr)

trainingLabels.append(float(currLine[21]))

# 使用改进的随即上升梯度训练

trainWeights = stocGradAscent1(array(trainingSet), trainingLabels, 1000)

errorCount = 0 # 错误数

numTestVec = 0.0

for line in frTest.readlines(): # 遍历每行数据

numTestVec += 1.0 # 测试集数量加1

currLine = line.strip().split('\t')

lineArr = []

for i in range(21):

lineArr.append(float(currLine[i]))

if int(classifyVector(array(lineArr), trainWeights)) != int(currLine[21]):

errorCount += 1 # 预测结果与真值不一致,错误数加1

errorRate = (float(errorCount) / numTestVec) # 计算错误率

print("测试的错误率为: %f" % errorRate)

return errorRate# 求结果的平均值

def multiTest():

numTests = 10

errorSum = 0.0

for k in range(numTests):

errorSum += colicTest()

print("在 %d 迭代之后, 平均错误率为: %f" % (numTests, errorSum / float(numTests)))测试结果:

总结

梯度上升算法:每次更新回归系数所有样本都参与。

优点:分类准确,获取全局最优解

缺点:当样本比较多时,训练速度特别慢

适用场合:样本较少的数据集

随机梯度下降法:每次更新回归系数只有一个样本参与。

优点:训练速度很快

缺点:准确率会降低,并不是朝着整体最优方向进行,容易获取到局部最优解

适用场合:样本非常多的数据集

2903

2903

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?