YOLOv11全网最新创新点改进系列:将 LDConv 融合于 YOLOv11,突破卷积操作的极限,提升目标检测精度与效率,让智能视觉更具灵活性与强大性能!

所有改进代码均经过实验测试跑通!截止发稿时YOLOv11已改进50+!自己排列组合2-4种后,考虑位置不同后可排列组合上千万种!改进不重样!!专注AI学术,关注B站up主:Ai学术叫叫兽!

购买相关资料后畅享一对一答疑!

详细的改进教程以及源码,戳这!戳这!!戳这!!!B站:AI学术叫叫兽 源码在相簿的链接中,动态中也有链接,感谢支持!祝科研遥遥领先!

好的!这是一篇学术文章,内容涉及深度学习和卷积神经网络的改进方法。全文较长,为了方便,我建议分段翻译。以下是文章的开头部分翻译:

LDConv: 用于改进卷积神经网络的线性可变形卷积**

作者:Xin Zhang、Yingze Song、Tingting Song(通讯作者)、Degang Yang、Yichen Ye 和 Liming Zhang

所属机构:重庆师范大学计算机与信息科学学院等。

摘要

基于卷积操作的神经网络在深度学习领域取得了显著成果,但标准卷积操作存在两个固有缺陷。一方面,卷积操作局限于局部窗口,因此无法捕捉其他位置的信息,且其采样形状是固定的。另一方面,卷积核的大小固定为 (k \times k) 的正方形,参数数量随着大小的平方增长。尽管可变形卷积(Deformable Conv)解决了标准卷积固定采样的问题,但其参数数量仍呈平方增长,且未探索不同初始采样形状对网络性能的影响。

针对上述问题,本文提出了线性可变形卷积(Linear Deformable Convolution,简称 LDConv)。LDConv 赋予卷积核任意数量的参数和采样形状,为网络开销与性能的平衡提供了更丰富的选择。在 LDConv 中,定义了一种新型坐标生成算法,用于生成任意大小卷积核的不同初始采样位置。为适应目标变化,加入了偏移量(offsets),以调整每个位置的采样形状。LDConv 将标准卷积和可变形卷积参数数量的平方增长趋势改为线性增长。相比于可变形卷积,LDConv 提供了更丰富的选择,并在参数数量等于 (k^2) 时可等效于可变形卷积。此外,本文还探索了在相同卷积核大小下使用不同初始采样形状的神经网络性能。通过不规则卷积操作完成高效特征提取,LDConv 为卷积采样形状提供了更多探索选项。

在 COCO2017、VOC 7+12 和 VisDrone-DET2021 数据集上的目标检测实验充分证明了 LDConv 的优势。LDConv 是一种即插即用的卷积操作,可替代标准卷积以提高网络性能。相关代码可在 GitHub 获取。

1. 引言

卷积神经网络(CNN)如 ResNet [1]、DenseNet [2] 和 YOLO [3] 等,在多个应用领域表现出了卓越的性能,并推动了现代社会技术的进步。这些成功的网络在从自动驾驶汽车中的图像识别 [4]、医学图像分析 [5] 到智能监控 [6] 和个性化推荐系统 [7] 等各个领域中,已经变得不可或缺。它们的成功依赖于卷积操作,这些操作有效地提取图像中的局部特征,并确保模型的复杂性。

尽管 CNN 在分类 [8]、目标检测 [9]、语义分割 [10] 等任务上取得了许多成功,但它们仍然存在一些局限性。其中最显著的局限性之一就是卷积采样形状和大小的选择。标准的卷积操作通常依赖于固定大小的正方形卷积核,如 1×1、3×3、5×5 和 7×7 等。传统卷积核的采样位置是固定的,不能根据目标的变化进行动态调整。可变形卷积(Deformable Conv)通过使用偏移量灵活地调整卷积核的采样形状,以适应目标的变化。例如,在 [13-15] 中,这些工作利用可变形卷积对齐特征。Zhao 等人 [16] 通过将可变形卷积添加到 YOLOv4 [17] 中,增强了对死鱼的检测性能。Yang 等人 [18] 将可变形卷积引入 YOLOv8 [19],提高了对牛的检测性能。Li 等人 [20] 将可变形卷积引入深度图像压缩任务 [21, 22],以获得内容自适应的感受野。尽管上述研究展示了可变形卷积的优越性,但它仍然不够灵活。可变形卷积只能定义 (k \times k) 的卷积操作来提取特征,即其参数数量为 1、4、9、16、25 等等。实际上,可变形卷积需要通过坐标重采样特征,然后通过常规卷积操作提取特征。因此,可变形卷积的参数数量呈平方增长,这使得重采样和卷积特征提取过程的计算和内存开销难以控制。

在处理图像时,可能需要应用更大尺寸的可变形卷积来提取信息。例如,5×5 的可变形卷积调整为 6×6 的卷积核,其参数数量直接从 25 增长到 36。这种突变可能导致设备内存不足。因此,可变形卷积中参数数量平方增长的趋势缺乏灵活性,不适合硬件环境,忽略了像 3、5、7、8、10、11、12 等参数数量的卷积操作。此外,可变形卷积没有探索不同初始采样形状对网络性能的影响。

为了应对上述问题,本文提出了灵活的线性可变形卷积(LDConv)。LDConv 能够灵活地调整卷积核参数的数量,以适应目标形状的变化。与标准卷积不同,LDConv 是一种新型卷积操作,可以使用任意数量的参数(例如 1、2、3、4、5、6、7 等)来提取特征,这在标准卷积或可变形卷积中是无法实现的。LDConv 可以轻松地替换网络中的标准卷积操作,以提高网络性能。重要的是,LDConv 允许卷积核参数的数量呈线性增长或减少,这对于硬件环境非常有利,也可以作为轻量级模型的替代方案,从而减少参数数量和计算开销。其次,当资源充足时,它还提供了更大尺寸卷积核的选择,以增强网络性能。常规卷积核使得参数数量呈平方增长趋势,而 LDConv 仅表现为线性增长趋势,并为卷积核提供了更多的选择。此外,LDConv 的思想可以扩展到特定领域,因为可以根据先验知识为卷积操作创建特定的采样形状,然后通过偏移量动态自适应地适应目标形状的变化。与此同时,LDConv 可以轻松地添加到一些新的卷积模块中,以增强其性能,例如 FasterBlock [23] 和 GSBottleneck [24]。在代表性数据集 VOC [25]、COCO2017 [26] 和 VisDrone-DET2021 [27] 上进行的目标检测实验充分展示了 LDConv 的优势。

综上所述,我们的贡献如下:

- 对不同大小的卷积核,提出了一种算法,用于为任意大小的卷积核生成初始采样坐标。

- 为适应目标的不同变化,利用偏移量调整不规则卷积核的采样位置。同时,探索了三种提取不规则卷积核特征的方法。

- 与常规卷积核相比,提出的 LDConv 实现了不规则卷积核提取特征的功能,为各种变化目标提供了任意采样形状和大小的卷积核,弥补了常规卷积的不足。

- 将 LDConv 的相应大小替换到 FasterBlock 和 GSBottleneck 中,以提高两个模块的性能。

好的,继续翻译接下来的部分:

2. 相关工作

近年来,许多研究从不同角度考虑并分析了标准卷积操作,并设计了新的卷积操作以提升网络性能。

Li 等人 [28] 认为卷积核在所有空间位置共享参数,这导致了在不同空间位置上的建模能力有限,且不能有效捕捉空间长程关系。此外,为每个输出通道使用不同的卷积核实际上并不高效。为了解决这些问题,他们提出了 Involution 操作,该操作通过反转卷积操作的特征来提高网络性能。Qi 等人 [29] 提出了基于可变形卷积的 DSConv。可变形卷积中通过学习得到的偏移量是自由的,这导致模型丢失了部分精细结构特征。这对细长管状结构分割任务构成了挑战,因此他们提出了 DSConv。Zhang 等人 [30] 从新角度理解了空间注意力机制,认为空间注意力机制本质上解决了卷积操作的参数共享问题。然而,一些空间注意力机制,如 CBAM [31] 和 CA [32],并没有完全解决大尺寸卷积核的参数共享问题。因此,他们提出了 RFAConv。Chen 等人 [33] 提出了 Dynamic Conv。与每一层使用一个卷积核不同,Dynamic Conv 基于注意力机制动态聚合多个并行的卷积核,提供了更强的特征表达能力。Tan 等人 [34] 认为卷积核大小在 CNN 中通常被忽视,这可能影响网络的精度和效率。其次,单纯的逐层卷积并没有充分发挥卷积网络的潜力,因此他们提出了 MixConv,在单次卷积中自然混合多个卷积核大小,从而提高网络性能。

为了应对传统序列数据处理中的局限性,Romero 等人 [36] 提出了 CKConv,这一方法通过将卷积核视为一个连续的函数,而不是一系列独立的权重,克服了 CNN 的缺点。CKConv 可以在单次操作中定义任意大的记忆范围,独立于网络的深度、扩展因子或网络大小。在设计卷积神经网络时,选择合适的卷积核大小对模型性能至关重要。传统方法要求在训练前固定卷积核的大小,但在训练过程中动态学习卷积核大小有助于提升网络性能。因此,Romero 等人 [37] 提出了 FlexConv,它能够在训练过程中学习具有可变大小的高带宽卷积核,同时保持固定的参数数量。在 CNN 中,通过增大卷积核的大小可以简单地扩展感受野。然而,卷积核大小与参数数量之间是平方关系,导致训练开销急剧增加,且训练非常困难。因此,为了利用大感受野而避免参数和计算成本,Hassani 等人 [38] 提出了 DCLS 方法,利用两种超参数(卷积核数量和扩展卷积核大小)来控制参数数量,从而实现更大的感受野。CNN 中的卷积核大小设置通常受到限制,通常需要预先设定卷积核的大小,使得超参数调优变得繁琐。因此,Pintea 等人 [39] 提出了 N-JetNet,通过使用尺度空间理论来获得卷积核的自相似参数化。

尽管这些方法在提升卷积操作性能方面做出了贡献,但一些工作仍然局限于常规卷积操作,并未支持多样化的卷积采样形状。其他方法虽然支持卷积核的灵活调整,但网络性能仍然未能达到最优。相比之下,LDConv 通过使用任意数量的参数和采样形状的卷积核高效提取特征,能够在网络中实现良好的性能。

3. 方法

3.1 定义初始采样位置

基于卷积操作的卷积神经网络通过常规采样网格在相应位置定位特征。在 [11, 35, 40] 中,为 3×3 卷积操作给出了常规采样网格。设 (R) 表示采样网格,则 (R) 如下所示:

[

R = {(-1, -1), (-1, 0), …, (0, 1), (1, 1)}

]

然而,由于可变形卷积和这些工作中的采样坐标是规则的,因此不能通过不规则卷积高效地提取特征。而 LDConv 的目标是支持不规则形状的卷积核。因此,为了使不规则卷积核具有采样网格,本文提出了一种算法来生成任意大小卷积的初始采样坐标 (P_n)。

首先生成常规采样网格,然后为剩余的采样点创建不规则采样网格,最后将它们拼接在一起形成整体采样网格。其伪代码如下所示。

算法 1:初始坐标生成的伪代码

# func get_p_n(num_param, dtype)

# num_param: LDConv 的卷积核大小

# dtype: 数据类型

####### function body ########

# 获取用于定义坐标的基整数

base_int = round(math.sqrt(num_param))

row_number = num_param // base_int

mod_numer = num_param % base_int

# 获取常规卷积核的采样坐标

p_n_x, p_n_y = torch.meshgrid(

torch.meshgrid(0, row_number),

torch.meshgrid(0, base_int)

)

# 扁平化常规卷积核的采样坐标

p_n_x = torch.flatten(p_n_x)

P_n_y = torch.flatten(p_n_y)

# 获取不规则卷积核的采样坐标

if mod_number > 0:

mod_p_n_x, mod_p_n_y = torch.meshgrid(

torch.arange(row_number, row_number + 1),

torch.arange(0, mod_number)

)

mod_p_n_x = torch.flatten(mod_p_n_x)

mod_p_n_y = torch.flatten(mod_p_n_y)

P_n_x, p_n_y = torch.cat((p_n_x, mod_p_n_x)), torch.cat((p_n_y, mod_p_n_y))

# 获取完整的采样坐标

p_n = torch.cat([p_n_x, p_n_y], 0)

p_n = p_n.view(1, 2 * num_param, 1, 1).type(dtype)

return p_n

如图 1 所示,为任意大小卷积生成初始采样坐标。设置这些卷积核初始采样形状时,需要从两个方面考虑。首先,不同的初始采样形状会影响网络在相同大小下的性能,同时接近正方形的形状有利于偏移量的学习,如后续实验所示。其次,为了方便生成任意卷积核大小的采样形状,图 1 中的采样形状考虑了这两个方面。

好的,继续翻译接下来的部分:

3.2 线性可变形卷积(LDConv)

显然,标准卷积的采样位置是固定的,这导致卷积只能提取局部信息,无法捕捉其他位置的信息。可变形卷积通过学习偏移量来调整采样网格,从而在一定程度上弥补了卷积操作的缺陷。然而,标准卷积和可变形卷积的采样网格都是规则的,它们不允许卷积核具有任意数量的参数。随着卷积核大小的增大,参数数量呈平方增长,这对于硬件环境并不友好。因此,本文提出了一种新型的线性可变形卷积(LDConv)。

如图 2 所示,LDConv 的整体结构被展示出来。通过 LDConv 提取特征的过程可以分为三个步骤。以 (N = 5) 为例,首先,根据 (N) 的大小,通过算法 1 生成初始形状((P_n))。然后,得到原始坐标((P_o + P_n)),这一过程重点在于为具有 (N) 个参数的卷积核生成相应的采样坐标。其次,通过卷积操作获得卷积核的偏移量,偏移量的维度为 ( (B, 2N, H, W) ),然后将偏移量添加到原始坐标中,从而生成新的采样坐标。这一过程的重点是为特征图上的每个位置生成不同的采样形状。最后,通过插值和重采样得到对应位置的特征,并应用相应的卷积操作来提取特征。这个步骤的主要目的是提取对应位置的特征。

通过上述三个步骤,LDConv 可以完成任意大小的卷积操作并提取特征。

LDConv 和可变形卷积的共同点在于,它们都通过偏移量调整初始采样形状。不同的是,LDConv 通过提出的算法生成初始采样坐标,完成具有任意数量参数的不规则卷积特征提取过程。这一点非常重要,因为它将可变形卷积的参数数量的平方增长趋势纠正为线性增长趋势。这为调节网络的参数数量、计算开销和设备内存消耗提供了灵活性。此外,可变形卷积的最后一步卷积操作无法提取与不规则卷积核对应的特征,而 LDConv 通过三种不同的方法有效地提取了这些特征。

LDConv 设计中探索了三种不同的特征提取方法,如图 3 所示:

- 方法一(图 3(a)):通过 Conv3d 将重采样后的特征转换为四维(C, N, H, W),然后使用步幅为 1 的卷积操作提取特征。

- 方法二(图 3(b)):将重采样后的特征堆叠到通道维度(C×N, H, W),然后使用 1×1 的卷积操作来减少维度至(C, H, W)。

- 方法三(图 3©):将重采样后的特征堆叠到行或列维度,使用列卷积或行卷积提取对应不规则采样形状的特征。

以上方法都能够通过对应的卷积操作提取与不规则采样形状对应的特征。LDConv 通过将这些方法结合起来,实现了不规则卷积核特征提取的过程。此外,为了清楚地展示 LDConv 的过程,在图 2 中,在重采样后,卷积大小对应的特征维度放置在第三维中,但在实现代码时,它位于最后一维。

LDConv 能够完美地完成不规则卷积的特征提取,并且能够根据偏移量灵活地调整采样形状,为卷积采样形状的探索提供了更多选项。与标准卷积和可变形卷积不同,LDConv 不受规则卷积核的限制。

3.3 扩展的 LDConv

LDConv 的设计具有创新性,能够实现具有任意形状和采样位置的卷积核的特征提取。即使没有使用可变形卷积中的偏移量,LDConv 仍能实现多种卷积核形状。因为 LDConv 能够重采样初始坐标以呈现多样的变化,如图 4 所示,本文设计了不同初始采样形状的 5 大小卷积。图 4 中仅展示了大小为 5 的一些示例,然而 LDConv 的大小可以是任意的,因此随着大小的增大,LDConv 的初始卷积采样形状变得更加丰富,甚至是无限的。

由于目标形状在不同数据集之间会有所变化,因此设计与采样形状相对应的卷积操作至关重要。LDConv 完美地实现了这一目标,通过为卷积操作设计相应形状的卷积核,可以灵活适应目标的变化。此外,LDConv 还可以像可变形卷积一样,通过添加可学习的偏移量来动态适应目标形状的变化。

图 5 和图 6 展示了 LDConv 被用来替代 FasterBlock 和 GSBottleneck 模块中的卷积操作以提高网络性能和减少计算开销。

4. 实验

为了验证 LDConv 的优势,我们在先进的 YOLOv5 [41]、YOLOv7 [42] 和 YOLOv8 [19] 基础上,进行了丰富的目标检测实验。首先,YOLO 系列算法作为目标检测领域的代表性算法,已广泛应用于多个领域,并取得了良好的检测性能。其次,YOLO 系列网络结构相比其他网络结构更为简单,因此我们可以在不同数据集上进行大量实验,以证明 LDConv 的优势。所有实验均在 RTX 3090 上训练。为了验证 LDConv 的优势,我们在 COCO2017、VOC 7+12 和 VisDrone-DET2021 数据集上分别进行了实验。

4.1 COCO2017 数据集上的目标检测实验

COCO2017 数据集包括训练集(118287 张图像)、验证集(5000 张图像),覆盖 80 个目标类别,已成为计算机视觉研究中的标准数据集,特别是在目标检测领域。我们选择了最先进的 YOLOv5n 和 YOLOv5s 检测器作为基准模型。然后,使用不同大小的 LDConv 替换 YOLOv5n 和 YOLOv5s 的卷积操作。实验细节与 [30] 中的目标检测实验相同。在实验中,除 epoch 和 batch-size 外,其他网络参数均保持默认。我们基于 batch-size 为 32,训练每个模型 300 个 epoch。与以前的工作一致,我们报告 (AP_{50})、(AP_{75})、AP、(AP_S)、(AP_M) 和 (AP_L) 指标。

此外,我们还报告了 YOLOv5n 和 YOLOv5s 在不同大小的 LDConv(5、4、6、7、9、13)下的目标检测结果。如表 1 所示,YOLOv5 的检测精度随着卷积核大小的增大而逐渐提高,同时模型所需的参数数量和计算开销也在增加。表 1 中的时间表示处理一张图像所需的时间(毫秒)。与标准卷积操作相比,LDConv 显著提高了 YOLOv5 在 COCO2017 上的目标检测性能。可以看到,当 LDConv 的大小设置为 5 时,它不仅减少了模型所需的参数数量和计算开销,而且显著提高了 YOLOv5n 的检测精度。其 (AP_{50})、(AP_{75}) 和 AP 均提高了 3 个百分点,表现非常出色。LDConv 改善了基准模型的 (AP_S)、(AP_M) 和 (AP_L),但显然它对大物体的检测精度比小物体和中等物体有显著提高。我们认为,LDConv 使用偏移量更好地适应了大物体的形状。

4.2 VOC 7+12 数据集上的目标检测实验

为了进一步验证我们方法的有效性,我们在 VOC 7+12 数据集上进行了实验。该数据集结合了 VOC2007 和 VOC2012,包含 16551 张训练图像和 4952 张验证图像,涵盖 20 个目标类别。为了测试 LDConv 在不同网络结构中的通用性,我们选择了 YOLOv7-tiny 作为基准模型。由于 YOLOv7 和 YOLOv5 系列有不同的架构,因此可以比较 LDConv 在不同架构下的性能表现。

在 YOLOv7-tiny 中,我们使用不同大小的 LDConv 替代标准卷积操作。替代细节与 [30] 中的工作一致。所有模型的超参数设置与前述实验相同。根据以往的工作,我们展示了 mAP50 和 mAP 指标。如表 2 所示,随着 LDConv 大小的增大,网络的检测精度逐渐提高,同时模型的参数数量和计算需求也随之增大。这些实验进一步证实了 LDConv 的优势。

4.3 VisDrone-DET2021 数据集上的目标检测实验

为了再次验证 LDConv 的强大泛化能力,我们基于 VisDrone-DET2021 数据集进行了相关目标检测实验。VisDrone-DET2021 是一个具有挑战性的无人机图像数据集,拍摄自不同的环境、天气和光照条件。它是中国最大的无人机航拍数据集之一,涵盖了广泛的场景。训练集包含 6471 张图像,验证集包含 548 张图像。

与前述实验相同,我们选择 YOLOv5n 作为基准模型,并使用 LDConv 替换网络中的卷积操作。在实验中,batch-size 设置为 16,以便探索更大的卷积大小,其他超参数与之前一致。我们依然报告 mAP50 和 mAP 指标。如表 3 所示,可以清晰地看到,不同大小的 LDConv 可以作为轻量级选项,减少模型的参数数量和计算开销,同时提高网络性能。在实验中,当 LDConv 的大小设置为 3 时,模型的检测性能相较基准模型有所下降,但对应的参数数量和计算开销却小得多。此外,我们可以逐渐调整 LDConv 的大小,探索网络性能的变化。LDConv 为网络提供了更多的选择。

4.4 比较实验

与可变形卷积 [11] 不同,LDConv 为网络提供了更多的选择,并且弥补了可变形卷积的不足。可变形卷积仅使用常规卷积操作,而 LDConv 可以同时使用常规和不规则卷积操作。当 LDConv 的大小设置为 (k^2) 时,它等同于可变形卷积。此外,DSConv [29] 也使用偏移量来调整采样形状,但其采样形状是针对管状目标设计的,采样形状的变化有限。为了对比 LDConv、可变形卷积和 DSConv 在相同大小下的性能,我们基于 YOLOv5s 在 COCO2017 上进行了实验。

如表 4 所示,当卷积核的参数数量为 9(即标准的 3×3 卷积)时,LDConv 和可变形卷积的性能相同。因为当卷积核大小为常规大小时,LDConv 等同于可变形卷积。然而,如前所述,可变形卷积没有探索不规则卷积核的大小,因此无法实现 5 或 11 参数数量的卷积操作。

在 LDConv 的设计中,我们没有对输入特征实现零填充,但可变形卷积使用了填充。为了公平比较,我们在 LDConv 中也采用了零填充。实验表明,LDConv 中的零填充有助于网络提高性能。

此外,我们基于 VOC 7+12 数据集选择 YOLOv5n 比较 LDConv、DSConv 和可变形卷积。在使用可变形卷积时,为了与 LDConv 公平比较,我们去除了零填充。如表 5 所示,可以看到 LDConv 实现了更好的性能。理论上,当可变形卷积的大小设置为 3 时,其性能应与 LDConv(N=9)相等。然而,可变形卷积在采样时从索引 1 开始,而不是从 0 开始,这导致某些信息丢失。由于 DSConv 设计用于特定的管状形状,其在 COCO2017 和 VOC 7+12 上的检测性能并不显著。

在实现 DSConv 时,Qi 等人 [29] 扩展了行或列的特征,最后通过行卷积或列卷积提取特征,类似于我们的做法。因此,他们的方法也能实现具有参数 2、3、4、5、6、7 等的卷积操作。我们也进行了对比实验,DSConv 没有完成下采样方法,在实验中我们用 LDConv 和 DSConv 替换了 YOLOv5n 中的 3×3 卷积操作。实验结果如表 4 和表 5 所示,LDConv 优于 DSConv,因为 DSConv 并不是为了提高任意大小卷积核的性能而设计的,而是针对特定目标形状进行优化的。相比之下,LDConv 提供了更多卷积核选择的可能性,并有效提高了网络性能。

4.5 基于不同采样形状的探索

如前所述,LDConv 能够通过任意大小和任意采样形状的卷积核提取特征。为了探讨不同初始采样形状对网络性能的影响,我们分别在 COCO2017 和 VisDrone-DET2021 数据集上进行了实验。我们在 COCO2017 上使用 YOLOv8n 进行实验,batch-size 设置为 32,epoch 为 100。在 VisDrone-DET2021 上使用 YOLOv5n 进行实验,batch-size 设置为 16,epoch 为 300,其他超参数保持默认设置。

如表 8 所示,LDConv 仍然能提高网络的检测精度。YOLOv8 和 YOLOv5 的网络结构相似,主要区别在于 C3 和 C2f 的设计。可以看到,在 YOLOv8 中,LDConv 带来的性能提升不如在 YOLOv5 中那么显著。我们认为,YOLOv8 在相同大小下需要更多的参数,因此更多的参数有助于像 LDConv 这样的卷积核提供更好的特征信息。也因此,在 YOLOv8 中加入 LDConv 时,其提升并没有 YOLOv5 显著。

此外,在相同大小下,我们还测试了不同初始采样形状对 COCO2017 网络性能的影响。结果表明,网络的检测精度在不同初始采样坐标下的波动不大。得益于 COCO2017 数据集的庞大数据量,网络能够灵活调整偏移量。然而,这并不意味着在所有初始采样坐标下,网络的检测精度没有显著差异。为进一步探索 LDConv 不同初始形状对网络的影响,我们使用 YOLOv5n 在 VisDrone-DET2021 上进行了实验。如表 9 所示,网络的检测精度随不同初始采样形状的变化而有所不同。因此,对于特定的网络和数据集,探索适合的初始采样形状以提高网络性能是至关重要的。

5. 分析与讨论

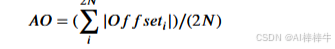

在前面的实验中,我们使用不同初始采样形状的大小为 5 的 LDConv 评估了 YOLOv5n 的性能。可以清晰地看到,在不同初始采样形状下,网络的表现存在差异。这表明偏移量的调整能力是有限的。为了衡量每个给定位置上偏移量的变化,我们定义了平均偏移量(AO),如下所示:

AO(平均偏移量)度量了每个位置采样点的平均变化程度,通过求偏移量的总和,然后取平均值。为了观察偏移量的变化,我们选择了训练后的网络,并选择最后一层 LDConv 来分析偏移量的整体变化趋势。对于分析,我们随机选择了四张 VisDrone-DET2021 的图像,并可视化了大小为 5 的 LDConv 在不同初始采样位置的变化情况。如图 9 所示,我们可视化了偏移量的变化度。图 9 中不同的颜色代表了不同初始采样形状下,偏移量在每个采样位置的变化情况。图 9 中的不同初始采样形状对应于表 9 中的初始形状。可以得出结论,对于图中的蓝色和红色初始采样形状,偏移量变化较小,说明这两种初始采样形状对于该数据集更为适合。正如表 9 中的实验所示,蓝色和红色初始采样形状对应的模型取得了更好的检测精度。

所有实验表明,LDConv 能够显著提高网络性能。与可变形卷积不同,LDConv 可以根据大小灵活扩展网络性能。在所有实验中,我们广泛探索了 LDConv 大小为 5 的效果。因为在 COCO2017 的大数据量下,我们发现当 LDConv 大小为 5 时,训练速度与原模型差异不大。此外,随着 LDConv 大小的增大,训练时间逐渐增加。在 COCO2017、VOC 7+12 和 VisDrone-DET2021 数据集上的实验中,LDConv 大小为 5 时,网络性能表现良好。当然,LDConv 对其他大小的探索仍然是可能的,因为其参数数量呈线性增长,且任意采样形状带来了更多选择的机会。

所有实验表明,LDConv 能够显著提高网络性能。与可变形卷积不同,LDConv 可以根据大小灵活扩展网络性能。在所有实验中,我们广泛探索了 LDConv 大小为 5 的效果。因为在 COCO2017 的大数据量下,我们发现当 LDConv 大小为 5 时,训练速度与原模型差异不大。此外,随着 LDConv 大小的增大,训练时间逐渐增加。在 COCO2017、VOC 7+12 和 VisDrone-DET2021 数据集上的实验中,LDConv 大小为 5 时,网络性能表现良好。当然,LDConv 对其他大小的探索仍然是可能的,因为其参数数量呈线性增长,且任意采样形状带来了更多选择的机会。

6. 结论

显然,在现实生活中以及计算机视觉领域,物体的形状会呈现出各种各样的变化。卷积操作的固定采样形状无法适应这些变化。尽管可变形卷积通过调整偏移量来灵活改变采样形状,但它仍然存在局限性。因此,本文提出了 LDConv,真正实现了使卷积具有任意采样形状和大小,为卷积核的选择提供了多样性。此外,还探索了不同的初始采样形状,并将其应用于 FasterBlock 和 GSBottleneck 中,取得了性能的提升。

尽管本文 的 LDConv 设计了多种采样坐标形状,但 LDConv 的灵活性在于它能够针对任意大小的卷积核提取信息。因此,未来我们将探索针对特定任务设计适当的大小和采样形状,为后续任务提供动力。

写在最后

学术因方向、个人实验和写作能力以及具体创新内容的不同而无法做到一通百通,所以本文作者即B站Up主:Ai学术叫叫兽

在所有B站资料中留下联系方式以便在科研之余为家人们答疑解惑,本up主获得过国奖,发表多篇SCI,擅长目标检测领域,拥有多项竞赛经历,拥有软件著作权,核心期刊等经历。因为经历过所以更懂小白的痛苦!因为经历过所以更具有指向性的指导!

祝所有科研工作者都能够在自己的领域上更上一层楼!!!

838

838

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?