!!!更好的阅读体验!!!

ResNet网络结构

亮点

- 超深

- residual模块

- 使用Batch Normalization加速训练,不需要使用dropout

残差结构有效解决了梯度消失/爆炸、退化问题

residual结构

重点:

-

1X1卷积层作用是改变通道数

-

右边的方法有效减少了参数

重点:

- 注意stride和通道数的变化

- 注意虚线部分的作用:改变深度和特征矩阵长宽

BN

目的:使得一批(Batch)数据的特征矩阵每个维度满足均值为0,方差为1。(还有 γ β \gamma \quad \beta γβ)

对象:一批数据,某一个通道的所有特征矩阵

注意:

-

训练时,traning:True 验证时:traning:False

-

Batch size 越大越好

-

bn层建议放在卷积层后,卷积不要使用bias (没用)

-

μ σ 2 \mu \quad \sigma^{2} μσ2在正向传播过程中统计得到

-

γ β \gamma \quad \beta γβ在反向传播过程中训练得到

迁移学习

好处:

- 快

- 数据集小也可以有好效果

- 注意:用别人的预处理方法

常见方式:

- 载入后训练所有参数,不固定

- 固定前面参数,只训练最后几层

- 固定所有参数,额外添加全连接层

ResNeXt网络结构

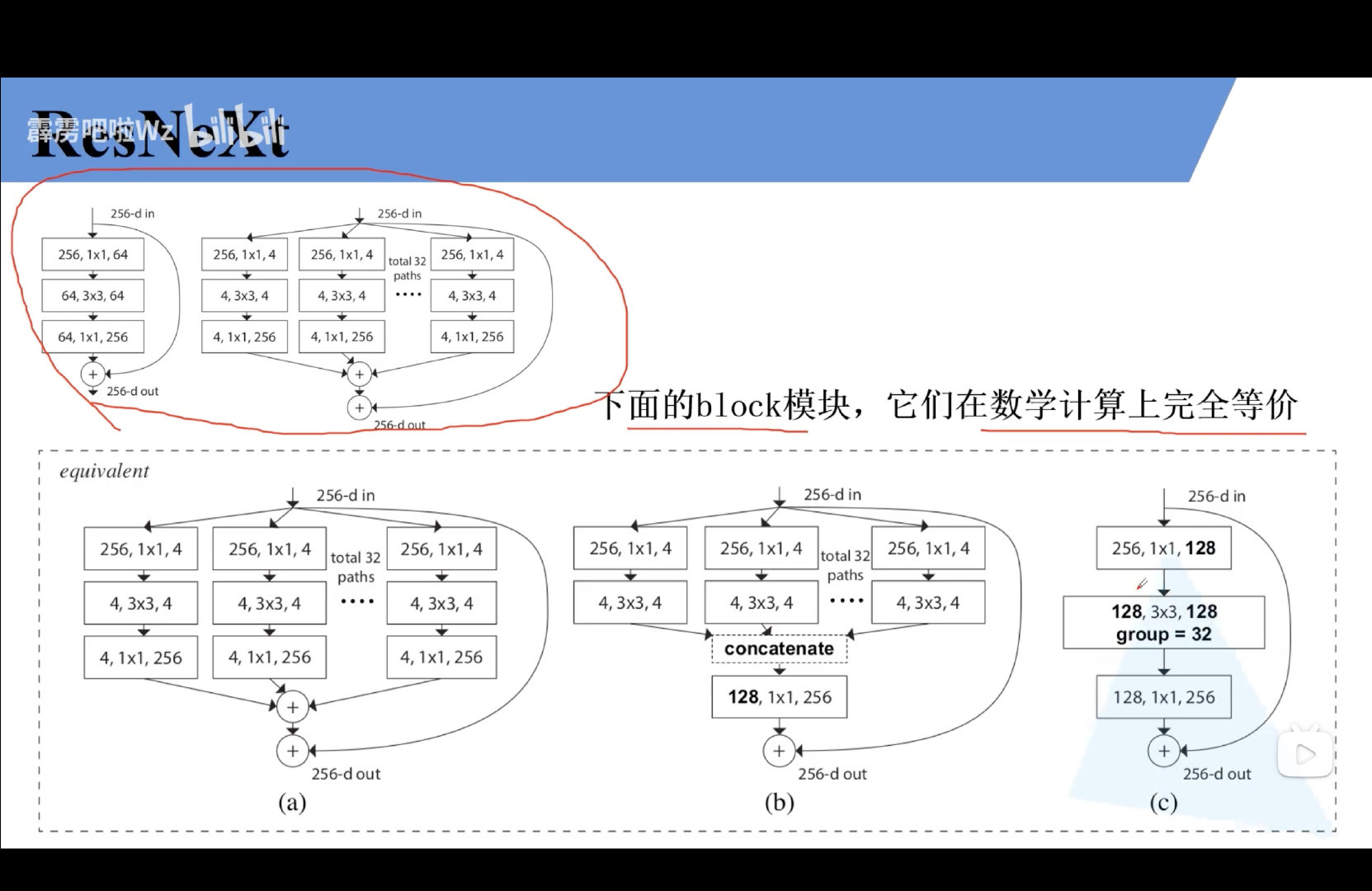

对ResNet的升级:更新了block

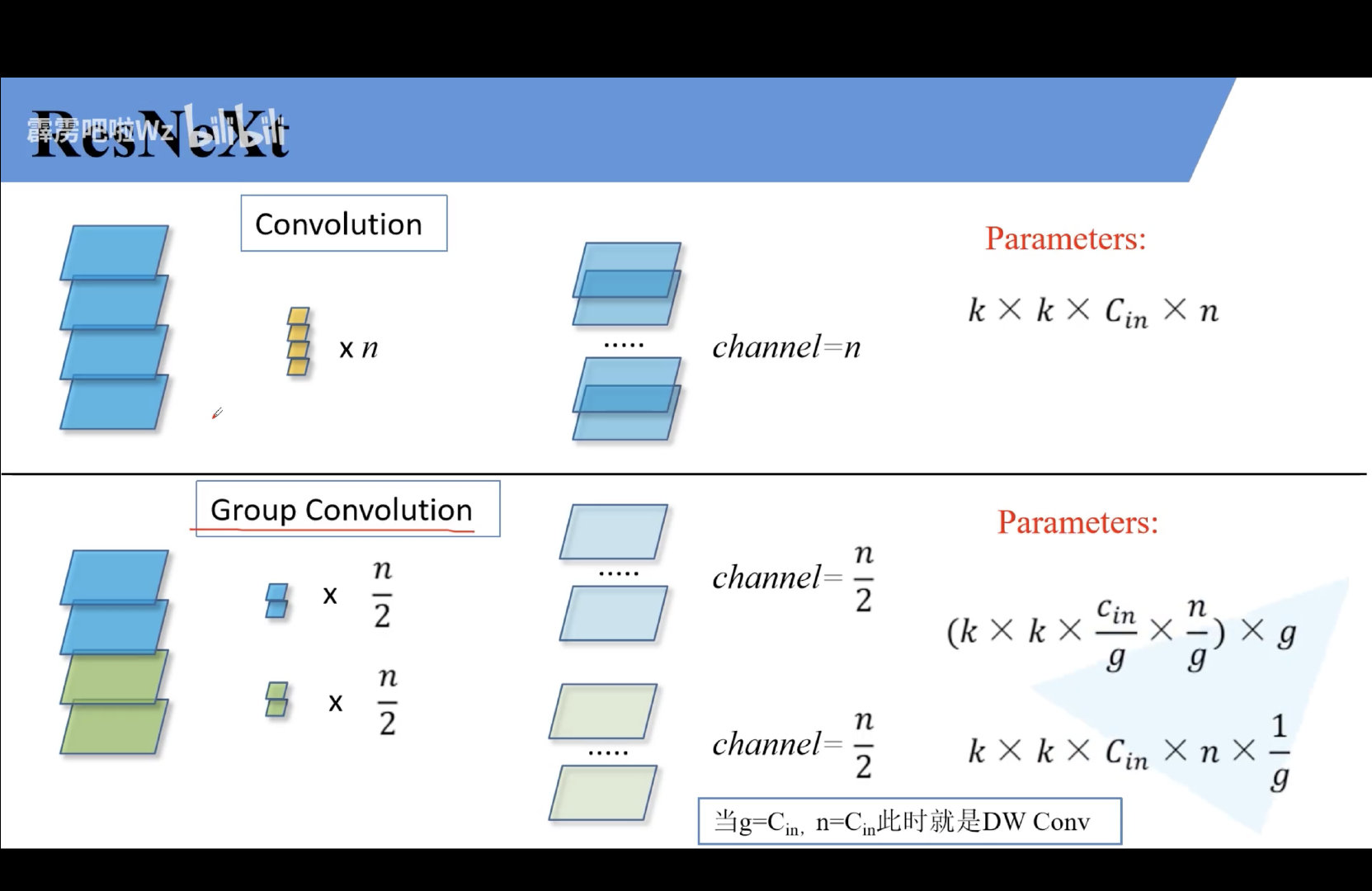

Group Convolution(组卷积)

block

本文详细介绍了ResNet网络结构,其亮点在于超深网络和residual模块,有效解决了梯度消失和退化问题。1X1卷积用于调整通道数,批量归一化(BN)加速训练。ResNeXt作为ResNet的升级版,引入了组卷积,进一步优化了网络性能。迁移学习在此类网络中发挥重要作用,可以快速获取好效果,常用策略包括全部参数训练、部分层微调等。

本文详细介绍了ResNet网络结构,其亮点在于超深网络和residual模块,有效解决了梯度消失和退化问题。1X1卷积用于调整通道数,批量归一化(BN)加速训练。ResNeXt作为ResNet的升级版,引入了组卷积,进一步优化了网络性能。迁移学习在此类网络中发挥重要作用,可以快速获取好效果,常用策略包括全部参数训练、部分层微调等。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?