deepseek 本地化部署

DeepSeek作为国内目前最火的AI技术,相信许多互联网爱好者都有所了解,大家可以通过DeepSeek官网进行体验访问,不过比较纠结的是大家估计都遇到过访问超时的情况。

如何可以流畅的体验呢,当然最好的方式是本地部署DeepSeek-R1模型,这样就不用担心访问超时的情况了。

这里基于Win10操作系统来本地部署DeepSeek-R1大模型,感兴趣的一起来看看吧!

一、安装ollama

要运行deepSeek-r1前提先要安装一个能运行大模型的工具,这里选择ollama。

ollama目前是github最火的大模型运行工具,如果本地需要部署大模型的话,ollama是首选的运行工具。

官网:https://ollama.com/

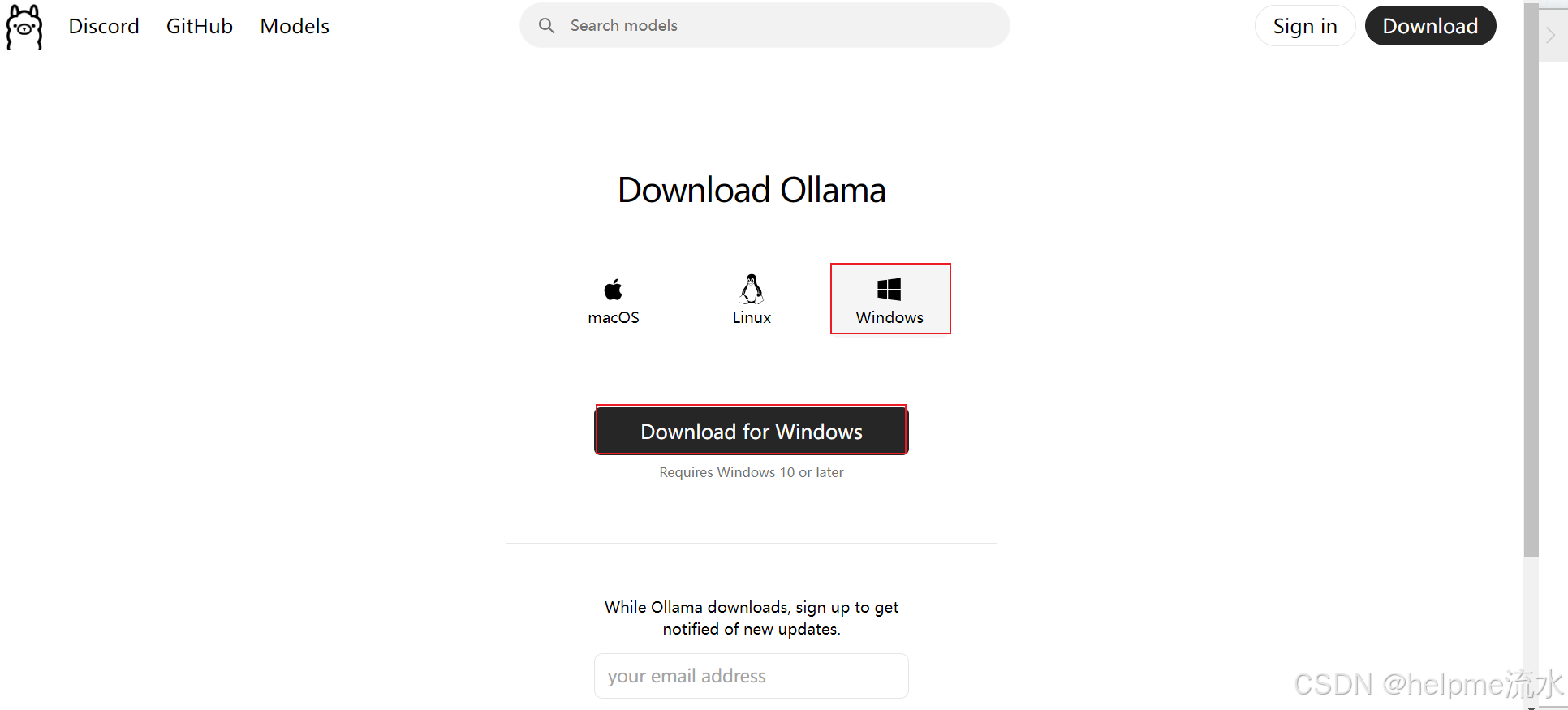

进入官网后,点击下载按钮进入下载页面

这里选择Windows操作系统,需要Win10及以上版本的操作系统。然后点击下载。

安装包体积745.4M下载会非常缓慢,大家可以从文章末尾获取下载地址。ollama下载完成后进行安装。

双击exe安装程序进入安装界面。

点击Install,进入安装过程,如下图:

直到安装完成即可。

二、安装DeepSeek-R1模型

运行ollama 打开PowerShell命令行窗口:

因为是个人电脑,本身电脑配置就不高,这样选择最基础的模型参数1.5B来进行安装。安装方式直接采用命令行控制台直接进行安装。具体命令如下:

ollama run deepseek-r1:1.5b安装过程如下图:

安装过程需要下载资源包,大家需要耐心等待。安装成功出现“success”字样,具体如下图:

查看安装成功的模型,执行如下命令:

ollama list

注意:cmd和Powershel命令行窗口需要使用管理员运行,否则可能报错

三、控制台运行测试

直接使用控制台进行对话,效果如下:

说明:因为是最基础的1.5B模型,对话问题的范围和准确性还是有待于提高的。不过整体相应速度还是可以的。对话效果如图:

四、通过cherry客户端运行

进入官网进行下载:

双击进行安装:安装完如下图进行操作

点击完管理:如下

模型处出现了本地1.5b模型

关闭页面。打开对话框,选择咱们自己的1.5b参数模型。则可以开始对话了。如下:

五、优化

以上操作就实现了自己访问本机的模型来进行对话:

如果本机模型对外提供服务则还需以下配置:

要更改 Ollama 服务的监听地址,使其接受来自网络的连接,您可以通过设置环境变量来实现。以下是在 Windows 系统中进行配置的步骤:

1. 退出正在运行的 Ollama 程序:

• 在任务栏找到 Ollama 图标,右键点击并选择退出。

2. 设置环境变量:

• 按下 Win + X,选择“系统”,然后点击“高级系统设置”。

• 在“系统属性”窗口中,点击“环境变量”。

• 在“用户变量”或“系统变量”中,点击“新建”,添加以下变量:

• 变量名: OLLAMA_HOST

• 变量值: 0.0.0.0:11434

• 如果需要允许来自任何来源的 HTTP 请求,还可以添加:

• 变量名: OLLAMA_ORIGINS

• 变量值: *

• 点击“确定”保存设置。

3. 重启 Ollama 服务:

重新打开应用程序Ollama

请注意,修改监听地址后,可能需要在 Windows 防火墙中开放相应的端口,以允许外部设备访问。

通过上述步骤,您可以成功地更改 Ollama 的监听地址,使其接受来自网络的连接。

本机下载多个参数模型:

如之前配置,将localhost配置成服务端地址: 然后重新管理加载模型

开启对话就可以选到了:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?