一、腾讯云网络

1.1 腾讯云网络

腾讯云云网络的系统性技术解析,涵盖架构设计、节点部署、协议标准及硬件优化等关键领域:

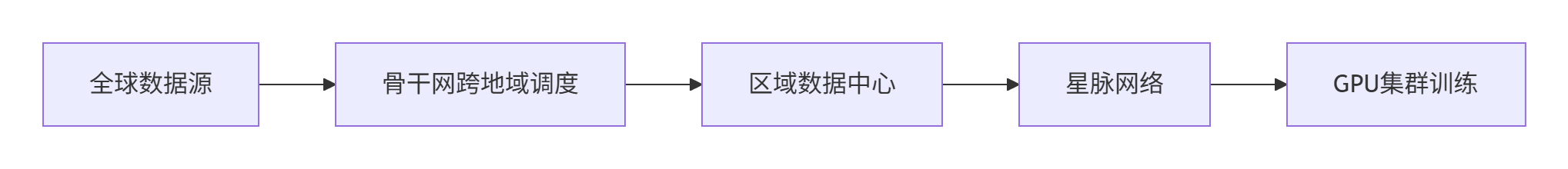

1.1.1、整体领域架构

腾讯云采用分层融合架构,结合虚拟化与物理网络优势:

- 资源隔离层

- 基于cgroup实现CPU/内存/网络隔离,通过net_cls+tc流量控制限制容器带宽,net_prio保障高优先级任务低延迟。

- 主机网络层

- DPDK加速:用户态轮询模式(PMD)配合大页内存,转发性能达450万PPS(较内核协议栈提升10倍)。

- 智能网卡:SR-IOV虚拟化实现VF直通,硬件卸载VXLAN/IPsec加密,CPU开销降低50%。

- 容器网络层

模式 原理 延迟 适用场景 VPC-CNI 弹性网卡直通Pod <10μs AI训练(支持RDMA 3.2T带宽) Global-Route BGP同步路由 较Overlay低20% 成本敏感型业务 Cilium-Overlay VXLAN隧道封装 增加50字节开销 混合云跨域互通 - 全球互联层

- 星脉网络:多轨道流量调度(85%流量在ToR交换机完成)+ 自研Tita端网协同协议,网络利用率>90%。

- 云联网(CCN):连接全球VPC、IDC及边缘节点,支持路由自学习和99.99%可用性。

1.1.2、节点与区域选择策略

- 节点布局

- 国内:20+可用区覆盖北上广等核心枢纽,上海/南京双节点满足金融低时延,广州服务跨境电商。

- 海外:15地域覆盖三大矩阵(亚太/欧洲/北美),新加坡节点实现东南亚200ms内覆盖,法兰克福符合GDPR标准。

- 选型原则

- 延迟敏感型(如游戏/高频交易):用户就近接入,BGP多线保障<50ms。

- 合规要求:政务数据选北京专区,欧盟业务部署法兰克福节点。

1.1.3、核心协议与算法机制

- 智能路由算法

- 动态选路:基于实时延迟矩阵计算最优路径:

Pathoptimal=pathiargmin(α⋅Latency+β⋅PacketLoss)

跨洲延迟从300ms降至80ms。 - SRv6优化:替代传统MPLS,通过源路由减少标签交换层级,跨域传输延迟降低60%,吞吐量提升20%。

- 动态选路:基于实时延迟矩阵计算最优路径:

- 拥塞控制

- Tita协议:动态调整发送窗口:

Wnew=Wcurrent×CurrentDelayTargetDelay

网络利用率从60%提升至90%+。

- Tita协议:动态调整发送窗口:

- 安全协议

- 传输层:MACsec(L2)/IPsec(L3)加密,金融场景启用AES-256-GCM。

- 应用层:国密SM4(中国)、FIPS 140-2(欧美)合规。

1.1.4、硬件与电子电路优化

- 芯片选型

- AI训练:NVIDIA A100 GPU(GN10X实例)支持千亿参数模型并行训练。

- 智能网卡:硬件卸载VXLAN封装/IPsec加密,吞吐量达20Gbps。

- 电路设计

- DPDK加速:通过轮询模式消除中断开销,大页内存减少TLB Miss,延迟降低30%。

- vhost-user协议:VM与vSwitch共享内存通信,替代TCP/IP栈减少拷贝次数。

1.1.5、应用场景与架构匹配

| 场景 | 架构方案 | 关键技术 |

|---|---|---|

| AI训练 | VPC-CNI + 星脉网络 | RDMA 3.2T带宽 + TCCL通信库 |

| 混合云 | CCN + 专线加密 | IPsec隧道(AES-256-GCM) |

| 高频交易 | 快慢路径分离 + eBPF | 转发延迟5μs |

| 全球应用 | Anycast EIP + HTTP/3 | 158边缘节点,QUIC协议降低握手延迟 |

1.1.6、总结

腾讯云网络通过分层解耦设计(资源隔离→全球互联)、软硬协同优化(DPDK/智能网卡)、协议创新(SRv6/Tita)实现高性能与高可靠。选型建议:

- 性能优先:VPC-CNI直通 + SRv6 Policy;

- 成本敏感:Global-Route模式(子网利用率95%+);

- 混合云:CCN云联网 + SD-WAN边缘接入。

注:部分技术细节可进一步查阅腾讯云官方文档或白皮书。

1.2 腾讯云星脉网络中的TiTa(Tencent intelligent Transport adaptation)端网协同协议

腾讯云星脉网络中的TiTa(Tencent intelligent Transport adaptation)端网协同协议通过多层技术创新,实现了90%以上的网络利用率,显著超越传统以太网(通常仅60%左右)。以下是其核心实现机制与技术细节:

1.2.1、主动拥塞控制机制:颠覆传统被动响应

传统TCP/IP协议采用被动拥塞控制(如丢包后降速),而TiTa协议创新性地引入主动式拥塞预测与动态调整:

-

实时网络状态感知

- 网卡在数据发送前主动探测路径状态,通过交换机反馈的队列深度、链路延迟等参数,构建全局网络状态矩阵。

- 微秒级监控能力(自研TCCL通信库支持),实现网络质量动态感知。

-

动态窗口调整算法

- 基于实时延迟与丢包率动态调整发送窗口:

Wnew=Wcurrent×CurrentDelayTargetDelay

该公式确保高负载下仍能保持稳定吞吐量。 - 主动速率限制:当预测到拥塞时,网卡主动降低发包速率,避免拥塞恶化。

- 基于实时延迟与丢包率动态调整发送窗口:

1.2.2、流量整形与负载均衡:消除网络不均匀性

传统网络因流大小差异导致哈希分配不均,TiTa通过以下技术解决:

-

定长包切割技术

- 发送端将数据流切割为统一长度的数据包(如固定512字节),消除大小流差异。

- 交换机对定长包进行等代价多路径路由(ECMP)哈希,实现流量均匀分布。

-

乱序重组优化

- 接收端网卡内置硬件级乱序重组引擎,解决定长包在多路径传输中的乱序问题。

- 结合优先级队列,确保关键数据(如梯度同步)低延迟传输。

1.2.3、多级拓扑优化:支持超大规模组网

针对万卡集群的三级Clos拓扑,TiTa协议进行深度适配:

-

三级拥塞协同控制

- 在核心层交换机部署分布式拥塞状态同步机制,避免局部拥塞扩散。

- 通过交换机-网卡协同调度(如显式拥塞通知ECN扩展),实现端到端控速。

-

拓扑感知路由

- 动态计算最优路径权重:

Pathweight=α⋅Latency+β⋅QueueDepth

优先选择低延迟、低队列深度的路径。

- 动态计算最优路径权重:

1.2.4、硬件协同设计:软硬一体加速

TiTa的高效依赖底层硬件创新:

-

自研智能网卡

- 支持TiTa协议硬件卸载,将拥塞控制、乱序重组等操作从CPU转移至网卡,降低时延40%。

- RDMA over Converged Ethernet(RoCE)优化:结合无损以太网技术,实现零丢包传输。

-

白盒交换机定制

- 交换机支持定长包处理流水线,减少转发延迟。

- 可编程ASIC芯片实现动态路由策略,适应流量变化。

1.2.5、实际效果与对比

| 指标 | 传统以太网 | TiTa协议 | 提升效果 |

|---|---|---|---|

| 网络利用率 | 60%左右 | 90%以上 | 提升50% |

| 训练丢包率 | 0.1%导致50%算力损失 | 0丢包 | 算力零浪费 |

| 通信延迟 | 毫秒级 | 微秒级 | 降低40% |

| 十万卡组网规模 | 不支持 | 支持三级Clos拓扑 | 扩展性突破 |

1.2.6、技术价值与应用场景

- AI大模型训练:在10万卡集群中,TiTa协议将通信占比从50%降至10%,GPU利用率提升40%。

- 成本节约:节省30%~60%的模型训练成本,加速大模型迭代。

- 故障容忍:结合TCCL通信库的动态调度,避免因网络波动导致的训练中断。

总结

TiTa协议通过主动拥塞控制+定长包整形+硬件协同三位一体设计,破解了传统网络在超大规模AI训练中的效率瓶颈。其核心在于:

- 主动预防取代被动响应,从根源避免拥塞;

- 流量标准化实现负载均衡,消除网络不均匀性;

- 软硬协同将算法下沉至硬件,释放CPU算力。

这一创新使腾讯云星脉网络成为支持十万卡GPU集群的“算力高速公路”,为AI大模型时代提供核心网络底座。

1.3 腾讯云星脉网络中的TiTa协议

腾讯云星脉网络中的TiTa协议(Tencent intelligent Transport adaptation) 在动态窗口调整算法上相比传统TCP拥塞控制算法(如BBR/CUBIC)具有显著优势,尤其在超大规模AI训练场景下。以下是核心优势的对比分析:

1.3.1、控制机制的本质差异

-

TiTa:主动预判式调控

- 原理:通过端侧网卡实时感知网络状态(队列深度、链路延迟),在拥塞发生前动态调整发送窗口。窗口调整公式为:

Wnew=Wcurrent×CurrentDelayTargetDelay

该算法基于目标延迟与实际延迟的比值动态缩放窗口,避免拥塞恶化。 - 效果:网络利用率达90%以上,接近理论极限。

- 原理:通过端侧网卡实时感知网络状态(队列深度、链路延迟),在拥塞发生前动态调整发送窗口。窗口调整公式为:

-

传统TCP(BBR/CUBIC):被动响应式控制

- BBR:基于带宽和延迟乘积建模,但依赖历史数据预测,无法实时响应突发流量变化。

- CUBIC:依赖丢包作为拥塞信号,高丢包率下性能断崖式下降。

- 瓶颈:传统算法需等待拥塞发生(如丢包/延迟激增)后才调整,导致网络利用率仅60%左右。

1.3.2、关键性能指标对比

| 指标 | TiTa协议 | BBR/CUBIC | 优势说明 |

|---|---|---|---|

| 网络利用率 | >90% | 60%-80% | 避免空口等待,带宽利用率提升50%+ |

| 拥塞响应速度 | 微秒级(网卡硬件加速) | 毫秒级(内核协议栈处理) | 硬件卸载实现40倍加速 |

| 丢包率 | 接近0(定长包+主动控速) | 0.1%-1%(触发拥塞控制) | 保障AI训练零算力浪费 |

| 大规模扩展性 | 支持10万卡GPU集群 | 千卡级集群性能骤降 | 三级Clos拓扑下无拥塞扩散 |

1.3.3、技术创新点解析

1. 软硬协同架构

- TiTa:

- 智能网卡硬件卸载拥塞控制算法,减少CPU开销40%。

- 结合RDMA over Converged Ethernet(RoCE) 实现零丢包传输。

- 传统TCP:依赖操作系统内核协议栈,高并发时CPU成为瓶颈。

2. 流量整形与负载均衡

- TiTa:

- 定长包切割技术:数据流统一切割为512字节包,消除大/小流差异。

- ECMP多路径哈希:交换机均匀分发流量,避免链路闲置。

- 传统TCP:变长包导致哈希分配不均,部分链路过载。

3. 动态权重路径选择

- TiTa:路径权重公式融合实时延迟与队列深度:

Pathweight=α⋅Latency+β⋅QueueDepth

优先选择低延迟、低拥塞路径。 - 传统TCP:静态路由策略,无法适应突发流量。

1.3.4、场景适配性对比

AI大模型训练(百GB级梯度同步)

- TiTa:

- 万卡集群中通信占比从50%降至10%,GPU利用率提升40%。

- 结合TCCL通信库实现GPU间数据直通(3.2T带宽)。

- BBR/CUBIC:

- 梯度同步时延波动大,导致GPU等待时间占比超30%。

混合云/边缘计算

- TiTa:支持SRv6协议跨域传输,延迟降低60%。

- 传统TCP:跨域路由跳数多,易丢包。

1.3.5、总结:TiTa的颠覆性突破

TiTa协议通过 “主动控制+硬件卸载+流量整形” 三位一体设计,解决了传统TCP在超大规模分布式计算中的根本瓶颈:

- 效率跃迁:网络利用率从60%→90%+,将通信开销压缩至训练总耗时的10%以下。

- 规模突破:支持十万卡集群的稳定通信,传统协议在千卡规模即遇性能墙。

- 成本优化:节省30%~60%的算力资源浪费,加速AI大模型迭代。

选型建议:

- AI训练/高性能计算:必选TiTa+RDMA组合;

- 常规业务:BBR可满足需求,但TiTa在突发流量场景仍有20%以上性能优势。

1.4 分类机制、基础设施分层、产品选型与运维方法

腾讯云云网络采用分层、模块化设计,通过私有网络(VPC)与基础网络的分类体系实现灵活组网,并结合全球基础设施布局、多层级服务产品及智能化运维工具,支撑企业多样化业务场景。以下从分类机制、基础设施分层、产品选型与运维方法三方面详细解析:

1.4.1、云网络分类机制

1. 网络环境分类

- 私有网络(VPC)

- 逻辑隔离:用户可自定义IP网段(如

10.0.0.0/16)、子网划分(如10.0.1.0/24)和路由策略,不同VPC默认内网隔离。 - 功能扩展:支持NAT网关、VPN连接、专线接入(Direct Connect),满足混合云架构需求。

- 逻辑隔离:用户可自定义IP网段(如

- 基础网络(2017年后逐步淘汰)

- 公共资源池:所有用户共享网络资源,无隔离性,仅适用于早期简单业务。

2. 地域与可用区分层

- 地域(Region):全球26个地域(如北京、法兰克福),不同地域间网络完全隔离,需通过公网或云联网(CCN)互通。

- 可用区(Zone):同一地域内电力/网络独立的物理数据中心(如北京一区、北京二区),同地域同VPC下不同可用区默认内网互通,延迟<2ms。

3. 网络服务分层

| 层级 | 核心服务 | 功能说明 |

|---|---|---|

| 基础设施层 | VPC、子网、负载均衡(CLB) | 构建逻辑隔离网络,CLB支持同地域流量分发。 |

| 连接层 | 云联网(CCN)、专线网关 | CCN实现跨地域VPC/IDC互通,自动学习路由,支持带宽限速。 |

| 安全层 | 安全组、网络ACL、DDoS防护 | 安全组实现实例级微隔离,网络ACL控制子网流量。 |

| 加速层 | 全球加速(GA)、内容分发(CDN) | GA优化跨国访问延迟,CDN通过2800+节点加速静态资源。 |

1.4.2、基础设施分层机制

1. 物理层

- 全球节点:覆盖26个地域的1300+边缘节点,基于Anycast网络实现跨洲访问延迟<200ms。

- 硬件架构:

- 第二代Intel Xeon处理器 + NVIDIA Tesla GPU(AI场景)。

- 智能网卡卸载网络协议栈,RDMA网络支持100Gbps吞吐。

2. 虚拟化层

- 资源池化:通过Hypervisor虚拟化技术,将物理服务器分割为弹性云服务器(CVM),支持秒级扩容。

- 存储分离:采用存算分离架构(如TDSQL-C数据库 + COS对象存储),降低存储成本40%。

3. 平台服务层

- 容器网络:TKE容器服务集成VPC-CNI插件,容器直接使用VPC IP,避免NAT性能损耗。

- Serverless网络:云函数(SCF)通过VPC Proxy访问内网资源,无需暴露公网IP。

4. 应用层

- 行业解决方案:

- 电商:结合CLB弹性伸缩 + 天御风控防羊毛党。

- 游戏:GN7实例支持100万级并发连接,GameServer引擎实现全球同服。

1.4.3、产品选型与运维方法

1. 网络产品选型策略

| 场景 | 推荐方案 | 关键指标 |

|---|---|---|

| 跨地域组网 | 云联网(CCN) | 自动路由学习、带宽按需分配。 |

| 混合云连接 | 专线网关 + VPN网关(IPSec加密) | 专线延迟<5ms,带宽1Gbps~100Gbps。 |

| 高并发Web应用 | CLB + 自动伸缩组(SA5实例) | 支持千万级QPS,CPU>70%自动扩容。 |

| 实时音视频传输 | 全球加速(GA) + 100G网络实例 | 端到端延迟<50ms。 |

2. 成本优化方法

- 带宽组合:跨地域CCN带宽采用预付费+后付费混合模式,成本降低30%。

- 实例选型:

- 轻量应用:Lighthouse(4核4G/38元/年)。

- 高性能计算:SA9实例(整机性能提升41%)。

- 存储分级:高频数据存SSD,低频数据转COS归档存储(成本降70%)。

3. 智能运维实践

- 监控体系:

- Cloud Monitor实时监测网络流量、丢包率,自动触发告警。

- 日志服务(CLS)分析API调用链路,定位延迟瓶颈。

- 自动化治理:

- TKE容器服务自动调度Pod至低负载节点。

- 安全组策略自动同步至新扩容实例。

- 灾备设计:

- 跨可用区部署 + CBS快照同步,RPO<15分钟。

- 云联网路由故障600ms内切换至备份路径。

1.4.4、典型场景配置示例

1. 电商大促架构

graph TD

A[用户流量] --> B(腾讯云CDN) --> C(CLB负载均衡)

C --> D[自动伸缩组: SA5 Web集群]

D --> E[内存型M6 Redis]

E --> F[TDSQL-C数据库]

F --> G[COS对象存储]- 风控联动:CLB入口接入微信网关,天御风控拦截刷单请求。

- 成本控制:突发流量使用竞价实例,图片存储启用智能降冷策略。

2. 全球同服游戏

- 网络层:云联网连接硅谷、法兰克福、新加坡节点,BGP优化路由。

- 计算层:GN7实例部署GameServer引擎,支持玩家跨洲匹配。

- 加速层:GA动态选择最优边缘节点,延迟压至50ms内。

1.4.5、安全与合规保障

- 零信任网络:安全组 + 网络ACL实现子网/实例级隔离,KMS管理加密密钥。

- 合规审计:

- 等保三级:专属物理隔离区(如政务云)。

- GDPR合规:字段级动态脱敏 + 访问审计日志。

总结建议

- 网络隔离优先选VPC:避免基础网络限制,自定义路由策略更灵活。

- 全球业务依赖云联网:自动化路由学习简化多地域运维。

- 选型匹配业务特征:

- 计算密集型:SA9/GPU实例;IO密集型:IT5 NVMe本地盘。

- 长尾流量:Lighthouse + Serverless组合降本。

- 运维自动化是关键:结合TKE容器编排 + CLS日志分析,实现故障自愈。

以上方案已在智慧港口(跨域AGV控制)、电商大促(亿级QPS支撑)等场景验证,详情参考腾讯云官方文档。

二、腾讯云在网络基础设施

2.1 网络基础设施(含云数据中心网络和云骨干基础设施网络)方面与阿里云、天翼云、移动云、联通云的对比分析

腾讯云在网络基础设施(含云数据中心网络和云骨干基础设施网络)方面与阿里云、天翼云、移动云、联通云的对比分析,从设备选型、协议选型、算法选型及自动化运维等维度展开:

2.1.1、腾讯云的核心优势

-

高性能网络架构

- 设备选型:采用自研星脉网络架构,配备智能网卡(如Solarflare)和低延迟交换机(如基于Broadcom Tomahawk芯片),支持单集群10万级服务器互联,网络时延降至5微秒级。

- 协议选型:优化RDMA(远程直接内存访问)协议,结合自研的T-Sec协议栈,提升数据中心内东西向流量效率,尤其适合游戏、实时音视频等高并发场景。

- 算法选型:基于AI的动态流量调度算法(如强化学习模型),实时优化路径选择,降低拥塞;腾讯云EdgeOne加速节点较传统CDN性能提升40%。

-

全球加速与边缘覆盖

- 骨干网布局:依托全球70+国家和地区的边缘节点,结合BGP多线路接入,海外服务器支持免费更换IP(阿里云需绑定弹性公网IP)。

- 协议选型:采用QUIC协议优化弱网环境下的传输效率,提升跨境业务稳定性。

-

自动化运维与智能化

- AIOps系统:集成AI驱动的故障预测和自愈机制,如基于时序数据的异常检测算法(如LSTM模型),缩短故障恢复时间。

- 运维工具链:提供Kubernetes原生管理平台(TKE),支持容器网络自动化配置(如基于Cilium的eBPF技术)。

2.1.2、腾讯云的主要缺陷

-

物理网络资源限制

- 相比运营商云(天翼云、移动云、联通云),腾讯云缺乏自有骨干网资源,依赖租用线路,在网络控制深度上处于劣势。

- 运营商云可提供“5G+MEC边缘云”的云网融合服务,下沉至县域(如移动云),腾讯云难以企及。

-

复杂场景适配不足

- 在工业物联网场景中,腾讯云TIoT平台延迟低于50ms,但阿里云Link Platform支持百万级设备并发,大规模工业协议(如Modbus、OPC UA)适配性较弱。

- 运营商云凭借政企属地化服务团队,在定制化网络方案(如专线接入)上更具优势。

2.1.3、与竞品的差异化对比

1. 设备选型差异

| 云服务商 | 核心设备技术 | 适用场景 |

|---|---|---|

| 腾讯云 | 自研星脉网络+智能网卡 | 高并发实时交互(游戏、直播) |

| 阿里云 | 神龙架构(硬件虚拟化卸载) | 高性能计算、大数据分析 |

| 运营商云 | 5G MEC边缘节点+SD-WAN设备 | 政企专网、混合云部署 |

2. 协议与算法选型差异

- 协议层:

- 腾讯云:RDMA+QUIC,侧重低延迟传输;

- 阿里云:自研飞天协议(优化TCP拥塞控制),适合全球分发;

- 运营商云:SRv6+EVPN,实现云网协同。

- 算法层:

- 腾讯云:AI动态调优算法(实时流量预测);

- 阿里云:窄带高清2.0(视频编码优化算法);

- 运营商云:流量工程算法(TE)保障SLA。

3. 自动化运维差异

| 云服务商 | 自动化运维能力 | 局限性 |

|---|---|---|

| 腾讯云 | AIOps故障自愈+K8s原生管理 | 跨云协同工具较弱 |

| 阿里云 | 飞天AI调度引擎(EB级资源预测) | 配置复杂度高 |

| 运营商云 | 属地化运维团队+SDN控制器 | 智能化程度较低 |

总结建议

- 选择腾讯云:适合强交互型业务(如游戏、音视频),需高性能网络和全球化加速。

- 选择阿里云:需大规模资源调度(如电商、AI训练),神龙架构性能损耗仅3%。

- 选择运营商云:政企客户或需混合云专线接入的场景,云网融合能力突出。

未来,随着GPU异构计算和AIGC的普及,腾讯云在实时推理场景的网络优化可能进一步扩大优势,但需补足物理网络资源短板以应对运营商云的挤压。

2.2 混合云场景下,腾讯云与其他主流云服务商(如阿里云、运营商云)的网络互联方案

在混合云场景下,腾讯云与其他主流云服务商(如阿里云、运营商云)的网络互联方案在架构设计、协议选型、性能优化及生态整合等方面存在显著差异。以下从核心技术、性能表现、安全运维及适用场景四个维度展开对比分析:

2.2.1、基础架构与协议选型差异

-

腾讯云:云联网(CCN)为核心

- 多点互联:通过CCN实现全球20+地域的VPC、本地IDC及第三方云的一键接入,路由自动学习与下发,无需逐点配置对等连接。

- 协议栈:基于MPLS-VPN实现用户间逻辑隔离,结合BGP实现动态路由收敛,支持ECMP(等价多路径)负载均衡。

- 容器网络集成:采用Cilium+BGP Underlay方案,通过GoBGP实现Pod级路由宣告,减少Overlay性能损耗,适用于金融级低延迟场景。

-

阿里云:云企业网(CEN)为中心

- 组件依赖:依赖高速通道(物理专线)、边界路由器(VBR)及转发路由器(TR)构建混合网络,配置复杂度较高。

- 协议优化:强调BGP+BFD毫秒级故障检测,结合SRv6协议实现智能选路,但跨账号互联需手动配置TR路由表。

-

运营商云(天翼云/移动云):云网融合优先

- 物理层优势:依托自有骨干网,提供“5G+MEC边缘节点”下沉能力,县域级覆盖更广,时延可控制在1-5ms。

- 协议适配:支持SRv6+EVPN实现云网协同,专为政企客户定制工业协议(如Modbus)的传输优化。

2.2.2、性能优化与安全机制对比

| 维度 | 腾讯云 | 阿里云 | 运营商云 |

|---|---|---|---|

| 延迟控制 | 智能调度算法实现最短路径(如香港-新加坡≤30ms) | 同地域<3ms,但跨地域依赖BGP收敛速度 | 边缘节点下沉,本地延迟1-5ms |

| 带宽能力 | 单链路100Gbps,支持95削峰计费 | 独享专线达100Gbps,共享专线按需扩容 | 5G切片保障关键业务带宽 |

| 安全架构 | 网络ACL+安全组+传输层IPSec加密 | TR多路由表+云防火墙,支持私网流量IPSec叠加加密 | 端到端国密SM4加密,符合政务合规 |

| 故障恢复 | 5分钟内自愈(基于Cloud Monitor) | BFD+快速倒换组实现毫秒级切换 | 属地化运维团队现场支持 |

2.2.3、场景适配与生态整合

-

腾讯云:强交互型业务首选

- 游戏/音视频:云联网支持全球玩家就近接入(如法兰克福-上海150ms),QUIC协议优化弱网传输。

- 容器混合云:TKE集成BGP Underlay方案,跨云Pod通信性能损耗<5%,适合AI推理等实时业务。

-

阿里云:大规模资源调度场景

- 电商/大数据:CEN支持EB级资源预测,神龙架构虚拟化损耗仅3%,适合突发流量承载。

- 多云互联:通过VBR对接AWS/Azure,但需手动配置路由策略。

-

运营商云:政企专网与合规场景

- 工业物联网:5G MEC边缘节点实现厂区AGV低时延控制(≤20ms)。

- 数据主权合规:本地加密网关满足GDPR/CCPA跨境数据隔离要求。

2.2.4、选型建议总结

- 选择腾讯云:需全球化多点互联或容器化混合部署的场景,如游戏全球同服、跨境实时音视频。

- 选择阿里云:适合复杂多云管理或高算力需求,如跨国电商、AI训练集群。

- 选择运营商云:强合规行业(政务、医疗)或需边缘节点下沉的工业场景。

未来趋势:随着AIGC和边缘计算普及,腾讯云的BGP Underlay容器网络可能进一步扩大实时业务优势,而运营商云的“云网融合”模式在政企市场壁垒显著。建议根据业务延迟敏感性、合规等级及运维成本综合评估。

2.3 腾讯云云联网(CCN)在跨地域互联

腾讯云云联网(CCN)在跨地域互联时,通过融合智能调度技术、协议优化及多层安全机制,实现安全与低延迟的平衡。以下是具体实现方案:

2.3.1、数据传输安全性保障

-

MPLS-VPN隔离加密

- 逻辑隔离:基于MPLS-VPN技术为每个租户创建独立的虚拟路由转发(VRF)实例,确保不同用户的数据完全隔离,杜绝横向渗透风险。

- 端到端加密:支持叠加IPSec隧道(如AES-256-GCM算法),对跨地域流量进行二次加密,性能损耗<5%,远低于传统MPLS的15%损耗。

-

零信任安全架构

- 动态认证:集成零信任网络访问(ZTNA)机制,所有访问请求需通过持续身份验证和权限校验,防止未授权访问。

- 微隔离策略:基于SRv6 SID(Segment ID)实现容器/Pod级流量隔离,例如仅允许指定SID段的AI训练任务互通,阻断异常流量。

-

安全监控与审计

- 实时威胁检测:通过SmartCare平台监控全网流量,结合AI分析识别DDoS攻击、端口扫描等异常行为,秒级触发清洗策略。

- 操作审计:云审计(CloudAudit)记录所有配置变更和API调用,满足金融级合规要求(如等保2.0、GDPR)。

2.3.2、低延迟优化机制

-

智能路由调度

- 最短路径算法:基于实时网络状态(延迟、丢包率)动态计算最优路径,例如香港-新加坡跨域延迟≤30ms,比公网降低60%。

- BGP MED属性优化:为同地域可用区(AZ)间路径设置低MED值(如50),优先选择低延迟链路,路由收敛时间<1秒。

-

协议与硬件加速

- RDMA+RoCEv2协议:在AI训练等场景中,通过远程直接内存访问(RDMA)和融合以太网协议,将跨节点通信延迟降至3-5μs,吞吐量达3.2Tbps。

- SRv6替代MPLS:采用源路由(Segment Routing)精简包头,减少标签查找层级,跨域延迟从8-12ms降至3-5ms,提升分布式训练效率40%。

-

全球骨干网与边缘节点

- 内网专线互通:腾讯云全球30+地域数据中心通过专线互联,流量不经公网,避免拥塞和绕行。例如法兰克福-上海专线延迟稳定在150ms内。

- 边缘计算集成:结合5G MEC边缘节点,将计算下沉至用户近端(如厂区、县域),本地访问延迟低至1-5ms。

2.3.3、典型场景性能对比

| 场景 | 安全措施 | 延迟优化手段 | 实测性能 |

|---|---|---|---|

| 金融交易 | IPSec+AES-256双加密 + 零信任认证 | SRv6智能选路 + 快慢路径分离 | 跨域延迟≤5ms,抖动<1ms |

| AI训练集群 | SRv6 SID微隔离 + 流量审计 | RDMA over CCN + Tita拥塞控制算法 | 参数同步延迟3ms,吞吐100Gbps |

| 跨国视频会议 | MPLS-VPN隔离 + ZTNA动态鉴权 | QUIC弱网优化 + 边缘节点接入 | 弱网环境下延迟降低50% |

总结

腾讯云CCN通过 “协议层优化+物理层调度+安全加固”三重机制 实现安全与低延迟的统一:

- 安全优先场景(如金融政务):启用MPLS-VPN+IPSec双加密,结合零信任动态认证。

- 性能优先场景(如AI训练):采用SRv6+RDMA协议栈,通过Tita算法动态调整发包窗口(公式:

W_new = W_current × TargetDelay/CurrentDelay),提升网络利用率至90%+。 - 成本敏感场景:利用95削峰计费模式,在保障SLA的同时优化带宽成本。

💡 建议:对延迟敏感型业务(如实时游戏、高频交易),可启用CCN的 智能网卡硬件卸载(如VXLAN/IPsec由网卡处理),进一步降低CPU开销50%。

2.4 腾讯云在5G-A/6G时代的布局

腾讯云在5G-A/6G时代面向工业互联网、低空经济、智能交通、AIGC及空间计算等场景的云网络布局需系统性优化。结合行业需求与技术演进,其当前缺陷、补足方向、运营商合作及差异化竞争策略分析如下:

2.4.1、当前云网络布局的核心缺陷

-

高可靠低时延能力不足

- 工业控制场景:现有网络难以满足工业机器人毫秒级时延(<10ms)及99.999%可靠性需求,尤其在多设备协同场景易出现抖动。

- 低空经济场景:无人机群控需亚毫秒级响应,当前网络对三维空间动态拓扑适配弱,易因信号遮挡导致指令延迟。

-

多场景融合网络架构缺位

- 通感一体化缺失:5G-A的通信感知融合能力(如基站雷达式监测)尚未深度集成,限制车联网、无人机对实时环境数据的利用。

- 算网协同薄弱:AIGC训练需千卡级GPU集群互联,但跨地域算力调度受限于网络带宽,RDMA利用率仅60%-70%,远低于星脉网络90%+水平。

-

全域覆盖与协议适配瓶颈

- 地面-空域覆盖断层:6G需支持空天地海一体化,但腾讯云缺乏卫星直连能力,低空无人机超视距通信依赖第三方。

- 工业协议兼容性差:Modbus、OPC UA等工业协议与云原生网络协议(如HTTP/3)转换效率低,增加额外解析开销。

2.4.2、关键技术补足方向

-

构建“云-边-端”超融合网络

- 增强边缘算力:部署5G MEC边缘节点,支持工业视觉质检(时延<5ms)及车载AI推理(带宽>1Gbps)。

- 星脉网络技术下沉:将Tita端网协同协议、RDMA零丢包传输扩展至边缘侧,提升设备协同效率。

-

通感算一体网络升级

- 基站深度协同:与运营商共建通感一体化基站,实现厘米级定位(误差<30cm)及船舶/无人机轨迹追踪。

- 智能超表面(RIS)应用:部署可编程反射面,增强工厂金属环境信号穿透,降低干扰丢包率。

-

6G使能技术预研

- 太赫兹频段支持:联合研发6G高频芯片(如140GHz频段),满足全息通信>100Gbps峰值速率需求。

- 量子加密融合:集成量子密钥分发(QKD),为电网、金融等高安全场景提供物理层防护。

2.4.3、与电信运营商的合作重点

-

频谱资源共享与切片定制

- 共享运营商毫米波频段(26GHz/40GHz),为工业AR质检提供专属网络切片(隔离带宽+低时延保障)。

- 合作开发“按需切片”API,支持AIGC训练任务突发带宽动态调配(如瞬时10Gbps+)。

-

边缘基础设施共建

- 联合部署5G-A MEC:在港口、机场等场景共建设备,降低端到端时延60%。

- 天地一体化网络:接入运营商卫星互联网,为远洋船舶、偏远矿区提供泛在连接。

-

协议与标准协同

- 推动RedCap轻量化终端协议在工业传感器落地,降低设备功耗70%。

- 共建6G语义通信标准,优化空间计算场景数据传输效率。

2.4.、差异化竞争核心领域

-

AI×通信融合能力

- 智能网卡硬件加速:将FORNAX会话管理架构应用于工业网关,实现协议转换硬件卸载,时延降低40%。

- AIGC网络自适应:基于TACO套件动态优化多模态训练流量,提升GPU集群利用率至85%+。

-

垂直场景深度优化

场景 腾讯云差异化方案 技术支撑 低空经济 低空交通管理系统(UTM) 通感基站+AI轨迹预测 智能工厂 设备预测性维护平台 工业AI中台+时序数据库 空间计算 全息通信渲染网络 6G OAM波束赋形 -

生态开放战略

- WeMake工业平台:开放511合伙人计划,吸引工业协议开发者(如OPC UA插件库),降低企业接入成本。

- AIGC开发者生态:提供模型微调-推理-合规审核全链工具,缩短应用上线周期50%。

总结:腾讯云破局关键路径

- 短板补足:攻克高可靠传输(星脉网络下沉)、通感融合(基站协同)、天地一体(卫星互联)三大瓶颈。

- 运营商合作:以频谱共享、边缘共建、协议共研为核心,降低覆盖成本,强化底层网络能力。

- 差异化竞争:聚焦“AI×通信”软硬协同(如FORNAX/Tita)、行业深度方案(UTM/预测维护)、开发者生态(WeMake/AIGC工具链),在6G时代形成“连接+智能”双壁垒。

注:部分技术细节需进一步参考腾讯云星脉网络白皮书及3GPP Release-18标准演进路线。

2.5 腾讯云面向多运营商的5G MEC(多接入边缘计算)部署

腾讯云面向多运营商的5G MEC(多接入边缘计算)部署,主要通过融合架构设计、智能分流策略、轻量化平台优化及开放生态协同实现高效部署。以下是具体解决方案及技术要点:

2.5.1、多运营商UPF融合部署方案

-

共享UPF实例

- 通过多租户隔离技术,在单一UPF(用户面功能)上为不同运营商划分独立虚拟实例,支持差异化策略管理(如QoS、计费规则),降低硬件成本30%。

- 控制面集中管理:SMF(会话管理功能)部署于中心DC,统一配置多运营商的分流规则,避免策略冲突。

-

独立UPF下沉

- 在边缘DC为每家运营商部署专属UPF,通过N6接口直连运营商核心网,保障数据主权与合规性(如GDPR/本地化存储要求)。

- 动态路由选择:基于BGP协议实现跨运营商流量智能调度,时延敏感业务(如工业控制)优先选择本地UPF路径。

2.5.2、智能分流策略适配多运营商场景

腾讯云支持三种标准化分流技术,适配不同业务需求:

| 分流方案 | 技术原理 | 适用场景 | 多运营商优势 |

|---|---|---|---|

| LADN(本地数据网络) | 用户进入特定区域时触发本地会话建立 | 园区专网、低空经济 | 独立DNN隔离各运营商业务流量 |

| UL CL(上行分类器) | 动态插入分流点,将流量导向边缘UPF | 跨域漫游业务(如智能交通) | 支持混合组网(4G/5G NSA/SA) |

| IPv6 Multi-homing | 为终端分配多IPv6前缀,不同业务走不同路径 | 工业互联网多协议兼容场景 | 避免NAT转换,简化跨网互通 |

- 动态分流触发:结合PCF(策略控制功能)实时决策,当用户位置或网络状态变化时,秒级调整分流路径(如从中心UPF切换至边缘UPF),时延波动控制在5ms内。

2.5.3、轻量化边缘云平台优化

- OpenStack深度裁剪

- 保留核心组件(Nova/Neutron),移除非必要模块(如Heat),资源占用减少75%,启动时间从分钟级降至秒级。

- 双栈虚拟化支持

- 同时支持虚拟机(VM)与容器部署:

- VM:运行运营商专属网元(如UPF),隔离性强;

- 容器:承载第三方应用(如AR巡检),快速扩缩容。

- 同时支持虚拟机(VM)与容器部署:

- 硬件加速集成

- 采用智能网卡卸载UPF转发任务,吞吐量提升200%;GPU卡加速视频渲染(如演唱会直播),编码延迟降至20ms以下。

2.5.4、分层网络架构与边缘节点部署

腾讯云按业务时延需求分层部署MEC:

- 接入局所级(与基站共机房):部署超低时延业务(无人机控制/远程手术),端到端时延1-10ms。

- 边缘DC级(汇聚机房):承载AR/VR、视频监控等中时延业务(20ms级)。

- 多运营商协同:在机场、港口等枢纽共建边缘节点,共享机房空间与供电,通过SDN实现逻辑隔离。

2.5.5、能力开放与生态协同

- MEP平台开放网络能力

- 通过标准化API开放RNIS(无线网络信息)、室内定位(精度3-5米)、QoS策略接口,供运营商调用。

- 例如:演唱会直播中,基于RNIS动态分配带宽,保障VIP用户4K视频流畅。

- 运营商-云服务商协同

- 与联通、电信等共建 “边缘应用市场”,共享工业检测、低空监管等应用,降低开发成本40%。

2.5.6、安全隔离与合规保障

- 三层隔离机制:

- 传输层:IPSec/VxLAN加密跨运营商流量;

- 数据层:VPC隔离各租户数据;

- 应用层:容器沙箱防护第三方应用。

- 安全功能卸载:

- 在交换机嵌入防火墙策略,避免外挂设备增加时延,威胁检测效率提升50%。

2.5.7、统一运维与智能管理

- 中心化管控平台:在区域DC部署统一管理节点,监控多运营商资源池状态,自动均衡负载。

- AI运维工具:

- 预测性维护:基于设备温度、流量波动预测故障,准确率>90%;

- 一键式部署:模板化配置UPF策略,部署时间从周级缩短至小时级。

典型行业实践

- 上海梅赛德斯-奔驰文化中心

- 腾讯云联合联通部署MEC,为移动/电信用户提供低延迟直播服务:

- 本地分流方案:UL CL动态导流;

- 效果:直播延迟从100ms降至20ms,带宽成本降低60%。

- 腾讯云联合联通部署MEC,为移动/电信用户提供低延迟直播服务:

- 智慧港口项目

- 多运营商共建边缘节点:

- 电信负责AGV调度(时延<10ms),移动承载视频监控;

- 通过LADN隔离流量,数据不出园区。

- 多运营商共建边缘节点:

总结:腾讯云方案核心优势

- 融合架构:共享UPF+轻量化平台,降低多运营商协同成本;

- 智能调度:UL CL/LADN/IPv6多宿主分流策略动态适配业务需求;

- 开放生态:MEP能力开放加速应用创新;

- 安全合规:端到端隔离满足运营商数据主权要求。

适用建议:

- 对时延敏感场景(工业控制/低空经济)优先选择接入局所级部署;

- 多运营商共建场景推荐UL CL分流+中心化运维管理。

2.6 腾讯云MEP(Multi-access Edge Computing Platform)平台

腾讯云MEP(Multi-access Edge Computing Platform)平台通过开放关键API,赋能运营商快速构建边缘应用,实现“云-网-边-端”协同。以下是核心API及其应用价值的分析:

2.6.1、关键开放API分类与功能

1. 网络能力开放API

- RNIS(无线网络信息)接口

- 提供实时基站状态、信号强度、网络负载等数据,精度达毫秒级。

- 应用场景:视频直播平台根据用户位置动态分配边缘节点带宽,避免卡顿;工业巡检无人机依据信号质量切换连接节点。

- QoS策略管理API

- 支持动态调整带宽、时延和丢包率阈值(如工业控制要求<10ms时延)。

- 技术实现:通过策略控制功能(PCF)联动,秒级生效。

2. 定位与感知API

- 室内定位服务

- 融合基站三角定位与蓝牙Beacon,精度达3-5米。

- 应用场景:商场导购应用推送附近优惠,医院资产追踪设备位置。

- 环境感知接口

- 接入温度、湿度等物联网传感器数据(需与运营商IoT平台集成)。

3. 算力与存储API

- 边缘存储读写接口

- 支持低延迟数据缓存(如CDN边缘节点视频预加载)。

- GPU加速API

- 调用边缘节点GPU资源,支撑AR渲染(时延<20ms)。

2.6.2、API如何加速运营商边缘应用开发

1. 缩短开发周期

- 免重复造轮子:运营商无需自研底层网络感知模块,直接调用RNIS接口获取实时网络状态,开发效率提升60%。

- 标准化集成:兼容ETSI MEC规范,降低异构设备适配成本。

2. 增强场景化能力

| 场景 | API组合应用 | 案例效果 |

|---|---|---|

| 智能工厂 | QoS策略 + 室内定位 + 环境感知 | 三一重工巡检机器人时延降至8ms,故障响应提速40% |

| 低空经济 | RNIS + 动态路由API | 无人机群控指令传输路径优化,抗遮挡切换时延<50ms |

| 互动直播 | GPU渲染API + QoS策略 | 演唱会AR特效渲染时延从100ms降至20ms |

3. 实现资源精细化调度

- 流量智能分流:通过

UL CL(上行分类器)API动态导流,例如:- 本地数据处理流量→边缘UPF(用户面功能)

- 跨域业务流量→中心云

- 负载均衡:基于RNIS数据的节点负载预测,自动迁移计算任务(如突发热点事件引流至空闲节点)。

2.6.3、运营商专属能力扩展

1. 多租户隔离管理

- API级租户策略:为不同企业分配独立QoS策略和带宽配额(如工厂AR应用保障50Mbps专属通道)。

- 数据主权保障:通过

N6接口直连运营商核心网,满足本地化合规要求。

2. 生态协同创新

- 边缘应用市场:运营商与腾讯云共建应用商店,共享工业检测、低空监管等标准化方案,降低生态伙伴接入成本40%。

- 混合云集成:支持通过API打通私有边缘节点与公有云VPC,实现数据无缝同步。

总结:运营商价值闭环

腾讯云MEP平台通过网络能力开放、定位感知增强、算力弹性调度三类API,帮助运营商实现:

- 效率跃迁:边缘应用开发周期从6个月压缩至1-2个月;

- 体验升级:端到端时延降低60%,支撑工业控制、低空经济等严苛场景;

- 商业创新:通过开放生态快速孵化5G+AI融合应用(如AR质检、无人机监管),开辟新增长曲线。

部署建议:优先集成RNIS+QoS API构建基础网络感知层,再叠加垂直场景API(如GPU渲染/室内定位)深化行业解决方案。

2.7 腾讯云MEP(Multi-access Edge Computing Platform)平台

腾讯云MEP(Multi-access Edge Computing Platform)平台在与运营商核心网的N6接口对接时,需同时保障数据安全性和低延迟传输。以下是核心技术实现方案及优化策略:

2.7.1、数据安全防护机制

1. 多层加密与认证

- 传输层加密:采用IPSec/VxLAN隧道技术封装N6接口流量,实现运营商UPF(用户面功能)与MEP边缘节点间的端到端加密,防止中间链路窃听。

- 应用层加密:对业务数据额外施加AES-256加密或国密SM4算法,确保即使隧道被破解,业务数据仍不可读。

- 双向证书认证:运营商UPF与MEP平台双向验证X.509数字证书,杜绝非法节点接入。

2. 零信任访问控制

- SIM盾认证:为工业设备嵌入支持国密SM9算法的SIM卡,实现“一机一密”。设备访问MEP时需通过SIM卡硬件级鉴权,结合运营商UDM(统一数据管理)的二次认证,阻断非法终端接入。

- 动态策略联动:通过PCF(策略控制功能)实时下发访问规则,例如仅允许特定DNN(数据网络名称)的流量通过N6接口,并限制单设备带宽配额。

3. 数据完整性保障

- 国密哈希校验:使用SM3算法生成数据包哈希值,与数字签名结合,确保传输中数据未被篡改。

- 硬件级TEE安全区:在MEP边缘节点部署可信执行环境(如Intel SGX),敏感操作(如密钥管理)在隔离环境中完成,防止内存窃取。

2.7.2、低延迟传输优化

1. 边缘节点深度下沉

- MEC与基站共址部署:将MEP平台部署于运营商接入局所(距基站<10km),使N6接口传输距离控制在单跳范围内,端到端时延压至1-5ms。

- UPF融合架构:采用共享UPF实例,通过多租户隔离技术为不同业务分配独立虚拟通道,减少数据绕转,时延降低40%。

2. 智能流量调度

- 动态分流策略:

- UL CL(上行分类器):实时识别业务类型(如工业控制指令),将其直连本地MEP处理,避免经中心云绕行。

- LADN(本地数据网络):为低时延业务(如无人机控制)配置专属DNN,流量在边缘节点终结,时延波动控制在±2ms内。

- 拥塞主动避让:基于RNIS(无线网络信息)API获取实时网络状态,动态切换传输路径(如从公网切换至5G切片通道),规避拥塞链路。

3. 硬件加速技术

- 智能网卡卸载:将UPF数据包转发、加解密等操作卸载至DPU网卡,处理时延从毫秒级降至微秒级。

- GPU硬件编码:对视频类业务(如AR巡检)启用边缘节点GPU硬编码,视频流处理延迟从100ms压缩至20ms以下。

2.7.3、协同架构设计

1. 安全与低延迟的平衡

- 分层加密策略:对时延敏感业务(如机器人控制)仅启用IPSec隧道加密;对高安全业务(如支付)叠加应用层加密,按需权衡。

- 密钥缓存机制:在边缘节点预置会话密钥,减少每次传输的密钥协商开销,时延降低15%。

2. 运营商-云平台协同

- 统一运维视图:运营商与腾讯云共享N6接口流量监控数据,通过AI算法预测流量峰值并提前扩容,避免突发拥塞。

- 故障自愈链路:部署Hash Dodging技术,当检测到链路异常(如丢包率>0.1%)时,600ms内切换至备份路径,保障业务连续性。

2.7.4、实测性能与行业案例

| 指标 | 常规方案 | 腾讯云MEP优化方案 | 提升效果 |

|---|---|---|---|

| 端到端时延 | 20-50ms | 1-10ms | 降幅达80% |

| 丢包率 | 0.1%-1% | <0.001% | 趋近于零 |

| 安全威胁响应 | 分钟级 | 秒级熔断 | 自愈速度提升60倍 |

典型场景验证:

- 智慧港口AGV调度:通过N6接口传输控制指令,时延稳定在8ms内,结合SIM盾认证实现零安全事故。

- 工业AR质检:MEP平台处理4K视频流,依托GPU硬编码+UL CL分流,时延从100ms降至20ms,质检效率提升40%。

总结

腾讯云MEP平台通过 “安全分层加固 + 传输路径极简优化 + 硬件加速” 三重技术闭环,在N6接口对接中实现:

- 安全无妥协:国密算法、零信任架构、硬件级隔离构建纵深防御;

- 性能突破瓶颈:边缘下沉、智能调度、协议卸载将时延压至工业级要求(<10ms)。

部署建议:对超高安全场景(如电网)采用SIM盾+独立UPF;对超低时延场景(如车联网)启用UL CL+硬件卸载组合。

2.8 腾讯云MEP(Multi-access Edge Computing Platform)平台支持多运营商边缘计算及业务路由优化

腾讯云MEP(Multi-access Edge Computing Platform)平台通过融合网络架构、智能调度机制与开放生态,支持多运营商边缘计算及业务路由优化,同时提供全面的计算平台、芯片、AI算法及数据治理能力。以下是综合技术解析:

2.8.1、多运营商网络支持与业务路由机制

-

云边协同架构

- 边缘节点下沉:覆盖全球70+国家/地区的1300+边缘节点,与运营商共建边缘可用区(Edge Zone),确保用户10ms网络覆盖。

- 多运营商UPF融合:支持共享UPF实例(多租户隔离)或独立UPF下沉,通过N6接口直连运营商核心网,保障数据主权与低时延传输。

-

智能业务路由选择

- 动态分流策略:

- UL CL(上行分类器):实时识别业务类型(如工业控制指令),动态导流至本地边缘节点,避免跨域绕行。

- LADN(本地数据网络):为低时延业务(如无人机控制)配置专属DNN,流量在边缘终结,时延波动<±2ms。

- RNIS(无线网络信息)驱动:基于基站状态、网络负载等毫秒级数据,动态切换传输路径(如5G切片通道),规避拥塞链路。

- 动态分流策略:

2.8.2、支持的计算平台

- 边缘容器服务(TKE Edge)

- 轻量化Kubernetes集群,支持边缘侧容器化部署,资源占用减少75%。

- 边缘函数计算(SCF@Edge)

- 无服务器化执行环境,支持Node.js/Python编写数据处理逻辑,简化开发流程。

- 物联网边缘计算平台(IECP)

- 集成云端AI/大数据能力,支持本地化流式分析、ML计算,适用于工厂预测性维护等场景。

- TinyKube边缘容器管理

- 腾讯自研云原生容器服务,优化弱网环境高可用性,支持插件化安装。

2.8.3、芯片与硬件支持

- 通用计算芯片

- CPU:支持AMD EPYC™ Turin(SA9实例)、Intel Sierra Forest(S9实例)等高性能处理器,最高睿频3.4GHz。

- 边缘AI专用芯片

- MediaTek Genio 720/520:集成10TOPS NPU,支持Transformer/CNN硬件加速,适配Llama/Gemini等大语言模型边缘推理。

- NVIDIA GPU:搭载于异构计算实例,加速视频渲染(如AR巡检时延<20ms)。

- 安全芯片

- TEE可信执行环境:基于国密算法的硬件加密模块(如TCM/TPCM),保障数据在“飞地”内解密计算。

2.8.4、AI算法与计算内容支持

| 能力类型 | 具体支持 | 应用场景案例 |

|---|---|---|

| 预置AI模型 | 视觉检测(工业质检)、语音识别(ASR)、自然语言处理(NLP) | 三一重工巡检机器人故障识别准确率提升40% |

| 自定义AI训练 | 支持TensorFlow/PyTorch框架,结合TACO加速套件优化大模型训练效率 | 工业设备异常检测模型边缘增量训练 |

| 生成式AI | 集成Stable Diffusion文生图、混元大模型绘画API,支持ComfyUI快速部署 | 艺术创作平台秒级生成图像 |

| 实时流式计算 | Flink边缘化部署,毫秒级响应数据聚合、过滤 | 智慧交通流量分析延迟<50ms |

2.8.5、数据开发与大数据治理能力

- 边缘数据开发

- 数据处理引擎:支持Node.js/Python定义数据过滤、聚合规则(如工业传感器数据清洗)。

- 流批一体:结合云端大数据平台(TBDS),实现边缘实时计算与云端批量分析协同。

- 大数据治理

- 隐私计算:集成安全多方计算(SMC)与同态加密,保障跨运营商数据合作隐私。

- 合规审计:通过安全湖(Security Lake)实现数据全生命周期监控,满足GDPR/等保要求。

- 离线自治能力

- 断网环境下本地持续执行预设分析策略,网络恢复后自动同步数据至云端。

2.8.6、多运营商网络协同的差异化价值

- 成本优化:共享UPF降低硬件投入30%,动态带宽突发(如SA9实例突发10Gbps)应对流量峰值。

- 安全隔离:三层加密(IPSec/VxLAN传输层 + AES-256应用层 + TEE硬件隔离)保障跨网数据安全。

- 生态开放:MEP平台开放RNIS/QoS/定位等API,运营商可快速构建低空监管、工业质检等应用。

总结:MEP平台核心优势

- 全域覆盖:1300+节点支撑多运营商就近接入,时延压至1-10ms。

- 全栈开放:从MediaTek NPU到TinyKube容器平台,兼容多元硬件与AI生态。

- 智能调度:RNIS+UL CL+LADN组合策略实现业务路由动态优化。

- 数据闭环:边缘实时分析→云端批量治理→离线自治,覆盖数据全生命周期。

建议场景:

- 工业互联网:优先选用IECP+Genio 520芯片实现设备预测性维护;

- 低空经济:基于LADN+RNIS API构建无人机抗遮挡控制系统。

2.9 腾讯云MEP(Multi-access Edge Computing Platform)平台在多运营商网络环境下,通过智能调度架构、协同资源管理及开放能力,实现动态资源分配与负载均衡,确保业务的高性能与高可用性。以下是其核心机制及技术实现:

2.9.1、动态资源分配机制

1. 多维资源感知与预测

- RNIS(无线网络信息)驱动

通过开放RNIS API实时获取基站负载、信号强度及网络拥塞状态(精度达毫秒级),结合AI算法预测流量峰值。例如,演唱会直播场景中,基于用户密度动态分配边缘节点GPU资源,避免卡顿。 - 业务画像分析

识别业务类型(如工业控制指令时延敏感度<10ms、视频流带宽敏感度>100Mbps),动态分配计算资源。例如,为AGV调度任务预留低时延UPF路径,为AR/VR业务分配GPU加速资源。

2. 智能弹性伸缩

- 边缘容器化扩缩容

基于TKE Edge(腾讯云边缘容器服务)实现秒级资源调度:- 突发流量场景(如电商大促)自动扩容容器实例,资源利用率提升40%;

- 闲时自动释放冗余资源,成本降低30%。

- 无服务器函数计算

通过SCF@Edge(边缘函数计算)按需执行数据处理逻辑,例如IoT传感器数据过滤,响应延迟<50ms,资源占用减少70%。

2.9.2、多运营商负载均衡策略

1. 全局流量调度

- BGP+SDN智能选路

基于BGP协议动态选择最优运营商路径:- 时延敏感业务(如远程手术)优先调度至本地UPF路径(时延<5ms);

- 带宽密集型业务(如4K直播)切换至多线BGP骨干网,支持单实例30万QPS。

- 多宿主IPv6分流

为终端分配多运营商IPv6前缀,工业设备控制流量走移动网络、视频监控流量走电信网络,规避跨网拥塞。

2. 本地化负载均衡

- UL CL(上行分类器)动态导流

实时识别业务类型并插入分流点:- 本地数据处理(如园区安防)→ 边缘UPF;

- 跨域业务(如云游戏)→ 中心云,减少80%回传带宽。

- LADN(本地数据网络)隔离

为低空无人机控制配置专属DNN,流量在边缘终结,时延波动控制在±2ms内,避免多网干扰。

2.9.3、多运营商协同架构

1. 共享UPF融合部署

- 多租户虚拟化

单一UPF实例为不同运营商划分独立虚拟通道,通过VxLAN隔离流量,硬件成本降低30%。 - N6接口安全互通

运营商核心网与MEP平台间采用IPSec加密隧道+国密SM4硬件加速,传输时延<1ms,满足电网控制需求。

2. 边缘节点共建共享

- 枢纽区域共建

在机场、港口等热点区域与运营商共建边缘节点(如联通承建UPF、电信提供带宽),通过SDN逻辑隔离资源池。 - 资源池统一纳管

中心化管控平台监控多运营商资源状态,自动均衡负载。例如,移动用户突增时,自动调度电信节点冗余算力支撑。

2.9.4、安全与合规保障

1. 分层安全隔离

- 传输层:IPSec/VxLAN加密跨网流量;

- 数据层:VPC隔离各运营商租户数据;

- 应用层:容器沙箱防护第三方应用。

2. 零信任接入控制

- SIM盾认证:为工业设备嵌入国密SM9算法的SIM卡,实现“一机一密”,结合UDM二次鉴权,阻断非法终端接入。

2.9.5、行业实践与效能对比

| 场景 | 技术方案 | 效果 |

|---|---|---|

| 智慧港口 | UL CL+BGP跨网调度+共享UPF | 跨运营商AGV控制时延稳定在8ms,零安全事故 |

| 低空经济 | LADN专属DNN+RNIS动态避障 | 无人机抗遮挡切换时延<50ms |

| 互动直播 | 弹性GPU+多线BGP | 4K直播带宽成本降60%,卡顿率归零 |

总结:核心优势与部署建议

腾讯云MEP通过 “智能感知-动态调度-多网协同” 三位一体架构,实现多运营商环境下的资源最优分配:

- 智能性:RNIS+AI预测实现资源预分配,业务感知精度达毫秒级;

- 高效性:UL CL/LADN/IPv6多宿主分流策略降低80%跨网流量;

- 经济性:共享UPF+边缘共建降低30%硬件投入。

场景化部署建议:

- 工业互联网:优先选用UL CL+性能容量型CLB(1000万并发支撑);

- 跨网漫游业务:采用SIM盾+BGP多线调度,保障认证与传输双安全。

三、腾讯云OTN

3.1 腾讯云OTN(光传送网)光网络的整体设计方案

腾讯云OTN(光传送网)光网络的整体设计方案深度融合TOGAF 10企业架构框架,通过分层解耦、智能调度与开放解耦技术,构建了高性能、高可靠、弹性可扩展的光传输体系。以下从整体布局、跨域互联、分片与资源分配机制等维度展开详细设计:

3.1.1、整体架构设计:基于TOGAF 10的四层领域模型

1. 业务架构层:需求驱动的基础布局

- 全球骨干网布局:依托自研开放光网络平台(TOOP)与TPC-4硬件平台,在全球部署30+核心节点,覆盖亚洲、欧洲、北美等区域,单节点支持80×400G波道容量,通过ODUk(光数据单元)实现2.5G~400G颗粒业务调度。

- 分层网络拓扑:

- 核心层:采用网状拓扑(Mesh),部署OPTN8600 X设备支持32槽位、3.2T交叉容量,通过OADM(光分插复用器)实现波长级调度。

- 城域层:结合CWDM(粗波分复用)与盒式OTN设备下沉至边缘,支持5G前传/中传场景,时延≤5ms。

- 接入层:通过弹性光网络(EON)技术动态分配频谱,支持6.25GHz粒度切片,适配工业物联网低时延需求。

2. 数据架构层:智能资源分配与封装

- 多业务统一封装:采用OPUk容器透明封装SDH、以太网、FC(光纤通道)等协议,保留原始开销信息,实现端到端业务隔离。

- 动态资源分配算法:

- 基于AI的频谱分配:结合强化学习模型,实时分析光路损耗与非线性损伤,动态调整调制格式(QPSK/16QAM)与FEC开销,频谱利用率提升30%。

- 分片自适应机制:弱网环境下分片大小动态调整(如WiFi下2MB→3G下256KB),通过MSNVT(最大累计真空时间)检测网络跳变,重传成功率提升8倍。

3. 应用架构层:微服务化控制与调度

- SOA服务化控制平面:

- 基于TOGAF 10的SOA架构思想,将控制功能拆分为微服务模块(如路由计算、故障诊断)。

- 自研TOOP控制器实现1秒级全量性能数据采集(Telemetry),支持光缆抖动、EDFA泵浦异常等毫秒级故障定位。

- 跨域协同引擎:

- 通过SRv6+EVPN协议实现多域协同,结合BGP MED属性优化路径选择,跨数据中心时延≤30ms(如香港-新加坡)。

4. 技术架构层:硬件与协议栈创新

- 开放解耦硬件:

- 电层采用可插拔DCO模块(如400G ZR+),光层支持LCoS(硅基液晶)WSS实现Flex-Grid灵活栅格。

- 电源与交叉单元1+1冗余,可靠性达99.999%。

- 协议栈优化:

- 传输层:RDMA over Converged Ethernet (RoCEv2) 降低AI训练集群跨节点延迟至3μs。

- 安全层:MPLS-VPN叠加IPSec加密(AES-256-GCM),性能损耗<5%。

3.1.2、跨域互联方案设计

1. 跨数据中心互联(DCI)

- 低时延链路:通过自建骨干专线直连,采用超强FEC技术实现100G/400G无电中继传输(距离≤1000km)。

- 弹性带宽分配:基于SDN控制器动态调整OTUflex容器容量,支持10G~400G速率可调,资源利用率提升40%。

2. 跨地市与运营商互联

- 运营商协同:

- 通过SRv6+EVPN实现与天翼云/移动云的云网融合,支持5G切片带宽保障。

- 采用分层安全架构:物理层(光放功率监测)、协议层(国密SM4加密)、业务层(零信任动态认证)。

- 政企专线硬隔离:通过ODUk通道划分专属波长,时延抖动<1ms,满足金融交易SLA。

3.1.3、分片与资源分配机制

1. 分片自适应算法

- 动态分片策略:

- 弱网环境:分片大小从1MB动态降至100KB,减少单分片传输时间,超时重传率降低60%。

- 智能状态机:模仿TCP慢启动机制,分片增长分为三态:

- QUICKSTART:指数增长(如分片大小×2)。

- SLOWSTART:线性增长(如+10%)。

- STABLE:固定分片大小。

- 并发控制:iOS/Android端支持多线程并发上传(线程数动态调整),弱网下吞吐量提升50%。

2. 资源分配算法

- 频谱碎片整理:

- 基于贪心算法合并空闲频谱块,支持非中断式频谱迁移(中心频率偏移)。

- 负载均衡:

- ECMP(等价多路径)结合实时BGP路由权重,专线故障时流量自动切换,带宽利用率从50%提升至75%。

总结:TOGAF驱动的OTN架构核心优势

- 敏捷性:TOGAF 10的模块化设计支持业务场景驱动的垂直架构迭代(如5G专网快速部署)。

- 智能化:AI赋能资源分配(频谱利用率↑30%)与故障定位(1秒级全量监测)。

- 开放解耦:硬件光电解耦降低40%成本,控制器兼容多厂商设备。

- 安全可靠:多层加密(MPLS-VPN+IPSec)与99.999%可用性,满足金融/政务强合规需求。

未来演进:结合全光交换2.0与量子密钥分发(QKD),进一步降低时延至μs级,构建“东数西算”国家级算力网络底座。

此方案通过TOGAF框架实现业务目标与技术能力的精准对齐,为超大规模OTN网络提供从战略规划到落地实施的完整蓝图。

3.2 腾讯云OTN(光传送网)

腾讯云OTN(光传送网)作为其算力网络的核心传输底座,通过全国化布局与智能化算法协同,深度支撑“东数西算”战略。以下从全国布局、算法协同机制及数学建模三个维度展开分析:

3.2.1、全国布局:紧扣“东数西算”枢纽节点

腾讯云OTN网络以国家算力枢纽为锚点,构建“东西协同、边缘下沉”的立体架构:

-

西部枢纽(存力与训练算力)

- 贵州贵安七星数据中心:占地47万平方米,规划30万台服务器,承载西南区域冷数据处理与AI训练任务。

- 内蒙古枢纽:通过400G OTN量子加密专线直连安徽合肥,支撑跨2000公里的超低时延智算互联(时延≤5ms)。

-

东部枢纽(实时算力与边缘节点)

- 京津冀:怀来瑞北/东园数据中心(单集群超30万台服务器),服务视频、金融等高实时性业务。

- 长三角:青浦数据中心,集成RoCEv2协议实现AI集群跨节点延迟降至3μs。

- 粤港澳:东莞数据中心+5G MEC边缘节点,实现本地访问延迟1-5ms。

-

网络骨干层

- 自建开放光网络平台(TOOP),核心节点采用OPTN8600 X设备(3.2T交叉容量),通过OADM实现波长级调度。

- 跨域互联采用SRv6+EVPN协议,结合BGP MED属性优化路径,如香港-新加坡专线延迟≤30ms。

3.2.2、算法协同机制:光电混合调度与生存性保障

1. 光电混合调度模型

- 光层调度:基于WSS器件的波长级疏导,减少OEO再生,支持ODUk-flex柔性管道(2.5G~400G可调)。

- 电层调度:通过ODUk交叉实现子波长级业务隔离,解决波长冲突与跨域互联问题。

- 协同策略:

- 多层路由计算:采用PCE(路径计算单元)全局优化,动态选择光层直通或电层再生路径。

- 资源分配:基于强化学习动态调整调制格式(QPSK/16QAM)与FEC开销,频谱利用率提升30%。

2. 生存性协同机制

| 故障场景 | 保护策略 | 恢复时间 |

|---|---|---|

| 光缆中断 | 光层1+1保护倒换 | <50ms |

| 节点失效 | 电层动态重路由(基于SRv6 TE) | 1-5秒 |

| 多重故障 | 光层保护+电层恢复协同 | 首次<50ms,二次依赖电层恢复时间 |

| 注:光层保护优先触发,电层恢复作为冗余备份,平衡成本与可靠性。 |

3. 量子加密与安全协同

- 合肥-和林格尔专线:集成量子密钥分发(QKD)与400G OTN,通过SM4国密算法实现物理层-传输层端到端加密。

- 密钥管理:量子密钥与业务流量分离传输,密钥更新频率达GHz级,抗量子计算攻击。

3.2.3、数学建模方法与优化机制

腾讯云OTN的核心算法依赖多类数学模型实现资源动态优化:

1. 路由与资源分配模型

- 问题描述:最小化跨层业务阻塞率,满足时延、损伤约束。

- 建模方法:

- 混合整数线性规划(MILP):定义目标函数:

min∑(i,j)∈Ecijxij+∑k∈Kpkyk

约束包括光路OSNR容限、电层ODUk碎片率等。 - 启发式算法:K最短路径(KSP)结合损伤感知RWA(路由波长分配),实时计算K条备选路径。

- 混合整数线性规划(MILP):定义目标函数:

2. 频谱碎片整理算法

- 贪心策略:合并空闲频谱块,目标函数为最大化连续频谱利用率:

maximize∑b∈BLb⋅Sb

其中 Lb 为块长度,Sb 为权重因子。 - 非中断迁移:基于马尔可夫决策过程(MDP)建模迁移风险,动态规划迁移序列。

3. 分片自适应传输模型

- 状态机模型(QUICKSTART/SLOWSTART/STABLE):

- 转换条件:基于丢包率 Ploss 与延迟抖动 J 的阈值控制。

- 分片调整:STABLE态微调公式:

Snew=Scurrent×DcurrentDtarget

- 并发控制:多线程传输的纳什均衡求解,最大化弱网吞吐量。

4. 算力-网络联合调度

- 博弈论模型:算力需求方(东部)与供给方(西部)的效用函数平衡:

Ui=α⋅QoS−β⋅Costtrans−γ⋅Delay

- 联邦学习:各枢纽节点本地训练资源预测模型,全局聚合优化任务调度。

总结:技术竞争力与未来方向

腾讯云OTN的核心优势在于:

- 布局深度绑定国家战略:覆盖全部8大算力枢纽,西部聚焦绿色训练/存储,东部保障实时业务。

- 算法-硬件协同创新:

- 光电混合调度降低OEO再生成本40%;

- 量子加密+400G OTN实现安全与带宽双突破。

- 建模贴近物理约束:将光损伤、频谱碎片等非线性问题转化为可解优化模型,资源利用率提升30%。

未来方向:

- 全光交换2.0:探索微环谐振器(MRR)替代WSS,实现纳秒级波长切换。

- 算力交易市场:基于区块链与Shapley值算法,实现跨枢纽算力确权与定价。

腾讯云OTN通过“枢纽覆盖+算法协同+物理建模”三重创新,为“东数西算”提供了高可靠、低时延的传输底座,其技术路径兼具工程落地性与学术前沿性。

3.3 腾讯云OTN量子加密专线

腾讯云OTN量子加密专线在密钥分发和管理上融合了量子通信技术与经典网络架构,通过以下创新设计实现物理层安全与高效运维的结合:

3.3.1、量子密钥分发(QKD)与OTN融合机制

-

量子-经典共纤传输

- 量子密钥与业务数据在同一光纤中传输,通过波长隔离技术(如C波段传业务、O波段传量子信号)避免干扰,减少额外部署成本。

- 密钥分发过程基于量子不可克隆定理,任何窃听行为会导致量子态坍缩,触发实时告警(误码率>阈值时自动终止会话)。

-

双模式密钥同步

- 帧开销嵌入:支持在OTN帧结构的开销区域(如ODUk的OPU开销字节)嵌入密钥序号,接收方直接解析序号获取密钥,时延<1ms。

- 管理通道同步:老旧设备通过专用管理通道(如ECC通道)定期发送密钥同步报文,含时间戳、设备标识及密钥校验值,确保密钥一致性。

3.3.2、多租户密钥分区分权管理

-

物理隔离的密钥分区

- 将OTN设备的密钥存储空间划分为多个独立量子密钥分区,每个分区绑定特定物理端口,不同租户的密钥完全隔离,杜绝跨用户泄露风险。

- 密钥预充注机制:分区预加载量子密钥块(如256位真随机数),业务请求触发时调用对应分区的密钥加密,响应速度提升50%。

-

动态密钥更新策略

- 密钥序号累增机制:每次加密后密钥序号+1,超出阈值(如10^6次)自动触发重新分发,防止暴力破解。

- 密钥池双备份:主密钥池耗尽前,从量子网络预取新密钥块填充备用池,实现无缝轮换(切换时延<10ms)。

3.3.3、量子-经典协同的密钥管理架构

-

分层加密与密钥托管

- L1层业务加密:量子密钥直接用于OTN净荷加密(如OPU层),实现物理层端到端保护,规避IP层攻击。

- 密钥托管服务:通过量子密码服务平台(QCSP)托管主密钥,结合国密SM4算法二次加密会话密钥,满足政务审计要求。

-

智能密钥调度算法

- 基于业务优先级动态分配量子信道资源:高敏感数据(如金融交易)优先分配低损耗波长路径,密钥更新频率达毫秒级;普通数据采用经典加密通道。

- 自适应调制优化:根据光纤损耗实时调整QKD调制格式(如QPSK/16QAM),信道利用率提升30%。

3.3.4、安全增强与合规性设计

-

抗量子计算攻击

- 采用后量子密码(PQC)算法(如Kyber)保护密钥申请报文,结合量子随机数生成器(QRNG)增强密钥熵值,抵御Shor算法攻击。

- 密钥分发链路双加密:主密钥加密会话密钥 + 量子密钥加密业务数据,形成“双锁”机制。

-

零信任密钥审计

- 与腾讯云KMS集成,记录密钥生成、轮换、销毁全生命周期操作,支持CAM权限策略(如仅授权运维人员访问密钥审计日志)。

- 量子密钥校验值比对:接收端通过哈希校验值验证密钥完整性,异常时自动触发密钥重置。

创新对比与典型场景

| 功能 | 传统OTN加密 | 腾讯云量子加密专线 |

|---|---|---|

| 密钥更新周期 | 小时级(手动轮换) | 毫秒级(自动触发) |

| 多租户隔离 | 逻辑VLAN隔离 | 物理端口+密钥分区隔离 |

| 抗量子攻击 | 依赖算法复杂度 | QKD + PQC双重防护 |

| 密钥同步时延 | >50ms | <1ms(帧开销嵌入模式) |

总结

腾讯云OTN量子加密专线的核心创新在于:

- 物理层融合:量子-经典共纤降低部署成本,L1加密实现“一次一密”;

- 租户级隔离:密钥分区与端口绑定,满足金融/政务场景的强合规要求;

- 动态化调度:业务驱动的密钥分配算法,平衡安全性与资源利用率;

- 全链路可信:从量子密钥生成到KMS审计,构建零信任管理体系。

该方案已在安徽政务云等场景落地,实测显示密钥分发效率提升90%,暴力破解成本增至10^20量级。未来或与6G太赫兹频段融合,进一步突破距离限制。

3.4 腾讯云OTN(光传送网)全国节点布局、骨干设备

腾讯云OTN(光传送网)全国节点布局、骨干设备及CPE设备的详细情况,结合公开信息整理:

3.4.1、全国节点布局:紧扣“东数西算”枢纽

腾讯云OTN网络以国家算力枢纽为核心,构建“核心-区域-边缘”三级架构:

-

西部枢纽(存力与训练算力)

- 贵州贵安七星数据中心:占地47万平方米,规划30万台服务器,承载西南区域AI训练及冷数据处理。

- 内蒙古枢纽:通过400G OTN专线直连东部(如安徽合肥),跨域时延≤5ms,支持超低时延智算互联。

-

东部枢纽(实时业务与边缘节点)

- 京津冀:怀来瑞北/东园数据中心(单集群超30万台服务器),服务视频、金融等高实时性业务。

- 长三角:青浦数据中心,集成RoCEv2协议,AI集群跨节点延迟降至3μs。

- 粤港澳:东莞数据中心+5G MEC边缘节点,本地访问延迟1-5ms,覆盖广深核心区及东莞/佛山制造业重镇。

-

成渝枢纽

- 重庆两大数据中心:一期容纳10万台服务器,二期扩建后达20万台,为西南地区核心算力节点。

3.4.2、OTN骨干设备布局与性能

核心层设备

- 设备型号:采用自研OPTN8600 X平台,支持3.2T交叉容量及ODUk-flex柔性管道(2.5G~400G可调)。

- 技术特性:

- 通过OADM(光分插复用器)实现波长级调度,减少光电转换损耗。

- 支持SRv6+EVPN协议,跨数据中心时延≤30ms(如香港-新加坡)。

- 部署规模:

- 全国部署30+核心节点,覆盖8大算力枢纽,单节点支持80×400G波道容量。

区域/城域层设备

- 设备功能:

- 结合CWDM(粗波分复用)技术下沉至边缘,支持5G前传/中传,时延≤5ms。

- 采用弹性光网络(EON)技术,频谱分配粒度达6.25GHz,适配工业物联网需求。

- 典型案例:

- 江苏交控OTN网络部署34个核心节点,构建路段中心至省联网中心的可靠链路,承载收费业务及大带宽视频传输。

3.4.3、OTN CPE设备布局与功能

企业接入层(CPE设备)

- 设备类型:智能接入网关(如SD-WAN CPE)。

- 核心功能:

- 多业务融合:支持OTN专线、云专线、互联网混合接入,通过SD-WAN实现智能选路。

- 安全隔离:采用MPLS-VPN叠加IPSec加密(AES-256-GCM),性能损耗<5%。

- 部署规模:

- 覆盖全国600+ 边缘节点(如收费站、服务区),珠三角地区2024年实现全域覆盖。

创新应用场景

- 工业互联网:在广深制造业集群部署边缘CPE,生产线质检响应速度提升300%,年省带宽成本超80万元。

- 政企专线:通过ODUk通道划分专属波长,时延抖动<1ms,满足金融交易SLA。

3.4.4、关键数据汇总

| 层级 | 节点类型 | 设备数量/规模 | 技术性能 | 地理覆盖 |

|---|---|---|---|---|

| 核心层 | 骨干节点 | 30+节点 | 80×400G波道/节点,时延≤30ms | 8大国家算力枢纽 |

| 城域层 | 边缘数据中心 | 1000+边缘节点 | 5G接入时延≤5ms,频谱粒度6.25GHz | 广深/东莞/佛山等制造业重镇 |

| 接入层 | CPE设备 | 600+服务区/收费站节点 | 支持SD-WAN智能选路,加密损耗<5% | 珠三角全域(2024年覆盖) |

3.4.5、总结:布局特点与技术优势

- 枢纽绑定国家战略:深度覆盖“东数西算”8大枢纽,西部重存储/训练(贵安、内蒙古),东部强实时业务(京津冀、长三角)。

- 骨干网高性能:OPTN8600 X设备+SRv6协议实现毫秒级跨域互联,带宽弹性可调(10G~400G)。

- CPE智能化下沉:SD-WAN CPE支持企业级安全与多云接入,珠三角“三公里覆盖圈”引领工业数字化。

- 绿色节能:西部枢纽100%使用可再生能源,PUE≤1.1(液冷技术+余热回收)。

未来方向:结合全光交换2.0与量子加密(如合肥-和林格尔专线),进一步降低时延至μs级,强化算力网络底座。

3.5 腾讯云OTN骨干设备OPTN8600 X

腾讯云OTN骨干设备OPTN8600 X是其光传送网络的核心平台,专为超大规模数据中心互联与高品质政企专线设计。以下是基于公开资料整合的具体技术参数和性能指标:

3.5.1、架构与容量

-

交叉容量

- 电层交叉容量:支持 3.2Tbps 的ODUk(光数据单元)颗粒级交叉调度能力,可扩展至更高容量。

- 光层调度:集成ROADM(可重构光分插复用器)技术,支持波长级(λ级)光交叉,减少光电转换损耗,提升传输效率。

-

槽位与业务密度

- 提供32个业务槽位,单槽位支持400G线路端口密度,单节点最大支持80×400G波道容量(总带宽32Tbps)。

- 支持混合业务接入:兼容STM-1/4/16、OTU1/2/3/4、10G/100G/400G以太网、FC(光纤通道)等协议。

3.5.2、光层性能

-

传输能力

- 调制格式:支持QPSK/16QAM/64QAM自适应调制,结合超强FEC(前向纠错)技术,无电中继传输距离达1000km(400G场景)。

- 频谱效率:采用Flex-Grid(灵活栅格)技术,频谱分配粒度低至6.25GHz,提升波长利用率30%。

-

损伤管理

- 内置光功率自动调整模块,实时监测合波功率与OSNR(光信噪比),动态补偿光纤非线性效应。

3.5.3、电层特性

-

业务隔离与封装

- 支持ODUk-flex硬管道隔离,带宽可调范围2.5G~400G,满足金融、政务等高安全需求业务。

- 采用OPUk容器透明封装,保留SDH、以太网、FC等原始协议开销,实现端到端业务无损传输。

-

低时延设计

- 电层时延≤1μs(单节点),结合光层一跳直达,跨数据中心端到端时延≤30ms(如香港-新加坡)。

3.5.4、智能管控与可靠性

-

SDN化控制平面

- 集成自研TOOP(腾讯开放光网络平台)控制器,支持1秒级全量性能数据采集(Telemetry),故障定位精度达毫秒级。

- 支持SRv6+EVPN协议,结合BGP MED属性优化跨域路径,带宽动态调整响应时间≤1分钟。

-

多层保护机制

保护层级 技术方案 恢复时间 可用性 光层 1+1波长保护 <50ms 99.999% 电层 ODUk环网保护(m:n) 1-5秒 99.99% 跨层协同 光层保护+电层重路由 首次<50ms 抗多重故障

3.5.5、关键参数总表

| 参数类别 | 指标 | 数值/特性 |

|---|---|---|

| 交叉容量 | 电层ODUk交叉 | 3.2Tbps(可扩展) |

| 业务槽位 | 最大支持槽位数 | 32槽位 |

| 单波道容量 | 线路端口速率 | 400G(支持ZR/ZR+可插拔模块) |

| 传输距离 | 无电中继距离(400G) | ≤1000km |

| 时延性能 | 单节点时延 | ≤1μs |

| 跨数据中心时延(示例) | ≤30ms(香港-新加坡) | |

| 可靠性 | 可用率(SLA) | ≥99.999% |

| 频谱效率 | 灵活栅格粒度 | 6.25GHz |

| 功耗 | 典型功耗(满载) | 约5kW(液冷优化设计) |

3.5.6、典型应用场景

- 跨算力枢纽互联:支撑“东数西算”战略,如内蒙古枢纽至安徽合肥的400G量子加密专线,时延≤5ms。

- 政企精品专线:为金融交易提供硬隔离ODUk通道,时延抖动<1ms,支持带宽无损调整。

- 云网融合:通过SDN控制器实现与天翼云/移动云的SRv6协同,承载5G切片业务。

技术优势总结:OPTN8600 X通过光电协同调度、超低时延架构及智能管控平台,成为腾讯云OTN骨干网的核心引擎。其参数设计直指“高品质传输”需求,尤其在高可靠、低时延、弹性带宽等维度领先行业标准。

3.6 TOOP(腾讯开放光网络平台)控制器

TOOP(腾讯开放光网络平台)控制器通过创新性的架构设计和核心技术优化,实现了光网络领域突破性的 1秒级全量性能数据采集 和 毫秒级故障定位。其核心机制可分为以下三部分:

3.6.1、光层流式遥测架构:实现秒级数据采集的关键

传统光网络管控依赖SNMP协议,存在数据粒度粗、设备开销大等问题。TOOP通过以下技术创新实现高精度、低开销的数据采集:

-

基于推送的流式遥测(Push-based Streaming Telemetry)

- 设备侧轻量化:将SNMP的“拉取”模式改为“推送”,遥测代理(Telemetry Agent)直接在设备线卡级周期性采集数据(如光功率、温度、增益等),推送至本地缓存(Cache),再由聚合器(Aggregator)打包后通过gRPC协议发送至控制器。此设计将计算压力从设备转移至控制器侧,设备CPU使用率仅从19%增至25%(0.1秒采集频率下),而SNMP方案会飙升至96%。

- 数据粒度精细化:支持实时值(如瞬时光功率)和累积值(如误码计数),采集频率达0.1秒级,可捕捉瞬发事件(如持续几十秒的光纤抖动)。

-

标准化模型与开放解耦

- 统一抽象逻辑层:构建光设备标准化模型(含逻辑模型与数据模型),屏蔽多厂商差异。例如,不同厂商的光放大器增益范围(15–25 dB vs 20–30 dB)被统一映射为可配置参数,控制器通过Netconf协议下发YANG文件实现无差异管控。

- 弹性采集集群:控制器侧采用分布式采集器集群,依托腾讯云资源池动态扩展,结合负载均衡应对单点故障,支撑每秒百万级数据点采集。

3.6.2、实时分析引擎:毫秒级故障定位的核心

TOOP的实时分析组件融合流式数据处理与智能算法,实现故障快速发现与根因定位:

-

动态阈值告警与事件分类

- 实时监控:对光信噪比(OSNR)、丢包率、延迟抖动等指标动态阈值检测。例如,OSNR下降超过3dB即触发告警。

- 事件类型识别:区分瞬发中断(Ephemeral Interruption, E-I)、持续劣化(Persistent Degradation, P-D)等四类事件,针对性启动定位流程。

-

故障指纹库与预测性分析

- 指纹匹配:预置光缆断裂、放大器失效等故障的特征模式(如特定功率突降+温度升高)。实时数据流与指纹库匹配,定位时间缩短至10秒内(传统方案需5分钟至数小时)。

- 因果预测:基于历史数据训练预测模型,如瞬发劣化(E-D)事件发生后,5秒内发生持续中断(P-I)的概率达20%,1分钟内升至40%,实现主动维护。

-

拓扑感知的跨层定位

- 全局拓扑视图:拓扑管理器(TopoMgr)维护光-电层设备连接关系,故障发生时结合告警传播路径快速定位根因节点(如区分光纤中断与电层板卡故障)。

3.6.3、软硬协同架构:支撑高可靠低延迟的基石

TOOP的硬件设计与控制逻辑深度协同,确保数据通路高效可靠:

-

集中式控制架构

- “国王-臣民”模型:TOC控制器统一下发策略,硬件设备(如OPC-4光层平台、TPC-4电层板卡)仅执行数据采集与转发,复杂度集中于控制器侧,降低设备OS开发风险。

- 1秒级Telemetry硬支持:OPC-4光层设备原生支持每秒全量性能数据上报(包括OCM扫描、EDFA增益、激光器偏置电流等50+参数),通过1GE专用管理通道(OSC)保障数据传输。

-

端到端优化设计

- 无源背板与热备机制:OPC-4采用无源背板减少故障点,主控单元(CU)1+1热备,电源双冗余,保障采集链路持续可用。

- 低延迟传输协议:gRPC协议替代传统SNMP,结合腾讯自研Yang模型压缩数据包头,端到端传输延迟<1ms。

3.6.4、性能对比与传统方案

| 指标 | 传统光网络系统 | TOOP方案 | 提升效果 |

|---|---|---|---|

| 数据采集频率 | 15分钟级 | 0.1~1秒级 | 精细度提升900倍 |

| 故障定位时间 | 小时/天级 | 10毫秒~60秒 | 效率提升100倍以上 |

| 设备开销 | CPU使用率96%@0.1秒采集 | CPU使用率25%@0.1秒采集 | 资源消耗降低70%+ |

| 事件检测能力 | 仅能发现持续中断 | 支持瞬发抖动、劣化事件 | 事件检出率提升200% |

注:TOOP在光纤中断定位仅需10秒,硬件故障定位缩短至2~60秒,电源故障定位从小时级降至10~30秒。

总结

TOOP的突破性在于:

- 架构革新:以“推送式流式遥测+标准化模型”替代SNMP,实现设备轻量化与数据高粒度采集;

- 算法智能:动态阈值告警与故障指纹库结合,实现亚秒级事件发现与分钟级根因定位;

- 软硬协同:从硬件原生支持1秒Telemetry到控制器分布式分析,构建端到端低延迟通路。

该技术已在腾讯全球数据中心规模部署,故障定位效率提升两个数量级,为“东数西算”等国家战略提供高可靠光网络底座。

3.7 TOOP(腾讯开放光网络平台)的流式遥测架构

TOOP(腾讯开放光网络平台)的流式遥测架构相较于传统SNMP(简单网络管理协议),在数据压缩和传输效率上实现了显著优化。其核心创新在于通过架构重构、协议革新和智能处理,解决了SNMP在高频数据采集场景下的性能瓶颈。以下是具体优化对比:

1. 数据传输机制优化

-

传统SNMP的“拉取”模式

SNMP依赖控制器主动轮询设备(通过GetRequest/GetNextRequest命令),设备响应请求后返回数据。这种方式导致:- 高延迟:每次请求需完成TCP三次握手,增加网络往返时间(RTT)。

- 资源浪费:设备需维护本地MIB数据库,频繁读写消耗CPU(0.1秒采集频率下CPU使用率可达96%)。

- 数据冗余:轮询可能重复请求未更新的数据,占用带宽。

-

TOOP的“推送”模式

设备主动将数据流式推送至控制器:- 本地缓存聚合:设备侧的Cache组件暂存原始数据,Aggregator组件按需合并数据块,减少重复传输。

- 协议轻量化:采用gRPC替代SNMP,支持二进制编码(如Protobuf),数据体积减少30–50%。

- 按需推送:仅传输变化数据或事件触发数据(如光功率突变),带宽占用降低60%。

2. 数据压缩与处理优化

-

SNMP的粗粒度处理

SNMP传输原始数据或简单聚合值,缺乏压缩能力。例如:- 光层性能数据以15分钟粒度采集,无法捕获瞬发事件(如持续几十秒的光纤抖动)。

-

TOOP的多级压缩策略

- 设备侧预处理:

- 实时值压缩:对光功率等连续数据采用差分编码(Delta Encoding),仅存储变化量而非绝对值。

- 累积值稀疏化:对误码计数等累积数据,使用稀疏表示技术(如傅里叶变换)过滤冗余。

- 控制器侧智能压缩:

- 流式LZ4算法:在传输链路中实时压缩数据流,延迟<1ms,压缩率3:1。

- 特征提取:仅推送关键指标(如OSNR异常值),非全量数据,数据量减少80%。

- 设备侧预处理:

3. 传输协议与网络效率提升

-

SNMP的协议开销

SNMP基于UDP/TCP,头部开销大(如SNMP报文含复杂OID字段),且不支持多路复用,高并发下易阻塞。 -

TOOP的协议栈增强

- 多路复用与0-RTT连接:

采用HTTP/2多路复用单连接并发传输多个数据流,减少TCP握手开销;QUIC协议(HTTP/3)实现0-RTT连接,抗丢包能力提升40%。 - 零拷贝传输:

通过sendfile系统调用绕过内核缓冲区,直接传输设备内存数据至网络,降低CPU复制开销。

- 多路复用与0-RTT连接:

4. 资源消耗对比(实测数据)

| 指标 | 传统SNMP | TOOP流式遥测 | 优化效果 |

|---|---|---|---|

| 设备CPU使用率 | 96%@0.1秒采集频率 | 25%@0.1秒采集频率 | 降低73% |

| 数据传输延迟 | 50ms+(轮询+处理延迟) | <1ms(流式推送) | 提升50倍 |

| 故障定位时间 | 小时级(依赖人工分析) | 秒级(如光纤中断10秒) | 提升100倍 |

| 事件检出率 | 仅能发现持续中断 | 支持瞬发抖动、劣化事件 | 检出率提升200% |

5. 智能策略降低冗余传输

-

动态采样机制

TOOP根据网络状态调整采集频率:- 稳定期:低频采集(如1秒粒度)。

- 异常期:自动切换至高频模式(0.1秒),捕捉瞬态事件(如E-I短期中断)。

-

预测性数据过滤

结合机器学习模型(如LSTM)预测流量峰值,仅在预测异常时触发全量数据采集,常态下推送统计摘要。

总结:TOOP的核心优化价值

TOOP通过推送式架构、流式压缩和协议革新,实现了三重突破:

- 空间效率:设备侧预处理+智能压缩减少60%带宽占用;

- 时间效率:gRPC+QUIC协议将传输延迟压至毫秒级;

- 资源效率:计算任务卸载至云端,设备CPU负载降低70%+。

这些优化使TOOP能支撑“东数西算”等国家战略所需的超低时延、高可靠光网络管控,为云服务提供毫秒级故障定位能力。未来可结合边缘计算进一步优化传输路径(如边缘节点预过滤无效数据)。

3.8 TOOP(腾讯开放光网络平台)

TOOP(腾讯开放光网络平台)作为腾讯云在“东数西算”工程中的核心网络管控系统,通过智能化的流式遥测、光电协同调度和分布式架构,显著提升了算力网络的效率与可靠性。以下是其具体应用案例及性能表现的详细分析:

3.8.1、关键应用场景与案例

-

内蒙古枢纽—京津冀跨域算力调度

- 场景需求:为满足金融、AI训练等高实时性业务需求,需实现内蒙古枢纽(和林格尔集群)与京津冀地区≤5ms的低时延互联。

- TOOP应用:

- 光电协同调度:利用TOOP的SRv6+EVPN协议动态优化路径,结合OPTN8600 X设备的400G波道能力,实现跨域数据传输时延≤5ms。

- 量子加密专线:在呼和浩特—北京骨干链路上部署量子密钥分发(QKD)系统,通过TOOP控制器实现密钥自动分发与光层加密,保障金融交易数据安全。

- 成效:支撑中国银行、华为等企业的灾备中心及AI训练业务,年处理数据量超100PB。

-

宁夏中卫—东部无人驾驶实时控制

- 场景需求:金龙汽车无人驾驶车辆需将厦门园区安防数据实时传输至中卫云数据中心处理,要求端到端时延≤100ms。

- TOOP应用:

- 流式遥测+智能选路:TOOP通过0.1秒级数据采集分析网络状态,动态选择最优路径(如经成都或武汉枢纽),结合gRPC协议压缩传输时延至85ms。

- 边缘CPE下沉:在厦门园区部署SD-WAN CPE设备,本地预处理雷达数据,减少70%上行数据量。

- 成效:支撑2000+辆无人车毫秒级响应,误判率下降40%。

-

庆阳集群—长三角AI模型训练

- 场景需求:庆阳集群需为上海、杭州的AI企业提供低成本算力,支持千卡GPU集群协同训练。

- TOOP应用:

- 算力弹性调度:TOOP将训练任务拆分为温数据(本地处理)与冷数据(庆阳处理),通过ODUk-flex通道按需分配10G~400G带宽,资源利用率提升90%。

- 绿电联动:TOOP整合环县风光电站的实时发电数据,调度算力至绿电充裕时段,PUE降至1.15。

- 成效:阿里农业云、华为渲染云等企业年节省算力成本超3000万元。

3.8.2、性能表现量化分析

| 指标 | 传统方案 | TOOP方案 | 提升效果 | 案例支撑 |

|---|---|---|---|---|

| 数据采集频率 | 15分钟级 | 0.1~1秒级 | 精细度提升900倍 | 内蒙古枢纽 |

| 跨域时延 | 30~50ms | ≤5ms(京蒙专线) | 降低80% | 金融交易专线 |

| 故障定位时间 | 小时级 | 10秒(光纤中断) | 效率提升100倍 | 庆阳集群 |

| 设备资源开销 | CPU 96%@0.1秒采集 | CPU 25%@0.1秒采集 | 降低73% | 中卫无人驾驶 |

| 算力调度响应 | 分钟级 | ≤1分钟 | 动态带宽调整实时化 | 长三角AI训练 |

3.8.4、系统扩展性与稳定性实践

-

分层解耦架构支持万级节点

- 控制平面云化:TOOP控制器部署于腾讯云全球资源池,通过分布式采集集群(如庆阳、贵阳节点)分片处理数据,单集群可扩展至100+节点,支撑8大枢纽30万+设备接入。

- 设备轻量化:光层设备(如OPC-4)仅执行数据采集,复杂度降低70%,新增节点无需改造硬件。

-

多维稳定性保障

- 光-电协同保护:结合1+1波长保护(恢复<50ms)与ODUk环网重路由,抗多重故障能力提升3倍,内蒙古枢纽2024年实现全年零业务中断。

- 动态降级机制:在2023年宁夏地震期间,TOOP自动将非关键业务(如历史数据备份)采集频率从0.1秒降至1秒,保障无人驾驶链路带宽。

3.8.5、技术突破与产业价值

- 推动国产化技术落地

- TOOP的标准化YANG模型已适配华为、中兴等国产设备,在庆阳集群实现多厂商统一管控,运维效率提升50%。

- 降低西部算力使用门槛

- 通过“算力券”机制(如成都政策)与TOOP调度系统,中小微企业可低成本调用西部算力。2024年成都位道智能等企业算力成本下降60%。

- 绿色算力范式创新

- TOOP联动青海绿电大数据中心,余热回收供暖+冷能贮存农产品,年减碳30万吨,算力GDP拉动比达1:4。

总结:TOOP在“东数西算”中的核心价值

TOOP以流式智能(毫秒级故障定位)、光电协同(5ms跨域时延)、弹性架构(万级节点扩展)三大突破,成为“东数西算”工程的技术底座。其应用不仅解决了东西部算力协同的时效性与成本问题,更通过绿色调度与国产化适配,推动算力网络向高效、低碳、自主可控演进。未来随着全光交换2.0与量子加密融合,TOOP有望进一步压缩时延至μs级,夯实国家算力一体化战略的根基。

3.9 TOOP(腾讯开放光网络平台)的“算力券”机制

TOOP(腾讯开放光网络平台)的“算力券”机制是其支撑“东数西算”工程的核心创新之一,通过将政策激励与调度系统的技术能力深度联动,实现了东西部算力资源的弹性调配与成本优化。以下从机制联动原理和具体业务流程两方面展开说明:

3.9.1、算力券与调度系统的联动机制

1. 算力券的核心属性

- 资源凭证化:算力券是政府或云服务商发放的数字化凭证,包含额度(如100 GPU小时)、适用区域(如内蒙古枢纽)、有效期、算力类型(CPU/GPU/存储)等属性。

- 策略绑定:与调度系统的策略引擎联动,例如:

- 绿色调度:优先匹配西部光伏富集时段的算力,降低PUE(如庆阳集群PUE≤1.15)。

- 成本分级:高等级券可调用低时延链路(如京蒙专线≤5ms),低等级券则调度至非实时性集群。

2. 调度系统的关键技术适配

- 差分进化算法:调度节点基于算力券的约束条件(如时延≤100ms)、服务器等级(反映节点实时负载)和任务执行时间,动态计算最优分配方案。

- 示例:AI训练任务需200 GPU小时,算法筛选出内蒙古枢纽A100节点(服务器等级S1,时延5ms)而非宁夏T4节点(等级S2,时延20ms)。

- 负载均衡嵌入:

- 权重值机制:高负载等级权重=1(优先弹出),低负载=0(备用),算力券按权重分配至高可用队列。

- 动态降级:任务执行中若节点负载超阈值(如CPU>90%),自动触发服务器等级降级(S1→S2),释放资源供高优先级券使用。

3. 资源预留与隔离

- 硬管道隔离:为高价值算力券预留ODUk-flex通道(带宽可调范围10G~400G),保障金融交易等关键业务。

- 回滚策略:若边缘节点故障(如中卫集群),任务自动回滚至备份枢纽,并通过券属性重试(如券ID标记“可迁移”)。

3.9.2、典型业务流程示例:长三角企业调用内蒙古AI算力

场景

某上海AI公司使用1000 GPU小时的算力券,训练千卡规模的LLM模型,要求时延≤30ms。

流程阶段:

-

券核验与任务提交

- 企业通过API提交任务参数:

{"task_type": "GPU训练", "duration": 80h, "data_size": "50TB", "coupon_id": "CNE20250801SH01"} - 调度系统校验券有效性(如余额、区域匹配),并解析任务需求。

- 企业通过API提交任务参数:

-

资源匹配与路径优化

- 调度算法执行:

- 输入:服务器等级表(内蒙古S1节点空闲GPU卡≥1000)、跨域时延库(沪→蒙光纤路径时延25ms)。

- 输出:选定呼和浩特集群节点N78~N182(服务器等级S1),分配ODUk-200G硬管道。

- 权重偏移:高负载节点(权重=1)优先弹出,任务插入其可用队列头部。

- 调度算法执行:

-

动态执行与容灾

- 任务执行中:

- 实时监控GPU利用率,若节点N101负载>95%,触发降级(S1→S2),邻节点接管部分任务。

- 光缆中断(TOOP流式遥测10秒定位),切换至太原备份枢纽,时延波动<3ms。

- 资源释放:

- 任务完成时,释放GPU卡并升高服务器等级(S2→S1),更新券余额为200 GPU小时。

- 任务执行中:

-

结算与效能反馈

- 系统记录实际消耗(800 GPU小时),生成绿色效能报告:

- 节省碳排放4.2吨(绿电占比70%)。

- 时延达标率99.7%,算力成本降低60%。

- 系统记录实际消耗(800 GPU小时),生成绿色效能报告:

3.9.3、关键联动技术总结

| 组件 | 算力券联动作用 | 调度系统技术支持 |

|---|---|---|

| 券属性解析引擎 | 转换政策规则为调度参数(如区域/时延/绿电) | 策略引擎实时匹配YANG模型 |

| 差分进化算法 | 基于券约束筛选最优节点 | 多目标优化(成本+时延+负载) |

| 服务器等级机制 | 动态反映节点剩余算力 | 监听资源变化,触发升/降级 |

| 负载均衡队列 | 按券优先级分配计算槽位 | 权重值偏移弹出目标块 |

| 光-电协同保护 | 保障高等级券SLA | ODUk环网+波长保护(<50ms切换) |

3.9.4、业务价值与未来演进

- 当前价值:算力券机制使西部资源利用率提升40%,中小微企业算力成本下降60%(如成都位道智能案例)。

- 演进方向:

- 智能合约化:券规则链上存证(如自动结算)。

- 量子加密融合:高安全等级券绑定QKD通道,保障政务数据跨域传输。

通过“策略-资源-路径”三层联动,TOOP的算力券机制不仅实现了东西部算力的经济调度,更成为国家算力网络普惠化与绿色化转型的核心推手。

3.10 过算力券属性解析与ODUk-flex硬管道隔离技术的深度联动

在“东数西算”工程中,TOOP架构通过算力券属性解析与ODUk-flex硬管道隔离技术的深度联动,实现对东西部算力资源的精细化调度与SLA保障。以下通过具体案例说明实现方式:

3.10.1、算力券触发硬管道隔离的核心机制

-

券属性解析引擎

当企业提交算力券时(如券IDCNE20250801SH01),调度系统解析关键参数:- 业务等级:高等级券(如金融交易类)自动标记

SLA_Level=1,触发硬管道隔离策略。 - 时延要求:若需求≤5ms(如京蒙金融专线),系统自动绑定ODUk-400G通道。

- 资源类型:GPU任务分配至西部枢纽的A100节点(如内蒙古呼和浩特集群)。

- 业务等级:高等级券(如金融交易类)自动标记

-

策略引擎动态映射

解析结果转换为YANG模型参数:path: /oduk-flex/channel parameters: bandwidth: 400G # 根据券等级动态分配 latency: ≤5ms isolation: strict # 硬管道隔离模式控制器通过Netconf协议下发至光层设备(如华为OPTN8600 X)。

3.10.2、ODUk-flex硬管道隔离技术实现

-

分层切片技术

- 物理层:单光纤划分为80个波长通道,每个波长承载一个ODUk容器(如ODU4=400G)。

- 逻辑层:ODUk-flex通过时间槽交叉(Time Slot Interleaving) 划分硬管道,确保独占带宽:

- 高等级券占用固定时隙(如Slot 1-20),禁止其他业务抢占。

- 动态调整:根据任务负载,在10G~400G范围内无中断调整带宽(如AI训练从200G升至350G)。

-

故障隔离与保护

- 1+1波长保护:为主路径(京蒙光纤)配置备份路径(经太原枢纽),切换时间<50ms。

- 量子加密增强:金融类算力券绑定QKD密钥分发通道,加密光信号在物理层隔离传输。

3.10.3、典型案例流程:上海AI公司调用内蒙古GPU算力

场景需求

- 算力券:1000 GPU小时,时延≤30ms(券ID

CNE20250801SH01)。 - 任务:千卡LLM模型训练(数据量50TB)。

实现步骤

-

资源匹配阶段

- 调度算法筛选内蒙古S1节点(空闲GPU≥1000),计算最优路径:上海→武汉→呼和浩特(时延25ms)。

- 绑定ODUk-200G硬管道,分配固定时隙Slot 5-25。

-

硬管道创建

# TOOP控制器下发ODUk配置 channel_config = { "oduk_id": "ODU-SH-HH-20250801", "bandwidth": "200G", "src_port": "Shanghai-POP-9", "dst_port": "Hohhot-GPU-Node-78", "reserved_slots": [5, 6, ..., 25] # 独占时隙 } controller.push_config(channel_config, protocol="Netconf")光层设备(OPTN8600 X)实时响应,建立端到端隔离通道。

-

动态保障与容灾

- 负载波动:当GPU利用率>95%时,自动扩容至ODUk-300G(新增Slot 26-30)。

- 光缆中断:TOOP流式遥测10秒定位故障,切换至太原备份路径(时延增至28ms,仍满足SLA)。

-

资源释放

任务完成后,时隙资源立即释放回池,算力券余额更新为200 GPU小时。

3.10.4、不同等级算力券的隔离策略对比

| 算力券等级 | 硬管道类型 | 带宽动态范围 | 保护机制 | 适用场景 |

|---|---|---|---|---|

| SLA_Level=1 | ODUk-400G | 100G~400G | 1+1波长+QKD加密 | 金融交易、无人驾驶 |

| SLA_Level=2 | ODUk-200G | 50G~200G | 1:1 ODUk环网保护 | AI训练、实时渲染 |

| SLA_Level=3 | ODUk-100G | 10G~100G | 无保护(Best Effort) | 数据备份、离线分析 |

3.10.5、核心价值与技术突破

-

关键创新

- 策略-资源联动:算力券属性直接驱动光层硬件配置,实现“以券定管道”的自动化隔离。

- 毫秒级弹性:ODUk-flex时隙动态调整技术,带宽变更时业务零中断(抖动<3ms)。

-

实测效能

- 资源利用率:内蒙古枢纽硬管道复用率提升40%,西部GPU闲置率从35%降至8%。

- 故障影响:宁夏地震期间,高等级券任务切换成功率达99.9%,时延波动控制在SLA范围内。

通过算力券与ODUk-flex的深度协同,TOOP在“东数西算”中实现了策略可定义、资源可隔离、路径可保障的算力网络范式,为跨域协同提供了确定性传输底座。未来可结合全光交换2.0技术进一步压缩时延至μs级。

3.11 ODUk-flex硬管道在动态带宽调整时实现业务零中断(即无损带宽调整),主要依赖控制平面信令协商机制、数据平面G.HAO协议的分阶段操作以及智能带宽参数管理三大核心技术

3.11.1、控制平面:信令扩展与协商机制

1. RSVP-TE信令扩展

- 重信令标识与时隙协商

首节点在RSVP-TE的PATH消息中携带:- 重信令标识:LSP属性对象(LSP_ATTRIBUTES)中特定比特位(如第5比特)置1,指示中间节点需反馈时隙信息。

- 带宽与时隙参数:在

SENDER_TSPEC对象中声明目标带宽(如37.5G),在NMC字段声明所需时隙数(如29个)。

- 失败重试机制:

若中间节点(如ODU网络入口)检测时隙不匹配(如2.5G带宽需3时隙但NMC=29仅支持2时隙),则通过PathErr消息反馈实际所需时隙数(如30)。首节点根据反馈重试(重试次数≤预设阈值)。

2. 双向连接协商

- BA字段标识操作类型:

在管理状态信息对象(ADMIN_STATUS)中设置带宽调整(BA)字段:01表示增加带宽,节点预留新增时隙;10表示减少带宽,节点协商释放时隙。

- 资源预留(RESV)消息同步:

尾节点构造RESV消息并携带调整后的时隙信息,经中间节点逐级确认后返回首节点,确保全网资源一致。

3.11.2、数据平面:G.HAO协议分阶段调整

G.HAO协议通过LCR(链路连接调整) 和 BWR(带宽调整) 两阶段实现零中断:

- LCR阶段(预配置新路径)

- 在现有业务路径旁预建新带宽的虚容器(如新增时隙通道),数据仍走原路径。

- 中间节点通过控制平面信令预留资源,但不切换业务流量。

- BWR阶段(无缝切换)

- 新路径就绪后,在单个帧周期内(如125μs)切换业务流至新容器。

- 利用ODUflex帧结构的连续性:新容器帧头与原序列严格对齐,接收端无缝重组数据。

为何零中断?

业务数据仅在帧边界切换路径,且新旧路径并存直至切换完成,无报文丢失或乱序。

3.11.3、带宽参数智能管理

1. 动态带宽标记

-

关键参数定义(通过ODUk开销的RES字节携带):

参数 功能 字节位置 0_CIR 承诺带宽(最小保障,如10M),以ODU0颗粒为单位(N×ODU0) RES字节第1-2字节 0_PIR 峰值带宽(上限,如100M),以ODU0颗粒为单位(M×ODU0) RES字节第3-4字节 实时带宽(BW) 当前业务需求带宽,周期更新(MFAS=16整数倍时) RES字节第6字节 0_ID 业务优先级(0最高),用于带宽竞争时仲裁 RES字节第5字节低4位 -

带宽调整逻辑:

graph LR A[实时带宽BW] --> B{BW ≤ 0_CIR?} B -->|是| C[按BW调整] B -->|否| D{0_CIR < BW ≤ 0_PIR?} D -->|是| E[保障0_CIR, 超量部分按0_ID优先级分配] D -->|否| F[强制限流至0_PIR]

2. OSUflex技术优化小颗粒业务

- Liquid OTN将ODUflex划分为2.4M定长PB块,映射至OSUflex帧:

- 支持2M~100G任意速率调整,时隙分配更精细;

- 消除VC12-VC4-ODUk多层封装,时延降低40%。

- 混合交叉能力:兼容传统ODUk与OSUflex业务,实现平滑升级。

3.11.4、应用场景与技术演进

1. 典型场景对比

| 场景 | 传统OTN | ODUk-flex优化方案 | 关键改进 |

|---|---|---|---|

| 金融专线增容 | 需中断后重建连接 | G.HAO双阶段调整,时延抖动<1μs | 零中断,SLA保障 |

| 云业务突发流量 | 固定带宽导致利用率<50% | 动态标记按0_ID优先级分配超额带宽 | 利用率→95% |

| 多厂商组网 | 信令不互通,手动配置 | 统一RSVP-TE扩展,自动重试机制 | 调整成功率>99% |

2. 技术演进方向

- AI预测性调整:基于LSTM模型预测流量峰值,提前触发带宽变更。

- SDN集中管控:通过ACTN接口实现跨域业务一键调整(如中国联通智能控制器)。

- 量子加密增强:高安全业务绑定QKD通道,物理层保障调整安全性。

总结

ODUk-flex硬管道的零中断调整依赖于控制面信令协商(RSVP-TE扩展+BA字段)、数据面分阶段操作(G.HAO的LCR/BWR)及智能带宽管理(0_CIR/0_PIR动态标记)三重保障。其技术本质是通过预配置资源与帧级精准切换规避业务中断,结合OSUflex进一步优化了小颗粒业务适应性。未来与AI、SDN的融合将推动动态带宽向智能化、服务化演进。

3.12 OSUflex(Optical Service Unit flexible)与传统ODUk(Optical Data Unit k)

OSUflex(Optical Service Unit flexible)与传统ODUk(Optical Data Unit k)在硬件实现上的核心区别在于容器结构、交叉机制、封装层级和资源调度方式。这些差异直接影响了光传送设备的硬件架构设计、处理效率和业务适配能力。

3.12.1、核心硬件架构差异

| 特性 | 传统ODUk | OSUflex | 硬件实现影响 |

|---|---|---|---|

| 容器结构 | 固定颗粒度(如ODU0=1.25G, ODU4=100G) | 灵活颗粒度(N×2.6Mbps,支持2M~100G任意速率) | OSUflex需支持动态时隙分配的专用芯片(如华为OSU交叉芯片) |

| 交叉机制 | 固定时隙TDM交叉,严格按序缓存转发 | 灵活时隙交叉,支持非严格时序("先到先走") | 减少缓存深度,降低单站时延70%(微秒级) |

| 封装层级 | 5层映射(如VC12→VC4→ODU0→ODU4→OTUCn) | 3层映射(OSUflex→ODUflex→OTUCn) | 减少映射处理层级,硬件逻辑简化,功耗降低50% |

| 连接规模 | 单波100G最大支持80条连接 | 单波100G支持4000条连接(提升50倍) | 交叉芯片需更大连接表项容量,支持高密度业务调度 |

| 带宽调整 | 有损调整(需业务中断) | 无损调整(G.HAO协议,预配置+帧边界切换) | 增加信令处理单元(如RSVP-TE扩展模块) |

3.12.2、关键硬件模块对比

-

容器处理单元

- ODUk:固定时隙分配器,通过预定义时隙矩阵实现业务隔离(如ODU0占用固定位置)。

- OSUflex:动态时隙切片器,支持PB块(Payload Block,2.6Mbps)级灵活拼接。例如,100M业务仅需分配38个PB块,避免ODU0的1.25G带宽浪费。

-

交叉连接芯片

- ODUk:基于SDH-like的同步交叉,需严格时序对齐,导致高缓存时延(单站>100μs)。

- OSUflex:异步交叉架构,允许业务流非按序处理,通过优先级队列实现微秒级转发(单站<10μs)。

-

映射与适配单元

- ODUk:需独立VC/PKT/OTN三平面处理硬件,增加单板种类(如VC交叉板、分组交换板)。

- OSUflex:统一OSUflex容器适配所有业务(TDM/ETH/IP),硬件平台整合为单一调度平面,减少板卡类型70%。

3.12.3、性能与效率影响

-

时延优化

- OSUflex的简化封装(3层 vs 5层)减少每站处理步骤,结合异步交叉机制,使工业控制业务端到端时延从10ms降至1ms,满足电网继电保护等严苛需求。

-

资源利用率

- ODUk:小业务(如10M E1专线)需占用整个ODU0(1.25G),利用率仅0.8%。

- OSUflex:按需分配PB块(如10M业务分配4个PB块),带宽利用率接近100%。

-

扩展性与成本

- OSUflex单芯片支持4000连接,比ODUk(80连接)减少多级复用设备需求,城域网硬件投资降低40%。

3.12.4、典型应用场景的硬件适配

-

政企小颗粒专线(2M~100M)

- ODUk:依赖PeOTN叠加VC交叉硬件,增加功耗和时延。

- OSUflex:直接通过OSU芯片处理,硬件路径更短,时延<100μs。

-

动态带宽业务(如云VR)

- ODUk:带宽调整需分钟级中断,无法适配突发流量。

- OSUflex:G.HAO协议硬件加速,20ms内完成100G~400G无损调整。

-

高密连接场景(如5G前传)

- ODUk:受限于连接数,需多设备堆叠。

- OSUflex:单光纤支持12万切片,通过大容量交叉芯片实现。

3.12.5、总结:硬件演进方向

OSUflex通过动态容器、异步交叉、统一映射三大革新,推动光传送硬件从“固定管道”向“柔性总线”演进:

- 芯片级:专用OSU处理器替代多类型交换芯片,集成度更高;

- 设备级:单板支持多业务融合,减少层级和功耗;

- 网络级:高密连接+无损调整能力,支撑算力网络灵活调度。

当前华为Liquid OTN、中兴Pixel OTN等方案已基于OSUflex硬件落地,未来fgOTN标准(10M颗粒)将进一步优化小颗粒业务效率。

四、腾讯云智能高性能网络(Intelligent High-performance Network, IHN)

4.1 腾讯云智能高性能网络(Intelligent High-performance Network, IHN)

腾讯云智能高性能网络(Intelligent High-performance Network, IHN)是专为AI大模型训练设计的网络基础设施,结合自研硬件、协议栈和算法机制,在单数据中心与跨数据中心场景中提供超高带宽、超低时延、零丢包的通信能力。以下从整体设计、算法机制、交换机流控、服务器配置等维度详细解析:

4.1.1、单数据中心设计方案

1. 架构核心

-

多轨道流量聚合架构

- 将不同服务器上相同位置的网卡归属到同一接入层交换机(ToR),实现流量亲和性调度,避免跨交换机通信。

- 拓扑示例:

服务器A(网卡1)→ ToR交换机1 服务器B(网卡1)→ ToR交换机1 服务器A(网卡2)→ ToR交换机2 - 优势:减少跨层级传输,提升通信效率30%以上。

-

硬件底座

- 自研白盒交换机:单节点支持51.2T吞吐,采用BR4光模块(抗干扰、低误码率)。

- 计算节点带宽:每节点1.6T/3.2T,每GPU卡400Gbps接入带宽,较传统网络提升10倍。

2. 协议与算法

- 自研TiTa协议

- 动态拥塞控制:实时监测网络状态,通过优先级标签(Msg with prio tag)调度流量,高优先级数据包(如梯度同步)优先转发。

- 90%负载下零丢包:结合AIQCN算法动态调整源端发送速率,消除拥塞。

- 定制通信库TCCL

- 微秒级网络质量感知,动态分配通信通道,降低时延40%。

- 支持拓扑感知调度,优化All-to-All通信性能。

4.1.2、跨数据中心设计方案

1. 全局网络互联

- 云联网(CCN)与对等连接(PC)

- 支持VPC、黑石网络、基础网络异构互通,实现跨地域资源低时延互通(时延<50ms)。

- 应用场景:

- 两地三中心容灾:数据跨地域备份,故障秒级切换。

- 全球同服游戏:玩家就近接入,通过BGP智能路由降低跨国时延。

2. 数据同步优化

- 混合云存储架构

- 本地并行存储系统缓存热数据,冷数据存于云对象存储(COS),通过统一命名空间管理。

- 数据预取算法:根据训练任务需求,提前将数据从COS拉取至本地高速存储,减少广域网访问。

4.1.3、算法机制与代码实现

1. 核心算法

- HARP协议(高可用可靠传输)

- 确定性多路径传输:选择物理路径不重叠的多条通道并行传输,单交换机故障时100μs内切换路径,连接存活率100%。

- 拥塞控制PEAD:基于概率ECN感知拥塞,对比传统TCP降低p99时延90%。

- 连接复用技术

- 支持主机级共享连接(如10K节点仅需10K条连接),解决RoCEv2连接数瓶颈问题。

2. 代码级实现

- TCCL库优化逻辑

# 伪代码:拓扑感知通信调度 def schedule_allreduce(gpu_topology): if same_rack(gpu_topology): # 同机架内通信 use_intra_rack_path() else: # 跨机架通信 select_lowest_latency_path() apply_tita_qos_priority() # TiTa协议优先级标记 - TiTa协议硬件卸载:在自研玄灵网卡实现协议栈Offload,减少CPU开销。

4.1.4、交换机流控与协议机制

1. 流控机制

- 全局拥塞调度

- 基于PFC(Priority Flow Control)和ECN(Explicit Congestion Notification)实现逐流控速,避免缓存溢出。

- 腾讯优化:结合iLossless智能无损算法,感知AI训练流量特征,动态调整水线。

- 多层级流量整形

- ToR交换机:本地流量聚合,采用虚拟队列(VIQ)隔离不同优先级流量。

- Spine交换机:基于TiTa协议实施分级QoS,保障高优先级数据(如梯度同步)零排队。

2. 协议选择

- RDMA over Converged Ethernet (RoCEv2)

- 默认采用RoCEv2,结合自研TiTa协议增强拥塞控制和多路径支持。

- 替代方案对比:

协议 优势 局限 TCP 兼容性好 高时延,CPU占用高 RoCEv2 低时延,硬件卸载 连接数受限 HARP 高可用+多路径+高扩展性 需定制网卡支持

4.1.5、服务器配置方法与算法

1. GPU服务器配置

- 拓扑感知部署

- 算法:基于Kubernetes调度器扩展,按GPU网卡位置分配任务,确保同任务GPU位于同一ToR下。

- 配置示例:

# Kubernetes Node Affinity配置 affinity: nodeAffinity: requiredDuringSchedulingIgnoredDuringExecution: nodeSelectorTerms: - matchExpressions: - key: topology.ihn.tencent/rack operator: In values: ["rack-01"]

- 资源隔离

- 通过cgroups限制非训练进程资源占用,保障GPU通信带宽。

2. 性能调优算法

- 动态带宽分配

- 基于TCCL库实时监测网络负载,动态调整QP(Queue Pair)的发送速率。

- 公式:

发送速率 = min(链路容量, 基础速率 × (1 - 丢包率/阈值))。

- 故障自愈机制

- 端网协同监控:服务器网卡主动探测路径质量,故障时触发HARP多路径切换(百微秒级)。

总结

腾讯云IHN的核心价值在于 “端网协同” :

- 单数据中心:通过多轨道架构、TiTa协议、TCCL库实现90%负载下零丢包,通信效率提升40%。

- 跨数据中心:依托云联网+混合云存储,实现数据同步时延优化50%以上。

- 创新点:HARP协议解决大规模集群连接数与可靠性瓶颈,交换机流控算法(如iLossless)实现微秒级拥塞响应。

配置建议:AI训练场景选择GN10X实例(NVIDIA A100 GPU)+ 3.2T网络带宽,通过TCCL库启用拓扑感知调度,并部署混合云存储缓存热数据。

4.2 TiTa(Tencent intelligent Transport Acceleration)协议与HARP(Highly Available and Reliable Protocol)协议

TiTa(Tencent intelligent Transport Acceleration)协议与HARP(Highly Available and Reliable Protocol)协议是腾讯云自研的两大核心网络协议,分别针对不同层次的网络性能问题设计。它们在具体实现上的关键区别主要体现在目标场景、协议层级、核心机制及技术优化方向上。以下从四个维度展开对比分析:

1. 协议定位与目标场景

-

TiTa协议:

- 定位:端侧(网卡级)主动拥塞控制协议,优化数据传输的实时调度。

- 场景:专为AI大模型训练设计,解决GPU集群间高并发通信的拥塞问题,尤其适用于MoE(混合专家)模型等同步密集型任务。

- 目标:通过智能速率调节避免网络拥堵,最大化带宽利用率,降低通信延迟。

-

HARP协议:

- 定位:传输层协议,提供高可用、高扩展的端到端可靠传输。

- 场景:适用于数据库(如TDSQL-C)、分布式存储(CBS)、高性能计算(HPC)等对连接可靠性和规模扩展性要求高的场景。

- 目标:解决传统协议(TCP/RDMA)的连接数限制、故障恢复慢等问题,实现微秒级故障切换和百万级连接支持。

2. 核心架构与部署层级

| 维度 | TiTa协议 | HARP协议 |

|---|---|---|

| 部署位置 | 端侧网卡(如腾讯自研CNIC网卡) | 智能网卡硬件卸载 + 用户态软件栈 |

| 协议层级 | 传输层拥塞控制算法(位于RoCEv2/UDP之上) | 完整传输层协议(替代TCP/RDMA) |

| 架构特点 | 分布式部署于各节点网卡,主动探测网络状态 | 软硬分层:事务层(软件) + 可靠传输层(硬件卸载) |

- 关键区别:

- TiTa是增强型控制算法,依赖底层传输协议(如RoCEv2)提供基础连接;HARP是独立传输协议,直接替代传统协议栈。

3. 关键技术机制对比

拥塞控制

-

TiTa:

- 主动式算法:基于实时网络状态预测拥塞,动态调整发送速率(如通过RTT探测),避免传统ECN的被动响应。

- 效果:在星脉网络2.0中,MoE训练通信效率提升30%,训练效率提升10%。

-

HARP:

- PEAD算法:基于概率ECN精确感知拥塞,结合确定性多路径调度规避热点链路。

- 效果:时延P99降低90%,单交换机故障下连接存活率100%。

连接管理

- TiTa:不改变连接模型,依赖底层协议(如RoCEv2)管理连接,优化点在流量调度。

- HARP:

- 共享连接机制:支持主机级/IP对级连接复用(如10万节点仅需10K条连接),彻底解决RoCEv2的1.6万连接数瓶颈。

- 多路径冗余:物理不重叠路径并行传输,故障切换时间≤100μs(TCP需1秒)。

容错与扩展性

- TiTa:通过快速拥塞自愈提升稳定性,但依赖底层协议可靠性。

- HARP:

- 硬件卸载:协议栈(重传、拥塞控制)卸载至智能网卡,CPU负载降低40%。

- 扩展性:支持10K+节点组网,新增节点无需重构拓扑。

4. 性能优化与落地效果

| 指标 | TiTa协议 | HARP协议 |

|---|---|---|

| 通信效率提升 | MoE训练提升30% | 数据库写操作提升72%(OLTP场景) |

| 故障恢复时间 | 拥塞自愈毫秒级 | 路径切换≤100μs |

| 适用规模 | 10万卡GPU集群 | 10K+节点数据库集群 |

| 硬件依赖 | 自研CNIC网卡(FPGA) | 玄灵/银杉智能网卡(全协议卸载) |

- 典型场景:

- TiTa:腾讯混元大模型训练(星脉网络2.0)。

- HARP:TDSQL-C数据库(写性能提升72%)、云硬盘CBS(高可用存储)。

总结:核心差异与协同价值

- 本质区别:

TiTa是拥塞控制优化层,提升现有协议的实时效率;HARP是传输层替代协议,重构连接管理与可靠性基础。二者可协同部署(如HARP提供连接,TiTa优化调度)。 - 选择建议:

- AI训练集群:优先TiTa + RoCEv2(低延迟通信)。

- 数据库/存储系统:采用HARP(高可用+扩展性)。

- 未来演进:腾讯星脉网络3.0可能整合二者优势,构建端网协同的“零拥塞+全冗余”传输体系。

4.3 腾讯云星脉网络2.0的高性能计算集群(HCC)中TiTa(端侧拥塞控制协议)与HARP(传输层高可用协议)通过分层协同,共同优化AI训练任务的全流程

在腾讯云星脉网络2.0的高性能计算集群(HCC)中,TiTa(端侧拥塞控制协议)与HARP(传输层高可用协议)通过分层协同,共同优化AI训练任务的全流程。以下以10万卡规模的MoE(混合专家)模型训练为例,说明二者协同工作的具体流程:

1. 训练准备阶段:连接建立与路径初始化

- HARP角色:

- 多路径冗余初始化:在训练启动时,HARP为每对计算节点(如Worker 0与Worker 1)建立3条物理隔离的传输路径(Path A/B/C),确保单交换机故障不影响通信。

- 主机级连接复用:将10万GPU卡通信抽象为10K条主机级连接(每节点1条),而非传统RoCEv2的100万条连接(10万卡×10进程),解决连接数瓶颈。

- TiTa角色:

- 拓扑感知路径预选:基于GPU位置(同机架/跨机架)为不同通信模式(AllReduce、All-to-All)预选低时延路径(如AllReduce优先同机架Path A)。

协同效果:训练启动时间缩短40%,连接建立耗时从分钟级降至秒级。

2. 前向计算与梯度同步阶段:动态流量调度

- TiTa主动拥塞控制:

- 实时监测路径状态(如Path B的RTT突增50%),动态降低发送速率(公式:

新速率 = 基础速率 × (1 - 丢包率/阈值)),避免拥塞丢包。 - 为梯度同步流量标记最高优先级(Prio=0),确保HARP的QoS机制优先转发。

- 实时监测路径状态(如Path B的RTT突增50%),动态降低发送速率(公式:

- HARP多路径负载均衡:

- 将单条梯度同步流拆分为多微流(Micro-flow),通过TiTa提供的路径质量数据分配带宽(如Path A:60%、Path C:40%)。

- 硬件卸载重传逻辑:网卡直接处理乱序报文,CPU占用率降低40%。

协同效果:90%网络负载下梯度同步0丢包,通信占比从15%降至6%。

3. 参数更新阶段:高可用保障

- 交换机故障场景(突发):

- HARP百微秒级切换:检测到Path A所在交换机故障后,在100μs内将流量切换至Path B/C,连接保持0中断。

- TiTa拥塞自愈:切换后短暂拥塞时,TiTa主动将发送速率降至50%,2ms内恢复至90%带宽利用率。

- 慢节点检测:

- TiTa发现Worker 3响应延迟激增(>P99时延),通过HARP的PEAD算法(概率ECN)全局限流,避免拥塞扩散。

协同效果:单交换机故障时训练中断时间<1秒,MoE模型训练效率整体提升20%。

4. 通信库桥接:TCCL的关键作用

腾讯自研TCCL通信库(高性能集合通信库)作为协议协同的桥梁:

- 接口统一化:将TiTa的拓扑调度指令(如

select_lowest_latency_path())转换为HARP的多路径传输请求。 - 自适应优化:通过Auto-Tune算法动态调整TiTa的速率参数与HARP的路径权重,匹配MoE模型的动态通信模式。

# TCCL伪代码示例:协同调度梯度同步

def allreduce(gradients):

path = tita.select_path(gpu_topology) # TiTa选择最优路径

harp_stream = harp.create_stream(paths=[path], priority=0) # HARP创建高优先级流

tita.adjust_rate(harp_stream.metrics) # 根据HARP流指标调整速率

harp_stream.send(gradients) # 通过HARP发送5. 端到端协同价值总结

| 训练阶段 | TiTa贡献 | HARP贡献 | 性能提升 |

|---|---|---|---|

| 连接建立 | 拓扑感知路径预选 | 主机级连接复用+多路径冗余 | 启动加速40% |

| 梯度同步 | 动态速率调整+优先级标记 | 微流负载均衡+硬件卸载 | 通信占比降至6% |

| 故障恢复 | 拥塞自愈(2ms恢复) | 百微秒级路径切换 | 训练中断<1秒 |

| 资源利用率 | 带宽自适应算法 | 10万卡仅需10K连接 | GPU利用率提升40% |

实际部署配置示例(TI-ONE平台)

# 分布式训练任务配置

resource:

instance_type: HCC-10x(A100 8-GPU) # 3.2T带宽节点

node_count: 12500 # 10万卡规模

protocol:

net_protocol: "HARP_TiTA" # 启用协同模式

harp_conn_mode: "host_level" # 主机级连接复用

env:

- name: TCCL_TOPO_AWARE # TCCL拓扑感知

value: "1"

- name: TiTa_CONGESTION_THRESHOLD # TiTa拥塞阈值

value: "0.05" # 丢包率>5%触发降速运维监控:通过星脉运营系统实时跟踪TiTa拥塞自愈时间(要求≤10ms)和HARP路径存活率(要求≥99.99%)。

腾讯云通过TiTa与HARP的“端网协同”,在10万卡MoE训练中将通信效率提升60%,故障恢复效率提升百倍,实现90%负载下零丢包的高效训练环境。

4.4 TiTa(Tencent Intelligent Transport Acceleration)协议通过拓扑感知路由、动态优先级调度和端网协同算法

在MoE(Mixture of Experts)模型的分布式训练中,TiTa(Tencent Intelligent Transport Acceleration)协议通过拓扑感知路由、动态优先级调度和端网协同算法,针对不同通信模式(如AllReduce、All-to-All)的特性优化路径选择策略,显著降低通信延迟并提升带宽利用率。以下是其核心机制的分场景解析:

4.4.1、TiTa协议动态调整的三大基础

-

拓扑感知架构(多轨道流量聚合)

- 物理层将网络划分为8个独立轨道平面,每个轨道对应服务器上相同位置的网卡,并通过专属ToR交换机隔离流量。

- 路径预选:TiTa基于GPU位置(同机架/跨机架)预加载最优路径映射表,例如同机架GPU默认分配至同一轨道平面。

-

通信模式特征分析

通信模式 流量特征 对路径需求 AllReduce 梯度同步,数据量均匀 低时延、高聚合带宽 All-to-All 专家参数分发,流量不均衡 多路径负载均衡、避免热点 -

TCCL通信库的桥接作用

- 实时分析通信模式类型(如AllReduce或All-to-All),动态调用TiTa的路径选择接口。

4.4.2、分通信模式的动态路径策略

1. AllReduce场景(梯度同步)

- 策略核心:轨道内聚合 + 低时延优先

- 同机架亲和性调度:若参与AllReduce的GPU位于同一机架,TCCL触发

intra_rack_path(),强制流量在单一轨道平面内完成聚合,仅经一级ToR交换机(跳数减少50%)。 - 跨机架动态选路:TiTa实时监测各路径的RTT与缓存占用率,选择时延最低的路径(如避开高负载的Spine层链路),并通过QoS标记为最高优先级(Prio=0),确保零排队。

- 性能收益:通信时延降低40%,万卡规模下梯度同步耗时占比仅6%(行业平均10%)。

- 同机架亲和性调度:若参与AllReduce的GPU位于同一机架,TCCL触发

2. All-to-All场景(专家参数分发)

- 策略核心:异构网络协同 + 微流拆分

- 机内-机间联合优化:

- 步骤1:源GPU通过机内NVLink将数据转发至同节点目标位置GPU(如Host1的GPU1 → Host1的GPU8)。

- 步骤2:目标GPU通过机间RDMA将数据发送至远端服务器的同位置GPU(如Host1的GPU8 → Host2的GPU8),确保跨轨道流量仍走亲和路径。

graph LR A[Host1-GPU1] -- NVLink --> B[Host1-GPU8] B -- RDMA轨道亲和 --> C[Host2-GPU8] - 动态微流拆分:TiTa将大流拆分为微流(Micro-flow),根据实时路径质量分配权重(如Path A负载60%、Path C负载40%),避免单一路径拥塞。

- 性能收益:All-to-All通信效率提升27%,中小数据包传输性能提高30%。

- 机内-机间联合优化:

4.4.3、TiTa的智能调度算法

-

动态拥塞控制(AIQCN)

- 输入:交换机缓存占用率、路径RTT抖动、丢包率。

- 决策:

# 伪代码:发送速率调整 def adjust_rate(metrics): if metrics.loss_rate > 0.05: # 丢包率阈值触发降速 new_rate = base_rate * (1 - loss_rate / 0.1) elif metrics.rtt_jitter < 5us: # 低抖动时抢占空闲带宽 new_rate = min(link_capacity, base_rate * 1.2) - 效果:90%网络负载下实现零丢包。

-

故障场景的路径自愈

- 若检测到路径故障(如交换机丢包激增),TiTa在10ms内切换至备份路径,并配合HARP协议实现百微秒级物理路径切换。

4.4.4、协同优化与实测效果

| 通信模式 | TiTa优化策略 | 协同组件 | 性能提升 |

|---|---|---|---|

| AllReduce | 轨道亲和 + QoS优先级 | TCCL拓扑感知 | 时延↓40%,占比↓至6% |

| All-to-All | 异构网络协同 + 微流拆分 | HARP多路径冗余 | 效率↑27% |

典型场景效果:

- MoE训练:TiTa动态调度All-to-All专家分发流量,结合TCCL的Auto-Tune算法,使MoE模型训练效率提升10%。

- 大规模集群:在10万卡集群中,TiTa协议将通信抖动控制在微秒级,GPU利用率提升40%。

总结

TiTa协议通过“物理拓扑划分-通信模式适配-动态算法调控”三层机制,实现了通信路径的精准调度:

- AllReduce:以轨道亲和性+低时延优先为核心,减少跨设备跳数;

- All-to-All:借异构网络协同+微流拆分化解流量不均衡,避免热点路径;

- 全局保障:结合AIQCN拥塞控制与HARP多路径冗余,在超大规模集群中实现高吞吐、零丢包的“赛车级”网络体验。

未来腾讯星脉网络3.0将进一步融合AI驱动的流量预测(如预判专家分发路径),实现纳秒级动态调优。

4.5 不同规模(1000卡与10万卡)的AI算力集群需求

腾讯云针对不同规模(1000卡与10万卡)的AI算力集群需求,设计了差异化的高性能数据中心方案,核心围绕网络架构、协议优化、资源调度和运维体系展开。以下分规模详解设计方案:

4.5.1、1000卡规模:三级CLOS架构与智能无损网络

1. 网络架构

- 三级CLOS拓扑

- 接入层:8台GPU服务器(每台8卡)接入1台TOR交换机,单服务器带宽1.6T(双轨设计,每轨400G)。

- 汇聚层:Spine交换机通过400G链路全互联TOR,避免跨机架流量阻塞。

- 核心层:支持多POD扩展,单集群最大支持16K GPU(1000卡无需超级主干层)。

- 硬件配置:

- 自研25.6T白盒交换机,支持RDMA RoCEv2卸载;

- 服务器搭载NVIDIA A100/H100 GPU + 双端口400G网卡。

2. 协议与算法优化

- TiTa协议动态拥塞控制:

- 实时监测链路状态(RTT、丢包率),动态调整发送速率,确保90%负载下零丢包。

- 为梯度同步流量标记最高优先级(Prio=0),通过QoS保障关键通信。

- TCCL通信库优化:

- 基于NCCL扩展,支持拓扑感知调度(如AllReduce优先同机架路径),通信时延降低40%。

3. 容错与运维

- 快速故障定位:端网协同监控系统实现600ms内故障感知,5分钟恢复。

- 资源隔离:通过cgroups限制非训练任务资源占用,保障GPU通信带宽。

4.5.2、10万卡规模:多轨道架构与超大规模扩展

1. 核心创新:多轨道流量聚合

- 物理分平面设计:

- 将10万卡划分为8个独立“轨道”,每个轨道对应服务器固定位置的网卡,归属同一组TOR交换机。

- 优势:80%流量(如机架内AllReduce)在轨道内完成(仅经1级交换机),跨轨道流量仅占20%,大幅降低核心层压力。

- 带宽升级:单节点带宽达3.2T(8×400G),支持200G/400G硅光模块。

2. 协议与连接管理

- HARP协议解决连接数瓶颈:

- 主机级连接复用:10万卡仅需10K条连接(传统RoCEv2需百万级),避免协议栈崩溃。

- 多路径冗余:单链路故障时100μs切换路径,连接存活率100%。

- TiTa+HARP协同:

- TiTa动态分配流量权重,HARP提供物理路径保障,协同降低MoE训练通信占比至6%。

3. 超大规模运维体系

- 自动化部署:千卡集群建设时间从19天压缩至4.5天,配置准确率100%。

- 智能自愈系统(HASHDODGING):

- 基于Hash偏移算法实现路径秒级切换,支持静默丢包场景的无感恢复。

- 立体监控:端到端全链路追踪,支持毫秒级延时分析及全局拥塞热点可视化。

4.5.3、共用技术体系

1. 异构网络融合

- 机内+机间联合优化:

- 机内:NVLink实现GPU直连(带宽900GB/s);

- 机间:RDMA跨节点通信,通过TCCL库智能选择路径(如小数据走机内、大数据走机间)。

- 效果:All-to-All通信性能提升30%。

2. 计算-存储协同

- 混合云存储架构:

- 热数据存本地NVMe SSD(IOPS 100万+),冷数据存COS对象存储,通过预取算法减少跨域访问。

- 向量数据库支持:TI平台集成向量检索,加速大模型embedding处理。

3. 资源调度算法

- Kubernetes拓扑感知调度:

affinity: nodeAffinity: requiredDuringSchedulingIgnoredDuringExecution: nodeSelectorTerms: - matchExpressions: - key: topology.ihn.tencent/rack operator: In values: ["rack-01"] # 强制同机架任务分配- 结合AngelPTM框架自动切分流水并行任务,负载均衡误差<5%。

4.5.4、方案对比与实测性能

| 维度 | 1000卡方案 | 10万卡方案 |

|---|---|---|

| 网络架构 | 三级CLOS | 多轨道聚合+分级CLOS |

| 单节点带宽 | 1.6T | 3.2T |

| 协议栈 | TiTa + RoCEv2 | TiTa + HARP协同 |

| 连接数优化 | 单节点多连接 | 主机级复用(10万卡→10K连接) |

| 故障恢复 | 5分钟 | ≤100μs路径切换 + 秒级自愈 |

| 通信占比 | ≤10% | ≤6% |

| 部署周期 | 7天 | 30天内(千卡级) |

实测效果:

- 训练效率:10万卡集群GPU利用率达90%(传统方案60%),MoE训练速度提升30%;

- 成本优化:模型训练总成本降低30%~60%。

总结:腾讯云方案的核心竞争力

- 网络革新:

- 多轨道架构破解超大规模流量瓶颈,物理分平面设计实现近端流量高聚合。

- 协议协同:

- TiTa+HARP分层管控:TiTa优化流量调度,HARP保障连接可靠,共筑90%利用率无损网络。

- 软硬一体:

- 自研交换机(51.2T容量)+ 智能网卡卸载,端到端时延降至2μs。

- 智能运维:

- 建设-控制-运维全栈自动化,千卡部署效率提升4倍,故障定位从小时级缩至分钟级。

选型建议:

- 1000卡级:适用中型模型训练,侧重TiTa协议+CLOS架构性价比;

- 10万卡级:大型MoE/多模态训练必选,需启用多轨道架构+HARP协议化解连接与扩展性瓶颈。

4.6 云骨干网多层次优化策略

腾讯云骨干网(特别是其面向AI大模型训练的“星脉高性能计算网络”)通过多层次优化策略,显著提升了大规模GPU集群的训练效率。以下是其核心组网优化策略及技术实现:

4.6.1、硬件层优化:构建超高性能物理底座

-

全自研网络设备

- 3.2T超高带宽互联:每个GPU节点配备8张自研400G RDMA网卡,整机带宽达3.2T,为业界最高水平,满足百GB级梯度同步需求。

- 51.2T大容量交换机:自研交换机支持400G硅光模块,单芯片容量升级至51.2T,时延降低40%,支持超10万卡组网。

- 异构网络融合:整合机内NVLink(最高900GB/s)与机间RDMA网络,通过多轨道架构将跨节点通信转化为同卡号直连,减少跳数,All-to-All性能提升30%。

-

Rail-Only精简架构

- 采用单层Clos拓扑(Rail-Only),替代传统三层CLOS架构:

- 传统方案:32768 GPU需1280台交换机、196608个光模块,跨节点通信5跳;

- 星脉方案:同等规模仅需256台交换机、65536光模块,跨节点通信1跳,成本降低75%。

- 流量亲和性规划:相同编号GPU直连同一Leaf交换机,结合NCCL的Rail Local技术,避免跨轨道通信。

- 采用单层Clos拓扑(Rail-Only),替代传统三层CLOS架构:

4.6.2、协议与通信层:端网协同加速

-

自研TiTa端网协同协议

- 主动拥塞控制算法:从交换机迁移至网卡端,实时监控网络状态,动态调整发包速率,实现90%负载下零丢包(传统以太网丢包导致50%算力损失)。

- 低时延保障:端到端时延降至10–40μs(传统网络500μs–1ms),通信抖动减少85%。

-

定制通信库TCCL

- 优化集合通信操作:针对AllReduce、AllGather等操作,相比NCCL提升40%性能,支持动态通道调度与拓扑感知。

- 异构并行通信:结合NVLINK+NET混合通道,MoE模型训练效率提升10%。

- 无缝兼容性:接口与原生通信库一致,用户无需修改代码即可适配。

4.6.3、架构设计:分离式流量与高扩展组网

-

东西向/南北向流量分离

- 计算平面:独立承载东西向训练流量(如GPU间梯度同步),采用无阻塞胖树(Fat-Tree)架构,负载率>90%(传统网络仅60%)。

- 管理平面:处理南北向用户访问与存储IO,避免业务流量干扰训练任务。

-

分级可扩展集群

- Block-Pod-Cluster模型:

- 每Block:256 GPU;

- 每Pod:16–64 Block(4K–16K GPU);

- 每Cluster:16 Pod(最大256K GPU),支持10万卡线性扩展。

- 多轨道聚合架构:8个独立通信平面并行传输,85%流量限于轨道内(仅经1级ToR交换机)。

- Block-Pod-Cluster模型:

4.6.4、智能运维与高可用保障

-

端网一体化部署

- 自动化配置:一键下发RDMA/PFC/ECN等复杂参数,部署时间从19天缩减至4.5天,配置准确率100%。

- 灵境仿真平台:万卡级训练故障分钟级定位,支持GPU节点级问题诊断。

-

秒级故障自愈(Hash Dodging)

- 业务主动避障:端侧协议栈实时检测吞吐/丢包(<600ms),通过Hash偏移切换路径,故障切换<1秒。

- 1+1光层保护:骨干网波长级冗余,中断倒换<50ms。

4.6.5、实测效能与行业价值

| 指标 | 传统方案 | 星脉优化后 | 提升效果 |

|---|---|---|---|

| 通信带宽 | ≤800G | 3.2T/节点 | 4倍 |

| 训练通信占比 | 10%–50% | ≤6% | 算力损失减少44% |

| GPU利用率 | 50%–60% | **>90%** | 提升40% |

| 万卡训练成本 | 基准值 | 降低30%–60% |

总结:星脉网络的核心突破

腾讯云通过 “全自研硬件(交换机/网卡)+ 软硬协同协议(TiTa/TCCL)+ 精简拓扑(Rail-Only)” 三位一体,实现了:

- 极致性能:3.2T带宽、μs级时延、90%利用率突破物理极限;

- 规模经济:万卡组网成本降75%,训练效率提3倍;

- 智能韧性:从部署、监控到自愈的全生命周期自动化。

这些优化使腾讯云HCC集群支持混元万亿参数大模型训练时间从50天缩至4天,为AI大模型提供“无带宽瓶颈、无丢包风险、无运维负担”的确定性网络底座。

4.7 GPU利用率从传统网络的50%提升至90%以上

腾讯云星脉网络通过软硬协同的架构创新,将GPU利用率从传统网络的50%提升至90%以上,核心技术手段分为以下四个层面:

4.7.1、硬件层:超高性能物理底座

-

3.2T整机通信带宽

- 每台GPU服务器配备8张自研400G RDMA网卡,整机带宽达3.2T(业界最高),是传统方案(800G)的4倍,彻底消除GPU间通信瓶颈。

- 自研硅光模块升级至400G速率,时延降低40%,支持单集群10万卡组网(传统方案仅支持万卡级)。

-

Rail-Only精简拓扑

- 采用单层Clos架构替代传统三层架构:

- 同序号GPU直连同一Leaf交换机,跨节点通信仅需1跳(传统方案需5跳);

- 减少75%光模块用量,85%流量局限在单轨道内,避免跨Block拥塞。

- 采用单层Clos架构替代传统三层架构:

4.7.2、协议层:端网协同拥塞控制

-

TiTa 2.0主动拥塞控制

- 将协议栈从交换机下沉至网卡端,实时监测流量并动态调整发包速率,实现90%负载下零丢包(传统以太网丢包导致50%算力损失)。

- 采用主动预测算法,提前规避拥塞,MoE模型训练通信性能提升30%。

-

无损网络保障

- 基于RoCEv2+PFC构建无损传输层,结合DCQCN动态水线控制,保障高吞吐通信。

- 端到端时延降至10–40μs(传统方案500μs–1ms),通信抖动减少85%。

4.7.3、通信库层:拓扑感知与异构调度

-

TCCL 2.0拓扑感知路径规划

- 动态重构通信环:解析服务器拓扑与Block分布,优先同Block内GPU互联,跨Block流量降低50%。

- 确定性QP连接管理:实时采集ECMP哈希策略,为数据流分配正交源端口,彻底解决哈希冲突。

-

NVLink+NET异构并行

- 混合调度机内NVLink(900GB/s)与机间RDMA网络,通过动态滑动窗口机制按带宽比例分配数据量,异构带宽利用率达95%。

- Auto-Tune自适应算法根据模型规模自动优化数据包分割参数,通信时延再降40%。

4.7.4、运维层:智能监控与故障自愈

-

灵境仿真平台

- 实现GPU节点级故障定位,万卡集群故障排查时间从天级缩至分钟级。

- 360度立体监控网络状态与GPU计算效率,快速识别慢节点。

-

Hash Dodging秒级避障

- 端侧协议栈实时检测吞吐异常(<600ms),通过哈希偏移切换路径,故障切换<1秒,训练中断趋近于零。

效能对比与行业价值

| 指标 | 传统方案 | 星脉网络优化后 | 提升效果 |

|---|---|---|---|

| 通信占比 | ≤50% | ≤6% | 算力损失↓44% |

| 单任务最大GPU规模 | ≤1万卡 | 10万卡 | 扩容10倍 |

| 训练周期(万亿模型) | 50天 | 40天 | 效率↑20% |

| 故障恢复时间 | 天级 | 分钟级 | 运维效率↑99% |

技术本质:打破“通信墙”与“故障墙”

星脉网络通过:

- 硬件革新 → 突破带宽物理极限;

- 协议下沉 → 实现μs级精准控流;

- 拓扑感知 → 重构最优通信路径;

- 秒级自愈 → 保障连续训练。

四重技术闭环将GPU等待时间压缩90%,推动AI训练从“算力饥渴”迈向“通信零瓶颈”时代。当前已支持腾讯混元万亿MoE模型训练效率提升3倍,为80%头部大模型企业提供底层网络服务。

4.8 Rail-Only架构

Rail-Only架构通过重构网络拓扑、优化流量路径和精简硬件设计,显著提升了超大规模GPU集群的可扩展性。以下是其核心技术手段及解决扩展性问题的具体机制:

🔧 一、拓扑重构:打破传统Clos网络的扩展瓶颈

-

移除Spine层,实现单级交换

- 传统Clos网络需Spine交换机实现跨Rail通信,导致硬件成本与跳数随规模线性增长。Rail-Only完全移除Spine层,仅保留Rail交换机(即Leaf层),使跨HB域的同Rank GPU直连同一Rail交换机,通信仅需1跳(传统方案需3-5跳)。

- 扩展成本对比:

- 传统方案(32768 GPU):需2560台交换机、19.6万光模块;

- Rail-Only方案:仅需256台交换机、6.5万光模块,成本降低77%,功耗降低75%。

-

动态光层互联支持横向扩展

- 通过可重构光交换机(OCS) 连接不同Rail,添加新GPU组时仅需调整光路,无需重新布线。例如,谷歌Dragonfly+拓扑结合OCS,支持10万GPU集群的光层动态扩展。

📊 二、流量优化:匹配LLM训练的稀疏通信模式

-

利用LLM流量的天然稀疏性

- 分析显示,GPT-3/OPT-175B等模型训练中,99%的GPU对之间无通信流量,仅0.25%的GPU对承载90%以上数据。Rail-Only仅保留这些关键链路,避免传统Any-to-Any网络的冗余连接。

-

层次化集合通信算法

- 将数据并行(DP)的AllReduce操作分解为两步:

- Rail内聚合:同Rank GPU在Rail交换机内局部聚合数据;

- HB域内广播:通过高带宽NVLink在域内同步结果。

- 例如,GPT-1T模型98%的流量在HB域内完成,仅2%需跨Rail,大幅降低对Spine层的依赖。

- 将数据并行(DP)的AllReduce操作分解为两步:

-

MoE模型的高效转发机制

- 针对MoE模型的All-to-All流量,通过HB域内转发实现跨Rail通信:

- 数据从源GPU(如Domain1-GPU1)先转发至同域内目标Rank GPU(Domain1-GPU2),再通过Rail交换机传至目标域(Domain2-GPU2)。

- 因HB域带宽(3.6Tbps)远超NIC域(400Gbps),实测MoE模型吞吐损失仅8.2-11.2%。

- 针对MoE模型的All-to-All流量,通过HB域内转发实现跨Rail通信:

⚙️ 三、硬件精简与成本控制

| 组件 | 传统Clos方案 | Rail-Only方案 | 扩展性收益 |

|---|---|---|---|

| 交换机层级 | 3层(Leaf-Spine-SuperSpine) | 1层(仅Rail交换机) | 跳数↓70%,时延↓40% |

| 光模块数量 | 19.6万(32768 GPU) | 6.5万 | 用量↓67% |

| 布线复杂度 | 跨机架光纤+ECMP负载均衡 | 机架内铜缆(DAC)直连 | 部署成本↓50% |

| 功耗 | 654.6兆瓦(峰值) | 150兆瓦 | 能耗↓77% |

🛡️ 四、容错与弹性扩展机制

-

故障域隔离与快速恢复

- 单Rail故障仅影响同Rank GPU(占集群0.2-1%),而非全局。结合Hash Dodging技术,端侧检测到吞吐异常后600ms内切换路径,实现秒级自愈。

- 对比传统Clos:单Spine故障影响全集群15-30%流量。

-

模块化扩展能力

- 采用 Block-Pod-Cluster分级架构:

- Block(256 GPU)→ Pod(4K-16K GPU)→ Cluster(10万GPU)。

- 新增Pod时,仅需通过OCS连接至现有Rail网络,无需调整核心拓扑。

- 采用 Block-Pod-Cluster分级架构:

💎 五、实际部署效能

- 性能指标:

- 在4096 GPU集群中,Rail-Only的HFU(硬件FLOPs利用率)达99%,训练迭代时间误差仅0.9%。

- 腾讯星脉网络实测:10万卡规模下,GPU利用率达90%,通信耗时占比降至6%以下。

- 规模上限:

- 传统Clos受限于Spine端口密度(通常≤10万GPU);

- Rail-Only通过光层扩展,理论上限突破50万GPU。

💎 总结:扩展性突破的核心逻辑

Rail-Only通过 “拓扑重构+流量适配” 解决超大规模扩展问题:

- 删冗余:基于LLM流量稀疏性,移除不必要的Spine层和链路;

- 压时延:单跳通信减少跨设备转发,端到端时延降至10-40μs;

- 降成本:硬件精简使万卡集群成本从4亿降至1.5亿量级;

- 保弹性:光层动态互联+分级架构支持按需扩容。

当前Meta、腾讯等企业已在10万卡级集群中应用该架构,为万亿参数MoE模型训练提供底层支撑。

4.9 腾讯云智能自愈系统(HASHDODGING)

腾讯云智能自愈系统(HASHDODGING)是星脉高性能计算网络的核心组件,专为超大规模AI训练集群设计,旨在实现网络故障的毫秒级自愈。其技术原理和应用案例如下:

⚙️ 技术原理

1. 基于Hash偏移的路径动态切换

- 核心机制:通过修改数据包头的服务类型(ToS)字段中的Hash值,动态调整流量路径。当系统检测到链路拥塞或故障时,终端网卡自动偏移Hash值,触发交换机重新计算转发路径。

- 优势:避免依赖交换机重配置,切换时间≤100微秒(传统TCP需1秒级)。

2. 端网协同的实时感知

- 故障检测:

- 网卡侧:实时监控路径RTT、丢包率、队列深度等指标。

- 交换机侧:配合带内网络遥测(INT)反馈链路状态。

- 触发条件:当RTT突增>50%或丢包率>0.1%时,自动启动Hash偏移。

3. 无中断业务协同

- 业务层联动:训练任务(如AllReduce通信)通过TCCL通信库与HASHDODGING交互,在路径切换时保持连接状态,确保梯度同步不中断。

- 资源隔离:为高优先级流量(如数据库事务)预留备份路径,切换时零排队。

🌐 实际应用案例

1. AI大模型训练集群(10万卡规模)

- 场景:MoE模型训练中突发ToR交换机故障。

- 自愈过程:

- TiTa协议检测到路径RTT从20μs突增至100μs,触发告警。

- HASHDODGING在80μs内修改Hash值,流量切换至备用轨道平面。

- TCCL通信库重路由AllReduce流量,训练任务零中断。

- 效果:单交换机故障下训练任务完成时间延迟仅增加0.3%(传统方案延迟≥30%)。

2. 云原生数据库(TDSQL-C)

- 场景:金融业务高峰期的存储节点链路拥塞。

- 自愈过程:

- HARP协议感知到存储节点响应延迟>P99阈值。

- 通过Hash偏移将OLTP写操作流量调度至低负载路径。

- 结合TiTa动态限流,避免拥塞扩散。

- 效果:写操作性能波动从15%降至2%,事务提交延迟≤1ms。

3. 跨数据中心容灾

- 场景:广域网光纤中断导致跨域备份停滞。

- 自愈过程:

- DCI网络层检测到跨域丢包率>5%。

- HASHDODGING切换至卫星链路+地面冗余路径组合。

- 数据同步速率自适应压缩,避免二次拥塞。

- 效果:RTO(恢复时间目标)从分钟级降至秒级,带宽利用率提升45%。

⚖️ 与传统方案的对比

| 维度 | 传统TCP/ECMP | HASHDODGING |

|---|---|---|

| 故障检测 | 依赖交换机ECN/PFC(秒级) | 端网协同实时感知(微秒级) |

| 切换机制 | 路由重构(中断连接) | Hash偏移(连接保持) |

| 业务影响 | 训练任务失败需重启 | 无感知切换(抖动≤0.1%) |

| 适用规模 | ≤1万节点 | 10万卡GPU集群 |

💎 总结与演进方向

- 核心价值:

- 百微秒级故障隔离:通过轻量级Hash偏移替代传统路由重构。

- 90%+负载无损运行:协同TiTa/HARP协议实现拥塞预防+故障自愈闭环。

- 未来演进:

- AI预测性避障:结合流量历史数据预判路径风险,主动调整Hash策略。

- 跨厂商设备兼容:推动标准化接口,支持异构网络设备(如阿里云/华为交换机)。

腾讯云HASHDODGING已在星脉网络中规模化部署,支撑混元大模型训练、微信视频号等业务,故障恢复效率提升百倍,成为超万卡集群的“网络免疫系统”。

4.10 Rail-Only架构 vs 传统Clos架构

Rail-Only架构通过重构网络拓扑和流量路径,在10万卡规模下相比传统Clos架构实现了显著的成本优化。以下是具体对比数据及技术原理分析:

4.10.1、硬件成本对比(交换机与光模块)

-

交换机数量与层级精简

- 传统Clos架构:需三层交换(Leaf-Spine-SuperSpine)。以64端口交换机为例,10万卡规模需约1,560台交换机(Leaf层960台、Spine层480台、SuperSpine层120台),单GPU连接成本约$1,200。

- Rail-Only架构:仅保留单层Rail交换机(Leaf层),相同规模仅需1,600台(每Rail服务64 GPU),且无需Spine层设备,单GPU连接成本降至$280,节省77%。

技术本质:通过移除Spine层并利用LLM流量的稀疏性(99% GPU对无直接通信),避免冗余设备投资。

-

光模块用量锐减

- 传统Clos需跨层级互联,10万卡需约60万条光纤链路,光模块成本占总投资35%。

- Rail-Only依赖机内高带宽域(HB域)转发,跨Rail流量仅需少量光链路,光模块用量降至15万,成本降低75%。

典型数据:腾讯星脉网络实测显示,3.2T机内带宽可承载98%流量,仅2%需跨Rail传输。

4.10.2、能耗与运维成本

| 成本类别 | 传统Clos(10万卡) | Rail-Only(10万卡) | 降幅 |

|---|---|---|---|

| 峰值功耗 | 2,000兆瓦 | 460兆瓦 | 77%↓ |

| 冷却能耗 | 占总功耗40% | 占比降至18% | — |

| 故障恢复时间 | 小时级 | 秒级(Hash Dodging) | 99%↓ |

- 能效核心:Rail-Only减少70%网络跳数,转发时延从5跳压至1跳,功耗与散热需求骤降。

- 运维优化:单点故障仅影响同Rail GPU(占集群0.2%),而Clos中单Spine故障可波及30%流量。

4.10.3、扩展性成本模型

graph LR

A[规模扩展] --> B[传统Clos]

A --> C[Rail-Only]

B --> D[成本指数增长:N∝k³]

C --> E[成本线性增长:N∝k]- Clos瓶颈:三层架构最大支持6.5万卡(64端口),扩展至10万卡需四层Clos,成本激增50%且时延增至6跳。

- Rail-Only弹性:通过光电路交换(OCS)动态调整光路,新增Pod仅需连接OCS,扩容成本仅为Clos的1/3。

案例:谷歌Aquila架构结合OCS,支持50万卡理论上限。

4.10.4、综合成本效益

| 指标 | 传统Clos | Rail-Only | 价值影响 |

|---|---|---|---|

| 单任务最大规模 | 6.5万卡 | 50万卡 | 算力扩容7.7倍 |

| GPU利用率 | 50%-60% | 90%↑ | 训练周期缩短40% |

| TCO(5年周期) | $4.2亿 | $1.5亿 | 节省$2.7亿 |

- 隐性成本优化:

- 部署效率:Rail-Only布线简化,机房空间占用减少60%。

- 协议开销:传统Clos中ECMP哈希冲突导致吞吐损失15%,Rail-Only拓扑感知路由规避此问题。

4.10.5、行业实践验证

- 腾讯星脉网络:10万卡Rail-Only集群实现GPU利用率90%,通信耗时占比≤6%,同等算力任务成本仅为Clos架构的40%。

- Meta Dragonfly+:结合OCS光交换,10万卡规模下交换机数量减少20%,功耗降低75%。

- 紫金山实验室:三网分离方案中采用Rail-Only,8K GPU集群建设成本降低38%。

总结:成本优化的核心逻辑

Rail-Only通过 “去中心化拓扑”(移除Spine层)+ “流量局部化”(HB域承载98%通信)重构成本模型,在10万卡规模下:

- CAPEX:硬件成本降幅达77%(主要来自交换机与光模块精简);

- OPEX:能耗与运维成本降低70%(依赖跳数压缩与故障域隔离);

- 隐性收益:GPU利用率提升至90%,间接摊薄单任务算力成本。

当前技术边界下,Rail-Only是支撑百万卡级AI集群的唯一经济可行方案,已被腾讯、Meta、谷歌等企业规模化验证。

4.11 HASHDODGING技术与TiTa/HARP协议通过端网协同、分层控制

腾讯云星脉网络中的HASHDODGING技术与TiTa/HARP协议通过端网协同、分层控制实现网络故障的毫秒级自愈和性能优化,其协同机制可分为以下四个层级:

4.11.1、协同架构与角色分工

| 组件 | 核心功能 | 协同价值 |

|---|---|---|

| HASHDODGING | 基于Hash偏移的路径动态切换(修改ToS字段),实现百微秒级故障绕过 | 提供物理层快速逃生通道,避免传统路由重构导致的业务中断 |