1.1随机变量和观测值

随机变量:它是一个未知的量,它的值取决于一个随机事件的结果。

例如:我抛一个硬币,正面朝上为0,反面朝上记为1.抛硬币是一个随机事件,抛硬币的结果就记为随机变量X,随机变量有两种取值,有可能为0,也有可能为1,抛硬币之前我是不知道X是什么的,但是我知道这个随机事件的概率,P(X=0)=0.5,P(X=1)=0.5。

通常我们使用小写字母表示观测值,概率统计中普遍使用大小写来区分随机变量和它的观测值。

上面说到观测值?那么观测值是什么意思呢?当随机事件结束,会观测到硬币的哪一面朝上,这个观测值就记为字母x,x只是一个数而已没有随机性,举个例子我扔了4次硬币就得到了4个观测值,如下图:x1=1,x2=1,x3=0,x4=1。

1.2 概率密度函数

概率密度函数物理意义:它意味着随机变量在某个确定的取值点附近的可能性,这听起来有点绕,我们来看一个例子:

我们用高斯分布来进行举例说明:

高斯分布,也叫正态分布,是一个连续的概率分布,随机变量的取值X可以使任何一个实数,高斯分布的概率密度函数为:

这里面μ是均值,σ是标准差, 下图坐标系中的横轴为随机变量的取值,纵轴为概率密度,其中的曲线为高斯分布的概率密度函数p(X),这个概率密度说明X在原点附近取值的概率比较大,远离原点的地方取值的概率比较小。

下图为:离散的概率分布,随机变量只能取{1,3,7}这几个值,如图右下角,X=1时的概率为0.2,X=3的概率为0.5,X=7的概率为0.3,其它任何地方概率都为0。

概率密度函数有这样的性质,把随机变量的定义域记作χ,如果p是个连续的概率分布,可以对p(X)做定积分,把所有X的取值都算法定积分得到的值为1,如果p是个离散的概率分布呢,随机变量在离散的χ取值,可以对p(x)做一个加和,把所有可能的取值都算上,结果等于1,这就是概率密度函数的基本性质,把所有可能的取值都算上,概率的积分和加和会等于1。

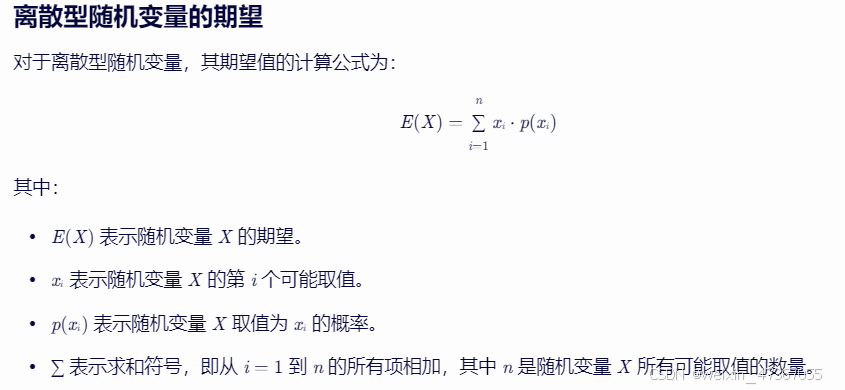

1.3 期望

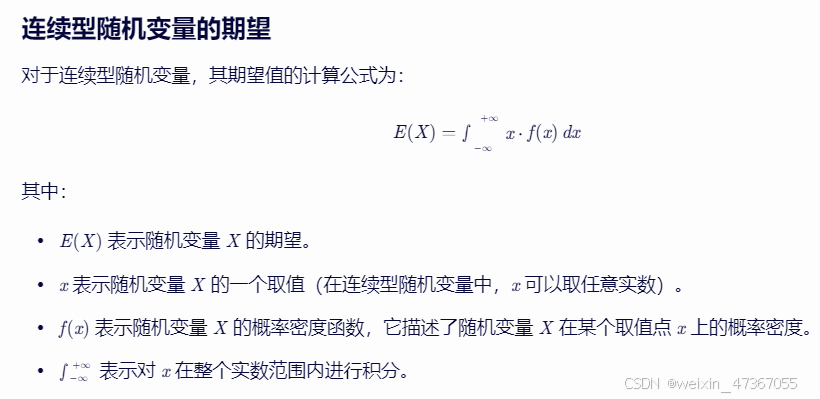

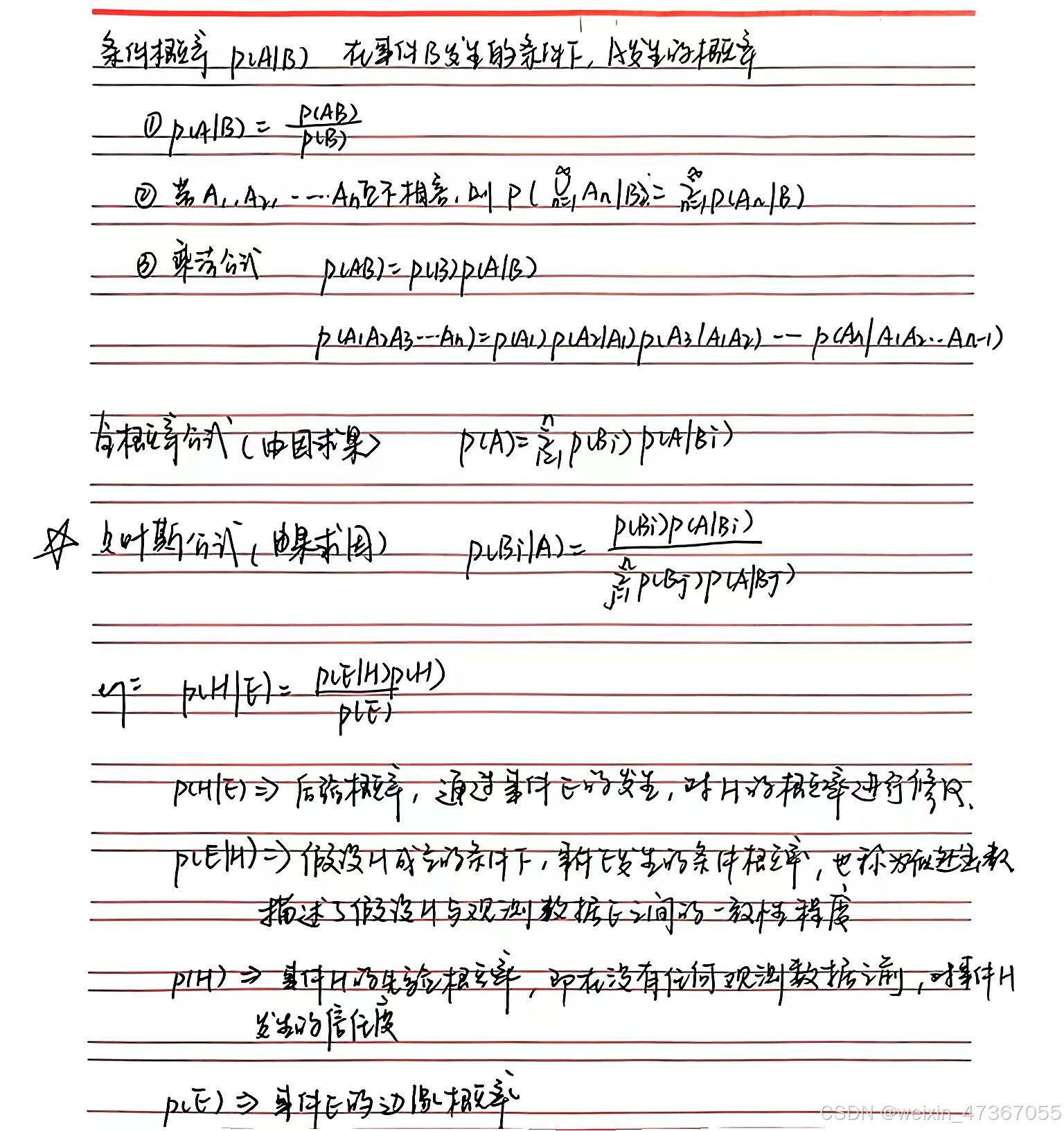

1.4 条件概率、先验概率、后验概率、边缘概率

1.5 中心极限定理

当样本量足够大时,独立同分布的随机变量之和或样本均值的分布将趋近于正态分布,而与原始随机变量的具体分布形式无关。

中心极限定理有几个重要的应用形式和变体,包括但不限于:

-

林德伯格-列维(Lindburg-Levy)定理:这是独立同分布随机变量序列的中心极限定理。它表明,独立同分布、且数学期望和方差有限的随机变量序列的标准化和以标准正态分布为极限。即,当随机变量序列X1, X2, ..., Xn独立同分布,且E(Xk) = μ,D(Xk) = σ²(k = 1, 2, ..., n)时,随机变量之和的标准化变量将渐近于标准正态分布。

-

棣莫佛-拉普拉斯(de Movire - Laplace)定理:这是服从二项分布的随机变量序列的中心极限定理。它指出,参数为n, p的二项分布以np为均值、np(1-p)为方差的正态分布为极限。即,当n足够大时,二项分布的概率可以用正态分布来近似计算。

中心极限定理的通俗解释是:在自然界与生产中,一些现象受到许多相互独立的随机因素的影响,如果每个因素所产生的影响都很微小时,总的影响可以看作是服从正态分布的。中心极限定理就是从数学上证明了这一现象。这一定理在实际应用中有着广泛的背景,如统计学中的样本均值估计、假设检验、置信区间的计算等,都依赖于中心极限定理的支撑。

概率论基础:随机变量、概率密度与中心极限定理

概率论基础:随机变量、概率密度与中心极限定理

1298

1298

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?