前言

目前DeepSeek最大的问题是访问流量太大,导致用户体验不好。通过将自己部署的 DeepSeek 服务无缝集成到 Dify 平台,我们可以在确保数据隐私的前提下,打造专属私人AI助手。

本文主要面向于想将自己服务器上的deepseek模型部署接入到dify平台上

1.基础环境

deepseek在服务器上部署

参考(前半部分):deepseek服务器部署指南及modelscope下载教程_modelscope deepseek-优快云博客

dify部署

参考:公用服务器部署dify,全流程版,超详细~-优快云博客

2.导入

基础环境配置好后,登录dify,通常端口为80,即为http://xxxxxx:80(中间替换成你自己的ip地址即可),登录后点击右上角头像,点击个人设置

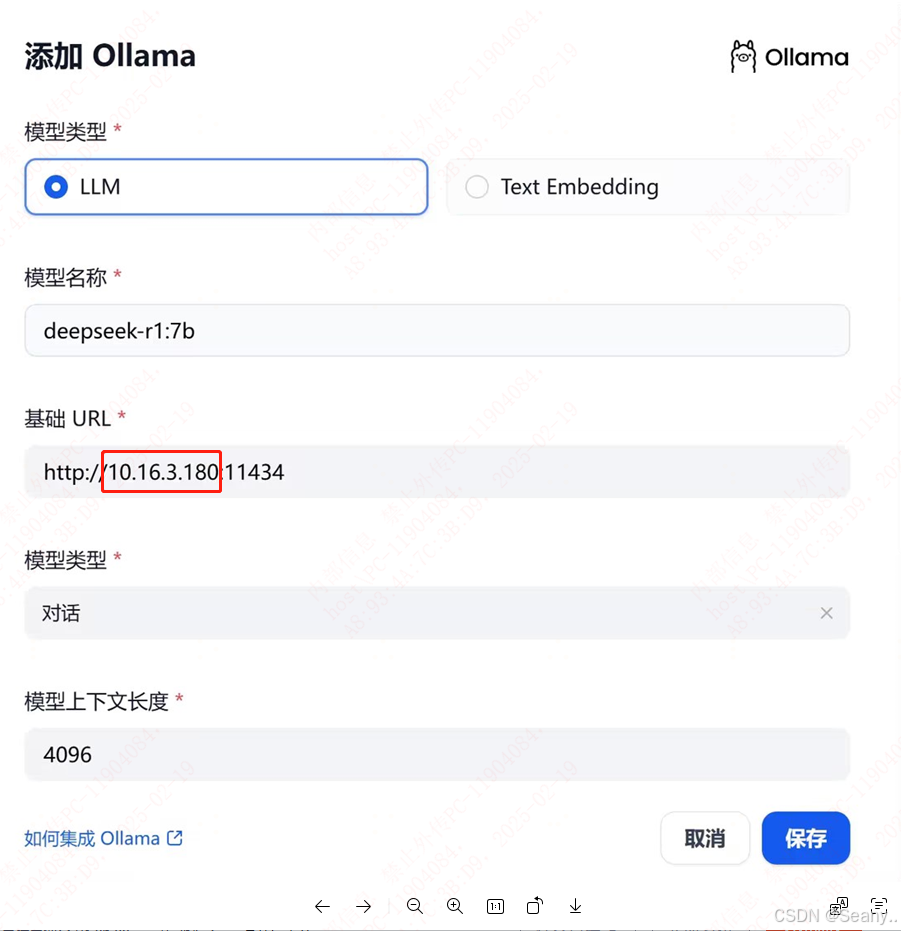

随后选择模型供应商,在右边找到ollama,添加模型,点击后如图

模型类型通常选择LLM,名称选择你自己服务器上部署过得模型,比如我这里选择的是7b版本,

这里的地址即ollma客户端运行地址,通常为http://xxxxxx:11434

如果你是在自己的服务器上部署,则就是服务器ip地址;

如果你是在自己电脑本地上部署,则就是你自己电脑的ip地址。

这里有个点需要注意一下:即在保存的时候,服务器上对应的模型要在运行中。

先打开服务器将对应模型运行起来

ollama run deepseek-r1:7b

ollama ps

查看到你需要的模型正在running状态即可,

这里有个点需要注意一下:即在保存的时候,服务器上对应的模型要在运行中。

先打开服务器将对应模型运行起来

ollama run deepseek-r1:7b

ollama ps # 查看到你需要的模型正在running状态即可,

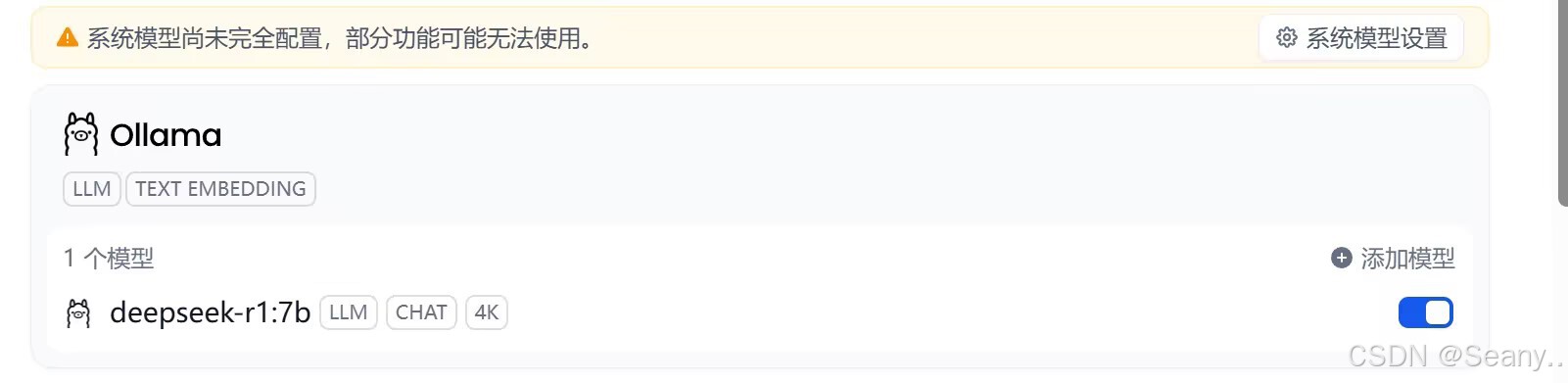

随后部署成功后,即可在上方看到自己接入的模型

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?